大多数情况下,尤其是深度学习中,想要求损失函数最小值处的参数,是无法通过闭式解得到的。需要使用梯度下降。

首先,Random Search是行不通的。

一元函数---导数

多元函数---偏导数---偏导数组成的向量就是梯度(gradient)

----------------------------------------------------------------------------------------------------

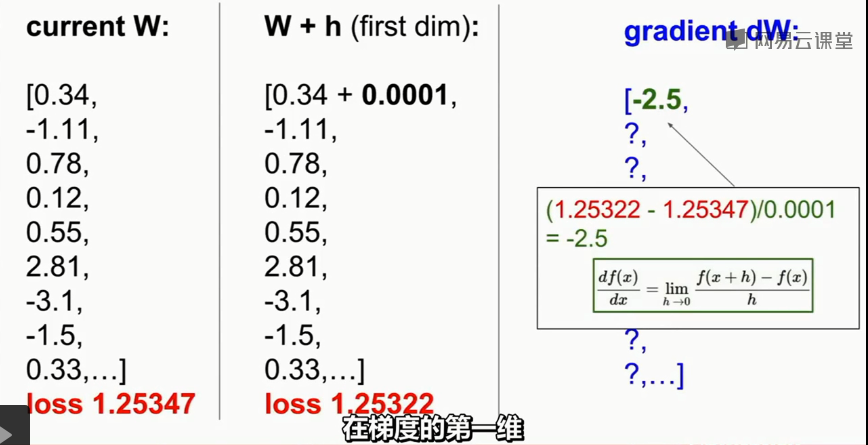

若使用有限差分方法计算梯度,如下图。这种方法非常的慢!经常使用这种方法来做梯度检查,用于调试。

-------------------------------------------------------------------------------------

实际中,我们使用微积分推导出梯度表达式再计算梯度。

-------------------------------------------------------------------------------------

二分类支持向量机中的标签是-1,+1

hinge loss = max(1-yiSi) Si = wxi+b

对于二分类问题中,只有一个分数Si,w只是向量,b是实数

-------------------------------------------------------------------------------------

多分类支持向量机

http://vision.stanford.edu/teaching/cs231n-demos/linear-classify/ 这个课程链接,可以调试多分类svm

hinge loss Li = Σ max(Sj-Syi+1,0) j ≠ i

这里Si有C个,分别是第i个样本被预测为第c类的分数

W是矩阵,每一行对应一类

b是向量,每一行对应一类

-------------------------------------------------------------------------------------

神经网络兴起之前,人们只能使用线性分类器

使用线性分类器时,不能将图片的像素直接作为输入特征,这样效果很差,因为线性分类器能力有限,数据集线性不可分。

要做特征转换后再输入到线性分类器中去。

-------曾经使用的特征转换方法有 颜色直方图,方向梯度直方图,bag of words(从NLP中启蒙得到)