本文整理自2023年 12 月 20 日举办的「2023 百度云智大会·智算大会」主论坛,百度智能云 AI 与大数据平台总经理忻舟的主题演讲《智算让大模型触手可及》。

在之前极客公园举办的创新大会上,百度集团董事长兼 CEO 李彦宏先生提到:卷 AI 原生应用才更有价值。

要做好 AI 原生应用,有三个关键的因素:基础大模型好不好,根据业务数据及反馈对模型的调优好不好,以及大模型开发、应用方式好不好。

百度及市场上的友商已经提供了很多优秀的基础模型;而今天我要为大家介绍的,就是百度智能云千帆大模型平台在模型调优和部署上的最新工作。有了调优好的模型,才能为卷 AI 原生应用打下坚实的基础。

在这之前,百度集团副总裁侯震宇先生已经介绍过千帆大模型平台的全景图了。

值得一提的是,千帆大模型平台是全球首个一站式的企业级大模型平台。自 3 月 27 日发布以来,千帆大模型平台服务了众多企业与开发者,不断进行功能和体验的迭代更新。

同时,大模型技术的发展非常快,而千帆大模型平台也紧跟技术趋势,不断将最新的模型引入进来、最新的研发范式固化到平台,帮助客户更好地开发、应用大模型。可以说,千帆是一个经过产业实践考验,又不断创新的平台。

我们来看两个数字:

-

千帆大模型平台已经服务了超过 40,000 个用户,距上一次百度世界大会公布用户总数仅仅过去了 2 个月的时间,我们的总用户量增长了近 2.5 倍。这足以证明大模型在企业开发、应用中的火爆程度。需要特别说明的是,这些用户可不是走马观花的来平台注册和浏览,而是真正调用过推理服务或者对模型进行调优,真真正正用在自己的业务中的。

-

另一个数字是累计模型的精调数量,用户在千帆大模型平台上精调产生的模型数量近 10,000 个,这也说明了用户对大模型的需求十分旺盛。

这两个数字给了我们很大的鼓舞,同时也鞭策我们持续迭代优化千帆大模型平台,给企业与开发者带来更好的体验与价值。

在我们接触到的各行各业的模型开发和训练需求当中,无论是开发者还是企业,都遇到了各种各样的挑战,希望通过千帆平台来解决这些问题,主要包括以下三个方面:

-

模型精调不易:大模型的精调难点核心在于可靠性的保障,比如如何在通用语料知识不遗忘的情况下提升特定场景的效果,如何通过精调来有效提升大模型格式/指令遵循的效果等。模型精调从模型选择、原始数据清洗、数据标注、模型精调,全流程均需要投入大量的专业算法工程师,并进行反复实验,才能获得更可靠的效果。

-

模型评估不全面:很多企业在建设大模型应用第一步就会做大模型效果评估,特别是生成式 AI 天然存在容易主观评价的难点,所以关于评估方式方法如何能有更好的全面性保障也是当前企业在研究的热点。从百度实践经验来看,不同行业场景下会需要不同数据、不同方法来评估,且需要长期在真实应用环境中追踪并评估效果。

-

计算与推理资源不足:大模型的训练及推理均需要更高性能的硬件和软件,当前大环境的算力紧缺也为企业构建大模型应用带来新的挑战。

基于这些问题,千帆大模型平台在最近的这段时间里,重点对提效和降本这两个方面做了新的升级。

-

提效:为提升效果而生的工具链,让训练开发大模型更加快捷便利,提升大模型的效果与效率。

-

降本:这也是许多企业关注的问题。千帆大模型平台极致利用资源,为用户提供远超预期的性价比。

千帆大模型平台一直致力于为用户提供最全面、最优质的大模型能力,方便企业开发者进行对比选择。目前千帆预置模型数量已经达到了 54 个,位居国内数量第一。这些模型中不仅包括了像 ERNIE-Bot 4.0 这样的文心大模型,也有很多第三方的开源和闭源大模型、行业大模型(如 ChatLaw 法律大模型、度小满轩辕金融大模型等等),服务于各行各业的用户。

这么多的模型对用户有什么价值?主要体现在以下两点:

-

AI 原生应用场景需求是多样的。千帆就像一个超市,能让开发者快速找到需要的所有大模型。举个例子,假如你想搭建一个类似如流的智能办公助手,除了基础的创作对话外,你会需要一些复杂的意图识别,甚至代码生成、图片生成的能力。千帆上集成了增强版 Llama2、SQLCoder、Stable Diffusion 等各具场景优势的大模型,可以帮助开发者快速完成场景落地。

-

大模型仍然处于爆发期、业界各种大模型层出不穷,对于开发者来说跟进、了解很难。千帆技术团队会对业界大模型保持密切跟进,遴选效果领先且最适合中国企业需求的大模型集成到千帆平台,确保开发者可以放心使用。

这些都可以帮助开发者降低试错成本,提高场景效果。

在选择好基础大模型后,下一步是对模型进行调优。千帆大模型平台在模型精调和持续预训练上做了新升级。支持国内外的优质大模型在千帆大模型平台上进行调优,涵盖文本生成、文生图、代码生成等多种应用场景。

-

SFT 新增 Llama2 13B 大语言模型、ChatGLM2-6B 模型、Baichuan 2 模型、Stable Diffusion XL 文生图大模型、SQLCoder 大语言模型。千帆对开源模型做了进一步的中文增强,以提升模型的训练效果。

-

对于大模型持续预训练(Post-pretrain)的训练模式,可以应用在教育、医疗、法律等多个行业,企业用户可直接训练得到专属的大模型。

同时,千帆在数据处理和训练中不断优化加速策略,并且能够自动感知训练过程中的异常问题,并自动解决。

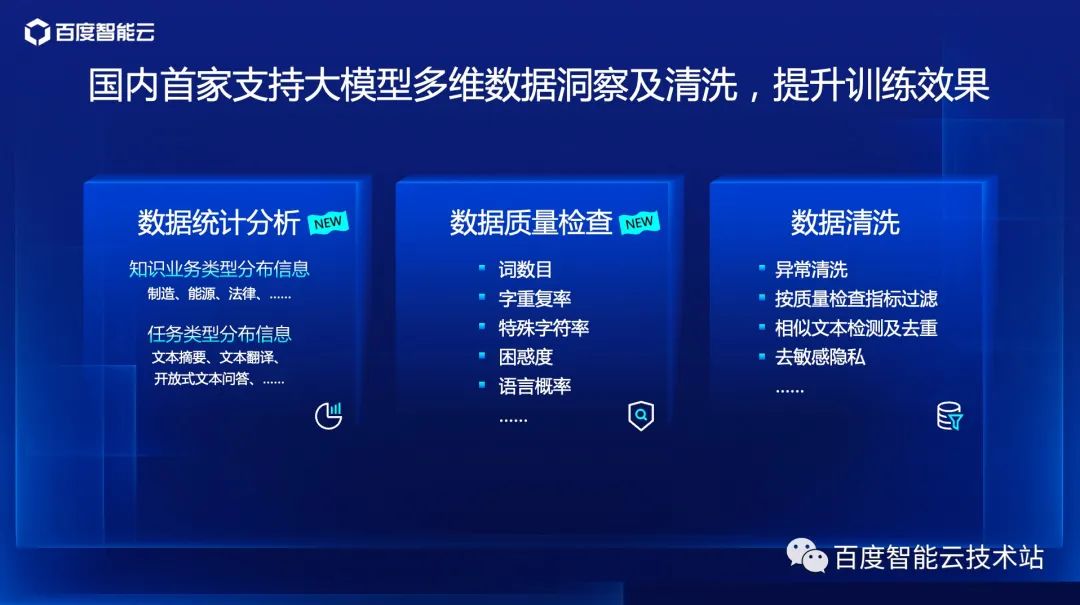

有了模型后,我们需要对数据进行分析与处理。对数据的分析和处理是千帆大模型平台的一个重要且极具特色的能力。

任何一个令人满意的大模型,一定少不了高质量的「数据集」。为了解决用户对优质数据的燃眉之急,保障模型效果,首先是对数据进行分析与数据质量检查。我们需要了解这些数据是什么,数据的质量如何,数据类型是什么,以及数据所在的行业,语言困惑度等等,这些都是我们对数据质量判定的指标。

对数据有基本洞察后,下一步需要进行数据清洗,如去除空白字符、异常字符、相似文本、敏感信息等等,这些工作对大模型调优非常重要,因为一旦产生低质量的数据会造成大量的成本浪费。

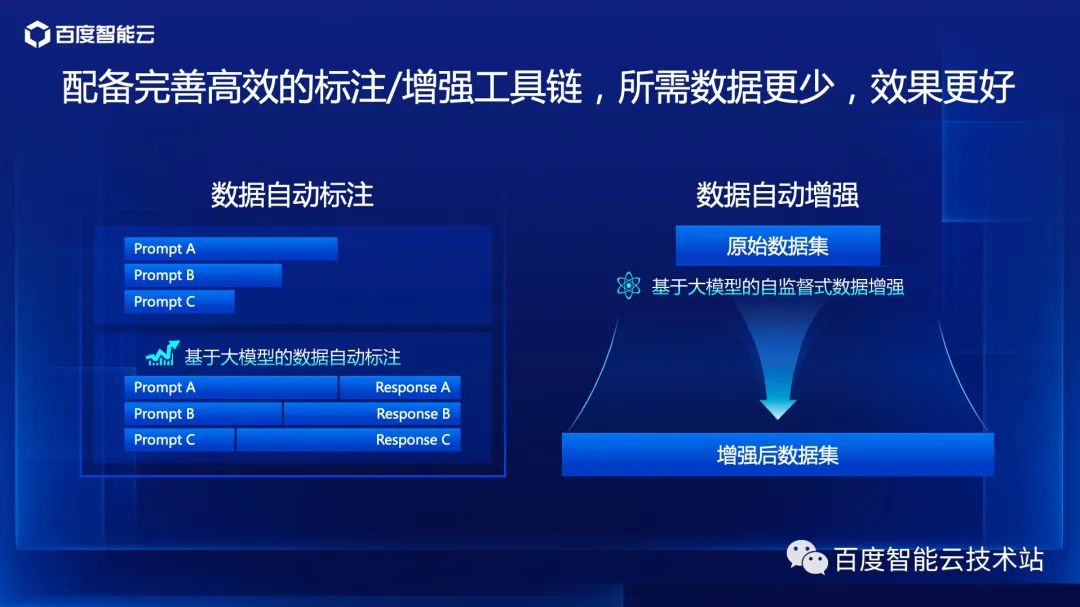

有了高质量的数据后,下一步将进行数据标注。千帆大模型平台提供基于大模型的「数据自动标注」功能,对数据集进行快速标注,人工仅需复核或精调标注信息,大大提升了标注效率。同时,如果用户的原始数据集相对较少,千帆平台还可以利用预训练大模型的自监督能力将数据增强,对原始数据集进行高效扩充。

有了好的模型以后,如何对模型进行评估也是业界难点之一。因为大模型的回答比较开放,传统的评估方法很难继续适用;所以对于开发者来说,如何选择最适合的基座大模型,如何衡量精调模型能否真正满足场景要求,很有挑战。

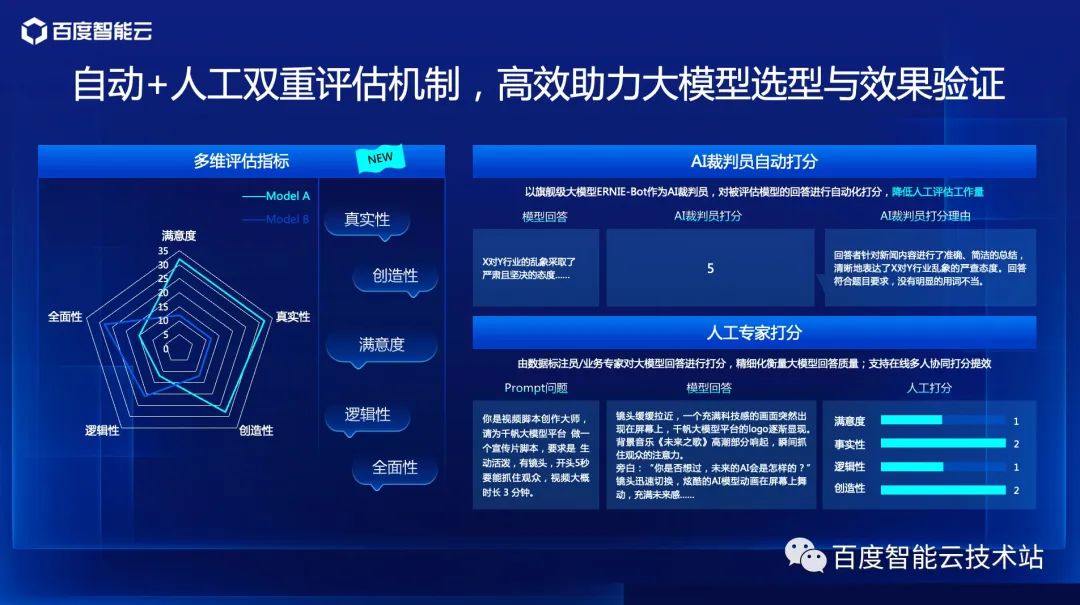

首先,千帆大模型平台在评估上引入了大量的评估指标,包括满意度、真实性、创造性、全面性等等,便于全面衡量大模型在业务应用中的价值。

千帆大模型平台沉淀了业界领先的大模型评估范式,同时支持自动、人工结合的双重评估机制,可以帮助开发者更高效、更体系化的评估大模型效果。

以上是对大模型调优最新升级的内容分享。下面以我们真实客户为例,与大家一起算个账。

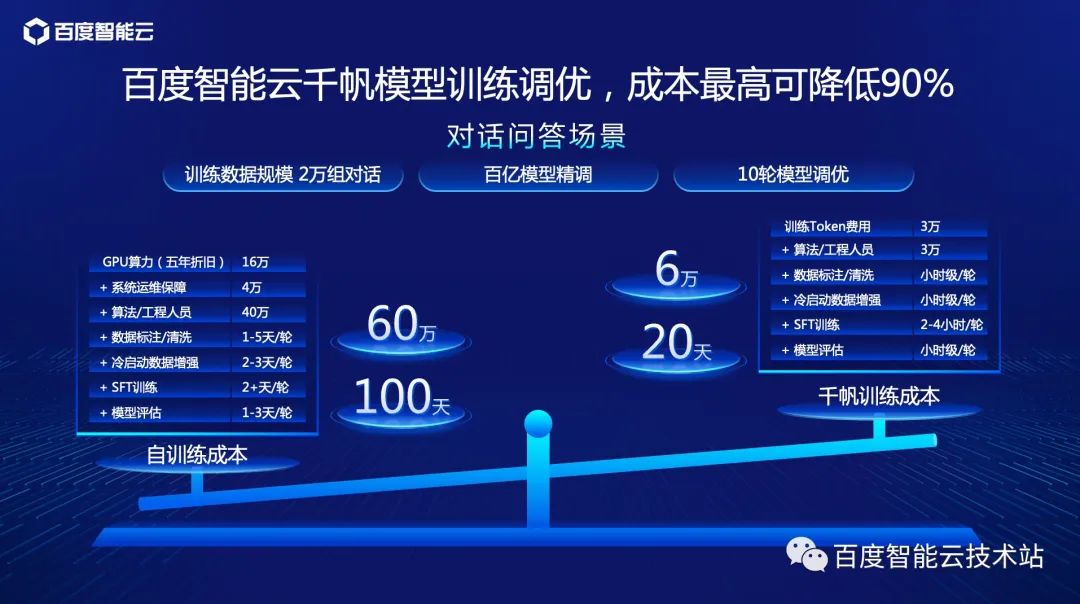

我们在与客户沟通的过程中,了解到他主要的使用场景集中在「线上客服 - 对话问答」中,场景包含两万多组对话。

依据自身场景需求,客户对百亿的模型进行精调。根据我们以往的经验,这项任务在经过十轮的模型精调方可达到稳定的状态。所以,企业自建平台从大模型调优、GPU 的算力、运维成本、人力成本的投入、时间成本评估来看,整个训练调优任务需要花费 60 万元,约 100 天的时间去完成。

同时,我们进行了详细的测算。如果达成与企业自建平台同样的效果,使用千帆大模型平台约 2 天就可以完成一次迭代。同时,千帆大模型平台为用户提供弹性资源,训练服务按 token 计费,客户按需求随时发起训练任务,无需担心训练算力资源的利用率,进一步降低成本。

在典型的大模型应用场景下,使用千帆大模型平台只需 6 万元、20 天的时间即可完成大模型训练调优,成本最高降低 90%,帮助企业的业务快速上线、反馈,提升业务竞争力。

下面,我们需要对模型做进一步的推理与部署工作。目前,大模型的部署需要解决两大问题:

-

资源消耗大,对设备的算力、显存等要求很高;

-

大模型推理性能整体比较差、吞吐低。

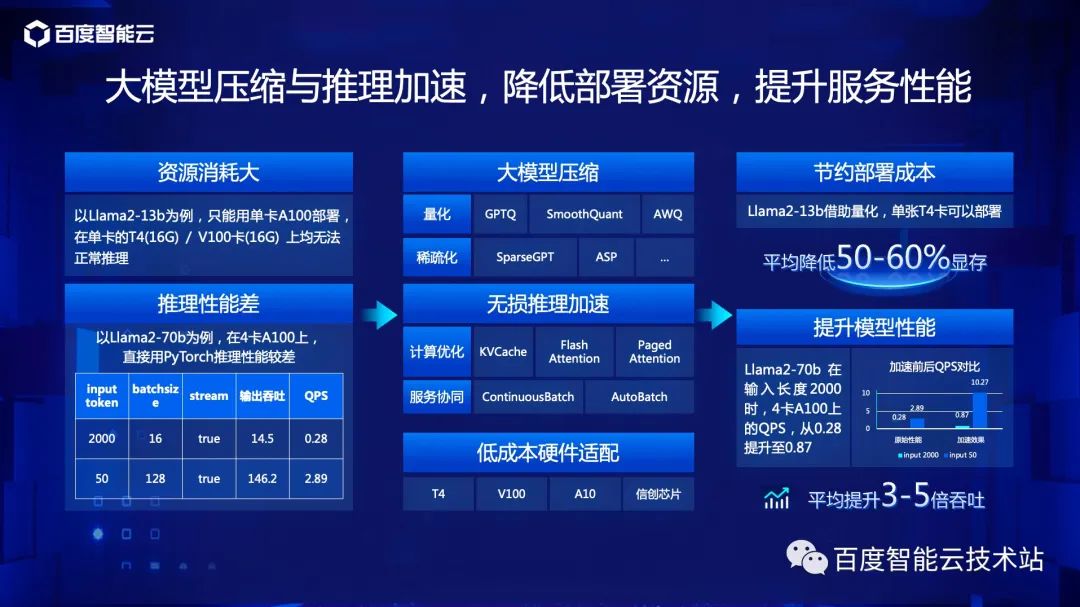

针对上述问题,千帆大模型平台通过三种技术路径来实现大模型推理与部署的优化:

-

模型压缩:通过量化与稀疏化降低显存的消耗;

-

无损推理加速:计算优化和服务协同优化,一起使用来提升模型的吞吐能力;

-

低成本硬件适配:如一些旧的 NVIDIA 计算卡、国产芯片等,从而提升整体的计算性能,降低成本。

通过上述三种技术路径的优化后,平均部署成本节约 50%~60% 显存,模型性能平均提升 3~5 倍的吞吐。

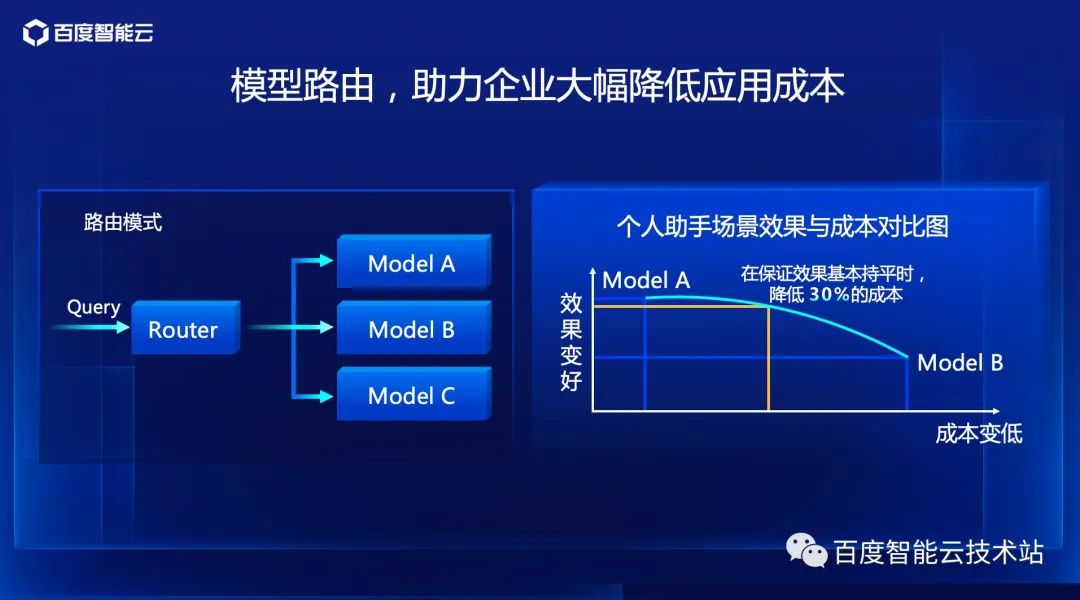

现在大模型的使用模式主要是调用一个强大的模型,来解决各类的业务问题。但是根据具体的业务应用场景,可能会有更好的选择。

下面是另一种技术路线 - 模型路由模式。模型路由模式主要是用不同层面的模型去解决不同难度的问题。比如:在数学学习场景中有小学题、中学题、大学题三种难度的题型。小学难度的题目由小学老师解决足矣,完全不需要中学教师与大学教授解决。

千帆大模型平台实现模型路由,将不同难度的问题交给不同的模型回答,这样在保证模型效果的同时,帮助企业降低成本。

如下图右侧所示,在个人助手类的场景下,通过模拟路由的方式将两个模型进行组合,在保证模型效果基本持平时,模拟路由方式降低了 30% 的成本。

千帆大模型平台推出了多种计费模式供客户选择,在满足客户要求的同时,又能做到成本的最优化。

-

Tokens:灵活性最高,按需使用,按量付费;

-

TPM:提供更大并发量和更大折扣额度,适合大型客户正式业务中使用;

-

批量计算(新上线):适合有离线内容生产需求,对实时性要求低,吞吐量大的客户;

-

算力单元:独占的专享部署硬件,协助客户部署自己的 SFT 过后的模型。

本次分享为大家全面介绍了从千帆大模型平台从模型调优到模型评估、模型推理的能力,以及如何帮助业务进行降本提效。

在未来,我们希望 AI 可以帮助更多企业进行智能化转型,为各行各业带来更大的价值,让大模型触手可及。

- - - - - - - - - - END - - - - - - - - - -

点击阅读原文

了解智算大会更多信息

推荐阅读

盘点 2023 “很刑”的 IT 民生事件:视频软件白嫖带宽、程序员改 ETC 余额…… SpringBoot 2.x 正式停更了。Java 8 由 Solon 接收! 罗永浩称“荣耀任意门”抄袭锤子开源软件 One Step 2024 年,Linux 内核的开发语言是否要从 C 转换为 C++ Linus 在 Linux 6.8 内核发现性能倒退问题 Git 开发人员讨论引入 Rust 的可能性 Linus“温馨提示”:Intel Xe 驱动代码严重缺乏测试 Linux 内核被冬季风暴“封印” LG 洗衣机每日使用的数据流量高达 3.6GB? 2024 技术招聘状况:AI 工具被视为作弊,Python 需求最大