YOLOv5改进 | 2023注意力篇 | EMAttention注意力机制(附多个可添加位置)

猜你喜欢

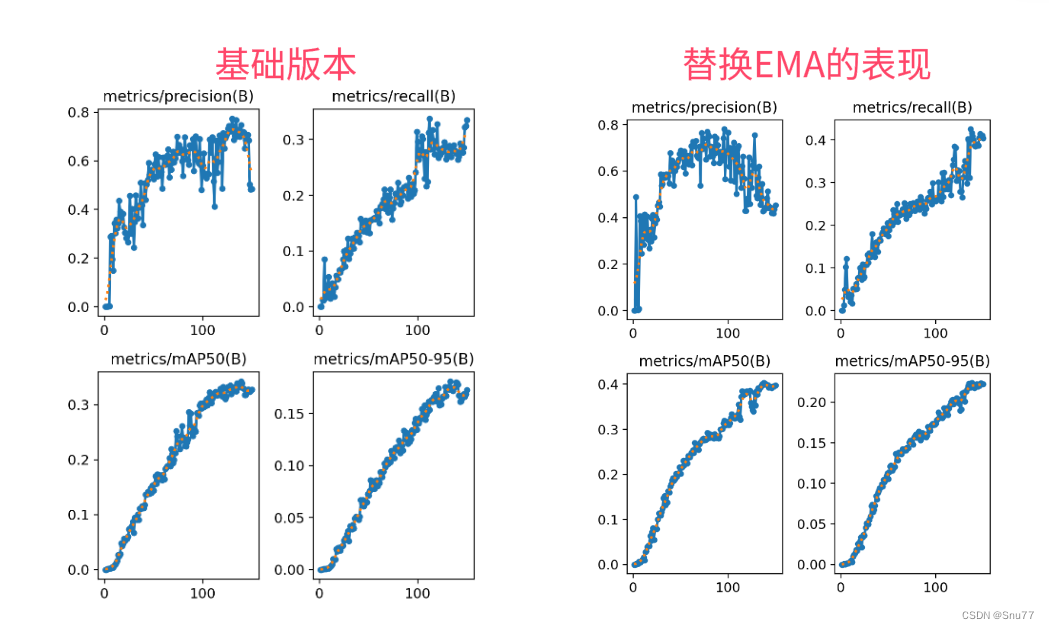

转载自blog.csdn.net/java1314777/article/details/135443454

今日推荐

周排行