斯坦福大学的人工智能机构 Stanford Institute for Human-Centered Artificial Intelligence (HAI)发布的这第五版《AI指数报告》(2022)英文版一共230页。为了方便阅读,我将他翻译成中文记录下来,本文仅摘取重要且有趣的部分,且有部分自己的阅读感受和见解,需要阅读原文的请至链接2022年斯坦福AI指数报告-深度学习文档类资源-CSDN下载。

人工智能指数报告跟踪、整理、提炼和可视化与人工智能相关的数据。这份报告的使命是为政策制定者、研究人员、企业高管、媒体记者提供公正、经过严格审查的全球数据,使得公众对复杂的人工智能领域有更透彻、更细致入微的理解。它旨在成为世界上最可信、最权威的人工智能数据和见解来源。

第二章. 人工智能模型性能

今年,模型性能章节包含了对人工智能更多技术子领域的分析,包括计算机视觉、语言、语音、推荐、强化学习、硬件和机器人技术。本次调研使用了许多量化测量方法,从常见的人工智能基准算法和对泛化领域调研的大赛挑战,来突出表现那些最佳人工智能模型的发展历程。

概要:

- 数据,数据,数据:基于实验室基准条件的模型技术结果则越来越依赖于使用更多的训练数据来获得更先进的结果。换言之,模型本身的设计好坏往往差别不大,而更多的训练数据能带来更好的实验效果。截至 2021 年,斯坦福大学AI指标报告中的 10 个基准测试中有 9 个最先进的 AI 系统经过了更多的训练。这种趋势隐隐指引着私营参与者倾向去寻找大量的数据集。

- 对特定计算机视觉子任务的兴趣日益浓厚:2021 年,研究界在一些具体的计算机视觉子任务上有着更高的兴趣水平,例如医学图像分割和蒙面人脸识别(我的导师张百灵教授在2015年左右就在研究这几个领域的具体任务,我想现在研究界只是有更多来自工程学院和生物学院的教授关心这类识别为他们在特定领域研究带来的创新成果,仅此而已)。例如,2020年前只有 3 篇研究论文针对 Kvasir-SEG 医学成像测试了系统基准。2021 年,有 25 篇研究论文。这种增长表明人工智能研究是在转向更直接、更实际应用的研究。

- AI 尚未掌握复杂的语言任务:AI 在基本阅读技术基准的性能上已经超过了人类的水平,SuperGLUE 和 SQuAD 等阅读理解基准表现提高了 1%–5%。虽然人工智能系统仍然无法在更复杂的语言任务上达到可媲美人类的表现,例如溯因自然语言推理(aNLI),但差异正在缩小。2019年,人类的表现仅领先 9个百分点(aNLI)。截至 2021 年,这一差距已缩小到 1%。

- 转向更通用的强化学习:在过去十年中,人工智能系统已经能够掌握一定限制条件下的强化学习任务。这要求系统最大限度地提高某项特定技能的表现,例如国际象棋。顶级国际象棋软件引擎现在比 Magnus Carlsen 的最高 ELO 分数高出 24%。然而,在过去两年,人工智能系统在新环境、更通用的强化学习任务上也提高了129%(Procgen) 。这一趋势预示着人工智能系统未来的发展可以学习更广泛地思考能力。

- 人工智能变得更实惠、性能更高:自 2018 年以来,训练图像分类系统的成本降低了 63.6%,而训练次数提高了 94.4%。其他 任务也出现训练成本降低、但训练时间加快的趋势:推荐系统,物体检测和语言处理,并有利于更广泛的人工智能商业应用。

- 机械臂正在变得更便宜:一项人工智能指数调查显示,机械臂的中位数价格在过去六年中下降了 4 倍——从2016 年每只手臂 50,000 美元下降到 2021 年的 12,845 美元。关于机器人的研究变得更容易获得,且负担得起。

2.2 机器视觉——视频

视频分析涉及的是序列帧(视频)的推理或任务操作,而不是单个帧(图像)。视频计算机视觉有广泛的用例,包括协助犯罪监控工作、体育分析、自动驾驶、机器人导航和人群监控。

目录

Kinetics-400, Kinetics-600, Kinetics-700

ActivityNet: Temporal Action Localization Task

Common Object in Context (COCO)

动作识别 ACTIVITY RECOGNITION

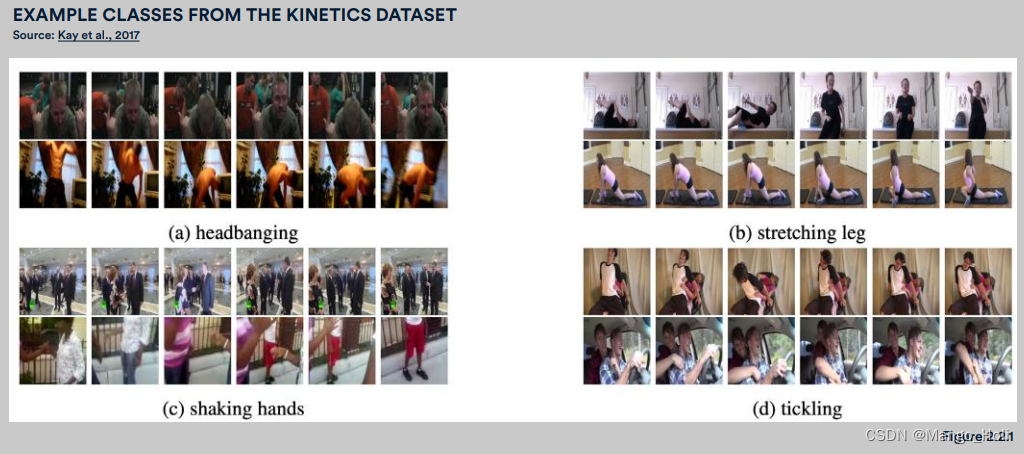

视频计算机视觉的一个基本的子任务是动作识别:在视频中识别发生的动作。人工智能系统挑战分类动作范围从简单的动作,如步行、挥手或站立,到更复杂以及更多步骤的动作,例如准备沙拉(它需要一个人工智能系统来识别和链接诸如切西红柿、洗蔬菜、制作酱料等离散动作)

Kinetics-400, Kinetics-600, Kinetics-700

Kinetics-400、Kinetics-600 和 Kinetics-700 是一系列用于对视频内动作识别进行基准测试的数据集。这三个数据集均包括 650,000 个大规模、高质量的 YouTube 视频剪辑(每个数据集的大小是 650,000 ),视频里有大量的人类活动,并要求 AI 系统分别从大约 400、600 和 700 个类别里进行动作分类。一些新的更具挑战性的动作类型也被添加到 Kinetics-700 系列数据库里,包括倒酒、演奏双簧管和制作拿铁咖啡艺术。

截至 2022 年,有一个模型在所有三个 Kinetics 数据集上名列前茅。MTV,Google Research 谷歌研究院与密歇根州立大学和布朗大学于2022 年 1 月发布的合作项目,在 Kinetics-600 系列数据集上实现了 Top-1 准确率为 89.6% ,在Kinetics-400 系列数据集上准确率为 89.1%,在 Kinetics-700 系列数据集上准确率为 82.20%。最引人注目的是,模型在 Kinetics 数据集上的性能差距在以相当显著的速率缩小。2020 年,模型在 Kinetics-400 和 Kinetics-700 数据集上的性能差为 27.14 个百分点。一年间,这个差距已缩小到 7.4 个百分点,这意味着相同模型的性能在更新、更难的数据集( Kinetics-700 )上比在更简单的数据集( Kinetics-400 )上有更快的提升,并且表明更简单的数据集上性能表现已经开始渐近极值。

ActivityNet: Temporal Action Localization Task

ActivityNet 是包含 700 小时200 种不同的人类活动(跳远、狗走路、吸尘等)人类活动解析的视频数据集。为了人工智能系统能够成功完成 ActivityNet 时序动作定位(Temporal Action Localization:TALT)任务,它必须执行两个独立步骤:(1)定位(确定动作发生的精确时间间隔); (2) 识别(分配正确的类别标签)。时序动作定位是计算机视觉中最复杂和最困难的任务之一。在 TALT 任务上的表现是根据识别的算数平均精度来衡量的,分数越高表示精度越高。

截至 2021 年,在 TALT 任务上表现最好的模型由华中科技大学与阿里巴巴联合开发,得分44.7%,与 2016 年该挑战初次公布的最高分数相比提高了 26.9 个百分点。尽管

该任务上自2016至2021年期间往年发布的最先进算法模型的性能收益(增长率)越来越小,如图。

目标检测 OBJECT DETECTION

目标检测是识别图片上目标对象的任务,如下图 2.2.4中所示AI系统如何识别物体的。对优先级、速度和准确性的不同哲学观将指引目标检测系统的不同设计。更快得到训练的系统可能处理起来更有效率,但检测结果不太准确。那些检测地更准确的系统可能表现更好,但会需要更长的时间来处理视频。这种速度和准确度的权衡也体现在近十年来首创的各类目标检测方法中。有优先考虑速度的一段法(one-stage),例如SSD、RetinaNet 和 YOLO;亦有优先考虑准确度的两段法(two-stage),例如 Mask R-CNN、Faster R-CNN、和Cascade R-CNN。

Common Object in Context (COCO)

微软Common Object in Context(COCO)目标检测数据集包含了80多个类别超过328,000张图像。有许多精度指标用于跟踪目标检测的性能,但为了保持一致性,本节和本报告的大部分内容都考虑用平均精度均值(mAP50)。自2016年以来,在COCO数据集上的目标检测性能提高了23.8个百分点,今年的顶尖模型:GLIP 的平均精度均值为79.5%。图 2.2.5说明了使用额外的训练数据如何主宰目标检测任务,就像其他计算机视觉领域一样。

You Only Look Once (YOLO)

You Only Look Once,意为“你只需要看一次”,是一个开源的目标检测模型,它强调速度(推理的延迟率)而不是绝对精度。多年来,YOLO进行了多轮迭代,图 2.2.6 绘制了YOLO目标检测器与在COCO数据集上表现出绝对最好性能SOTA的检测器之间的区别。自2017年以来,YOLO目标检测器的性能已经有很大进步(提高了28.4个百分点)。其次,YOLO和性能最好的目标检测器之间的性能差距已经很小。2017年,这一差距还是11.7%,到2021年,差距降至了7.1%(减少4.6%的性能差距)。在过去的五年里,目标探测器变得更快更好了。

Visual Commonsense Reasoning (VCR)

视觉常识推理挑战(VCR)是视觉理解的一个相对较新的任务。视觉常识推理要求人工智能系统从图像场景中回答有挑战的问题,并提供他们回答背后的推理(与VQA挑战不同的是,评判VCR性能表现是衡量Q->AR分数,即聚合判断机器的好坏靠的是,其一选择正确的选择题答案(Q->A),其二选择正确答案的理由(Q->R)。

自从这项挑战首次亮相以来,人工智能系统在视觉常识推理方面变得更好了,尽管它们仍然只需要一个答案)。这个挑战的数据集包含了29万对选择题的答案和理由,它们来自11万张从电影中拍摄的图像场景。图 2.2.7 阐述了在VCR挑战中提出的各种问题。

性能水平远远落后于人类(图 2.2.8)。2021年底,VCR挑战的最高分为 72.0,自2018年以来的表现增长了63.6%。尽管自发起挑战以来已经有了巨大的进展,但改进已变得越来越微小,这表明需要发明新的技术来显著提高表现。