【编者按】GPT 系列的面世影响了全世界、各个行业,对于开发者们的感受则最为深切。以 ChatGPT、Github Copilot 为首,各类 AI 编程助手层出不穷。编程范式正在发生前所未有的变化,从汇编到 Java 等高级语言,再到今天以自然语言为特征的 Prompt 工程,编程的门槛进一步降低,让很多开发者也不由得思考,编程的未来究竟会如何演化,在这大模型时代,开发者又该何去何从?基于此,《新程序员 007:大模型时代的开发者》邀请到图灵奖得主、中美法三国院士 Joseph Sifakis 进行深度对话。万字长文,感受对人工智能的深邃思考。

注:《新程序员 007》聚焦开发者成长,其间既有图灵奖得主 Joseph Sifakis、前 OpenAI 科学家 Joel Lehman 等高瞻远瞩,又有对于开发者们至关重要的成长路径、工程实践及趟坑经验等,欢迎大家点击订阅年卡。

采访 | 邹欣,CSDN &《新程序员》首席内容顾问

作者 | 王启隆

责编 | 唐小引

出品 | 《新程序员》编辑部

从 ChatGPT 引发百模大战,GPTs 让人人都能用自然语言构建 GPT,全球范围内对于 AGI 通用人工智能的探索日渐深入,而计算机领域关于“超智能”的神话也愈演愈烈,其中一个广泛传播的观点是,计算机智能最终将超越人类智能,技术奇点即将到来。

机器智能(图源:AIGC 生成)

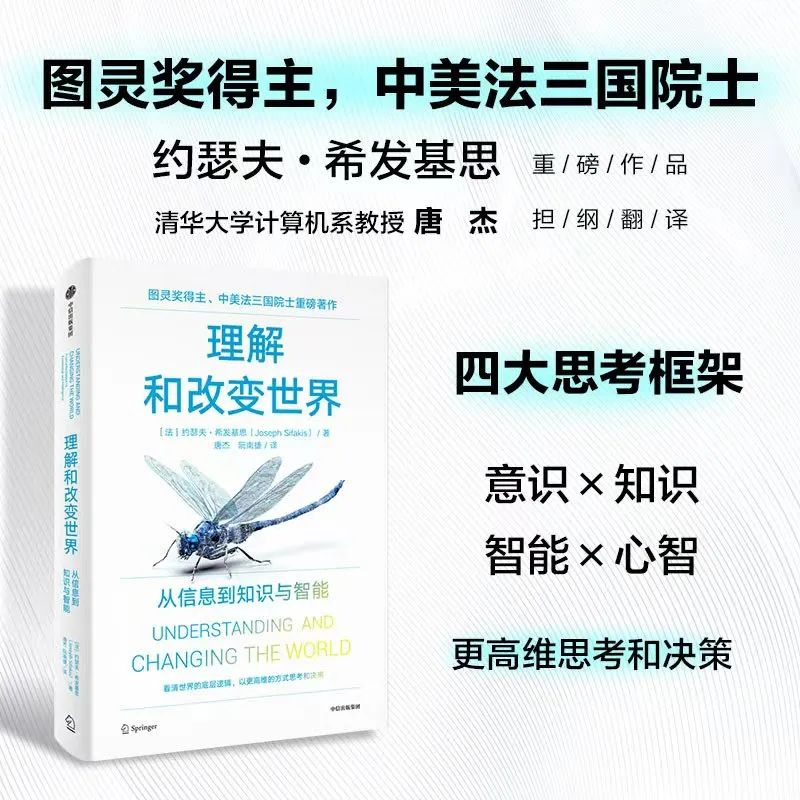

但同时,也有许多科学家对这些热议保持理性或反对的态度。图灵奖得主、中美法三国院士 Joseph Sifakis 认为,再强大的机器也不足以战胜人类的智慧,在他的著作《理解和改变世界》中这样谈道:“我认为科学界应该对这种蒙昧主义和信口开河的混杂产物做出反应,并基于科学和技术标准,对人工智能的前景给出清醒的评估……人们都在热议计算机智能的假想风险,也许把真正的风险掩盖住了,包括引发高失业率、安全性、侵犯隐私权等。”

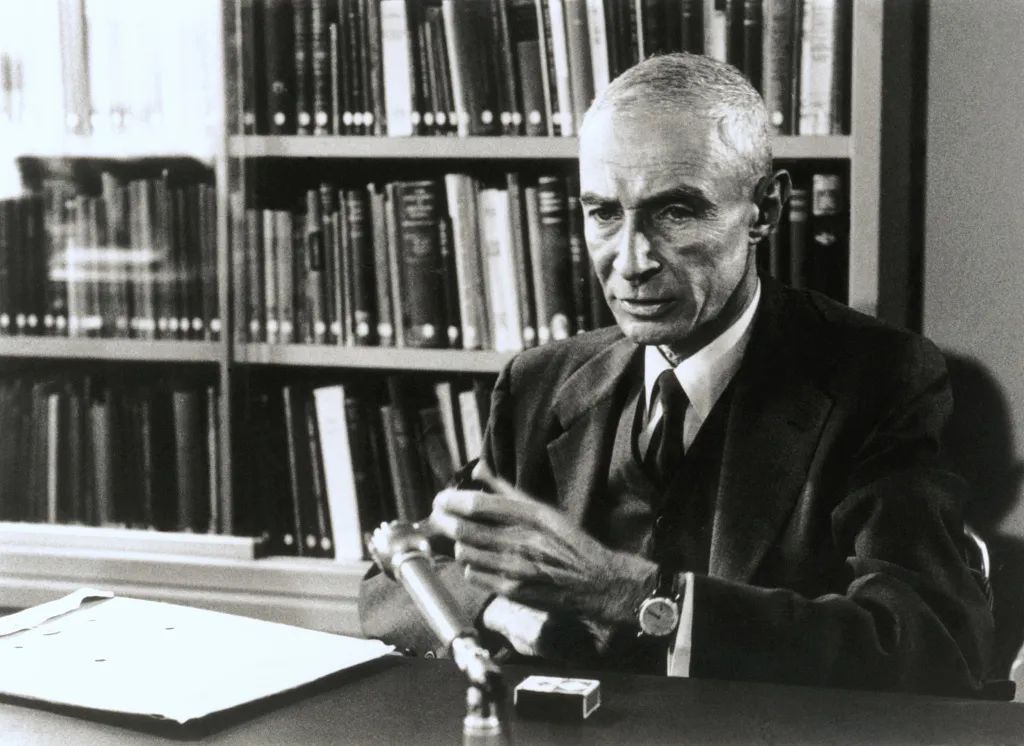

Joseph Sifakis,图灵奖得主、中美法三国院士

Joseph Sifakis 教授出生于 1946 年,是知名的计算机科学家,他的一生都在致力于系统验证和形式化方法在系统设计中的应用,他开发了多个验证工具,提出了解决状态爆炸问题的抽象技术。2007 年,由于在模型检测理论及应用上所做出的杰出贡献,他获得了国际计算机界最高奖——“图灵奖”。

除了图灵奖得主的身份外,他还是中美法三国院士,对教育充满热忱,与中国渊源深厚,是中国南方科技大学计算机科学与工程系的杰出教授,他说“我对中国学生渴望学习和理解事物的热情印象深刻,我希望能持续看到中国源源不断的创新,因为你们有能力构想并实现一些伟大的事情。”

怀揣着好奇心与满载的问题,CSDN &《新程序员》首席内容顾问、技术畅销书《编程之美》《构建之法》作者邹欣代表开发者对 Joseph Sifakis 教授(以下简称 Joseph)进行了深度采访,并在 2023 长沙·中国 1024 程序员节的“新程序员全球人工智能高峰论坛”上进行了压轴直播。采访过程中 Sifakis 教授金句频出,展现了他博学而健谈的一面:

-

开启电传飞控时代的空客 A320:“四十多年前带领 12 位工程师,用 6 万行 C 语言代码和简单的底层硬件开发了飞机控制系统——这些都很简单。”正文还有更多的技术细节揭露!

-

Sifakis 教授近期的研究领域是自动驾驶:“对于关键系统,如自动驾驶汽车,我个人认为最好的解决方案是将神经网络与传统解决方案并行工作。”

-

对「奇点时刻」的看法:“完全是胡说八道,是荒谬的。”

-

程序员到底该不该在工作中使用 AI:“对于经验丰富的工程师来说,利用 GPT 或其他大模型来提高生产力绝对是正面的。”随后话锋一转:“大模型会毁了初级程序员!”

-

AI 的真正风险:“为关键事情做选择的责任从人类转嫁到了机器上。”

-

评价计算机科学的未来:“这个时代的计算机科学家应该具备更广泛的文化知识,因为机器正在被应用于不同的领域。”

-

在采访中盛赞中国:“你们的创造非常有趣,充满激情和年轻的力量,开拓了我的视野。”

12 个人、6 万行代码、1 门 C 语言

开启电传飞控的时代

再强大的机器也不可能战胜人类的智慧。

邹欣:首先,请 Joseph 教授向我们的开发者朋友们介绍一下自己,以便大家能够更好地了解您。

Joseph:我起初在雅典国家技术大学(希腊最古老、最负盛名的大学)学习电子工程,后来出于某种原因我前往了法国学习物理。到了 1970 年,我对物理学的兴趣转移到了计算机课程上,历史上的那一年差不多也是计算机科学的起点。总之,我最终决定放弃物理,转而学习计算机。

我一生中的大部分时间都生活在法国,在那里我创建了自己的实验室,发展了关于系统验证的理论。我们最为人所知的成就包括开发用于空中客车的编程技术、空客 A320(Airbus A320)的嵌入式系统 Ansys SCADE 及其技术认证等。2007 年,我获得了图灵奖,我的一系列工作得到国际的广泛认可。近几年我对自主系统开始感兴趣,尤其是自动驾驶系统。

邹欣:众所皆知,编程技术具有非常广泛的应用领域,有些仅仅是用于低风险场景,而有些则是用于精细的关键系统,比如导航或支持飞机运行的系统等。但据我所知,要证明一个程序拥有 100% 的准确率是非常困难的,几乎不可能。

Joseph:没错,为此我们就必须提供一些证实程序准确率的证据,而这正是空中客车面临的挑战,因为空中客车也是世界上第一批使用数字电传操纵飞行控制系统的商用飞机。这个挑战实际上在于说服认证机构,向他们证明,在用计算机取代了所有的电动机械系统后,放一台电脑在飞行员和飞机的机电部件之间,系统就能正常工作。

事实上,我们不得不为这些系统开发一套编程符号体系以及一个经过认证的编译器。在上世纪 80 年代末 90 年代初,我们真的做了一个编译器出来,并且还应用了一些验证技术。这套系统非常简单,我们只用了不到 6 万行的 C 语言代码就完成了它。

邹欣:整套系统都是用 C 编写的吗?

Joseph:我们用的是那种限制重重的 C 语言,没有任何动态特性。那个时候的另一大限制是系统必须在裸机上运行,没有操作系统,所以确保系统的正确性反倒容易得多。因为如果没有任何操作系统,就只需要像编译器一样生成非常简单的循环代码,再设置一个运行时系统来处理外部事件。总而言之,它的原理其实很简单。

邹欣:这么简单的系统,却完成了一大壮举——据统计,空中客车在 40 年左右的时间里一直以非常安全的记录飞行。

Joseph:这也是为什么我们在验证上所做的工作已经得到了认可。所谓严格的工程设计技术,意味着要从需求出发,并配备一套严格的方案生成代码,且工程师必须对自己的所有决策作出合理的解释,技术实现也必须具有可行性。实际上,只有空客 A380 采用了真正的操作系统来工作,其他空客都是用我上述提到的方法运行的。

邹欣:A380 是一个更先进的型号吧?

Joseph:是的,因为使用操作系统其实会导致更多问题——在我看来,让一个“看似完美的实时操作系统”掌控全局,对于空中客车来说本身就是一大问题。

邹欣:这样的话题对我这个程序员而言实在很有“杀伤力”,所以请让我稍微深入了解一点技术细节。这个程序可以编译并在裸机上运行,那是否存在一个可以运行的硬件抽象层(HAL),还是直接在设备上进行操作?

Joseph:没有,取而代之的是一个小调度器,也就是事件管理器。它非常简陋,只有先进先出(FIFO)队列,程序通过将事件放入这个队列,按照一种循环的方式运行。这种循环程序的核心是通过周期性的方式对输入进行采样,继而处理在某个时间段内到达的所有事件。除此之外还涉及了一些技术细节,但整体来说这就是一种非常简单的循环程序,我们称之为响应式编程(Reactive Programming)。

邹欣:某种意义上,这好像也是一个实时系统,对吗?

Joseph:这是一个硬实时系统,即要求在预定的时间内完成任务,没有任何的中断、多任务处理或优先级。因为我们采用了更传统而简洁的方式,让一个事件处理器来满足硬实时系统的基本需求。这个系统使用的循环程序结构就像那艘著名的“五月花号”船一样坚固可靠,事件触发某个动作,满足某个条件即可执行。整个系统就是一个巨大的循环:当条件为真时,执行某个任务;当条件不满足时,执行其他任务;而处理这些任务的方式是一个庞大的分支结构,执行任务,同时每隔一段时间执行一些操作。

这是一个非常简单的程序,没有动态性也没有指针。原理如此简单,却可以得到一个万分安全的系统,因为它避免了使用多任务处理或优先级处理时可能遇到的所有困难。

邹欣:非常精彩。这是一个相当巨大的 while()循环,在循环里还有很多不同的事件。

Joseph:是的,对于每种情况,确保有足够的时间是很重要的。我们设定了一个固定的周期,时间大约是 10 毫秒左右。这个系统需要确保分析代码、检查每个情况是否能够在规定时间内完成。如果 C 代码足够简单,就可以做到。因此,系统能够提供非常强的响应性保证。唯一的参数就是这个周期,然后你对代码进行分析,针对每种情况进行相应的处理。

邹欣:这一壮举的关键要素在于,你的程序是机器的唯一掌控者,没有其他因素能干扰到它。

Joseph:程序员掌控机器,也就掌控了一切的安全问题。

邹欣:虽然你一直在强调它很简单,但我认为即使从今天的角度来看,这可能仍是世界上最具挑战性且确实可行的系统之一。

Joseph:说到当年,我们还向那些空中客车的工程师学习,借用了一种叫做同步数据流(Synchronous Data Flow)的建模符号表示法。它就像一个巨大、有输入的数据流网络,是一种类似于模块图示语言的存在。我们就是靠从空客工程师那里学到的同步数据流更精确地定义语义、编写编译技术。

空客工程师有着电气工程的背景,所以这是他们理解的语言。对于工程师而言,会更熟悉 MATLAB Simulink 这个工具,它实际上更复杂一些。但现在时代不一样了,工程师们只要编写 Simulink 图表,程序就能直接生成 C 代码。

邹欣:你们大概花了多少人/时间来制作第一个飞行控制系统的版本?

Joseph:当时,我们为此创建了一个实验室。实验室中有 12 名工程师,原计划用三年来开发程序,但实际上只用了两年来开发第一个版本。实验室的全体工作人员大约有 20 人,但并非所有人都参与了这个项目。其中一些人在我的实验室中开发了一种名为 Lustre 的语言,后来 Esterel Technology 公司接管了这个项目,最终发展为一个叫做 Esterel 的工具,如今仍在使用——总之说来话长,这里面的故事多得说不完。

邹欣:用编程语言这种抽象的文本形式来控制数十吨的机器起飞和翱翔,真是一件非常浪漫的事情。

Joseph:在许多行业中,这种思路体现为使用特定领域的语言(DSL)。不必直接在通用编程语言中编写,而是通过 DSL 生成相应代码。这一思想在各个领域都普遍存在,例如 SQL 在数据库领域的应用。使用特定领域语言为系统提供结构化原则,是汽车工业、航空电子和互联网平台等行业的通用做法。通过这种方式,可以有效避免许多潜在问题。

大模型的黑盒是自动驾驶面临的下一道坎

人类思维的计算具有“弹性”——它具有天生的适应机制。正是这种适应机制使得语言和概念的产生成为可能。

邹欣:我目前就职于一家专注于自动驾驶技术的初创公司。我们发现在一些特定条件下,比如高速公路,算法表现相当不错。

Joseph:是 L4 级别吧?

邹欣:我们还处于从 L2 级别向上发展的阶段。

Joseph:嗯……你看,自动驾驶技术如今被分为六个不同级别,其中三个级别用于自动驾驶和驾驶辅助系统,其余三个用于其他系统。在 L3 级别,有一个需要在人类驾驶员监督下行驶的自动驾驶系统,但我认为这个想法并不可行,因为人与机器之间的交互是一个非常棘手的问题。

然后就是 L4 级别的完全自主驾驶,既特定地理条件下的自主驾驶。这种实现方式正在取得进展,中国和欧洲都进行过一些有趣的实验。L4 级别的自主驾驶之所以可能成功,是因为在高速公路或受保护的特殊环境中,情境感知问题相对较为简单和琐碎。

自动驾驶汽车所面临的主要问题是,系统需要能够理解所发生的事件并正确解读。因此,感知功能必须足够可靠,并建立对外部世界的准确模型,这是非常困难的。除此之外,还有人为干涉的因素,这也是为什么在一些论文中我将自动驾驶称之为“疯狂想法”的原因。从我个人的角度来看,虽然制造自动驾驶汽车是一项巨大的科学挑战,但社会可能不应将其作为首要任务。

图源:CSDN 下载自视觉中国

邹欣:如果一个人类驾驶员处于高压力或疲劳的情况下,他可能会犯错,人们对此通常很宽容。但如果是人工智能犯错,就会有很多人认为这是不可接受的。

Joseph:是的,这涉及到多重标准的问题。首先,人工智能的挑战在于它采用了一种与传统计算机不同的计算方式——神经网络的黑盒,我们对其了解严重不足。还有一个备受关注的问题就是人工智能的可解释性,在传统的系统工程中,存在一个原则:如果工程师声称系统具有某个性质,必须提供一种证明其正确性的方法,尤其是对于关键系统。然而,对于人工智能而言,这是不可能的。

缺乏标准是人工智能领域的一个根本问题,也是业界众多讨论的焦点所在,更是系统工程中的一个基本问题。在我熟悉的航天领域里,飞行系统在每小时的飞行中故障率不得超过 10 的负 9 次方,每一架飞机都要经过系统性的验证。我们在生活中构建的任何技术、任何物件,从烤面包机,到桥梁,再到电梯都是经过认证的,世界上任何事物都是经过认证的,而现在对于人工智能却没有任何标准,因为我们无法推理系统的行为。

在美国,一些机构因为缺乏标准,甚至容许存在自我认证的系统。只要像特斯拉这样的公司声称其车辆能够自主行驶,驾驶员就能直接启动车辆,而无需任何形式的保证。这样的想法却能在美国逐渐普及,因为美国在人工智能技术方面占据主导地位。

从比较大模型与人类的角度看,人类具有理解情境的能力,并且拥有“健壮性思维”。健壮性思维指的是人类可能在某个情境下犯错或者正确,但却会保持相对一致的判断和思考方式,而不是在相似的情境中表现出不一致的结果。神经网络则存在异常现象,例如对抗样本,稍微改变输入可能导致系统输出不稳定。这些现象在系统工程中是不可接受的。

我并不是要全盘否定在关键系统中使用人工智能。相反,我认为我们应该致力于开发一些能够提供必要保证的技术,我个人正致力于解决这一挑战。实际上,从不可信任的组件构建可信任的系统是一个历史悠久的难题,可以追溯到冯·诺伊曼的时代。对于关键系统,如自动驾驶汽车,我个人认为最好的解决方案是将神经网络与传统解决方案并行工作。例如,使用一个大型神经网络作为驾驶的端到端解决方案,并同时运行一个传统系统来避免碰撞。这样,我们可以在同一体系结构中整合 AI 和我们信任的传统系统,以确保性能和安全性的平衡。

邹欣:这就是一套混合系统(Hybrid System)。也就是说,自动系统应该专注于技术部分,但在功能设计或其他方面,我们应该采用传统的系统工程方法。

Joseph:无论如何,系统工程方法是必要的。如今,像 Waymo 和英伟达(NVIDIA)这样的公司拥有自动驾驶平台,只要有钱就能购买他们的服务。这些自动驾驶平台基于神经网络,它们从摄像头接收图像并生成加减速和转向信号,也就是我们所说的“端到端的 AI 解决方案”。

然而,这些系统的可信度无法得到担保。如果自动驾驶公司想将系统集成到汽车中,就必须考虑传统系统工程的因素。这包括将其集成到电机机械系统中,并分析在故障情况下的反应,如发动机故障或爆胎。

传统技术存在一个问题,即模型驱动方法与神经网络这种黑箱的集成问题。我们无法理解神经网络内部的运作,而基于模型的解决方案则可以提供内部信息以及不同危害的传播方式和对策。所以你会发现,在自动驾驶领域还有很多问题是人们没注意到的,这些问题与智能解决方案无关,而是与系统工程息息相关。

邹欣:你刚才提到了爆胎的情景。从系统工程的角度来看,如果发生爆胎,可能意味着传感器信息显示某个轮胎的压力低于正常水平。

Joseph:如果是传统系统的话,就很容易想象到这种风险是如何在控制系统内得到监控的。

邹欣:毫无疑问会触发某些事件处理器。

Joseph:我们都熟悉传统系统,了解如何处理、如何创建应对这种情况的机制,即我们所说的容错系统等。但是对于大模型神经网络,所有这些理论都无法迁移到神经网络上。特别是因为神经网络的黑盒无法被分析,也无法对风险传播等方面做出任何判断。因此,我们在传统系统上进行的故障分析在神经网络上并不适用。

邹欣:这是一个非常重要的观点,不能让黑盒完全掌控一切。它可以是系统的重要组成部分,但不能是整个系统。

Joseph:这是很多人今天正在努力实现的理念——在正常情况下能够运行的黑盒+非正常和特殊情况下的另一个系统。这个理念看似简单,但两个系统如何合作是一个仍然悬而未决的问题。

邹欣:这也是为什么大多数自主驾驶系统仍然停留在 L2 阶段的原因。

AI 可以做出非凡的事情

却不能理解世界

认知论的问题(How),其关注的是“如何”“怎样”。例如世界如何变化、我们如何思考、如何建造建筑以及鸟类如何飞行等。这些问题的答案使我们能够理解或改变世界。

邹欣:在你的职业生涯中,你参与并见证了许多技术创新。常有人说我们往往高估了一项新技术的短期影响,而低估了它们的长期效果。你能分享一个例子吗?

Joseph:这样的例子太多了,一个新想法有可能被重视,但更多时候是被轻视。但让我们以人工智能为例,你应该知道它经历了起起落落。1982 年,日本的国际贸易与工业部(MITI)曾启动了为期十年的计划。

邹欣:是第五代计算机吗?

Joseph:没错,当时这是一个巨大的事件,目标是结合大规模并行计算机和逻辑编程,打造能支持人工智能未来发展的超级计算机。我还记得当时日本花了很多钱,并激发了美国和欧洲的其他项目蓬勃生长。结果所有这些项目都因为过高的野心而失败,因为当时的焦点是符号主义 AI,而最后联结主义 AI 通过神经网络反超,没有人能想象到神经网络如此强大。总而言之,符号操作系统和逻辑编程语言被高估了,成为了历史的尘埃。

第五代计算机计划的产物——PIM 计算机(图源:维基百科)

邹欣:我记得有个逻辑编程语言叫做 Prolog,相当受欢迎。

Joseph:Prolog 和很多其他语言在竞争,其中有一个就是我们熟知的 Lisp。这些都是所谓的 AI 语言,因为人们曾认为 AI 是一个语言问题,但我认为 AI 是一个更深层次的问题。而在本世纪初,神经网络作为被低估的方案,出人意料地取得了显著进展。

邹欣:我认为那个年代的人们没有意识到数据的重要性。训练一个神经网络需要大量的数据,例如为了理解手写文字,就需要大量的数据。

Joseph:应用统计分析技术需要时间。在 80 年代,我们也尝试过使用神经网络进行实验,但由于问题规模和数据可用性等原因,并未取得令人信服的结果。

邹欣:“第五代计算机”之后还出现了一个叫做人工智能寒冬的时期,全世界都对 AI 非常失望。

Joseph:确实,最初符号主义人工智能思想占据主导地位,但不得不说这是一个伟大且具有挑战性的想法,因为我认为它更加理性。符号主义 AI 曾强调句法和语义的区分,但未能奏效。而今天的大语言模型在思想方面明显不同,却解决了这一问题,它们无需区分句法和语义,只需考虑文本,通过建立词汇与所有可能用法的概率联系,使用简单算法预测下一个最有可能的单词。而实现这一切仅仅是因为人类有了数据,有一个数亿或数万亿参数的大模型。

邹欣:所以人们不再使用象征性和确定性逻辑,而是依赖统计学和统计模型,斟酌下一个词生成的可能性。

Joseph:基于上下文的统计模型实际上并不理解文本,因此它们容易产生无意义的结果,而符号主义 AI 依赖于语义,这是一个明显的区别。

邹欣:但这牵涉到理解的核心概念。你的书名是《理解和改变世界》,“理解”具体指的是什么呢?你怎样定义这个词?

Joseph:至少对于有意识的理解来说,这也是可以争论的,人类会经常下意识地自动思考一些事情,其中就存在一种理解。但由于我们无法直接描述这种理解是什么,所以从认识论的角度来看,我会说“理解”至少意味着你对世界建立了一个模型。

人类会在脑海里建立一个关于世界的模型。在我们分析句子的时候就会调用这个模型,我们会在阅读书籍的时候尝试理解每个词的意义,并将其组合,最终理解多个概念的构成。但这种理解的方法只适用于人类,无法应用于机器上。

实际上这是人类和机器之间的一个显著区别,因为人类拥有常识。我曾在一次演讲解释过这个显著区别:例如,有报道称特斯拉汽车将交通信号灯错误地认作月亮,或者将月亮误认为黄色的交通信号灯,而这种情况永远不会发生在人类身上。为什么会这样?因为我们具有常识推理和常识理解的能力,我们深知交通信号灯不可能出现在天上。

从出生开始,我们就构建了一个外部世界的模型,并通过积累经验不断丰富这个模型。通过这个模型,人类能理解诸多事物,比如父亲的年龄大于孩子的年龄,不进食会导致饥饿等。然而,如果要向神经网络解释这些事情,就必须从定义父亲、孩子、食物等基本概念开始,而这些概念是我们人类思维中固有的。

邹欣:这是否意味着我们的人工智能还处于非常早期的阶段呢?例如,人类的婴儿或者蹒跚学步的孩子也有可能混淆月亮与交通信号灯。

Joseph:没错,人工智能和一个成熟的人是截然不同的。在我的书中,我提供了许多这样的例子。当我们理解一件事情时,我们通过感官获得信息,将这些感官信息与我们思维中的概念联系起来。

比如,当我向你展示一张雪覆盖了一部分停车标志的图片时,你看到后就会说,“哦,这是一个停车标志”,毫无疑问,为什么呢?因为感觉信息进入你的大脑,你知道什么是停车标志,知道它的形状、颜色、位置等。而如果你想要训练一个神经网络去识别停车标志,你需要为它提供大量不同天气条件的训练数据,这是一个很大的区别。这也是构建自动驾驶汽车技术所面临的问题。

停车标志(图源:CSDN 下载自视觉中国)

问题是,如何让机器以一种非常高效的方式来理解世界?目前人类智能依赖于两种模型。我们有来自感官信息、由大脑处理的数据库知识,还有心理模型的符号模型。人类知道如何将这两者连接起来,而今天人工智能面临的挑战是我们不知道如何连接这两种类型的模型,即数据库和符号模型。

邹欣:现在的人工智能,通常称为 ChatGPT 的 AGI 模型,很受欢迎。但在科学家中也有些人对 ChatGPT 的强大表示怀疑,比如杨立昆(Yann LeCun)教授。总而言之,对于我们是否会到达 AI 超越人类的“奇点时刻”,世界上似乎出现了不同的声音。你对奇点有哪些看法呢?

Joseph:很多学者提出了关于奇点的奇怪理论,比如库兹韦尔。我觉得这些理论完全是胡说八道,是荒谬的。他们的观点是,人类未来将达到一个点,机器的晶体管数量或其他参数会超过我们大脑中的神经元数量。但任何一位理性的工程师都清楚,这就是个愚蠢的论点。为什么呢?因为智能并不仅仅是数量的问题,而是在于如何组织数据以接近人类的智能水平。所以从技术角度来看,这个论点站不住脚,纯粹是无稽之谈,我不会再讨论这个了。

奇点时刻来临(图源:AIGC 生成)

人们喜欢听一些耸人听闻的故事,对吧?如果我告诉你明天地球将被火星人入侵,那肯定能上头条。人们就是喜欢刺激,不太愿意认真思考。我们人类明明面临着很多问题,比如气候变化,但更多人愿意沉浸在娱乐性的故事中。

但我们还是可以聊一聊人工通用智能。我们离人工通用智能还有多远呢?首先,我们应该就智能的概念达成一致。实际上,这也是我写《理解与改变世界》的原因。如果你想变得聪明,就必须先理解世界,这也是我选择这个标题的原因。如果翻阅牛津词典,可以查到智能的定义就是能够学习、理解和逻辑思考世界,并且执行任务的能力。

机器可以做出非凡的事情,却不能理解世界。例如,你不能让 ChatGPT 来驾驶一辆车,也不能让 ChatGPT 来操作一个智能工厂。历史上对于智能的概念存在许多讨论,比如著名的图灵测试一直以来都备受争议。图灵测试的原理就是问问题,我觉得它并不是一个好的测试。你可能在媒体上读到过一些报道,某些人会发表论文声称自己的机器通过了图灵测试,实现了真正的人工智能。但这些都是站不住脚的论点,不够技术也不够有深度。

邹欣:他们对问题的考虑显得过于简单了。

Joseph:不止如此,从工程角度来看会发现两个问题。

首先,实验者的主观判断可能导致不可靠的结论,因此我们不能仅仅依赖于他们的意见,需要其他客观的标准来做出决策。其次,实验者可能会选择有偏见的问题,倾向于提出对机器或人类有利的问题。比方说,我可以问你“根号 2 等于多少?”普通人可能无法提供足够精确的答案,而机器却可以。

目前存在一种更为复杂的图灵测试,但仅仅是对话形式,并不能全面评估智能。还有人引入了替代测试的概念。其核心思想是,如果机器在某一特定任务上的表现能够与人类媲美,那么机器在这个任务上就具备了与人类相当的智能。以驾驶为例,我们强调了需要考虑多个技能的综合运用,而非仅限于单一的智能表现。

最近我写了一篇关于这个的论文*,说明我们还有很长的路要走。目前我正在努力理解驾驶员的技能,一个驾驶员至少有 15 种不同的技能——车辆操作、空间感知、危机决策、方向感等等,他们通过结合这些技能来驾驶。也许人类在每种技能上都不是很擅长,甚至对于每种技能都可以找到一个比人类做得更好的机器,但人类的特点就是可以管理所有这些不同的技能,并通过结合这些技能来达到目标。我不知道未来的智能是否能够达到这种水平,可能那时我已经没机会见证到了。

* 此处提到的论文指《Testing System Intelligence》,发布于 2023 年 5 月 19 日

对大模型的依赖会让我们不再承担选择的责任

科学技术的进步对于那些不配管理和引导它的社会来说是无用的,甚至是危险的。即使是最完善的法律体系在没有自由遵守道德规范的情况下也是无效的。

邹欣:很多程序员认为当前的人工智能浪潮威胁到了他们的生存,但这一浪潮也为他们带来了更多机会。敏捷软件开发的倡导者肯特·贝克(Kent Beck)曾经在推特上写道,“我很不情愿地用 AI 试着写代码,发现它可以让我的 90% 技能被取代,但是,它可以让我剩余的 10% 技能放大一千倍。”你同意这种观点吗?

Joseph:关于在编程或系统工程中使用大模型,我想强调一些非常重要的事情。我认为对于经验丰富的工程师来说,利用 GPT 或其他大模型来提高生产力绝对是正面的。然而,对于初级的程序员而言,完全依赖大模型可能带来一系列问题。因为他们需要学习如何组织错误、设计系统以及构建程序结构。编程并不仅仅在于编写简单的函数,更在于如何设计代码和系统的框架,以确保其健壮性。而大模型对此帮助有限,因为设计和编写代码片段之间存在明显的差异。

我建议入门阶段的程序员避免完全依赖大模型,而是尽可能亲自编写代码,因为这有助于培养他们的技能。由于他们缺乏经验和专业知识,他们可能难以察觉大模型中的错误和故障。

然而,对于经验丰富的程序员或系统工程师而言,情况就不同了。他们可以通过处理大模型永远无法完成的任务来提升生产力,这些任务包括代码结构、软件设计和软件架构等高级工作,是系统工程师的立足之本。

邹欣:例如,中学生在学校考试的时候是禁止使用计算器的,但是长大之后又可以了。

Joseph:完全正确。所有这些技术的风险都集中在年轻一代。在法国的一次采访中,我曾表示我们应该禁止中学生使用 ChatGPT,原因是学生可能对此形成过度依赖。如果年轻时未能学会如何组织思维、智力成熟以及在不同情境中作出选择,那长大后就会产生问题。即使是学习乘法——我指的不是背乘法表,而是通过类比建立“数感”。我见过年轻人完全失去对数字的感觉,无法将数量联系起来,失去了通过解决算术问题获得的经验性判断能力。

邹欣:缺乏详尽的第一手实践,年轻人就会失去对现实世界的感知。

Joseph:这就是问题所在。当人们过分依赖机器和外部系统时,他们可能会与现实脱节,导致严重的后果,比如无法区分月亮和交通灯。对于个人,特别是年轻人来说,不去过分依赖科技是至关重要的。

邹欣:所以说,一个人可能会因为过度依赖其他系统的帮助,从而失去对现实的感知?

Joseph:这不是我的推断,而是来自现实生活的经验论。人类的意识特征在于,任何时刻我们都能感受到周围发生的事情,理解世界的状态,理解可选的方案。我们在生活中有目标,并且必须管理这些目标,基于此做出需要承担个人责任的决策。这也是一些哲学家所谓的“自由意志”,我们行使自己的自由意志,选择去做这件事而不是那件事。

现在,假设有一个面对未来踌躇不定的男孩,为了做出决策,他可能会去问最火的大模型,“我是应该成为一名医生还是一名工程师?”

你发现了吗?选择的责任从人类转嫁到了机器上。如果人工智能生成长篇大论的答案,给这个男孩详细分析为什么做一个工程师比做一名医生更好,那男孩可能就会受到影响。但是,他自己的偏好是什么呢?他的梦想又在哪里?究竟是大数据的推荐算法决定了我们的偏好,还是我们掌握着自己的偏好?

在我的人生中,我必须做出许多这样的决定,这是我作为一个人的责任。我当年决定停止学习物理学,转而学习计算机科学。我父亲就强烈反对这个决定,但是我承担了选择的责任。如果承担了责任,就必须为此而奋斗,成为一个负责任的人。人类可以自行选择并努力实现目标,这就是人类的本质,如果我们失去了这种选择和承担责任的能力,可能会永远不再快乐。

邹欣:谈及外界因素对个人的影响,你在书中也提到了媒体煽动性报道问题。你用了一个词“media sensationalism”来形容媒体的这种行为,这是什么意思?对于中国读者来说,这是个新鲜词汇。

Joseph:现在有很多书大谈阔论世界末日,宣传人类历史的终结将会是人工智能,机器终将统治人类。很多名人也明里暗里支持这些观点,比如埃隆·马斯克、比尔·盖茨等等,而让我从逻辑上分析,这些完完全全就是胡言乱语。因为世界上的任何一种技术都可以通过诡辩来夸大类似的威胁。

让我举个例子,原子能。我们可以用原子来产生电力或制造炸弹,并将其普及到其他技术上面。所以对于我来说,技术是中性的,而如何处理技术是人类的责任。目前所有声称人工智能灾难论的声音都是为了同一个目标,那就是宣传人类将面临一种命中注定的灾难,而我们对此无能为力。这正是他们的核心观点。最终社会上被分为两派观点,一派声称大灾难要来临了,另一派声称“噢,那就随他去吧”,你会发现这两派看似对立,实际上都在宣扬我们不需要采取任何行动来阻止灾难。

所以,在很多采访里我都会说,政府对此需要承担巨大的责任。我们该做的不是无止境的宣传,而是做出实际行动控制这些技术的发展。直到 20 世纪末,所有的科学和技术都在推动进步。进步就是为了人类的福祉,使人们更加幸福地来控制科学,控制世界。而到了某些人的口中,技术进步变得不再重要,人类变得无足轻重,因为机器人马上就会统治世界。这是非常糟糕的。

邹欣:你的观点提醒了我一件事。请问你有没有看过电影《奥本海默》?

Joseph:我没时间看,但是我很熟悉奥本海默的故事。

邹欣:这部电影虽然长达三小时,但却引人入胜。它讲到,原子弹爆炸在全球引起了轰动,当时也有大量的世界末日论。但是历史却证明了大多数国家合作确保原子能被用来产生大量的、可控的能源,造福人类。

Joseph:所有人类文明都依赖这个观念。从 17 世纪的法国启蒙运动开始,人类以科学和技术为中心的思想一直控制着历史的演进,这是所有人类文明的核心思想。但有趣的是,直到 20 世纪,在哲学上还存在一个问题。哲学家们开始思索如何理解世界,而人类的幸福在其中起到了重要的作用。无论是马克思主义者还是存在主义者都在探讨如何让人类更幸福。

而今天却冒出一些哲学家们传播世界末日的思想,宣告人类历史就要结束了。在美国有很多这样的书籍,我认为这些都是愚蠢的观点。我们应该保持人类作为我们历史中的主要参与者的角色,杜绝机器作为主导者的可能性。

奥本海默(图源:CSDN 下载自视觉中国)

新时代的计算机科学需要多元化的知识

人类在主动学习方面依然领先于计算机。因此对于儿童的教育,其目标不仅要教会他们知识,培养他们的批判性思维,还要重视培养他们获得经验的技能。

邹欣:你在计算机科学方面有着很长的职业生涯,从电子工程到计算机专业,从希腊到法国……所以我想,你一定遇到过许多导师或学者,你可以谈谈其中一个对你影响最深、你最欣赏的科学家或者教授吗?

Joseph:我认为对我影响最深的导师实际上是我在高中的老师,而不是大学里的教授。

邹欣:高中?

Joseph:高中生会对所学到的东西印象非常深刻。我很幸运地遇到了一群优秀的高中老师,他们不仅传授知识,还教我如何思考、如何应用知识以及如何培养好奇心。我还因自己是希腊人为荣,我能在小时候就有机会热爱古希腊语言和文化,这一点在我的书中也有体现。

此外,在我上高中的那个时候,教育还未染上政治色彩,不像今天的欧洲一样充满煽动性。我们更多地是被鼓励学习数学,而我热爱几何学,因为几何学要求很多创造力和严谨的推理。

邹欣:所以你的高中老师对你影响最大。

Joseph:当然,我在大学也遇到了很多卓越的教授,但是高中让我成功爱上了科学与创造。我觉得这个道理可以适用于所有人,因为高中是人生中的重要节点,如果在高中就对科学没有兴趣,那么到大学也没什么机会爱上科学。总而言之,让孩子接受正确的教育真的非常重要。

邹欣:在当前的中国高中,大多数老师关心的是如何帮助学生通过高考,追求高分,并没有鼓励研究。

Joseph:研究也很重要!学校是为了传授知识而存在的。但传授知识不是教人背书,而是构建学生的思维和培养创造力,教导学生应用自己的知识。我有来自不同国家的学生,有些国家的学生必须死记硬背很多东西,但他们不知道如何应用自己所学之物。而这种应用知识的能力是要在年轻时培养起来的。

在西方的教育体系中,已经进行过许多改革,试图使教育更加自由。不少西方心理学家宣扬应该放任孩子们的自由,导致孩子们缺乏努力的概念。努力是非常重要的。我曾花了好几个小时试图解决一个数学问题,当时我只是想着要努力完成一件事情,但现在我意识到一次次的努力对培养我的创造力和专注力至关重要。

我发现现在的小孩子都喜欢短视频,比起文字更喜欢更生动的表现方式。他们无法专注于某件事。只有练习专注,才能组织自己的思维。

邹欣:在您的书中,您提到了建立计算机科学和数学之间联系的重要性。在当今社会,程序员们应该如何学习或掌握足够的数学知识,以在计算机科学领域取得卓越成就呢?

Joseph:以人工智能为例,开发神经网络就需要深入的数学知识。神经网络曾被认为是一种算法,但实际上这是错误的概念,事实是程序员必须编写算法来训练神经网络。这些算法就涉及到大量的数学,包括应用数学甚至是物理学的理论,比如熵的概念、热扩散等等。因此,对于现代的程序员而言,仅仅擅长编写代码是不够的。

现在有了 ChatGPT,导致程序员的价值在不断地降低。所以我认为这个时代的计算机科学家应该具备更广泛的文化知识,因为机器正在被应用于不同的领域。比方说,如果一个程序员想编写嵌入式系统的程序,就应该了解实时控制问题,了解控制与环境的互动意味着什么。此外,可能还需要了解物理系统之外的模拟器,这就涉及到机械工程问题。有些情况下,编程甚至离不开生物医药方面的学问。而这一切可以在大学里学到,程序员应该有广泛的文化背景。

邹欣:广泛的文化背景?能展开说一下吗?

Joseph:我拥有电气工程的背景,后来学习了计算机科学。我曾经遇到一些计算机科学家,他们是出色的程序员,但如果他们不理解电气工程的概念,比如图像处理、电气工程甚至机械工程中使用的应用数学,就显得有些不足。

我建议年轻人努力获取数学、物理科学等多方面的广泛知识。现今的课程可能过于专注于人工智能,但人工智能是一门知识吗?人工智能本身什么都不是,这个技术是基于多元化的知识构建而成的。人们应该具备科学背景来理解和应对未来可能的挑战,编程教育应该更加注重培养学生对多学科知识的理解,而不仅仅关注短期技能。

众所周知,全球就业市场非常不稳定。今天需要一名人工智能专家,明天可能就需要其他的东西。如果没有广泛的文化背景,那么未来必将困难重重。

邹欣:我深有同感。当今的编程教育存在一个问题,老师们过于关注短期技能,只教学生如何操作数据。我们一般称之为 CRUD(创建、检索、更新和删除)。

Joseph:看看麻省理工学院这样的美国顶尖大学,看看他们是如何培养人才的。MIT 的学生可以在学习计算机科学的同时自由选择许多其他学科的课程,其中就有非常优秀的数学或物理课程。

现在的大学里有这种多元文化的生长空间,有些学校甚至会把电子工程和计算机科学合并在一起,称之为 EECS 部门。相比之下,单独的计算机科学课程成为了一个坏主意。

著名的 MIT EECS,既麻省理工学院电气工程与计算机科学系(图源:维基百科)

邹欣:所以,编程本身可能只是计算机科学教育的很小一部分。

Joseph:没错。计算机科学是关于我们如何使用机器来发展知识,而不同类型的知识会让这门学科更加广泛。

缺乏批判精神是这个时代的症结

社会衰落的一个特征是平庸的人物在公共生活中大行其道。

邹欣:我想再谈谈书名《理解和改变世界》。在改变之前,我们要先理解。这样的话,会不会有教育家主张为了理解而不需要接受大量的知识?

Joseph:是的,这个时代上网就能找到知识,我们已经不再缺乏知识的获取途径了。问题是如何建立、组织脑海中知识的城池,利用我们拥有的知识创造一些东西。

我的书中就有谈到不同类型、不同层次结构的知识。在顶部是所谓的元知识,有些人称之为“智慧”。智慧意味着无所不知,但问题是,全知者能不能利用这些知识解决问题?世界上多的是缺乏广泛知识的人,但有些人懂得如何管理自己所拥有的少量知识来解决问题。

邹欣:这种空有知识却不懂应用的人,就是所谓的“书呆子”吗?

Joseph:是的,他们面临着无法解决实质问题的困境,缺乏批判思维,对知识的理解有限,因此在做出高效决策方面存在问题。

邹欣:在书中的最后几章,你分享了一些关于社会、精英治理和民主的见解。你能解释一下精英治理是什么意思吗?它与其他学派的观点有何不同?

Joseph:我认为民主实际上依赖于两个基本原则。首先,人们可以平等地在法律面前表达自己的意见,这是一方面。而另一个同样重要但未得到充分强调的方面是,民主是一个能够选出最杰出、最有才干的人才来治理的体制。

我认为今天的西方国家普遍存在治理方面的危机,这一点甚至能从每日的新闻报道中得出,几乎每一位公民都认为自己未能票选出最杰出的人担任治理职位。至于原因,我就不再深入分析了。

民主的生存至关重要。至少在西方国家,我们正面临着深刻的危机。如果我们的体制无法培养出优秀的精英,并且这些精英致力于公共利益、不腐化,那它们都被一个精英群体所取代。至少是在西方世界里对其构想的方面,那将是民主的一个重大危机。

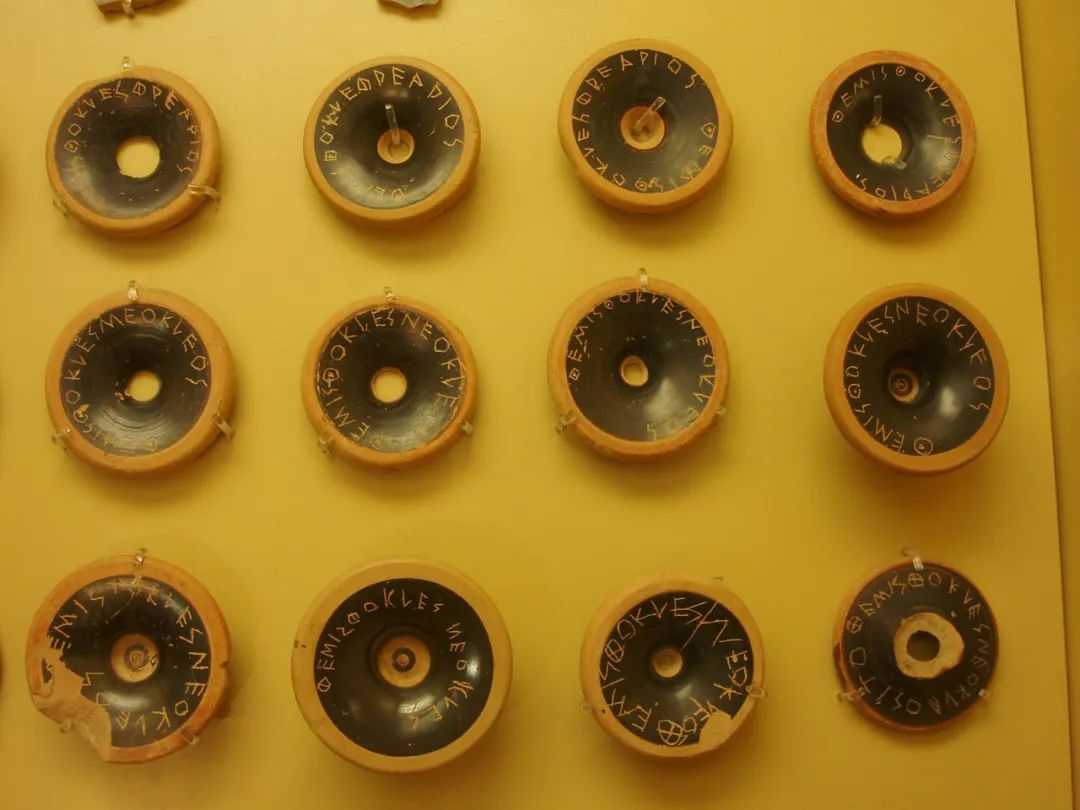

邹欣:这让我想起了古希腊的陶片放逐法。在雅典有个制度,所有公民都可以投票来决定哪个人被驱逐。其中有一位很著名的政治家也被放逐,很多人并不了解他的具体行为,只是讨厌他的名声而投票放逐他,这是精英治理的反面吗?

Joseph:强大的个体对民主而言无疑是不利的。然而,雅典的民主模式是建立在一个小城市上的。我认为,在每个民主国家里,都应该有一些机制来控制权力。

而西方社会今天面临的一个问题是,有些人已经变得像政府一样强大,甚至过犹不及。举个例子,埃隆·马斯克在金融和技术方面的影响力是巨大的。他在西方世界比许多政府更具有影响力。我认为我们应该建立一些控制机制,用来约束这种现象。很不幸地是,这个问题并没有得到足够的重视,但我们应该在全球范围内建立控制机制来应对这种情况。

曾用于驱逐雅典执政官地米斯托克利的陶片(图源:维基百科)

邹欣:所以平衡是很重要的。

Joseph:非常重要。

邹欣:另外,还要保持一种宽容的态度。否则,任何新的想法都可能会被那些相对落后的人拖垮。

Joseph:这就是另一种现象了。我谈论西方世界是因为那是我生活的地方,而现在有些人变得非常不容忍,导致一些话题很难进行讨论。

邹欣:实际上,我们的对话已经触及了不少深层次的问题。如果有越来越多的不敢谈论的议题,这可能不是一个好兆头。对于进步和理解来说,我们需要更多自由分享和讨论的空间。

Joseph:这些问题非常纷繁复杂,因为它们牵涉到平衡的问题。我认为当权力过于集中时,人就会变得傲慢,对其他声音不够容忍,这是很自然的反应。因此,我们需要在各个层面上保持平衡。

目前,我们在许多领域都面临缺乏平衡而导致困扰。这不是在说我们没有讨论自由,而是很多观点被大型媒体强加给人们,导致大众对人工智能产生过度追捧。而这都是这是由大集团共同推动的结果,所以我认为缺乏批判精神正是这个时代的症结所在。

邹欣:所以,如果一个社会或者一个生态系统不容忍少数意见,会变得相当危险。

Joseph:是的,但问题比较微妙。即使现在你有不同的观点,也无法被充分倾听。这不仅仅是容忍的问题。主导当今观点的力量非常庞大,即使你高声疾呼反对,也可能被完全忽视。它可能会被掩盖,而媒体也可能选择不予报道。

我可以举个例子,我的书在西方并没有特别成功,因为我选择的道路与主流思想相左。然而,在中国却取得了成功。根据我在一些平台上看到的评分,我认为它算是成功的。我认为这之所以成功,是因为人们在接受新思想方面更加开放,不像其他地方那样容易受到主导观点的影响。

邹欣:确实很有趣,因为你拥有一种所谓的“光环”,毕竟你是图灵奖得主。中国文化的特点就是我们真的很尊重那些取得崇高学术地位的人。总之,我们当然希望听到更多你的想法。

Joseph:我认为在中国,人们同样非常尊重知识,基于传统更加尊重那些带来知识的人。我对中国学生渴望学习和理解事物的热情印象深刻。这些价值观对我们的文明至关重要,在一些西方国家已经失去了。年轻人不再像过去那样努力学习和获取知识,而更多地追逐虚荣、健康和富裕。当然,这些东西可能也很重要,但更重要的是你获取了多少知识。

人工智能问题不能操之过急

技术的应用解决了人们的许多实际问题并使生活变得更舒适,但这也意味着我们丧失了某些解决问题的技能。

邹欣:最后,让我们稍微聊聊你在中国的经历。你多次访问中国,并在几所中国大学任教。相比其他西方学生,你对中国学生有什么印象?

Joseph:正如我先前提到的,我觉得中国学生更有动力。他们对获取知识充满渴望,而且对那些传授知识的人充满尊重,展现出一种在中国常见的活力。我认为中国人非常有动力去追求目标,对未来有着远见并且能够取得显著成就。而一些西方国家似乎显得有些疲惫,人们缺乏奋发向前的动力。

一些中国城市,比如深圳,让我感到非常良好。我未来计划再次访问深圳。此外,我发现在像深圳这样的城市,拥有美丽的建筑和宜人的生活环境。相较于我曾访问的其他国家,更多的是一些统一而缺乏美感的建筑物。而在中国,你们拥有现代化且令人印象深刻的基础设施,对美的追求非常热衷。你们的创造非常有趣,充满激情和年轻的力量,开拓了我的视野。

邹欣:中国的领袖经常展现出“我能做” (can do)的态度,他们真的会付出努力去实现目标。

Joseph:是的,这点非常重要,也是中国的优势。在我的书中也有提到,一些西方民主国家的政府现在过于依赖金融,导致国家力量减弱。我希望能持续看到中国源源不断的创新,因为你们有能力构想并实现一些伟大的事情。

我可以分享一个故事:当我第一次访问中国时,我作为安全关键系统的专家被邀请到北京开会,有人向我介绍待建的高铁项目。会议结束后,我告诉我的妻子,“这些人的条件太差了,他们永远无法建造出高铁。”但是你们最终建造出比法国高铁更为先进的列车。恭喜你们,因为你们做到了。当时还有些人谈到研发中的新型商用飞机,我不记得代号了……

邹欣:C919。

Joseph:C919。它是空客 A320 的一种等效机型。你们成功将它建造出来,只因为你们有这个愿景,并投入了所有的努力、所有的资金、所有的力量来实现这些目标。这正是中国的优势。

国产商飞 C919(图源:CSDN 下载自视觉中国)

邹欣:说到超级列车,我也去过欧洲好几次,并坐了一趟欧洲之星,从意大利到法国。

Joseph:我认为中国的列车要好得多。

邹欣:欧洲之星是很好的列车,也存在不少改进的余地。但它似乎只停留在自己辉煌时期的水平,并没有更进一步。

Joseph:是的,我觉得中国已经建立了非常好的基础设施。至少我参观过的城市都有着非常现代化的基础设施。这和我所看过的 90 年代中国截然不同。

邹欣:实际上这引出了一个非常有趣的计算机科学问题。和旧基建一样,计算机界也存许多遗留系统。比如一个运行了 20 年的软件,要改进就非常困难,甚至不如推翻重来。

Joseph:确实如此。

邹欣:所以,改进和更新遗留系统是相当困难的任务。但如果从零开始,可以利用最先进的技术,即使是从最基础的层次开始,最终建立起非常现代化的基础设施和系统。我在编程领域已经有 20 多年了,一路上目睹了很多类似的情况,改进现有系统确实很有挑战。

Joseph:大部分遗留系统已经运行了 50 年甚至 60 年,要想改进它们确实是一项巨大的任务。

邹欣:中国和希腊都有着悠久的历史,所以很多传统都难以改变。正如你的书名所说,“理解”了才能“改变世界”。对于如何改变一个遗留系统,您有什么建议吗?

Joseph:从零开始构建一个能够替代旧系统并整合基础设施的新系统,是非常具有挑战性的。我想说的是,这是一个相当复杂的问题,因为你无法仅通过更改部分来替代它。所以,在构建大型系统之前,最好提前制定出良好的政策,而不是被自己过往的选择所束缚。如果成为了过往选择的囚徒,那很多事情都可能出错,甚至积重难返。

在 ITU 仍被称为 CCITT 的那个年代,我在法国电信公司当过研究员。研究员必须先提交申请,详细说明公司的协议在运行和设计方面多么良好,并且可以进行验证等等。这种做法现在已经被废弃了,现在如果有一个协议,只需构建一个参考架构测试,然后就能投入使用。但这是有代价的,因为在快速推进的过程中,很容易会做出一些不可逆转的选择。

就我个人而言,我建议大家都放慢一些,尤其是在面对巨大问题的情况下更应慎重。如今在网络安全方面,全球面临着巨大的挑战。如果不了解系统的运作方式就无法确保其安全性,即使是相对简单的系统也是如此。我更倾向于采用更程序化的方法,尽力掌握软件的控制权,特别是在涉及关键基础设施结构和类似情况的系统时采用这种方法。

邹欣:所以关键是在采取行动之前先试着去理解。

Joseph:确切的说,是要遵照科学和严谨工程的规则。要进行理性上的理解,而不是情感上的理解。现如今有很多有关人工智能的论文,会介绍负责任的、道德的、对齐的人工智能。但这些论文大多不符合工程学的基本规则,作为一个工程师,如果我要介绍一个系统并给出特性,我也应该给出验证这个特性的方法。所以,如果一个人不了解人类伦理是如何运作的,他就无法验证自己的系统是否是道德的,这违背了任何标准的工程实践。

邹欣:的确,基于感觉的快思考和基于理性的慢思考都有其优势。

Joseph:人类的思维正是如此。快速思考是一种辅助处理器,走路就是一种快速思考,我只要想走路就可以走路。但理性思考是基于模型的,需要先给辅助处理器下达指令,再完成编程、演奏乐器等复杂任务。所以原则上,人工智能也应该这样工作。

Joseph Sifakis《理解和改变世界》