Title: Efficient Semantic Segmentation by Altering Resolutions for Compressed Videos

PDF: https://arxiv.org/pdf/2303.07224

Code: https://github.com/THU-LYJ-Lab/AR-Seg

导读

视频语义分割(Video Semantic Segmentation, VSS)由于是要对高帧率视频进行逐帧预测,因此是一项计算量很大的任务。最近的研究中,为了实现计算高效的VSS,提出了紧凑型网络架构或自适应网络策略等。然而这些工作都没有考虑到影响计算成本的一个关键因素:输入分辨率。因此,作者提出了一种名为AR-Seg的交替分辨率网络框架用于视频分割,以实现高效的VSS。AR-Seg旨在通过对非关键帧使用低分辨率来减少计算成本;同时为了防止因降采而导致的分割性能下降问题,作者设计了一个交叉分辨率特征融合CR-eFF模块,并使用一种新的特征相似性训练FST策略进行监督。 具体来说:CReFF首先利用存储在压缩视频中的运动矢量,将高分辨率关键帧的特征高效融合到低分辨率非关键帧上,以实现更好的空间对齐,并采用局部注意机制有选择地聚合关键帧中的局部特征。此外,提出的FST通过显式相似性损失和共享解码层的隐式约束,对聚合后的特征进行监督。在CamVid和Cityscapes数据集上实验表明:AR-Seg在保持高分割精度的同时,可以节省67%的计算成本

引言

视频语义分割的目标是预测视频序列中每一帧像素的语义标签,而这种视频序列通常是以一定帧率(25fps或更高)记录的连续图像帧的系列。

基于图像的分割方法应用于逐帧视频帧会消耗相当多的计算资源。

为了提高VSS的计算效率,现有的方法主要集中在网络架构的设计上:

- 一类主流方法是提出了紧凑高效的基于图像的架构来降低每帧的计算开销。

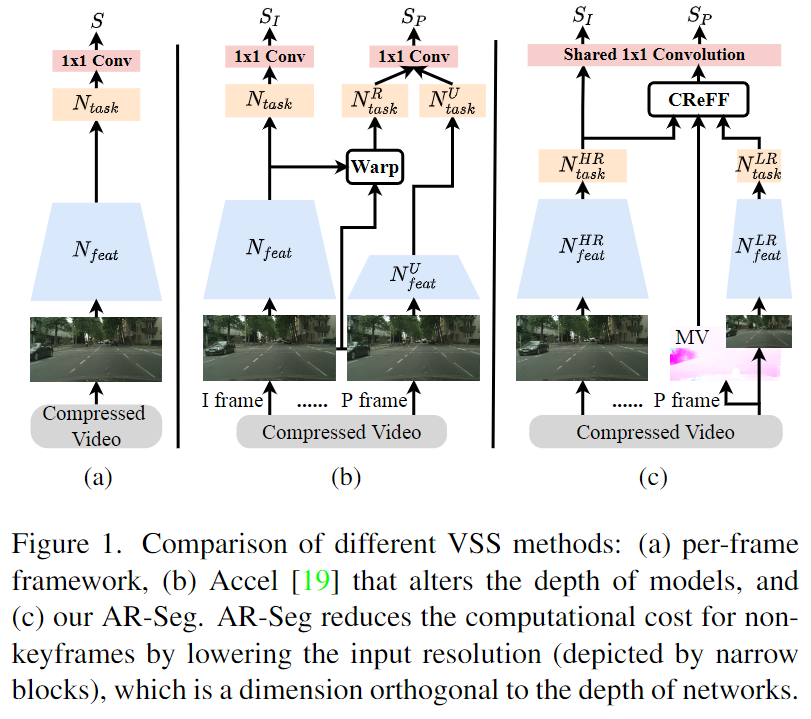

- 另一类主流方法是将深度模型应用到关键帧上,而浅层网络模型则应用于非关键帧上以避免视频帧的重复计算。

而上述提到现有的两个主流方法忽略了影响视频分割计算成本的一个关键因素:输入分辨率

输入分辨率直接决定计算量,例如2D卷积的计算成本与图像宽度和高度的乘积成正比。一旦我们将输入帧下采样0.5 × 0.5,那么计算开销可直接减少75%。缩小分辨率确实可以极大降低计算开销,但通常也会丧失图像部分信息,并进一步导致分割精度的降低。

考虑到视频分割的特殊性(相邻帧信息通常是强相关的),为此本文提出了利用视频中的时间相关性(相邻帧的相关性)来防止降低分辨率带来的精度下降问题。它的核心思想是:低分辨率帧中缺少的局部特征信息,是可以从稀疏的高分辨率参考帧来获取到的。

本文提出了一种用于压缩视频的分辨率交替框架网络AR-Seg,以极低的计算量实现了高效的视频分割,如上图1(c)所示。AR-Seg网络使用一个HR分支来处理高分辨率的关键帧,使用一个LR分支来处理低分辨率的非关键帧。为了防止由于下采样(降低分辨率)而引起的分割性能下降问题,作者在LR分支中插入了一个CReFF模块(Cross Resulution Feature Fusion),并使用FST(Feature Similarity Training)策略进行训练,以丰富LR特征中的局部特征等细节信息。

具体而言,CReFF将HR关键帧中的局部特性信息以下面两个步骤高效融合到LR非关键帧中:

- 通过使用运动矢量进行特征扭曲来对齐来自不同帧的特征的空间结构,这可以几乎不增加任何成本地从压缩视频中获得。

- 使用局部注意机制有选择地将扭曲的特征(可能在扭曲后存在噪声)聚合到LR特征中,由于局部注意机制为邻域中的每个位置分配不同的重要性,因此它是避免被噪声扭曲特征误导的有效方式。

而FST训练策略通过显式相似性损失(聚合特征与从非关键帧推断的高分辨率特征之间的相似性损失)和隐式约束,指导CReFF聚合特征的学习,以帮助低分辨率分支从高分辨率分支中学习到可靠且有效的特征。

综上所述,AR-Seg是通过改变输入分辨率显著减少了VSS的计算成本,同时保持了高分割准确性。

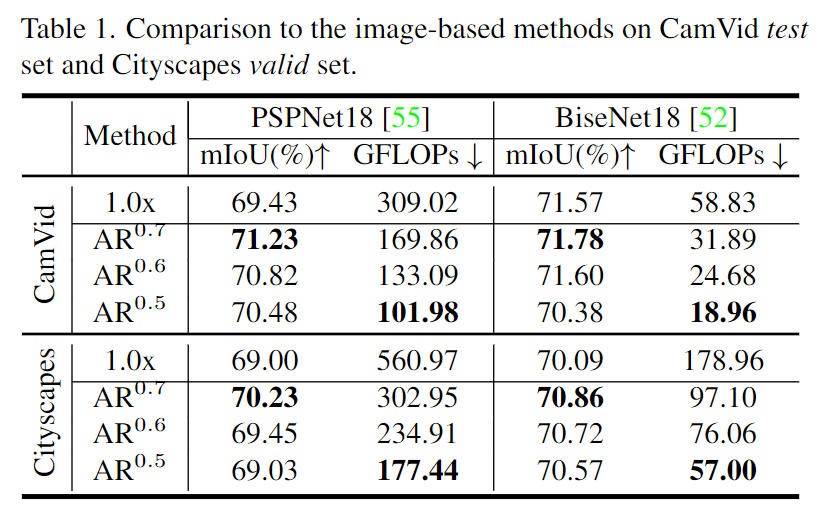

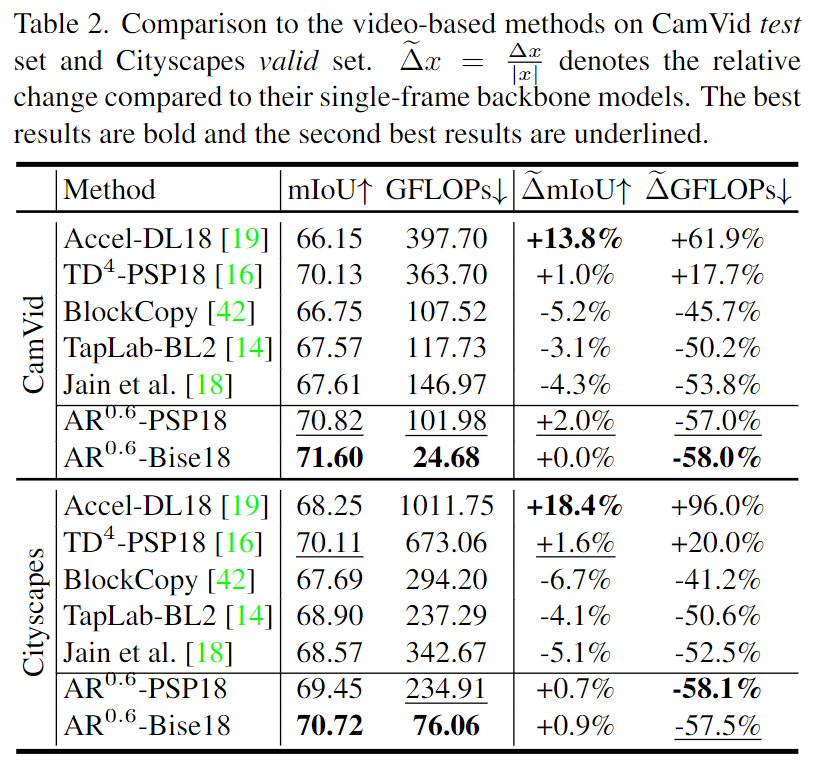

实验结果表明,AR-Seg比常规分辨率baseline模型减少了近70%的计算成本,同时保持了高分割精度。因此本文的贡献包括:

- 提出了高效的压缩视频语义分割框架

AR-Seg - 设计了一种有效的

CReFF模块以防止由降采样导致的精度损失 - 提出了一种新颖的

FST训练策略,指导LR分支从HR分支中学习

相关工作

轻量级语义分割

为了提高图像分割的效率,许多轻量型的网络架构被提出来:DFANet采用轻量级骨干网络降低计算成本,并设计了跨层级聚合来进行特征细化;DFNet利用部分排序剪枝算法搜索分割模型,以在速度和准确度之间获得良好的平衡;ICNet使用级联融合模块,并将部分计算从高分辨率转换到低分辨率;Wang等人设计了超分辨率学习来提高图像分割性能;BiSeNets使用两个流路径分别处理低级细节和高级上下文信息;ESPNet使用高效的空间金字塔加速卷积计算。这些轻量高效的骨干网络降低了单张图像分割的计算负担,并可以有效应用于VSS任务中。

视频语义分割

视频语义分割方法通过将从关键帧提取的深层特征传播到非关键帧来降低计算量。这些方法中,有些直接复用关键帧的分割结果,有些则在邻域内插值分割结果,有些则从非关键帧中提取浅层特征,并通过空间变异卷积将其融合到传播的深层特征中。为了解决视频帧之间的空间错位问题,一些方法利用光流将中间特征从关键帧映射到非关键帧,有些方法还通过全局注意力机制聚合不同时间戳的特征。

压缩域视频分析

近年来,压缩视频格式被广泛应用于计算机视觉任务中。这些方法直接将运动矢量和残差图作为额外的模态,输入到网络中进行视频动作识别和语义分割,这些运动信息还有助于补偿来自不同帧的特征的空间不对齐。在视频分割中,也有几种方法提出了在压缩域中进行高效分割的方法。这些方法降低了VSS的计算成本,但由于非关键帧的特征细化模块能力有限,因此性能会有所降低。

方法

在AR-Seg中,仅处理一些关键帧以保留细节,并将其他非关键帧处理为低分辨率以降低计算成本。AR-Seg框架包括两个分支:HR分支和LR分支。HR分支用于关键帧,LR分支用于非关键帧。两个分支共享相同的骨干网络结构,但针对不同的分辨率进行训练。在LR分支骨干网络的最终卷积前,加入了一个CReFF模块,以聚合HR特征,并预测低分辨率的非关键帧。

为了识别关键帧,我们利用了编码在压缩视频中的图像组GOP中的帧结构。GOP包含三种类型的连续L帧:I帧、P帧和B帧。I帧采用内部编码模式进行编码,而P帧和B帧采用互动编码模式进行编码,并为运动补偿计算运动矢量。在每个GOP中,我们将第一帧I帧视为关键帧,并以高分辨率进行处理。GOP中其余的L-1帧是非关键帧,以低分辨率进行处理。

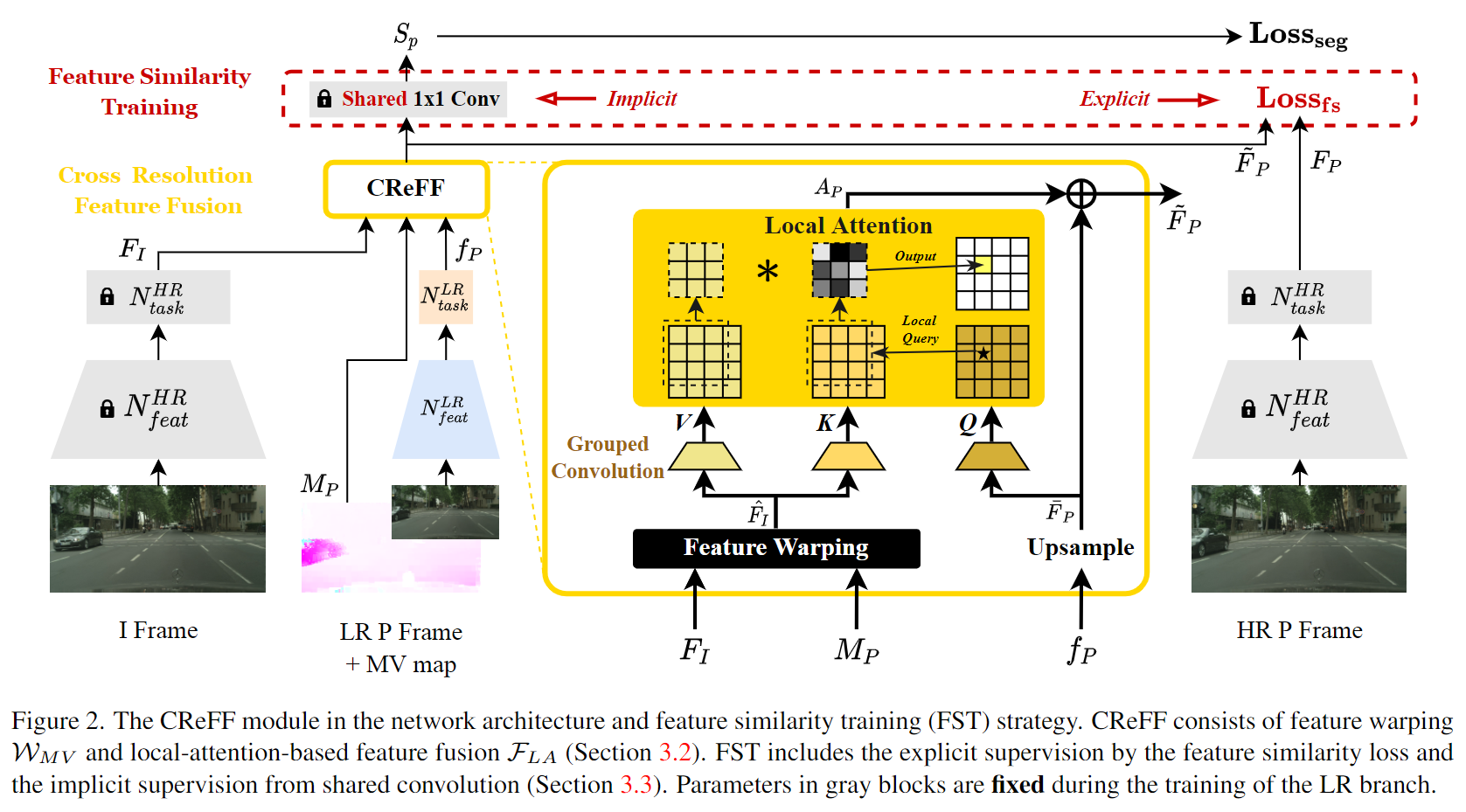

CReFF: Cross Resolution Feature Fusion

如上图2所示,AR-Seg的HR分支从I帧中提取特征 F I ∈ R C × H × W F_I \in R^{C \times H \times W} FI∈RC×H×W,LR分支从P帧中提取特征 f P ∈ R C × h × w f_P \in R^{C \times h \times w} fP∈RC×h×w。虽然P帧以低分辨率处理,但CReFF将 F I F_I FI、 M P M_P MP和 f P f_P fP作为输入,生成聚合特征 F P ~ \tilde{F_P} FP~,其中 M P ∈ R 2 × H × W M_P \in R^{2 \times H \times W} MP∈R2×H×W表示P帧到I帧的MV。 M P M_P MP的两个通道对应于运动矢量的x和y维,分别表示为 c x c_x cx和 c y c_y cy。在CReFF模块内,基于MV的特征变形操作 W M V W_{MV} WMV首先将 F I F_I FI向P帧的空间布局进行变形,可以将其公式化为逐像素移位。

其中$ \hat{F_I} \in R^{C \times H \times W}$ 表示经过变形后的高分辨率特征,将进一步融合到低分辨率特征中。

总之,CReFF模块首先从I帧中提取的特征信息对齐到P帧,然后根据 Q P Q_P QP和 K I K_I KI之间的像素相似性聚合到LR分支中。

FST: Feature Similarity Training

FST训练策略用于有效地训练CReFF模块。FST的核心思想是利用P帧的高分辨率特征 F P F_P FP(从HR分支提取)来引导学习LR分支中聚合特征 F P F_P FP的训练。因为 F P F_P FP包含足够的细节信息来产生高质量的分割结果,CReFF可以在FST的监督下学习如何将 F P F_P FP和 F I F_I FI聚合成有效的高分辨率特征。FST通过以下方式明确和隐式地监督LR分支的训练过程。

其中显式约束是使用特征相似性损失函数 L f s L_{fs} Lfs。 作者使用均方误差(MSE)来衡量 F P ~ \tilde{F_P} FP~和 F P F_P FP之间的差异(衡量了两个特征向量之间的距离),这相当于对低分辨率模型进行了额外的正则化:当距离较小时,说明两者相似度较高,因此可以将MSE作为一种度量相似性的方式,用于监督训练低分辨率模型。这种显式约束的作用是帮助低分辨率模型更好地学习从高分辨率模型中汇聚的信息,并提高分割结果的质量。

而隐式约束是 F P ~ \tilde{F_P} FP~和 F P F_P FP的共享解码层。 在训练于HR图像上的分割主干模型中,最后的卷积层充当分割解码器,包含有关高质量HR特征的深层语义信息。为了利用这种信息,我们直接将HR分支的最后一个1×1卷积层传递到具有固定参数的LR分支中。由于这些参数是在HR特征上训练的,因此当 F P ~ \tilde{F_P} FP~更接近HR特征 F P F_P FP时,它们会产生更好的分割结果 S P S_P SP。

总之,通过明确和隐式的约束,FST有效地将HR特征的知识从HR分支传递到LR分支,实现基于CReFF的聚合特征的高质量分割。 上图2展示了LR分支的总体训练策略。HR I帧提供FI特征,用于在CReFF中进行特征融合,HR P帧提供FP特征,用于FST的显式监督。使用总损失L通过反向传播训练LR分支的参数,其中HR分支和共享的最后卷积层的参数是固定的。

实验结果

::: block-1

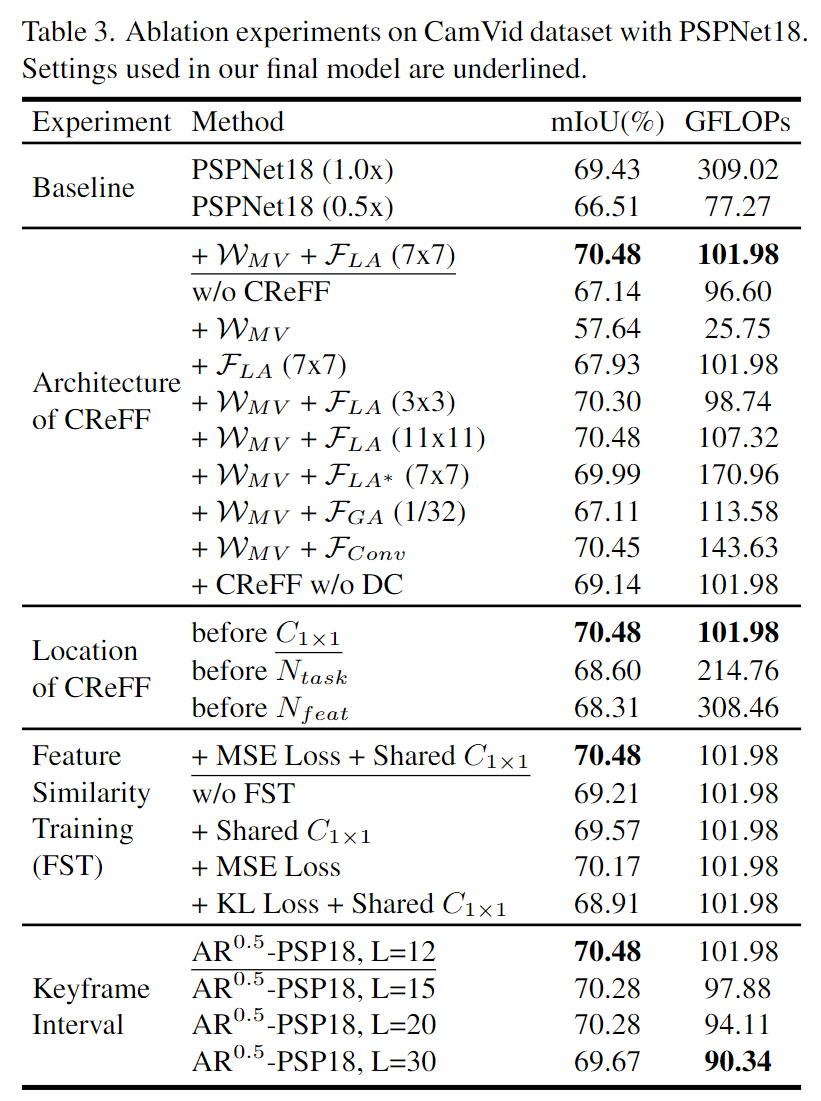

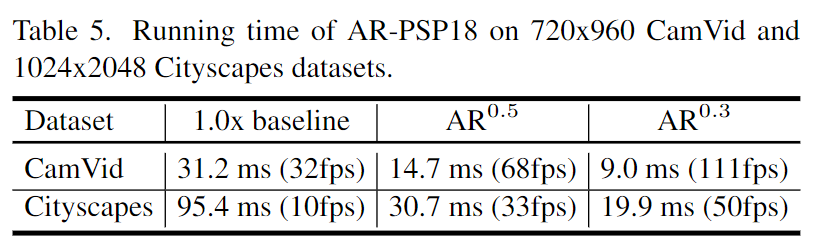

在CamVid和Cityscapes数据集上使用d=11的AR0.5-PSP18模型进行语义分割的结果。可以看到,相比于以0.5倍分辨率工作的常数分辨率PSPNet18,AR0.5-PSP18预测了更多的语义细节。与1.0倍分辨率基线相比,AR0.5-PSP18生成了类似的分割结果,但只消耗了33.0%的计算成本(以GFLOPs为单位测量)。

:::

::: block-1

(a) 展示了在不同LR分辨率下AR-Seg的性能。(b) 展示了在与关键帧的不同距离下,带注释帧的mIoUd(与关键帧之间的距离)。当d从1变化到L-1时,mIoUd的值区间在(a)中表示为彩色条。

:::

::: block-1

展示了AR-Seg在使用不同编解码器压缩的视频上的表现,可以发现,AR-Seg的准确度与其以图像为基础的分辨率恒定的对应方法相当,甚至更好。

:::

结论

本文提出了一种针对压缩视频语义分割的分辨率交替框架AR-Seg,从输入分辨率的角度创新性地提高了视频分割的效率。通过共同考虑体系结构设计和训练策略,提出的CReFF模块和FST策略有效地防止了降采样引起的精度损失。在两个广泛使用的数据集上评估的结果表明,AR-Seg在减少高达67%的计算成本的同时可以实现有竞争力的分割精度。 本研究目前仅使用两个交替分辨率(即HR和LR)。未来的工作将考虑应用更复杂的多分辨率和关键帧间隔调度,以进一步提高VSS性能。

如果您也对人工智能和计算机视觉全栈领域感兴趣,强烈推荐您关注有料、有趣、有爱的公众号『CVHub』,每日为大家带来精品原创、多领域、有深度的前沿科技论文解读及工业成熟解决方案!欢迎添加小编微信号: cv_huber,备注"CSDN",加入 CVHub 官方学术&技术交流群,一起探讨更多有趣的话题!