文章作者邮箱:[email protected] 地址:广东惠州

▲ 本章节目的

⚪ 掌握Spark的通过api使用SparkSQL;

一、通过api使用SparkSQL

1. 实现步骤

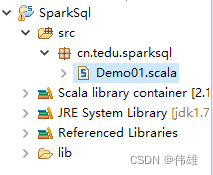

1. 打开scala IDE开发环境,创建一个scala工程。

2. 导入spark相关依赖jar包。

3. 创建包路径以object类。

4. 写代码。

5)打jar包,并上传到linux虚拟机上

6)在spark的bin目录下

执行:sh spark-submit --class cn.tedu.sparksql.Demo01 ./sqlDemo01.jar

7)最后检验

2. 代码示例

package cn.tedu.sparksql