主要参考:

openai官网:https://openai.com/blog/dall-e/

2102.DALLE: Zero-Shot Text-to-Image Generation

2204.DALLE-2 : Hierarchical Text-Conditional Image Generation with CLIP Latents

论文资源网盘下载:https://pan.baidu.com/s/1KLvYrTTXlDCBv1HfU1q5Kg?pwd=0828

知乎大师兄,解析DALL-E :https://zhuanlan.zhihu.com/p/480947973

csdn-kunli 解读,带代码 :https://blog.csdn.net/u012193416/article/details/126108145

知乎 DAlle 如何实现:https://www.zhihu.com/question/447757686

先导知识

- Resnet(残差网络结构,Deep residual learning for image recognition)

- Transformer (Attention is all you need)

- dVAE (离散的变分自编码器)

- CLIP (Contrastive Language–Image Pre-training)

方法概述

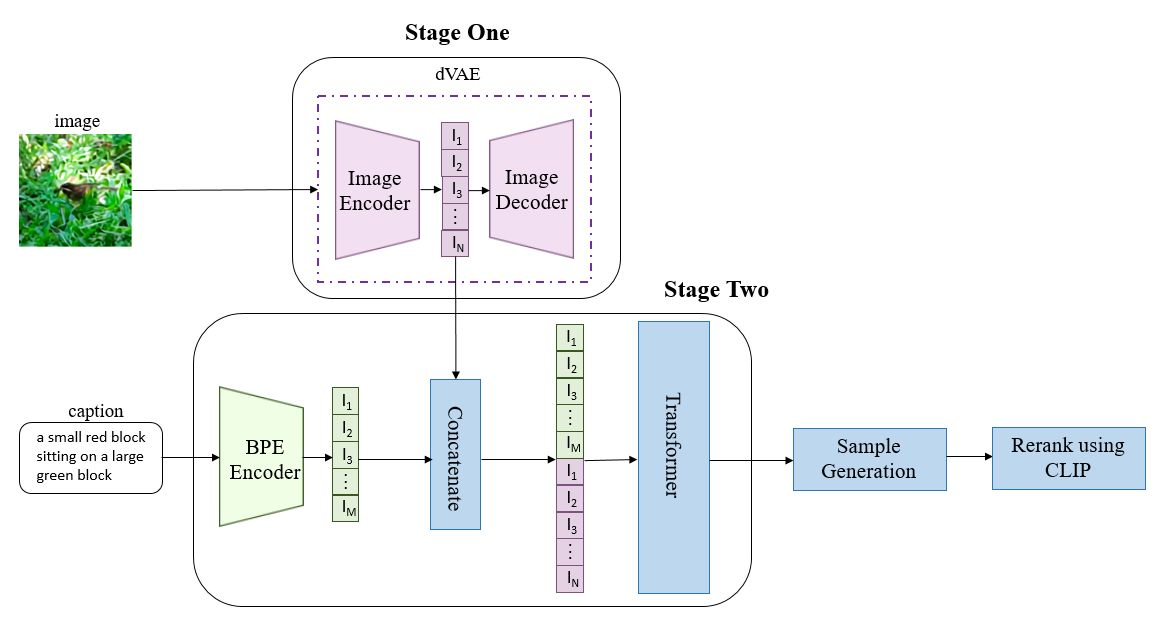

DALLE包括三个独立训练得到的模型:dVAE,Transformer和CLIP,其中dVAE的训练与VAE基本相同,Transformer采用类似GPT-3的生成式预训练方法。

在第一个阶段,将

256×256的图片分为32×32个patch,然后使用训练好的离散VAE模型的encoder将每个patch映射到大小为8192的词表中,最终一张图片转为用1024个token表示。在第二个阶段,使用BPE-encoder对文本进行编码,得到最多256个token,token数不满256的话padding到256;再将

256个文本token与1024个图像token进行拼接,得到长度为1280的数据;

最终将拼接的数据输入训练好的具有120亿参数的Transformer模型。在第三个阶段,对模型生成的图像进行采样,并使用同期发布的CLIP模型对采样结果进行排序,从而得到与文本最匹配的生成图像。

作者:金雪锋

链接 https://www.zhihu.com/question/447757686/answer/1764970196

原文

摘要

文本到图像的生成传统上专注于在固定的数据集上为训练找到更好的建模假设。

这些假设可能涉及复杂的架构、辅助损失或辅助信息:如在训练期间提供的对象部分标签或分割掩模。

提出一个基于transformer的简单方法,该转换器自动回归地(autoregressively)将文本和图像的tokens标记建模为单个数据流。

有了足够的数据和规模,当以零训练、零学习(zero-shot)方式评估时,我们的方法与以前的特定域模型(domian-specific)具有竞争力。

引言

文本到图像合成工作开始于2015年

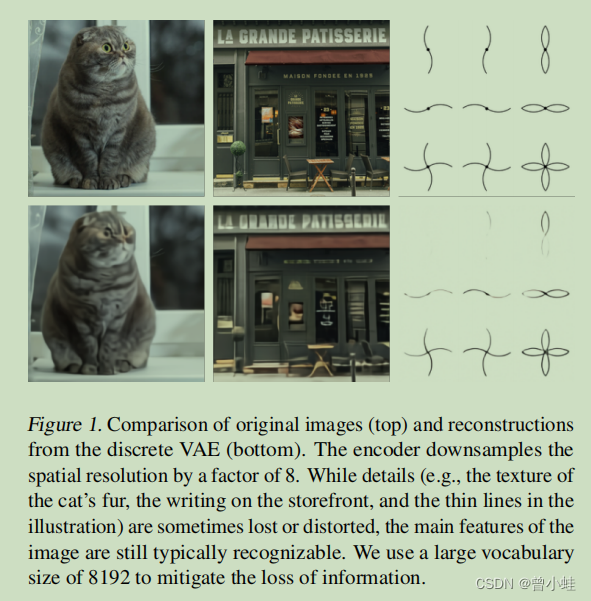

图1

比较原始图像(顶部)和离散VAE(discrete)重建(底部)。该编码器将空间分辨率降采样了8倍。虽然细节有时会丢失或扭曲(例如,猫毛的纹理(texture of the car’s fur),店面上的文字(writing on the storefront),以及插图(illustration)中的细线),但图像的主要特征仍然是可以辨认的。我们使用了8192 的大词汇量来减少信息的丢失。

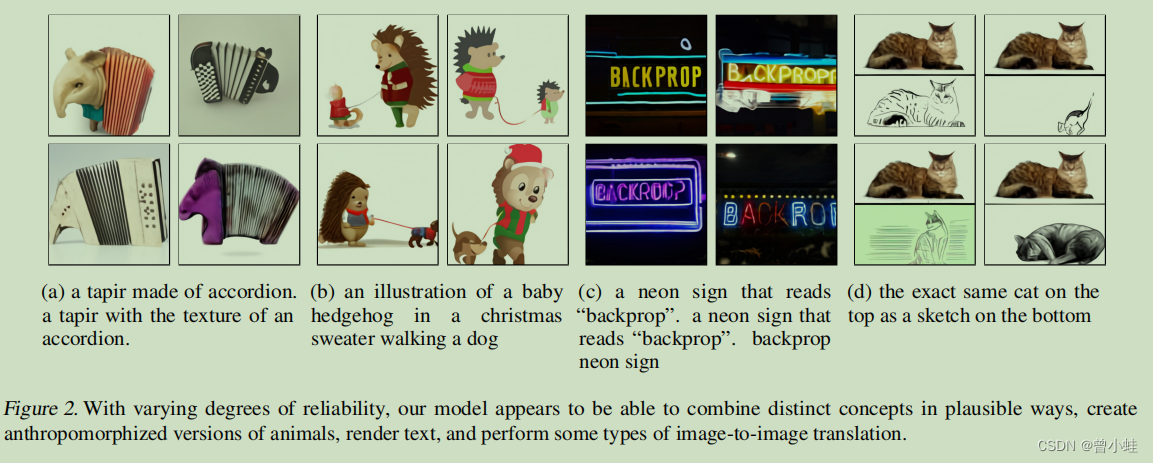

图2 生成的各种风格图

具有不同程度的可靠性,我们的模型似乎能够以合理的(plausible)方式结合不同的概念(distinct concepts),创建拟人化(anthropomorphized)的动物版本,渲染(render)文本,并执行某些类型的图像到图像的翻译:

- a: 具有手风琴(accordion)纹理的貘(音译mo,英文tapir). 由手风琴构成的貘

- b:一只穿着圣诞毛衣遛狗的的刺猬(hedgehog)插图

- c: 一个写着“背面道具”的霓虹灯标志( neon sign)。一个写着“背面道具”的霓虹灯标志。后支撑霓虹灯标志

- d: 顶部的猫和底部的素描完全一样