目录

1.基本原理

基于Kohonen映射的自组织SOM(Self-Organizing Map)分类器是一种常用的无监督学习算法,用于将高维输入数据映射到一个低维的空间,以便进行数据聚类和可视化。Kohonen映射,是一种用于将高维数据映射到低维空间的无监督学习算法。它由芬兰科学家Teuvo Kohonen在1980年提出,用于实现对输入数据的聚类和可视化。Kohonen映射的核心思想是将相似的输入数据映射到邻近的神经元上,从而保留数据的拓扑结构和分布特征。

1.1Kohonen映射原理

Kohonen映射的原理是通过自适应调整神经元之间的权重,将输入数据映射到一个二维的神经元网络,也称为SOM网络。在SOM网络中,每个神经元都对应一个权重向量,表示特定的特征或属性。训练过程中,输入数据被输入到SOM网络中,然后寻找与输入数据最相似的神经元,即最优匹配单元(Best Matching Unit,BMU),并通过更新BMU附近的神经元权重来实现数据的映射。

Kohonen映射具有以下优点和应用:

-

数据聚类:Kohonen映射可以将相似的数据映射到相邻的神经元上,从而实现对输入数据的聚类。

-

数据降维:将高维数据映射到低维空间,有助于数据可视化和分析。

-

特征提取:在训练过程中,神经元的权重可以捕捉输入数据的特征,用于后续任务。

-

图像处理:在图像处理中,Kohonen映射可以用于图像分割、特征提取等任务。

-

数据可视化:将高维数据映射到二维平面,可以可视化数据的分布和结构。

1.2 SOM分类器

SOM分类器基于Kohonen映射,它通过逐步调整神经元的权重来实现对输入数据的聚类。SOM的核心思想是将高维输入数据映射到一个二维网格上,使得相似的输入在映射空间中也是相邻的。训练过程中,SOM会自适应地调整神经元的权重,使得神经元之间的权重逐渐趋于相似,从而捕捉数据的分布特征。

SOM网络(Self-Organizing Map Network),也称为Kohonen映射,是一种无监督学习神经网络,用于将高维输入数据映射到低维的拓扑空间中。SOM网络由芬兰科学家Teuvo Kohonen于1980年提出,主要用于数据聚类、降维和可视化等任务。它的核心思想是通过自适应调整神经元之间的权重,实现对输入数据的有效表示和映射。

结构和特点

SOM网络通常是一个二维的神经元网络,其中每个神经元对应一个权重向量。这些神经元按照拓扑结构排列,形成一个类似于网格或地图的结构。每个神经元的权重向量表示了某种特征或属性,而整个SOM网络的拓扑结构则保留了输入数据之间的拓扑关系。

SOM网络的主要特点包括:

-

无监督学习:SOM网络不需要标签或目标输出,它自动学习输入数据之间的模式和结构。

-

竞争学习:在SOM网络中,神经元之间存在竞争关系,只有最匹配的神经元(BMU)会响应并调整权重。

-

拓扑保持性:SOM网络保留了输入数据的拓扑结构,相似的输入数据在拓扑上映射到相邻的神经元。

-

降维和可视化:SOM网络将高维数据映射到低维空间,有助于数据的可视化和理解。

工作原理:

SOM网络的工作原理涉及以下步骤:

-

初始化:初始化SOM网络,包括设置神经元的数量、拓扑结构和权重。

-

输入数据传递:将输入数据逐个输入到SOM网络中。

-

最优匹配单元(BMU):计算输入数据与每个神经元权重的距离,找到最匹配的神经元,即BMU。

-

更新权重:根据BMU的位置和邻域函数,更新BMU及其周围的神经元的权重。

-

邻域更新:随着训练的进行,邻域函数逐渐减小,使得附近的神经元也受到调整。

-

迭代:重复步骤2~5,直到达到预定的迭代次数或收敛条件。

SOM的基本结构如下所示:

2.实现步骤

-

初始化神经元权重:随机初始化神经元的权重向量。

-

选择输入样本:从训练数据中随机选择一个输入样本。

-

寻找BMU(Best Matching Unit):计算输入样本与每个神经元的距离,找到距离最近的神经元作为BMU。

-

更新邻域内神经元:根据BMU和邻域函数,更新BMU附近的神经元权重。

-

更新学习率和邻域参数:随着训练的进行,逐渐减小学习率和邻域参数。

-

重复步骤2~5:迭代地处理所有输入样本,直到达到预定的迭代次数或收敛。

3.部分程序

function [N] = reduceNeurons(Data,Neurons)

N = zeros(3,1,4);% 减少神经元数量的函数% 初始化减少后的神经元矩阵

lattice = zeros(size(Neurons,1),size(Neurons,2));% 创建一个与神经元矩阵大小相同的零矩阵

for i=1:50% 对前50个数据样本进行遍历

[~,x,y] = getBMU(Neurons,Data(i,:));% 获取最佳匹配单元的位置

lattice(x,y) = lattice(x,y) +1;% 在对应位置计数

end

[M, index] = max(lattice);% 找到每列最大值及其索引

[~, index2] = max(M);% 找到最大值中的最大值及其索引

N(1,1,:) = Neurons(index(index2),index2,:);% 将对应位置的神经元值保存

lattice = zeros(size(Neurons,1),size(Neurons,2));% 重置零矩阵以进行下一轮遍历

for i=51:100% 对第51到100个数据样本进行遍历,执行类似操作

[~,x,y] = getBMU(Neurons,Data(i,:));

lattice(x,y) = lattice(x,y) +1;

end

[M, index] = max(lattice);

[~, index2] = max(M);

N(2,1,:) = Neurons(index(index2),index2,:);

% 重置零矩阵以进行下一轮遍历

lattice = zeros(size(Neurons,1),size(Neurons,2));

for i=101:150% 对第101到150个数据样本进行遍历,执行类似操作

[~,x,y] = getBMU(Neurons,Data(i,:));

lattice(x,y) = lattice(x,y) +1;

end

[M, index] = max(lattice);

[~, index2] = max(M);

N(3,1,:) = Neurons(index(index2),index2,:);

end

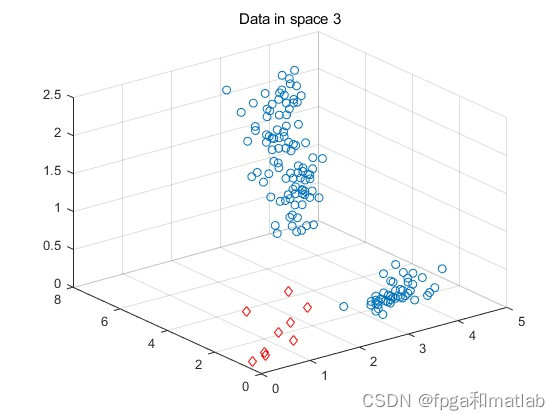

up30354.仿真结果