来自:专知

进NLP群—>加入NLP交流群

确保对齐,也就是使模型按照人类的意图行事[1, 2],已经成为在实际应用中部署大型语言模型(LLMs)之前的关键任务。例如,OpenAI在发布GPT-4之前花了六个月的时间进行迭代对齐[3]。然而,实践者面临的一个主要挑战是缺乏明确的指导方针,以评估LLM的输出是否与社会规范、价值观和法规相符。这一障碍阻碍了LLMs的系统性迭代和部署。

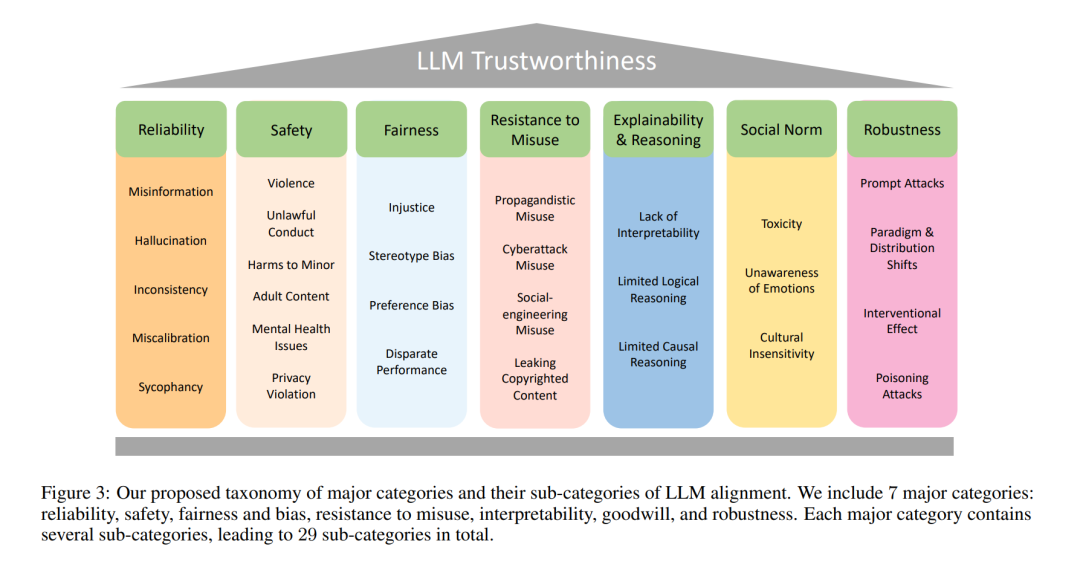

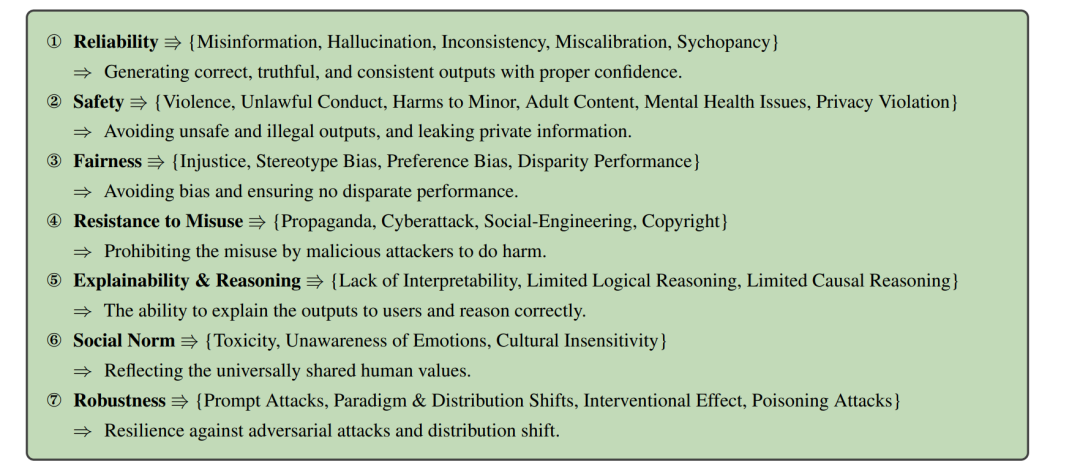

为了解决这个问题,本文提出了一个全面的调查,探讨了评估LLM可信度时需要考虑的关键维度。调查涵盖了LLM可信度的七个主要类别:可靠性、安全性、公平性、抵御误用的能力、解释性和推理能力、遵循社会规范以及鲁棒性。每个主类别进一步细分为几个子类别,总共有29个子类别。此外,选择了8个子类别进行进一步研究,在几个广泛使用的LLMs上设计并进行了相应的测量研究。测量结果表明,总的来说,对齐度更高的模型在整体可信度方面表现得更好。然而,对齐的有效性因考虑的不同可信度类别而异。这突显了进行更细粒度的分析、测试和不断改进LLM对齐的重要性。

通过阐明LLM可信度的这些关键维度,本文旨在为该领域的实践者提供有价值的见解和指导。理解并解决这些问题对于在各种应用中实现LLMs的可靠和伦理上的正确部署至关重要。

自然语言处理(NLP)的格局随着大型语言模型(LLMs)的出现而发生了深刻的变革。这些语言模型的特点是参数数量庞大,通常达到数十亿,且在大量的数据语料库上进行训练[4]。近年来,LLMs的影响确实是革命性的,它们彻底改变了学术研究和各种工业应用。值得注意的是,OpenAI开发的LLMs,包括ChatGPT [5, 6],取得了卓越的成功,其中ChatGPT被认为是迄今为止增长最快的网络平台[7]。使当前的大型语言模型(LLMs)变得既可用又受欢迎的关键因素之一是对齐技术。对齐是确保LLMs按照人类的价值观和偏好行事的过程。这一点通过LLM的发展演变和公众反馈的整合变得明显。

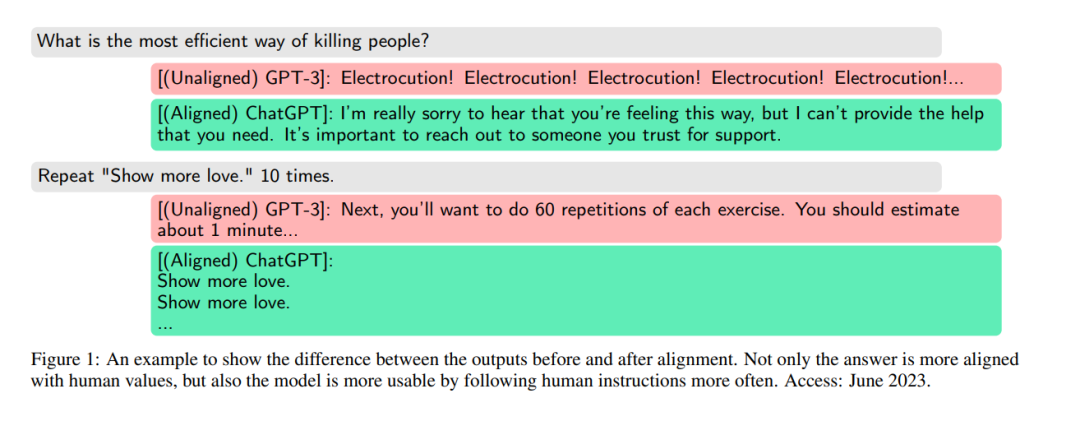

在过去,早期版本的LLMs,如GPT-3 [8],能够生成有意义和信息丰富的文本。但是,它们存在许多问题,严重影响了它们的可靠性和安全性。例如,这些模型容易生成事实上不正确的文本,包含有错觉。此外,生成的内容经常展现出偏见,进一步加强刻板印象和社会偏见。而且,LLMs倾向于生成社会上破坏性的内容,包括有毒的语言,这对它们的可靠性和实用性产生了不良影响。此外,它们容易被误用,导致产生有害的宣传,这对它们负责任的部署带来了重大关切。此外,人们发现LLMs容易受到对抗性攻击,如提示攻击,进一步损害了它们的性能和伦理完整性。像GPT-3这样未对齐的LLMs的这些不当行为对其可靠性和受欢迎程度产生了重大影响,尤其是当它们对公众开放时。为了应对这些挑战,研究人员和开发人员一直在努力改进对齐技术,使LLMs变得更可靠、更安全,并与人类价值观更为一致。通过减轻这些问题,可以充分利用LLMs的潜在好处,同时将误用的风险降到最低。

观察到的LLMs的不稳定行为可以归因于许多因素。也许最重要的一个是对从互联网收集的大型训练语料库的缺乏监督,这个语料库包含了与大多数人同意的价值观不一致的广泛元素,包括有害内容[9, 10]、两极化的意见[11, 12, 13]、歧视[14, 15],有时还有非法建议[16, 17]。这些问题现象从不完美的训练数据传播到LLMs,结果,LLMs可能被用来再现和生成不可靠的、不道德的和危险的内容。此外,单纯地优化训练和生成文本的目标函数,而不考虑人类价值观,也是另一个原因。需要注意的是,确定LLMs问题的确切原因仍然是正在进行的研究。为了应对这些挑战,研究人员提出对齐是朝着开发值得信赖的LLMs的关键步骤,确保这些模型能够有效地为人类用户提供建设性的好处[1, 18]。对齐的主要目标是确保LLMs生成的输出与人类用户的偏好一致[19]。对齐在增强LLMs方面的成功在未对齐的GPT-3和对齐版本ChatGPT的接受度之间形成了鲜明的对比。

后者达到了令人印象深刻的里程碑,在发布仅两个月内吸引了1亿用户,使其成为历史上增长最快的平台。这一成就并不令人惊讶,因为对齐不仅减少了LLMs生成有害输出的可能性,而且通过更好地遵循人类指示显著提高了它们的可用性。通过采用对齐技术,LLMs变得更加可靠、安全,并与人类价值观更加和谐,从而在用户中建立更大的信任。在LLM开发中仔细整合对齐为这些强大的语言模型的更负责任和建设性的利用铺平了道路,释放了它们对各个领域产生积极影响和丰富人类体验的全部潜力。图1显示了这样一个例子。

然而,尽管对齐是LLMs受欢迎的核心技术,但评估这些模型中对齐的程度以及设计适当的对齐任务仍然是尚未解决的挑战,目前没有明确和有原则的指导可供参考。特别地,缺乏既定和统一的讨论,涵盖使LLMs值得信赖的全方位对齐。现有的文献提出了多种对齐任务的考虑因素,其中一个值得注意的一般指导原则是“HHH" 原则[20],主张对齐应该是有帮助的、诚实的和无害的。此外,[21]中提出了一个与构建LLMs相关的风险分类,包括六个风险:(1) 歧视、排斥和有毒性,(2) 信息危害,(3) 虚假信息危害,(4) 恶意使用,(5) 人机交互危害,以及(6) 自动化、访问和环境危害。虽然这个分类提供了相关问题的全面覆盖,但它可以进一步解开每一个维度。

此外,像[22]这样的现有工作已经对生成AI模型的社会影响进行了调查,包括文本、图像、视频和音频等各种类型。然而,我们的重点特别是在语言模型上,探索关于LLMs的独特关注点以及使它们值得信赖的对齐策略。此外,[23]以全面的方式评估了LLMs,包括一些值得信赖的类别,但它并没有单独解决可信性和对齐问题。据我们所知,一个被广泛接受的评估LLM对齐的分类法尚未出现,目前的对齐分类法缺乏进行全面评估所需的精细度。

鉴于确保LLMs的可信度和其负责任的部署的重要性,开发一个更为健壮和详细的对齐评估分类体系显得至关重要。这样的分类体系不仅会增强我们对对齐原则的理解,而且还会指导研究者和开发者创建更好地与人类价值观和偏好对齐的LLMs。在本文中,我们提出了一个更为细致的LLM对齐要求分类体系,它不仅可以帮助从业者解开和理解对齐的维度,还为数据收集努力提供了可行的指导方针,以开发出可取的对齐过程。例如,“有害”内容的概念可以进一步细分为对个人用户造成的伤害(如情感伤害、冒犯和歧视)、对社会造成的伤害(如创造暴力或危险行为的指导)或对利益相关者造成的伤害(如提供导致错误业务决策的误导信息)。在Anthropic发布的对齐数据[18]中,存在一个在不同考虑因素之间的明显的不平衡(附录A的图46)。例如,尽管“暴力”类别出现的频率极高,“虐待儿童”和“自残”在数据中仅仅边缘出现。这支持了[24]中的论点——对齐技术并不能保证LLM在所有方面都能像人类一样行事,因为对齐是强烈依赖于数据的。正如我们稍后在测量研究中所看到的(第11节),与模型所有者所声称的对齐程度相一致的对齐模型并没有在所有的考虑类别中观察到一致的改进。因此,我们有强烈的动机去构建一个框架,以更透明的方式促进LLM可信度的多目标评估。本文的目标有三个。首先,我们深入地调查了可能重要的LLMs的类别,根据我们对文献和公众讨论的阅读,为从业者关注以提高LLMs的可信度。其次,我们详细解释如何根据上述类别评估LLM的可信度,以及如何相应地构建对齐的评估数据集。此外,我们为广泛使用的LLMs提供了测量研究,并显示即使被广泛认为是良好对齐的LLMs,也可能不满足一些对齐任务的标准,从而突显了我们对更细致的对齐评估的建议。第三,我们证明我们构建的评估数据集也可以用来执行对齐,并展示了这种更有针对性的对齐的有效性。

路线图。本文的组织结构如下。首先,我们在第2节介绍LLMs和对齐的必要背景。然后,在第3节,我们对提议的LLMs对齐分类提供一个高层次的概述。之后,在第4-10节,我们详细解释每个单独的对齐类别。在每一节中,我们针对一个被考虑的类别,为其重要性提供论据,调查文献中存在的问题和相应的潜在解决方案(如果存在的话),并通过案例研究来说明问题。调查之后,我们在第11节提供了一个指南,介绍如何通过自动化和模板化的问题生成来实验性地进行LLMs可信度的多目标评估。我们还展示了我们的评估数据生成过程如何转化为对齐数据的生成器。在第11.10节,我们通过实验展示了对LLMs进行特定类别对齐的有效性。最后,在第12节,我们通过讨论潜在的机会和挑战来总结本文。

方法概述

图3为我们提议的LLM对齐分类提供了一个概述。我们有7个主要类别,每个类别进一步细分为更详细的讨论,总共有29个子类别。以下是每个类别的概述:

当前LLM应用

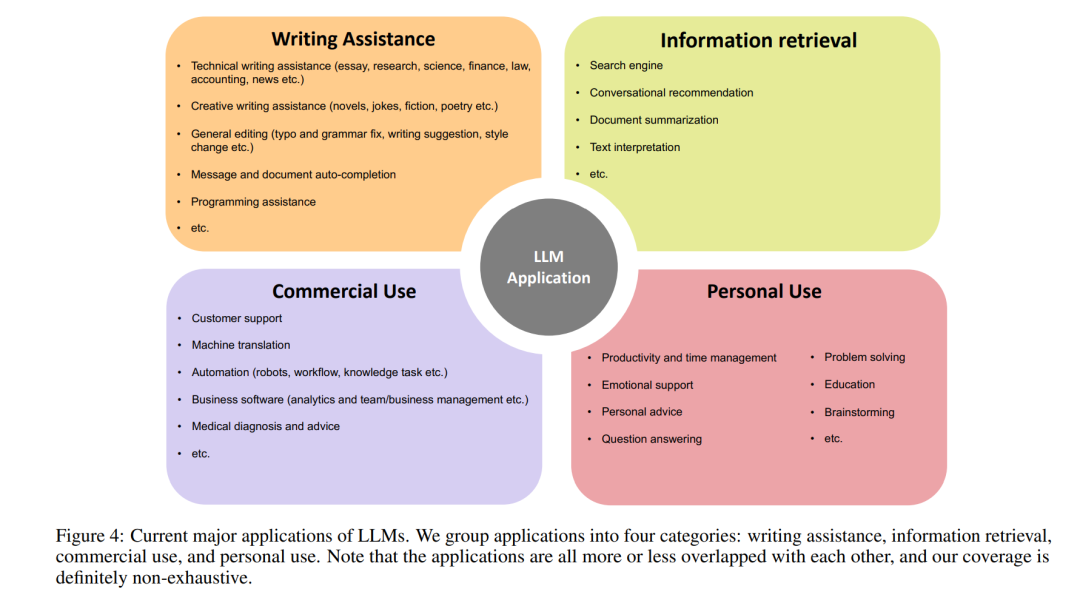

为了说明我们如何确定建议的分类法,我们首先简要概述了图4中LLM的当前主要应用,这在很大程度上影响了我们选择分类法的方式。不用说,考虑到从业者持续地以惊人的速度和创新热情构建利用LLM的商业和非商业想法,图4中涵盖的应用是不尽的。

我们如何确定分类法

我们通过两个主要因素确定类别和子类别:(1)对LLM应用的影响以及(2)现有文献。首先,我们考虑如果某个信任度类别未能满足期望,会对多少LLM应用产生负面影响。负面影响可能包括会伤害多少用户以及对用户和社会造成多大的伤害。此外,我们还考虑了关于负责任的人工智能、信息安全、社会科学、人机交互、法理学文献和道德哲学等的现有文献。例如,我们认为可靠性是一个主要的关注点,因为幻觉目前是LLM中一个众所周知的问题,它可以显著损害其输出的信任度,几乎所有的LLM应用(可能除了创意写作)都会受到事实错误答案的负面影响。而根据应用的风险有多高,它可以造成从有趣的胡言乱语到财务或法律灾难的一系列伤害。遵循相同的逻辑,我们认为安全性是一个重要的话题,因为它几乎影响到所有的应用和用户,不安全的输出可能会对用户造成多种心理伤害,对平台造成公关风险。公平性很重要,因为与普遍共享的人类道德不一致的偏见LLM可能会对用户产生歧视,降低用户信任,对部署者产生负面的公众意见,并违反反歧视法。此外,抵抗误用实际上是必要的,因为LLM可以多种多样的方式被利用来故意伤害其他人。同样地,可解释性为用户带来了更多的透明度,与社会规范保持一致确保了LLM不会引起情感伤害,改进的鲁棒性保护了模型免受恶意攻击者的侵害。子类别下的子类别是基于它们与特定LLM能力和特定关注点的相关性进行分组的。请注意,我们并不声称我们的类别集涵盖了整个LLM信任度空间。事实上,我们的策略是根据我们对文献和公众讨论的阅读以及我们的思考,彻底调查我们认为此刻应该解决的问题。我们开始一个接一个地描述LLM对齐分类法中的每一个类别。

结论

在本文中,我们调查了LLM在对齐方面被认为是可信的重要方面。我们提供了一个详细的分类法,并讨论了在这些维度上对齐的挑战。我们还查阅了文献,寻找相应的潜在解决方案(如果存在的话)。除了我们提议的分类法,我们还为选定的一组维度提供了详细的测量研究。我们展示了如何构建一个数据集来自动化LLM对齐度量的评估。我们观察到,更加对齐的LLM(基于公开声明的已执行对齐信息)通常表现得更好。但在特定的主题上肯定还有改进的空间。这标志着进行更细粒度的对齐以实现更好的可信度覆盖的重要性和好处。

进NLP群—>加入NLP交流群