一、入门实践例子

这里有一段字符串

Hello, my phone number is 010-26640201 and email is 1032432843@awk.com, and my website is https://cdnpiaow.com

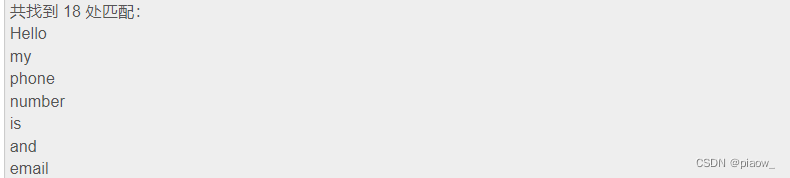

1.匹配每个单词块

[a-zA-z]*

2.匹配每个单词块后指定字符的语句

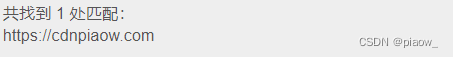

[a-zA-z]+://

3.匹配前缀为上述字符串,后面为任意字符串的语句

说明:/s代表任意空白字符串,等价于[\t\n\r\f],[^…]代表匹配不在[]中的字符,例如匹配所有非空字符[^/s],*代表匹配0或多个前面的表达式

这里通过匹配得到网页URL

[a-zA-z]+://[^/s]*

二、match匹配

1.初识match()匹配

这里首先介绍第一个常用的匹配方法 —— match,向它传入要匹配的字符串以及正则表达式,就可以检测这个正则表达式是否匹配字符串。

match 方法会尝试从字符串的起始位置匹配正则表达式,如果匹配,就返回匹配成功的结果;如果不匹配,就返回 None。

示例:

import re

content = 'Hello 123 4567 World_This is a Regex Demo'

print(len(content))

result = re.match('^Hello\s\d\d\d\s\d{

4}\s\w{

10}', content)

print(result)

print(result.group())

print(result.span())

运行结果如下:

41

<_sre.SRE_Match object; span=(0, 25), match='Hello 123 4567 World_This'>

Hello 123 4567 World_This

(0, 25)

group()方法会输出完整的匹配结果

span 方法可以输出匹配的范围,结果是 (0, 25),这就是匹配到的结果字符串在原字符串中的位置范围。

2.匹配目标

刚才我们用 match 方法可以得到匹配到的字符串内容,但是如果想从字符串中提取一部分内容,该怎么办呢?就像最前面的实例一样,从一段文本中提取出邮件或电话号码等内容。

这里可以使用 () 括号将想提取的子字符串括起来。() 实际上标记了一个子表达式的开始和结束位置,被标记的每个子表达式会依次对应每一个分组,调用 group 方法传入分组的索引即可获取提取的结果。

import re

content = 'Hello 1234567 World_This is a Regex Demo'

result = re.match('^Hello\s(\d+)\sWorld', content)

print(result)

print(result.group())

print(result.group(1))

print(result.span())

可以看出其中数字部分的正则表达式被()括了起来

<_sre.SRE_Match object; span=(0, 19), match='Hello 1234567 World'>

Hello 1234567 World

1234567

(0, 19)

3.通用匹配

刚才我们写的正则表达式其实比较复杂,出现空白字符我们就写 \s 匹配,出现数字我们就用 \d 匹配,这样的工作量非常大。有一个万能匹配可以用,那就是. *(点星)。其中.(点)可以匹配任意字符(除换行符),*(星)代表匹配前面的字符无限次,所以它们组合在一起就可以匹配任意字符了。有了它,我们就不用挨个字符地匹配了。

示例:

import re

content = 'Hello 123 4567 World_This is a Regex Demo'

result = re.match('^Hello.*Demo$', content)

print(result)

print(result.group())

print(result.span())

输出结果:

<_sre.SRE_Match object; span=(0, 41), match='Hello 123 4567 World_This is a Regex Demo'>

Hello 123 4567 World_This is a Regex Demo

(0, 41)

4.贪婪与非贪婪(即优先级.*和.*?)

引例:

import re

content = 'Hello 1234567 World_This is a Regex Demo'

result = re.match('^He.*(\d+).*Demo$', content)

print(result)

print(result.group(1))

输出结果:

<_sre.SRE_Match object; span=(0, 40), match='Hello 1234567 World_This is a Regex Demo'>

7

奇怪的事情发生了,我们只得到了 7 这个数字,这是怎么回事呢?

这里就涉及一个贪婪匹配与非贪婪匹配的问题了。在贪婪匹配下,.* 会匹配尽可能多的字符。正则表达式中.* 后面是 \d+,也就是至少一个数字,并没有指定具体多少个数字,因此,.* 就尽可能匹配多的字符,这里就把 123456 匹配了,给 \d + 留下一个可满足条件的数字 7,最后得到的内容就只有数字 7 了。

import re

content = 'Hello 1234567 World_This is a Regex Demo'

result = re.match('^He.*?(\d+).*Demo$', content)

print(result)

print(result.group(1))

这里我们只是将第一个 .* 改成了 .*?,转变为非贪婪匹配。结果如下:

<_sre.SRE_Match object; span=(0, 40), match='Hello 1234567 World_This is a Regex Demo'>

1234567

当 .*? 匹配到 Hello 后面的空白字符时,再往后的字符就是数字了,而 \d + 恰好可以匹配,那么这里 .*? 就不再进行匹配,交给 \d+ 去匹配后面的数字。所以这样 .*? 匹配了尽可能少的字符,\d+ 的结果就是 1234567 了。

所以说,在做匹配的时候,字符串中间尽量使用非贪婪匹配,也就是用 .*? 来代替 .*,以免出现匹配结果缺失的情况。

但这里需要注意,如果匹配的结果在字符串结尾,.*? 就有可能匹配不到任何内容了,因为它会匹配尽可能少的字符。例如:

import re

content = 'http://weibo.com/comment/kEraCN'

result1 = re.match('http.*?comment/(.*?)', content)

result2 = re.match('http.*?comment/(.*)', content)

print('result1', result1.group(1))

print('result2', result2.group(1))

运行结果如下:

result1

result2 kEraCN

可以观察到,.*? 没有匹配到任何结果,而 .* 则尽量匹配多的内容,成功得到了匹配结果。

5.修饰符

正则表达式可以包含一些可选标志修饰符来控制匹配的模式。修饰符被指定为一个可选的标志。我们用实例来看一下:

import re

content = '''Hello 1234567 World_This

is a Regex Demo

'''

result = re.match('^He.*?(\d+).*?Demo$', content)

print(result.group(1))

和上面的例子相仿,我们在字符串中加了换行符,正则表达式还是一样的,用来匹配其中的数字。看一下运行结果:

AttributeError Traceback (most recent call last)

<ipython-input-18-c7d232b39645> in <module>()

5 '''

6 result = re.match('^He.*?(\d+).*?Demo$', content)

----> 7 print(result.group(1))

AttributeError: 'NoneType' object has no attribute 'group'

运行直接报错,也就是说正则表达式没有匹配到这个字符串,返回结果为 None,而我们又调用了 group 方法导致 AttributeError。

那么,为什么加了一个换行符,就匹配不到了呢?这是因为。匹配的是除换行符之外的任意字符,当遇到换行符时,.*? 就不能匹配了,所以导致匹配失败。这里只需加一个修饰符 re.S,即可修正这个错误:

result = re.match('^He.*?(\d+).*?Demo$', content, re.S)

这个修饰符的作用是使。匹配包括换行符在内的所有字符。此时运行结果如下:

1234567

这个 re.S 在网页匹配中经常用到。因为 HTML 节点经常会有换行,加上它,就可以匹配节点与节点之间的换行了。

另外,还有一些修饰符,在必要的情况下也可以使用。在网页匹配中,较为常用的有 re.S 和 re.I(使匹配对大小写不敏感)。

6.转义匹配

例:匹配除换行符以外的任意字符,但是如果目标字符串里面就包含.,那该怎么办呢?

这里就需要用到转义匹配了,示例如下:

import re

content = '(百度) www.baidu.com'

result = re.match('\(百度 \) www\.baidu\.com', content)

print(result)

当遇到用于正则匹配模式的特殊字符时,在前面加反斜线转义一下即可。例如。就可以用 . 来匹配,运行结果如下:

<_sre.SRE_Match object; span=(0, 17), match='(百度) www.baidu.com'>

可以看到,这里成功匹配到了原字符串。

这些是写正则表达式常用的几个知识点,熟练掌握它们对后面写正则表达式匹配非常有帮助。

三、search

因为 match 方法在使用时需要考虑到开头的内容,这在做匹配时并不方便。它更适合用来检测某个字符串是否符合某个正则表达式的规则。

这里就有另外一个方法 search,它在匹配时会扫描整个字符串,然后返回第一个成功匹配的结果。也就是说,正则表达式可以是字符串的一部分,在匹配时,search 方法会依次扫描字符串,直到找到第一个符合规则的字符串,然后返回匹配内容,如果搜索完了还没有找到,就返回 None。

例子:

首先,这里有一段待匹配的 HTML 文本,接下来写几个正则表达式实例来实现相应信息的提取:

html = '''<div id="songs-list">

<h2 class="title"> 经典老歌 </h2>

<p class="introduction">

经典老歌列表

</p>

<ul id="list" class="list-group">

<li data-view="2"> 一路上有你 </li>

<li data-view="7">

<a href="/2.mp3" singer="任贤齐"> 沧海一声笑 </a>

</li>

<li data-view="4" class="active">

<a href="/3.mp3" singer="齐秦"> 往事随风 </a>

</li>

<li data-view="6"><a href="/4.mp3" singer="beyond"> 光辉岁月 </a></li>

<li data-view="5"><a href="/5.mp3" singer="陈慧琳"> 记事本 </a></li>

<li data-view="5">

<a href="/6.mp3" singer="邓丽君"> 但愿人长久 </a>

</li>

</ul>

</div>'''

可以观察到,ul 节点里有许多 li 节点,其中 li 节点中有的包含 a 节点,有的不包含 a 节点,a 节点还有一些相应的属性 —— 超链接和歌手名。

result = re.search('<li.*?active.*?singer="(.*?)">(.*?)</a>', html, re.S)

if result:

print(result.group(1), result.group(2))

由于需要获取的歌手和歌名都已经用小括号包围,所以可以用 group 方法获取。

运行结果如下:

齐秦往事随风

1.如果正则表达式不加 active(也就是匹配不带 class 为 active 的节点内容),那会怎样呢?我们将正则表达式中的 active 去掉,代码改写如下:

result = re.search('<li.*?singer="(.*?)">(.*?)</a>', html, re.S)

if result:

print(result.group(1), result.group(2))

由于 search 方法会返回第一个符合条件的匹配目标,这里结果就变了:

任贤齐沧海一声笑

2.注意,在上面的两次匹配中,search 方法的第三个参数都加了 re.S,这使得 .*? 可以匹配换行,所以含有换行的 li 节点被匹配到了。如果我们将其去掉,结果会是什么?代码如下:

result = re.search('<li.*?singer="(.*?)">(.*?)</a>', html)

if result:

print(result.group(1), result.group(2))

运行结果如下:

beyond 光辉岁月

可以看到,结果变成了第四个 li 节点的内容。这是因为第二个和第三个 li 节点都包含了换行符,去掉 re.S 之后,.*? 已经不能匹配换行符,所以正则表达式不会匹配到第二个和第三个 li 节点,而第四个 li 节点中不包含换行符,所以成功匹配。

四、findall

前面我们介绍了 search 方法的用法,它可以返回匹配正则表达式的第一个内容;findall 方法会搜索整个字符串,然后返回匹配正则表达式的所有内容。

还是上面的 HTML 文本,如果想获取所有 a 节点的超链接、歌手和歌名,就可以将 search 方法换成 findall 方法。如果有返回结果的话,就是列表类型,所以需要遍历一下来依次获取每组内容。代码如下:

results = re.findall('<li.*?href="(.*?)".*?singer="(.*?)">(.*?)</a>', html, re.S)

print(type(results))

for result in results:

print(result)

print(result[0], result[1], result[2])

运行结果如下:

<class 'list'>

('/2.mp3', ' 任贤齐 ', ' 沧海一声笑 ')

/2.mp3 任贤齐 沧海一声笑

('/3.mp3', ' 齐秦 ', ' 往事随风 ')

/3.mp3 齐秦 往事随风

('/4.mp3', 'beyond', ' 光辉岁月 ')

/4.mp3 beyond 光辉岁月

('/5.mp3', ' 陈慧琳 ', ' 记事本 ')

/5.mp3 陈慧琳 记事本

('/6.mp3', ' 邓丽君 ', ' 但愿人长久 ')

/6.mp3 邓丽君 但愿人长久

可以看到,返回的列表中的每个元素都是元组类型,我们用对应的索引依次取出即可。

如果只是获取第一个内容,可以用 search 方法。当需要提取多个内容时,可以用 findall 方法。

五、sub

除了使用正则表达式提取信息外,有时候还需要借助它来修改文本。比如,想要把一串文本中的所有数字都去掉,如果只用字符串的 replace 方法,那就太烦琐了,这时可以借助 sub 方法。示例如下:

1.例子:

import re

content = '54aK54yr5oiR54ix5L2g'

content = re.sub('\d+', '', content)

print(content)

运行结果如下:

aKyroiRixLg

2.实际应用:

1.在上面的 HTML 文本中,如果想获取所有 li 节点的歌名,直接用正则表达式来提取可能比较烦琐。比如,可以写成这样子:

results = re.findall('<li.*?>\s*?(<a.*?>)?(\w+)(</a>)?\s*?</li>', html, re.S)

for result in results:639*

print(result[1])

运行结果如下:

一路上有你

沧海一声笑

往事随风

光辉岁月

记事本

但愿人长久

2.此时借助 sub 方法就比较简单了。可以先用 sub 方法将 a 节点去掉,只留下文本,然后再利用 findall 提取就好了:

html = re.sub('<a.*?>|</a>', '', html)

print(html)

results = re.findall('<li.*?>(.*?)</li>', html, re.S)

for result in results:

print(result.strip())

运行结果如下:

<div id="songs-list">

<h2 class="title"> 经典老歌 </h2>

<p class="introduction">

经典老歌列表

</p>

<ul id="list" class="list-group">

<li data-view="2"> 一路上有你 </li>

<li data-view="7">

沧海一声笑

</li>

<li data-view="4" class="active">

往事随风

</li>

<li data-view="6"> 光辉岁月 </li>

<li data-view="5"> 记事本 </li>

<li data-view="5">

但愿人长久

</li>

</ul>

</div>

一路上有你

沧海一声笑

往事随风

光辉岁月

记事本

但愿人长久

可以看到,a 节点经过 sub 方法处理后就没有了,然后再通过 findall 方法直接提取即可。可以看到,在适当的时候,借助 sub 方法可以起到事半功倍的效果。

六、compile

前面所讲的方法都是用来处理字符串的方法,最后再介绍一下 compile 方法,这个方法可以将正则字符串编译成正则表达式对象,以便在后面的匹配中复用。示例代码如下:

import re

content1 = '2016-12-15 12:00'

content2 = '2016-12-17 12:55'

content3 = '2016-12-22 13:21'

pattern = re.compile('\d{2}:\d{2}')

result1 = re.sub(pattern, '', content1)

result2 = re.sub(pattern, '', content2)

result3 = re.sub(pattern, '', content3)

print(result1, result2, result3)

例如,这里有 3 个日期,我们想分别将 3 个日期中的时间去掉,这时可以借助 sub 方法。该方法的第一个参数是正则表达式,但是这里没有必要重复写 3 个同样的正则表达式,此时可以借助 compile 方法将正则表达式编译成一个正则表达式对象,以便复用。

运行结果如下:

2016-12-15 2016-12-17 2016-12-22

另外,compile 还可以传入修饰符,例如 re.S 等修饰符,这样在 search、findall 等方法中就不需要额外传了。所以,compile 方法可以说是给正则表达式做了一层封装,以便我们更好地复用。

到此为止,正则表达式的基本用法就介绍完了,后续可以通过具体的实例来体会正则表达式的用法。

参考材料:《Python3网络爬虫开发实战》,崔庆才著。