因为最近在招聘软件上收到了一些Prompt工程师的岗位邀请,月薪在35~45K之间,薪水不菲。

但我本人对Prompt工程师这个概念有所怀疑,总觉得这个事干好了就是在加速自己被裁的进度,而且做一个领域的Prompt设计师过于垂直,投入的精力没有办法得到积累。

所以就看了宝玉大佬整理的微软最新演讲,教我们“如何训练和应用GPT”[1]。

看完后,进一步让我觉得Prompt工程师是风口上的猪,同时我对prompt和GPT的思考模式有了更深的理解。

简单来说,GPT的核心是“模仿”,而Prompt就是给GPT一个模仿的样本。

展开说的话,就一起看看下面的内容吧。

-

token与中文屋

你是不是也对“token”这个概念比较模糊?什么GPT更新了,支持了更多的token输入与输出。

可啥叫token?

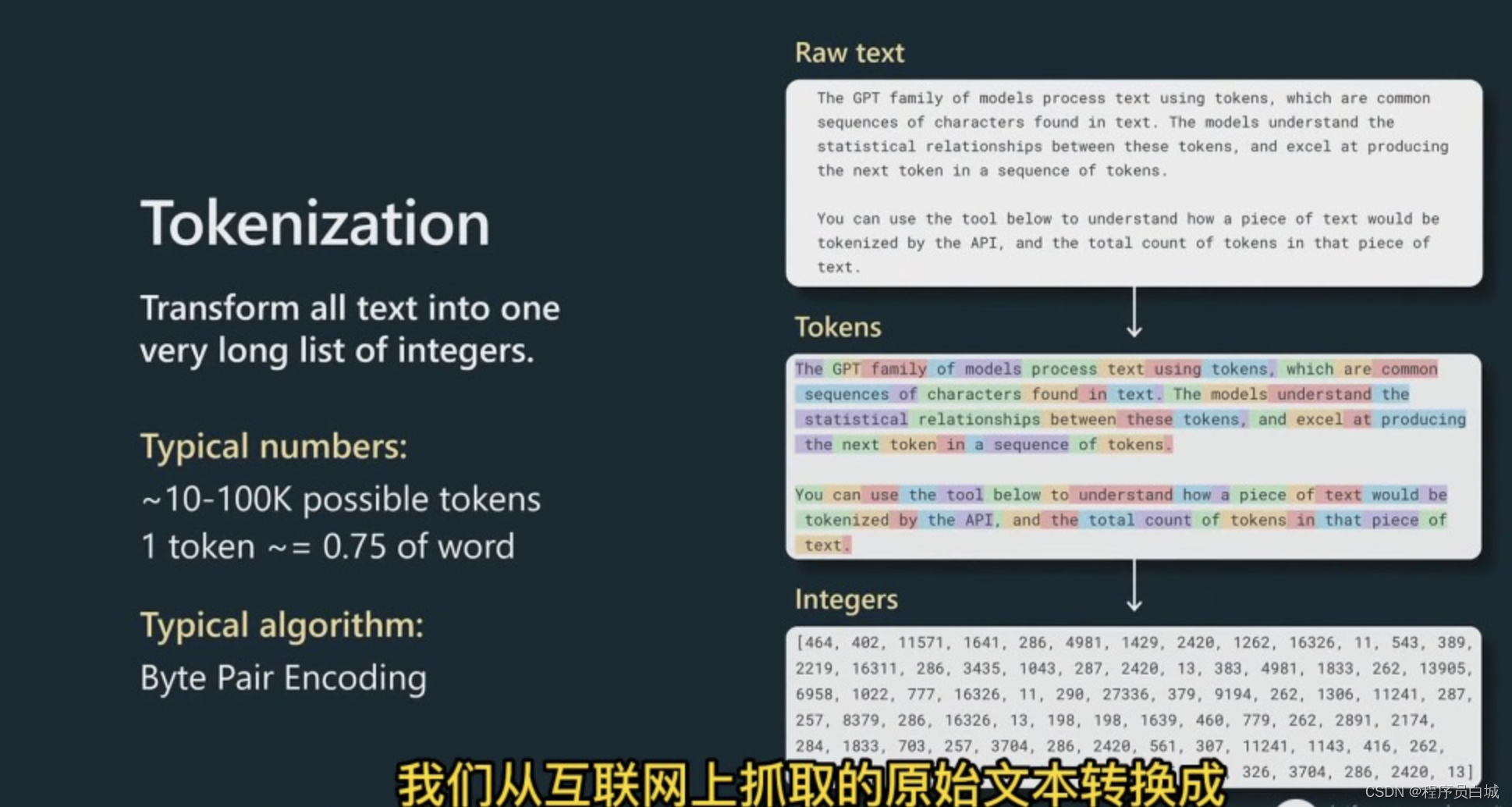

其实,大家常说的tokens,原来就是下图右侧第2张的一堆被分割的彩色单词。

GPT工作时,会把收到的文本(上图右侧第1张),通过分段标注(上图右侧第2张)转换为数字数组(上图右侧第3张)。

接着,拿这一串看着似乎没有意义的数字,送入神经网络。

交由Transform去处理这些输入的权重,最终返回给我们结果。上图输入到输出之间只有3层神经网络,现在GPT据说有80层。

说回正题,你有没有发现,GPT把“文本”转化成“数字”的过程,有点像“中文屋”。

“中文屋”这个概念出自约翰·罗杰斯·瑟尔的论文《心灵、大脑和程序》。它的实验过程可表述如下:

一个对中文一窍不通,只说英语的人关在一间只有一个开口的封闭房间中。房间里有一本用英文写成的手册,指示该如何处理收到的中文讯息及如何以中文相应地回复。房外的人不断向房间内递进用中文写成的问题。房内的人便按照手册的说明,查找合适的指示,将相应的中文字符组合成对问题的解答,并将答案递出房间。

约翰 · 瑟尔认为,尽管房里的人可以以假乱真,让房外的人以为他说中文,但事实上他根本不懂中文。

我们可以这么理解:在上述过程中,房外人的角色相当于程序员,房中人相当于计算机,而手册则相当于计算机程序。

每当房外人给出一个“输入”,房内的人便依照手册(计算机程序)给出一个“输出”。

而正如房中人不可能透过手册理解中文一样,计算机也不可能透过程序来获得理解力。既然计算机没有理解能力,所谓“计算机于是便有智能”便更无从谈起了。

也就是说,GPT本身并不理解它输出的东西,它只是通过80层左右(也不少了)的神经网络,在推断每一个数字(token)后最可能出现的数字,然后再返回给你,这也就是NLP的原理。

所以人们常想的AI统治世界的事,可能还太遥远了。

-

GPT是怎么思考的

我们在写东西时,几乎会有一个独立的系统在审视、思考我们所写的内容。我们通常会有一个“内心独白”,在心里默念整段句子,预期下一句写什么,再整体看看所写的内容是否通顺、符合逻辑。

所以说“写作”甚至是“说话”(察言观色)其实是一个复杂的过程。

但GPT不是这么思考的。

GPT输出的内容是一个一个独立的token,你可以想象成一个个独立的“小块”。GPT在运算每个token时,都会投入同等的注意力,即是说每个token对GPT而言同等重要。那么你就不能指望GPT知道哪里是你想重点输出的内容。

GPT输出时,并不像你,它不做循环反思,也不在“交卷前”进行任何合理性检查,输出了就输出了。

GPT只是在不停推理、模仿出下一个单词。

但它也有优点,它有海量的事实性知识,有几百亿的参数,有完美的工作记忆。

因为我们和GPT思考模式的存在差异,所以才有了所谓的Prompt工程师。这个岗位的作用就是能搭建起我们的大脑和GPT的大脑之间的桥梁,从而达到让GPT思考的更像人一样的目的。

-

Prompt的原则

所以,在使用GPT尤其是用它解答逻辑问题时,你不能指望它像略去过程的参考答案一样,直接用一个token解答你复杂的问题。

给GPT一些token用来思考。

你可以让它“一步步地输出答案”,从而让GPT展示出它的“解题过程”,从而减少GPT输出每一个token所占的工作量。这样,就能提高GPT回答正确的概率。

你可以这么说:

让我们用一步一步地方式来解决这个问题,以确保我们得到正确的答案。

你可能已经发现,GPT最擅长的是“模仿”。

无论是让GPT扮演某个角色,或是给出例子,让GPT一步步地“解题”,都是为了提高GPT的输出效果。

这时候就会觉得,之前我使用的好用的GPT模版都有一些共性,即他们强调“模仿”,并且给出了“实例”。

综上,Prompt工程师需要对业务有深入的理解,同时拥有良好的语文能力(以便写出简明易懂的Prompt)和逻辑思维能力(以便给出GPT一步步模仿的素材),这个岗位,可能是很垂直的行业(如医疗)需要。

灵感

1.

Experience comes from what we have done. Wisdom comes from what we have done badly.

经验来自于我们做过的事情。智慧来自于我们做砸的事情。

2.

我发现,培养能让自己心情愉悦地投入创作工作的好心情,值得你多花几个小时的时间。——《巨人的工具》B. J. 诺瓦克的访谈

3.

知识必须不断地被整理、改进、挑战和提升,否则就会消失。——彼得·德鲁克

4.

世界上的新词可真多啊。

21年我在学DeepLearning的课程时,从没听说过一个词叫“LLM”,但最近老是在招聘需求里看到。

整理了维基[4]里的介绍如下,“虽然没有正式的定义”,汗:

大型语言模型 (LLM) 是一种计算机化语言模型,由具有许多参数(数千万到数十亿)的人工神经网络组成,使用自监督学习或半监督学习在大量未标记的文本上进行训练。 LLM 在 2018 年左右出现,在各种任务中表现良好。这已经将自然语言处理研究的重点从以前为特定任务训练专门的监督模型的范式转移开来。

虽然术语大型语言模型没有正式的定义,但它通常是指具有数百万甚至数十亿个参数的深度学习模型,这些参数已经在大型语料库上“预先训练”过。LLM是通用模型,擅长广泛的任务,而不是针对一项特定任务(例如情感分析,命名实体识别或数学推理)进行训练。