环境:WIN11+ANACONDA+PYCHARM+python3.6.6+tensorflow-gpu1.12

目标:创建图、使用图、使用变量、使用fetch和feed、一个案例

快捷键:shitf+enter运行;tab补全;shift+tab查看方法详情

Graph1中。节点op,可理解为操作。需要传入数据、变量,进行op后,再输出新的数据。

Graph2给出了一个具体的例子。

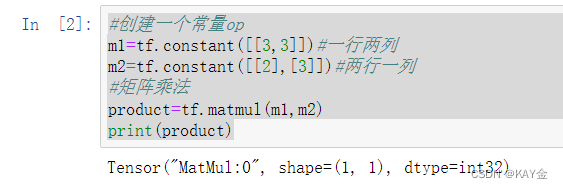

在JUPYTER里尝试运行一个实例,

import tensorflow as tf

#创建一个常量op

m1=tf.constant([[3,3]])#一行两列

m2=tf.constant([[2],[3]])#两行一列

#矩阵乘法

product=tf.matmul(m1,m2)

print(product)运行结果为一个Tensor,因为这里虽然定义了op,但并没有放在会话里执行。

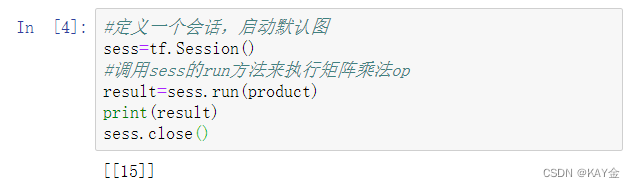

完整的执行op需要定义一个会话:

#定义一个会话,启动默认图

sess=tf.Session()

#调用sess的run方法来执行矩阵乘法op

result=sess.run(product)

print(result)

sess.close()

也可以用其他方式定义会话:

with tf.Session() as sess:

#调用sess的run方法来执行矩阵乘法op

result=sess.run(product)

print(result)这样就不需要去关闭会话了。

接下来学习变量。

x=tf.Variable([1,2])

a=tf.constant([3,3])

#增加一个减法op

sub=tf.subtract(x,a)

#增加一个加法op

add=tf.add(x,a)

#初始化所有变量

init = tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

print(sess.run(sub))

print(sess.run(add))输出为:

[-2 -1] [4 5]

再举一个例子,实现变量的自增

#创建一个变量,初始化为0

state =tf.Variable(0,name='counter')

#创建一个op,作用是使state加1

new_value=tf.add(state,1)

#赋值op

update = tf.assign(state,new_value)

init=tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

print(sess.run(state))

for _ in range(5):

sess.run(update)

print(sess.run(state))输出为:

0 1 2 3 4 5

接下来学习fetch和feed

fetch就是同时运行多个op

#fetch

input1= tf.constant(3.0)

input2= tf.constant(2.0)

input3= tf.constant(5.0)

add=tf.add(input2,input3)

mul=tf.multiply(input1,add)

with tf.Session() as sess:

result=sess.run([mul,add])

print(result)输出为:

[21.0, 7.0]

feed则是不初始化变量的具体值

#feed

#创建占位符

input1 = tf.placeholder(tf.float32)

input2 = tf.placeholder(tf.float32)

output=tf.multiply(input1,input2)

with tf.Session() as sess:

#feed的数据以字典的形式传入

print(sess.run(output,feed_dict={input1:[7.0],input2:[2.0]}))输出为:

[14.]

一个使用案例:逼近线性模型y=0.1x+0.2

import tensorflow as tf

import numpy as np

#使用numpy生成100个随机点

x_data=np.random.rand(100)

#样本模型

y_data=x_data*0.1+0.2

#构造一个线性模型

b=tf.Variable(0.)

k=tf.Variable(0.)

y=k*x_data+b

#定义一个二次代价函数

loss=tf.reduce_mean(tf.square(y_data-y))

#定义一个梯度下降,优化训练,学习率0.2

optimizer=tf.train.GradientDescentOptimizer(0.2)

#定义一个最小化代价函数

train=optimizer.minimize(loss)

#初始化变量

init=tf.global_variables_initializer()

with tf.Session() as sess:

sess.run(init)

for step in range(201):

sess.run(train)

if step%20==0:

print(step,sess.run([k,b]))输出为:

0 [0.05407926, 0.10036313] 20 [0.1038326, 0.19792749] 40 [0.10238596, 0.19870982] 60 [0.10148535, 0.19919682] 80 [0.100924686, 0.1995] 100 [0.10057565, 0.19968873] 120 [0.10035835, 0.19980623] 140 [0.10022309, 0.19987938] 160 [0.10013888, 0.19992492] 180 [0.100086465, 0.19995324] 200 [0.10005383, 0.19997089]

ps:具体值可能不一样,但都是趋近【0.1,0.2】