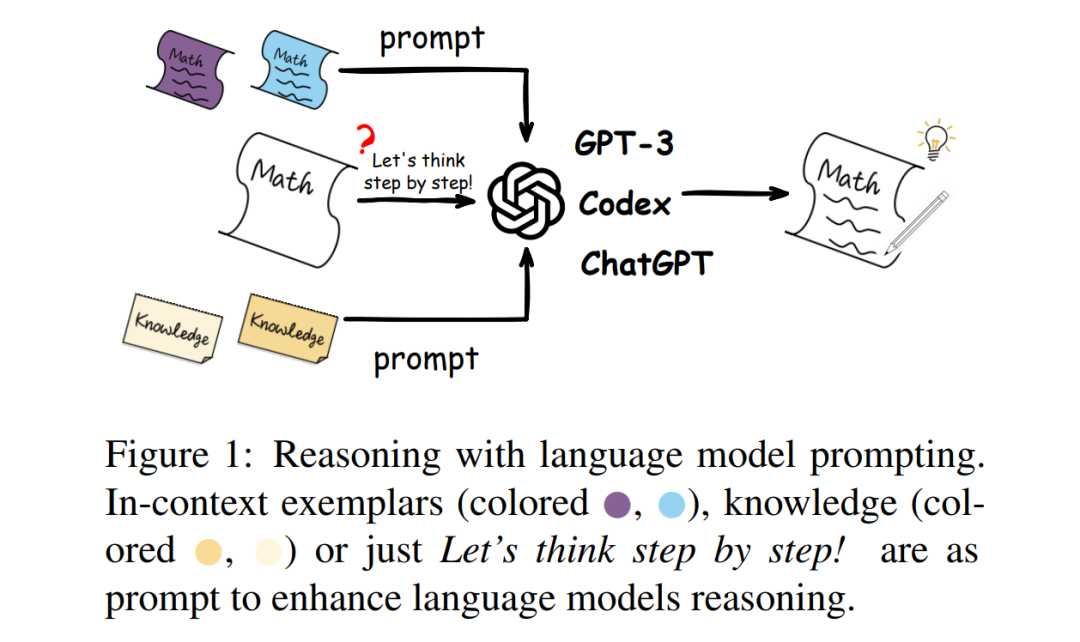

大语言模型需要65B或更多参数量才能涌现足够的推理能力,这对于训练或微调是极大的资源与人力挑战,那有没有办法不训练模型来充分利用大语言模型的能力?这还真有,办法是顾问团与小助手。

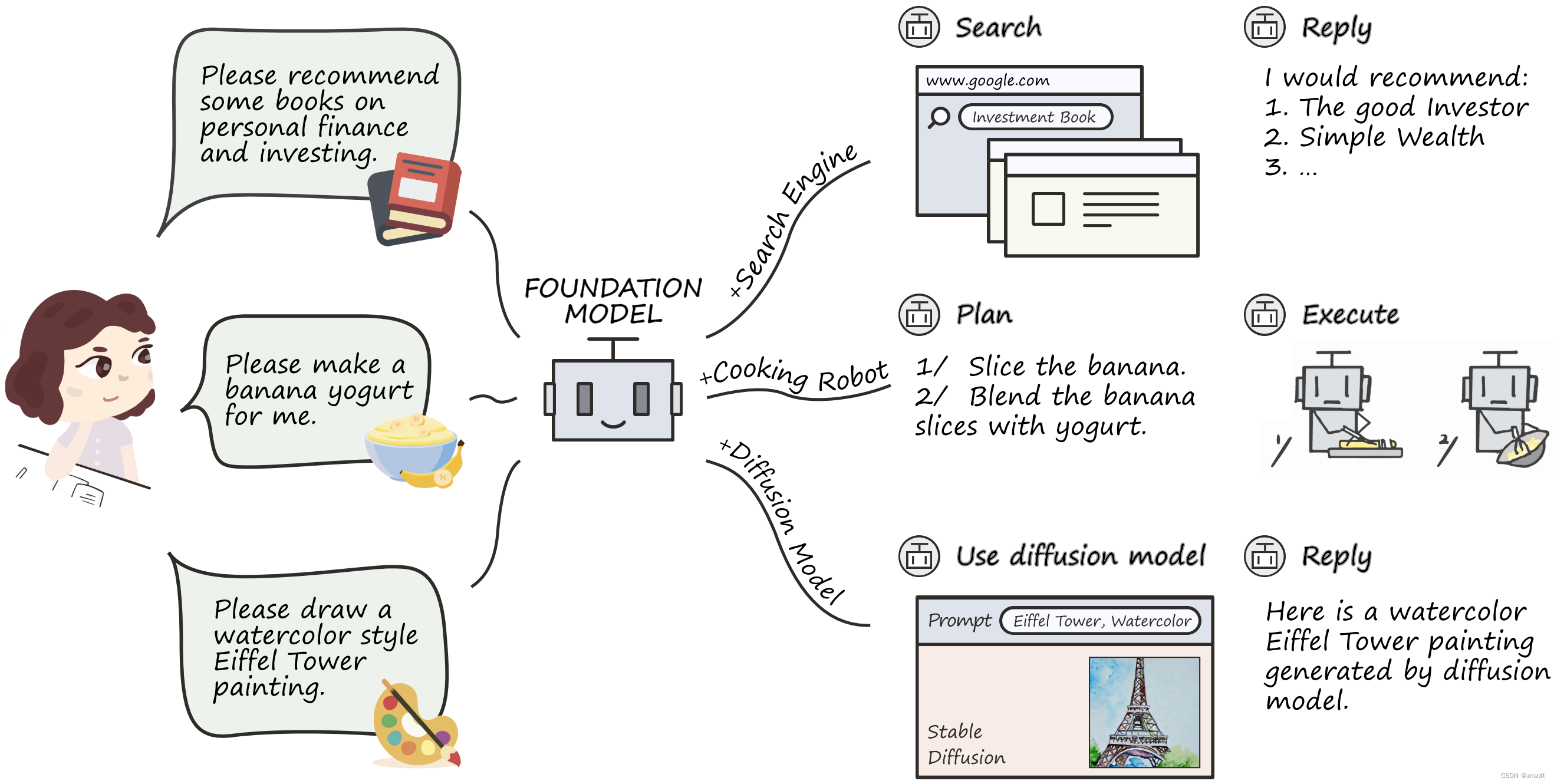

核心架构是 以LLM为中心,作为中枢调度,Langchain方式作为顾问团(提供业务相关资料),Tools作为小助手,被LLM调用来获得具体的能力。 这种方式可以补充大模型对于实时知识的不足以及具体业务能力(如复杂 数据计算)的不足,利用大模型的推理与归纳能力。

lanchain: LangChain 完整指南:使用大语言模型构建强大的应用程序 - 知乎 (zhihu.com)

tool learning: OpenBMB/BMTools: Tool Learning for Big Models, Open-Source Solutions of ChatGPT-Plugins (github.com)

系统架构图:

本质上,langchain工具包也有部分类似tool learning的功能:

Tool Learning 架构图: