大家好,我是千与千寻,好久不见,最近太忙了,去医院拔了颗智齿,这不是刚休息一天,就立刻来给大家分享ChatGPT的新奇项目了。

ChatGPT的功能确实是好用,但是我觉得有一个小缺点,就是反应的时间比较慢,原因是GPT-3.5/GPT-4.0的模型体积较大,比较占用内存空间。

同时大模型的运行是在国外的主机上,在一定程度上网络传输也消耗时间。

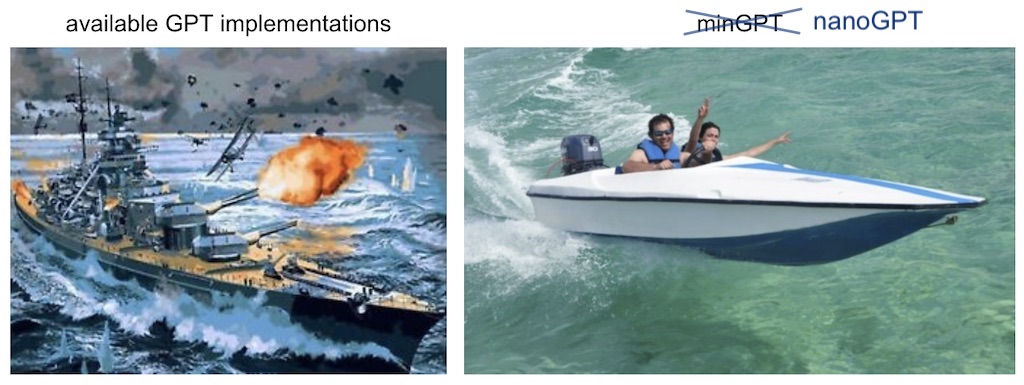

今天给大家带来的项目是nanoGPT模型,他是minGPT模型的重写,但是比minGPT模型的体积更小,性能更好!

我们今天手动复现一下nanoGPT模型,可能说到现在,你可能有些一头雾水,千寻哥到底要做什么?

放心,程序员同行之间禁止废话

nanoGPT可以简单理解为构建ChatGPT的框架,我今天带领大家手把手使用nanoGPT框架,训练一个微型的ChatGPT,GPT的全称是“Generative Pre-trained Transformer”。就是文本预训练的生成模型。

NanoGPT地址:

https://github.com/karpathy/nanoGPT

我们首先复现官方的Demo,训练一个在莎士比亚的作品上训练一个角色级别的GPT。

首先,我们将其下载莎士比亚的戏剧文本作为训练模型的数据集。

1、莎士比亚戏剧数据集的部分文本内容&#x