导读

扩散模型的发展引起了各界对生成模型的广泛讨论,推动了语音、音频、图像等模态的理论模型进步。6月10日的北京智源大会“生成模型”论坛邀请了斯坦福大学副教授Stefano Ermon、浙江大学教授赵洲、智源研究院研究员刘广、加州大学洛杉矶分校助理教授周博磊、斯坦福大学助理教授吴佳俊,共话生成模型领域的最新进展,展开了别开生面的前沿讨论。

使用分数而不是可能性是建模分布的关键思想。-- Stefano Ermon

音频比文本更复杂,不止包含语义信息,也包含韵律、时长、能量、音高等属性。-- 赵洲

数据混合扩充的方式可能是个正确的方向。-- 刘广

把生成模型和机器决策结合起来,可以提供一些新的思路。-- 周博磊

利用自然界中存在的丰富的结构、符号和程序,是为了在视觉世界中更好地感知和理解。-- 吴佳俊

论坛专家名单

李崇轩 |中国人民大学准聘助理教授

Stefano Ermon | 斯坦福大学副教授

赵洲 | 浙江大学教授

刘广 | 智源研究院研究员

周博磊 | 加州大学洛杉矶分校助理教授

吴佳俊 | 斯坦福大学助理教授

朱军 | 清华大学教授、智源首席科学家

Recent advances

in score-based diffusion models

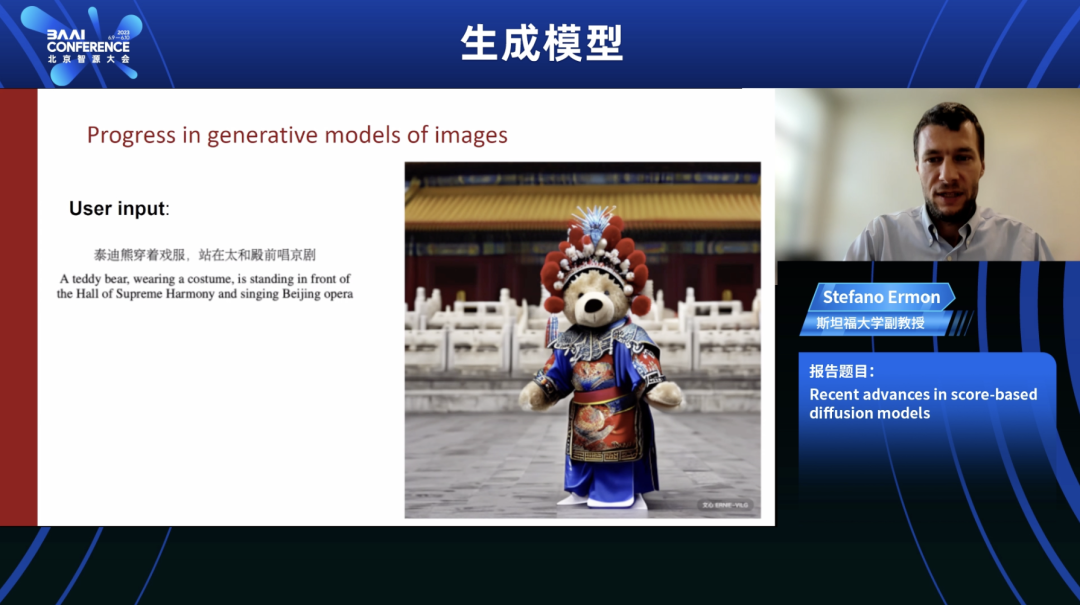

Stefano Ermon | 斯坦福大学副教授

图像生成技术的基础是构建一个能够理解自然图像结构的模型,模型需要理解什么样的像素序列是合理/不合理的。这种模型还可以被用来检测对抗性攻击,或者找出机器学习系统的输入是否有问题。

建立一个复杂的生成模型是有挑战性的,因为概率分布需要建立在非常高维的空间上,同时模型需要能够为大量可能的对象分配概率。

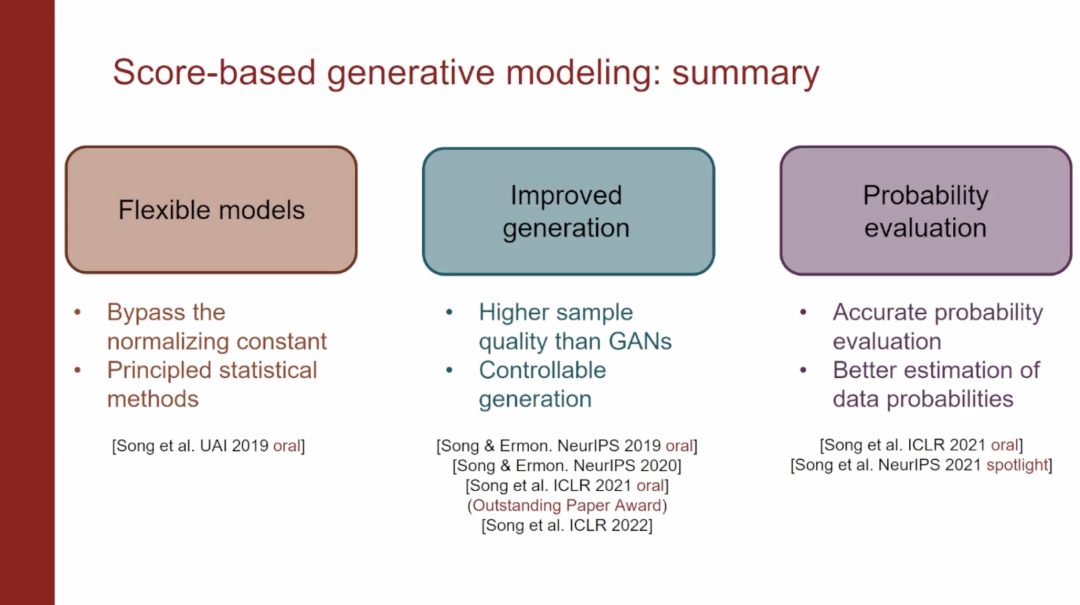

得分函数是对数密度函数的梯度,通过得分函数,可以直接使用任意神经网络进行建模。这是一项关键创新,使我们能够使用更强大的神经网络来开发图像的概率模型。

将目标函数重写为等价形式,实际上是试图最小化在不同数据点估计分数的范数,同时最小化在训练集中的数据点评估分数的雅可比轨迹。当处理高维数据时,可以比较它们的随机投影而不是直接比较梯度的向量场,可以扩展到像图像这样的高维数据集,仍保留分数匹配、一致性和渐近正态性的许多良好性质。

所有这些优秀的图像-文本-图像生成模型的核心是这种基于郎之万动力学估计数据分布的得分的想法。扩散模型允许以一种非常自然的方式控制生成过程,可以应用于不同数量的投影和不同类型的测量。

使用分数而非概率是建模分布的关键思想,能够使用任意的神经网络来对梯度的矢量场进行建模,可以在不使用对抗性方法或者在极大极小的情况下,使用扩散模型进行可控生成,从这些模型中进行采样,不仅可以生成样本,而且在样本中可以评估模型下的可能性。

多模态生成式语音模型

赵洲 | 浙江大学教授

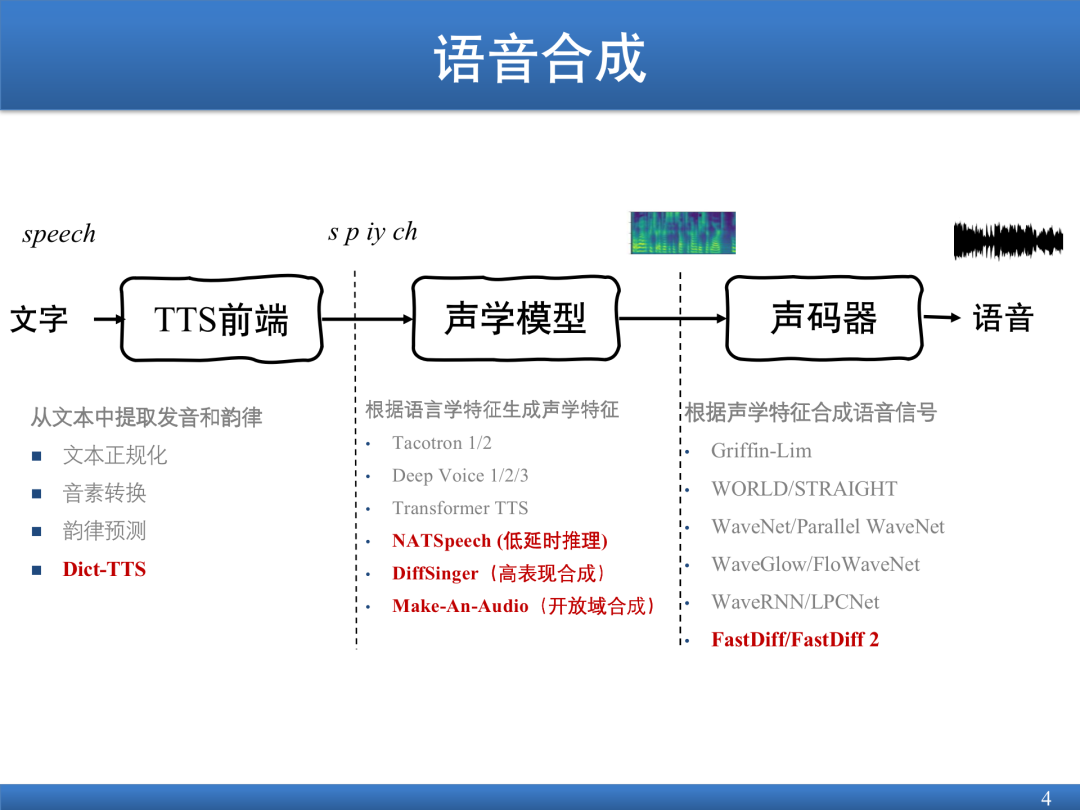

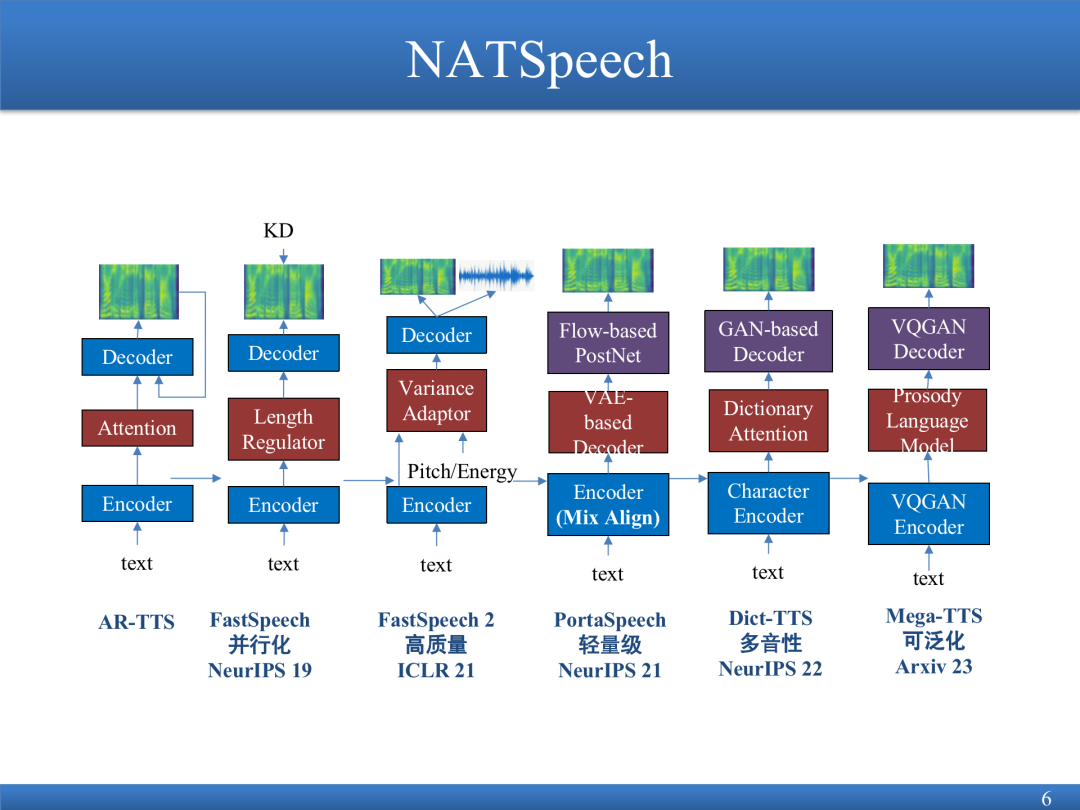

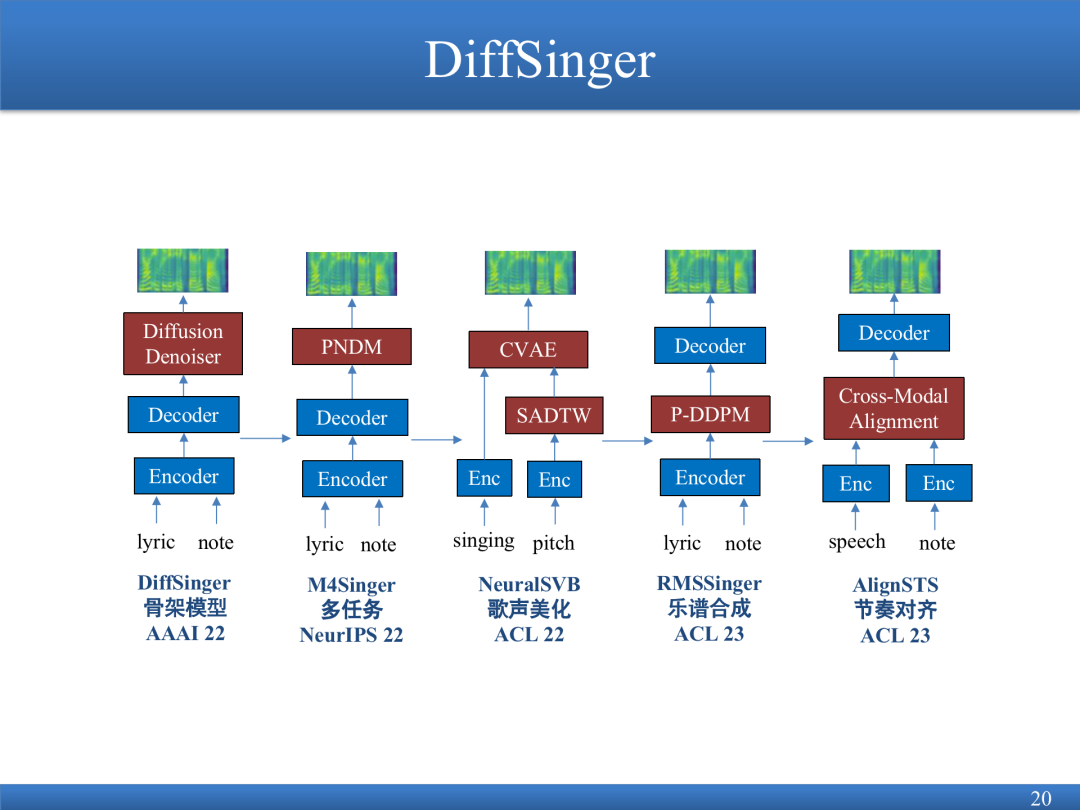

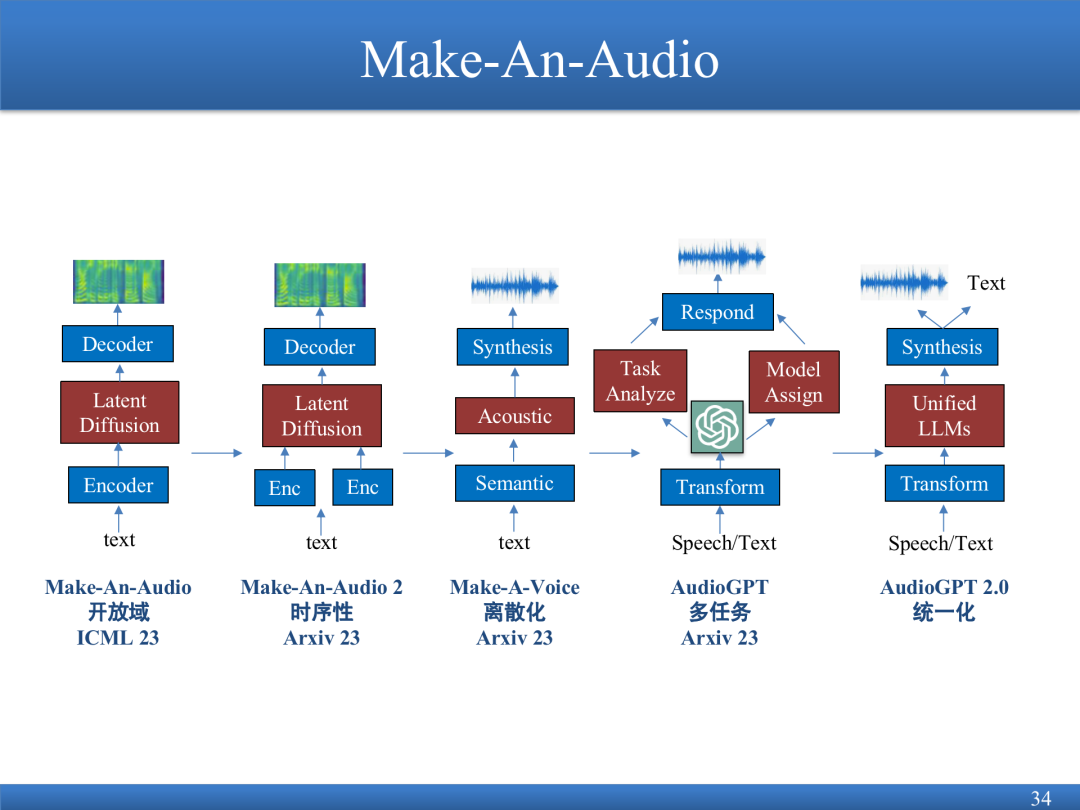

本次报告从三个角度来介绍生成式模型在声学模型的应用:生成语音的NATSpeech模型;语音生成歌声的DiffSinger模型;生成音频的Make-An-Audio模型。音频生成也是一种语音生成。其 框架,一般由三个部分组成:(1)前端。通过NLP的技术从文本中提取发音、韵律;(2)给定音素,合成频谱;(3)声码器,输入频谱图,输出语音。

NATSpeech模型基于Transformer框架做了一些改进。Transformer框架的推理速度相对是比较慢的;并且存在一些漏词的现象。为了同时提高推理速度和解决漏词的现象,NATSpeech采用了非自回归的预测形式,实现了模态转换的学习过程。

DiffSinger模型可以完成一些高表现力合成工作,沿用PortaSpeech的思想,用之前的模型生成出来的频谱编码,对不同的频谱进行加噪,进行一次性加噪和加速降噪,生成歌曲。

Make-An-Audio可以给文本、图片、视频配音,修复音频,支持通用音频合成。

AudioGPT 把之前的工作进行集成,支持不同的任务,从音频到文本、音频到音频、文本到音频、图片到音频不同的生成工作,得到整合的能力。

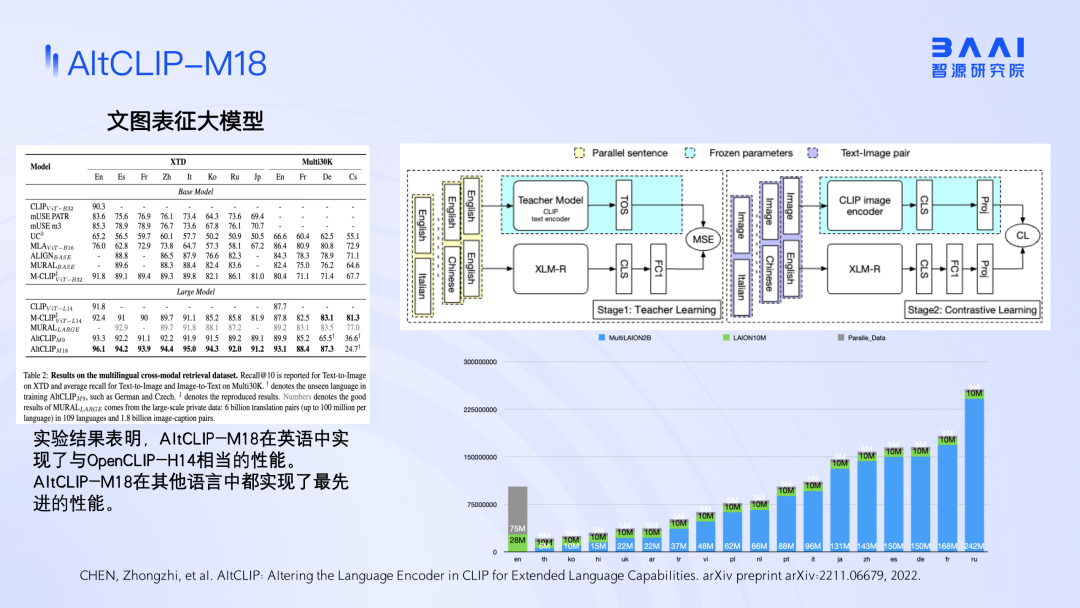

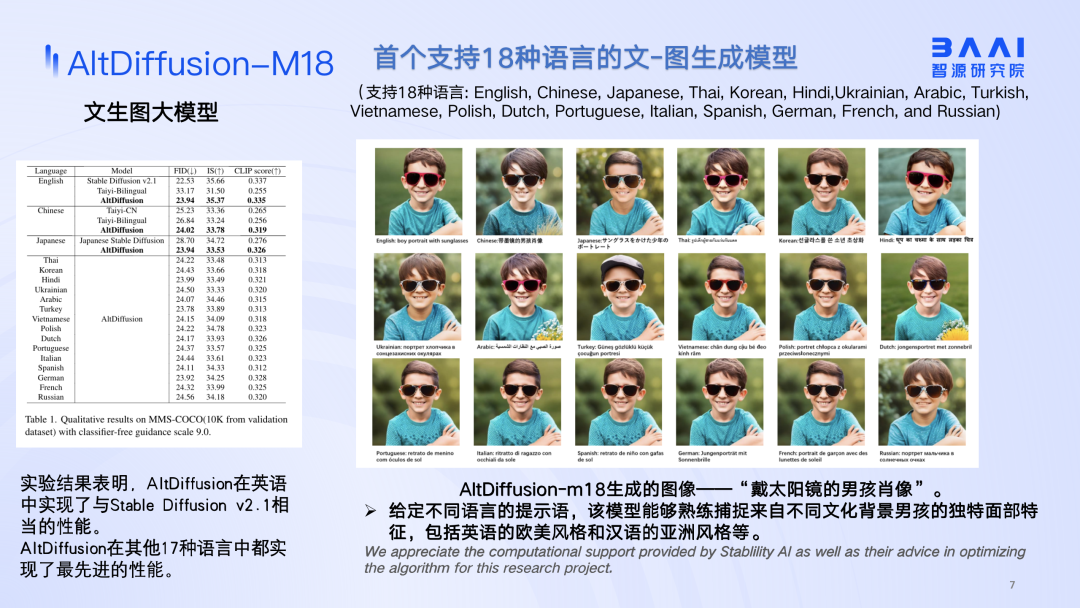

“低资源”的多语言文生图模型

AltDiffusion-M18

刘广 | 智源研究院研究员

现有的文生图领域研究存在三个主要问题:

(1)缺乏高质量数据集。开源数据集的质量是参差不齐的,语言分布极度不均衡,可以获取的渠道有限。

(2)可控生成。在生成的时候,可控性还不够高,难以实现复杂编辑。

(3)文生图的评价。自动化评价指标跟人的主观评价指标一致性较低,人工评价成本比较高,缺乏统一的评价标准的定义。

本次报告主要针对高质量数据集的问题展开。

中文开源图文的数据集,在多语言分布上很不均衡。为了训练Diffusion的多语言版本,先训练了多语言版本的CLIP,分别对英文和中文的数据蒸馏。这种训练模式会降低英文表达能力。把这个CLIP模型接到原来的Diffusion模型上,做了一个扩展,相当于是把原来的2.1扩展成18种语言文图生成模型,从而能够支持18种语言。

把Aquila模型、最新智源公布的语言模型和Diffusion模型对接,可以用文字输入去做一些图片的生成,同时,还接入多步可控编辑的模块,把复杂的多步的指令输入到语言模型中。语言模型分解指令,然后再基于指令做可控图像编辑的模型,可以在很大程度上保留所有的细节信息,同时实现对部分的区域进行高精度的修改。

不管是AltDiffusion模型,还是AltCLIP模型,把不同语言混合到一起进行对比学习,或者Diffusion模型训练的时候,都会遇到数据不平衡的问题。如果只在一个语言环境中训练会破坏语言的对齐能力,如果把多种不同平行语言的能力放在一起做训练,可能会缓解这样的问题。

基于鸟瞰图的可控

和可交互的大规模场景生成

周博磊 | 加州大学洛杉矶分校助理教授

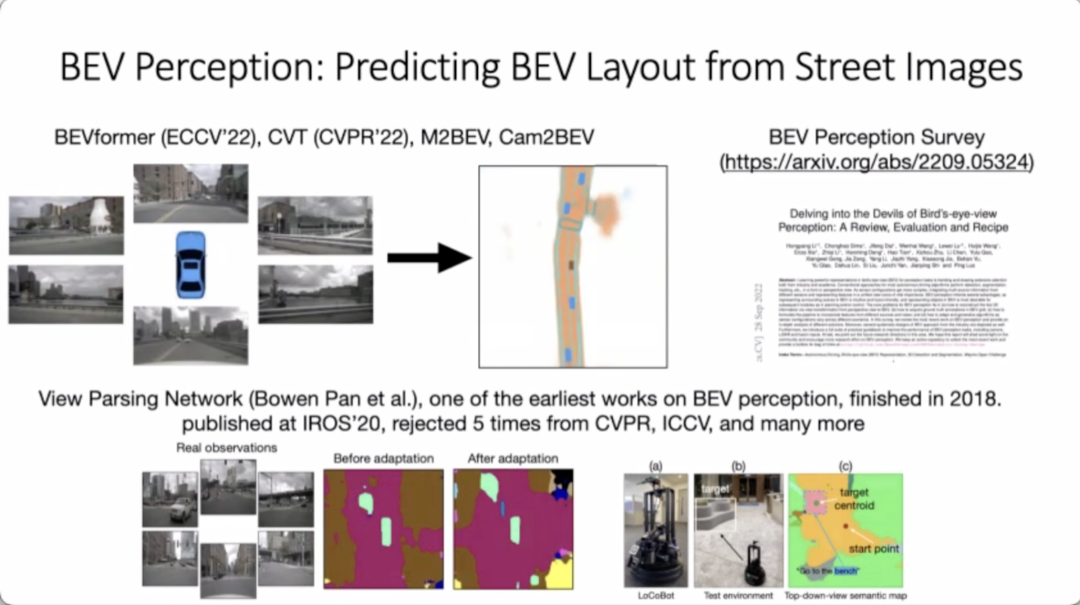

这里关注的是有条件的场景生成,更直接的一种表征方式是鸟瞰图的表征方式。第一部分,利用鸟瞰图进行场景生成,研究希望生成这种第一视角的驾驶图片;第二部分,基于鸟瞰图进行场景仿真,加入一些物理的表征,使整个场景就可以真正动起来,也可以跟下游的任务(比如自动驾驶)联系起来。

研究希望把输入的一个鸟瞰图生成不同视角第一人称的图片。解决方法是对BVE-Gen 进行建模,分别对鸟瞰图及图片生成进行学习,再把两部分联系起来,采取编码的不是文本而是BEV,把鸟瞰图变成特征后,将图片解码出来。

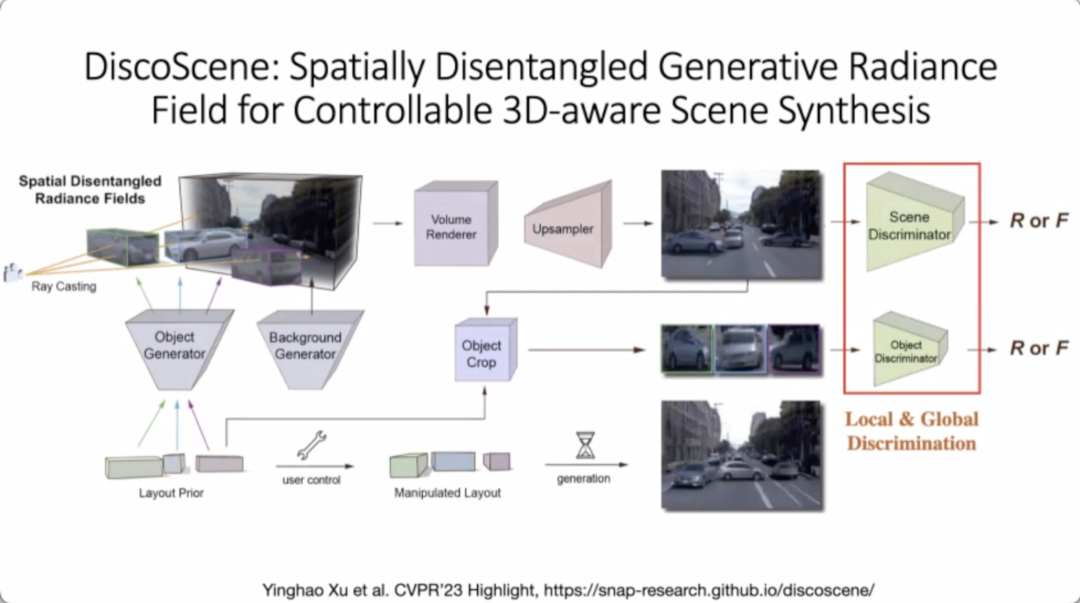

研究尝试把生成模型和神经场模型结合起来。神经场模型可以重建场景,并没有生成能力,但是神经场模型自身带有很多3D信息,把这两者进行融合,相当于用二维鸟瞰图生成三维结构图,再从三维结构图里面进行神经的渲染,把场景渲染出来。

研究提出了DiscoScene的模型。模型的输入是一个鸟瞰图的3D的抽象表征,象征物体对应的位置,可以把前景和背景两者结合起来,相当于把GAN的模型跟神经场模型结合,提高图片真实度。通过改变输入的Layout的结构,把生成出来的图片进行对应编辑,使用神经网络进行渲染。与之前的一些方法进行了对比,在3D-aware的细分领域,这些场景里面DiscoScene模型效果都是目前最好的。

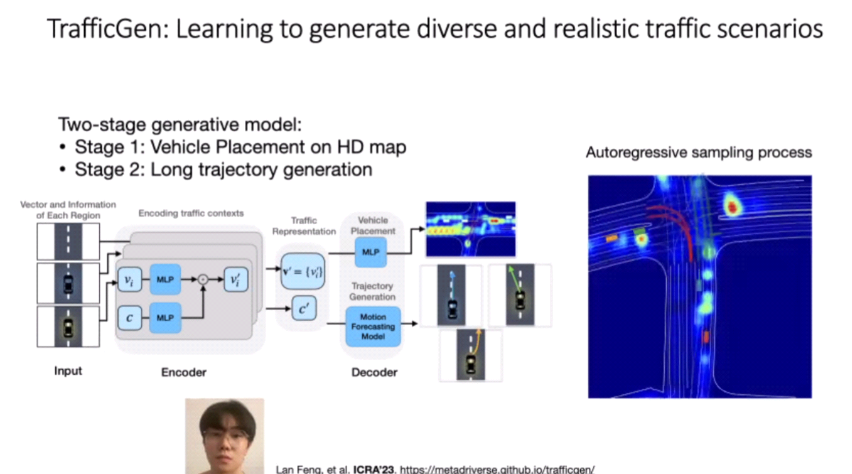

MetaDrive的驾驶模拟器可以更好地把机器决策跟机器感知结合起来,其效率相对以前的模拟器大幅提高,在单机PC上面,可以达到500帧的训练效率,保证了它的场景可以从实际数据库里面导入一些新的场景。同时团队研发了一个TrafficGen的模型,生成过程分两个步骤:把车放入鸟瞰图;对每一辆车生成未来轨迹,从而对这个场景进行仿真。

TrafficGen模型已经开源,可以把TrafficGen产生的场景导入到其他的模拟器,帮助模拟器拓展场景。

Understanding the Visual World

Through Naturally Supervised Code

吴佳俊 | 斯坦福大学助理教授

本次报告对什么是编码以及什么是自然监督有更广泛的解释。利用自然界中存在的丰富的结构、符号和程序,是为了在视觉世界中更好地进行感知和理解。从根本上说,编码规则的形成只有两个过程:第一种编码规则来自人类;第二种编码来自自然。一类自然对象都有相同的内在分布,包括几何形状,包括纹理,包括构成的材料,如何反射光线,还包括它们的物理特性。即使真正学到了物体内在的生成分布,仍然有事物内在的规则性、结构或编码,自然将它们提供给我们。通过生成神经网络执行这种更通用的约束或编码,能帮助我们更好地理解视觉世界。

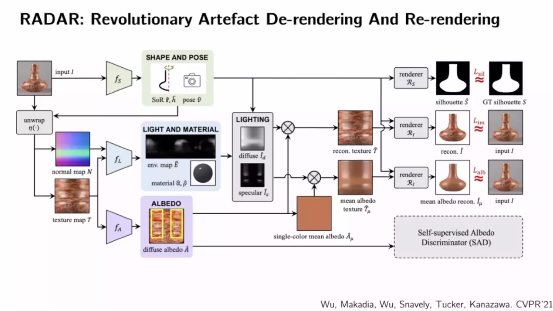

关注相关视觉数据的程序论文,从草图到自然图像开始,到单图像学习,然后从一个平面到多个平面,直到3D方向的研究。3D中的物体形状,通常具有抽象和程序化的结构。从某种意义上说,使用学习方法来模拟实际成形过程,能够推断出形状的程序表示。同样的,在计算机图形学中,关于如何使用计算机图形学的过程模型来处理形状,就是使用神经网络进行推理。因为形状程序的分配非常有限,使用神经网络作为程序执行器,这样就可以进行大部分自监督的训练。

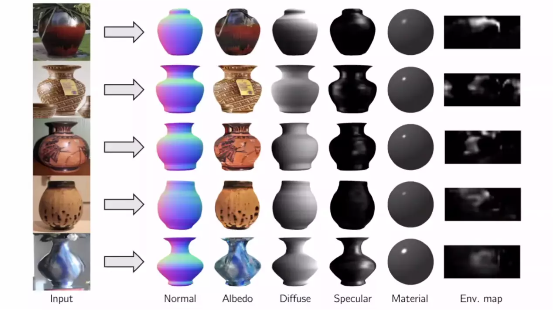

在几何学中这些形状有明确的规律,比如它是旋转对称的。一旦有了形状,将对象平铺,这样就可以得到表面的法线和纹理。进行标准的内在图像分解,可以在重新渲染期间将其放回,重建纹理,然后将其放置到极点和形状,重建原始图像。

通过设置不同的内在的图像组件,表面法线和反射率得到3D效果,可以对物体进行虚拟化,可以从不同的视图观察。

视觉世界中的一类示例或一种对象,它们天然共享基本相似的内在特性、几何形状、反射率。这些是会考虑纳入的基本的自然监督编码,这是一种普遍性,确实适用于所有地方。未来可以考虑如何将其扩展到具有复杂背景的更复杂场景,即照明、对象和背景之间的复杂交互,这些场景有些更具程序性,有些则更少。

至于如何从被动感知到互动,再到与场景互动,其中很多都是受认知启发的。那么,如何将人类认知与自然语言联系起来,因为语言和谈论事物的方式是另一个重要的自然监督来源,将是另一个更具启发性的研究工作。

圆桌讨论

y

Q1、生成式AI的发展可能有很多滥用问题,导致社会安全性或者一些其他的问题,如何从技术上解决这些隐患?

朱军:从AIGC发展之后,技术可能被用在恶意的目的。2019年前后,有用生成式模型-GAN技术合成虚假视频在网上传播带来一些恶意的效果。在那之后,大家都在想着用程序、用人工智能来识别自动检测这种Video、图片、语音、文本等等。

相关的技术方面在AIGC更进一步发展之后,生成质量是更高的,实际上计算机生成的内容和自然的、真实的图片或者视频也好,还是有很多区别的,比如说它的一些特征分布会存在差异,包括有一些通过换脸等等合成出来的图片或者视频,本身在自然度上,平滑上会存在特征的区别,用这些信息可以通过计算机算法方式更精准地来做识别,这个也有很多的进展和相关的应用。

但是这本身是相互在演进的,未来的AIGC是不是能够发展到完全超过了,现在对人来说很多程度是可以接受,视觉上可以达到比较好的效果,但是未来在算法上,也会对检测算法带来更多影响,我相信肯定会是这样的。

但是检测本身,我觉得还是检测内容上比较有负面影响的内容,并不是对检测是不是算法生成,这可能并不是那么地急迫,相对来说我觉得就像刚刚讲的一些案例,有一些目的的内容,这可能从本身要表示的内容上可以去进一步地检测,不光是从展示的视觉特征上。

吴佳俊:就像朱老师最后说的,AIGC肯定会越来越精确,以至没有办法分辨。最终是需要社会有系统性的解决问题,就像炸药一样,我们要制定规则。如果说这个技术变得越来越方便的时候,尤其现在可以改造模型,你可以转化Token,进一步就可以模仿人类的行为,你可以得到这个人在做别的事情,各种场景下的结果,我觉得它肯定会非常真实。现在可能Video的效果还不太好,将来会越来越好,Video在网上有很多数据,至少通过外表的角度看起来是真实的角度,效果是很真实的。这个问题到最后就不是一个纯粹技术性的问题,就是需要一个综合社会考虑的问题。

赵洲:现在的生成模型可能会有一些生成的不自然的地方,可以来进行检测。随着模型越来越大,越来越逼真,之后是很难分辨出来的。我的一个看法就是,并不需要否定生成技术的本身,主要针对它可能会出现一些比如说恶意内容的情况来采取措施。

如果模型越来越逼真,越来越细节,个人认为可能还有一个方式可以来分辨,就是在模型生成的时候,给模型加载数字的水印。加载数字水印的同时,标注生成的内容是通过哪个模型或者哪个机构生成的,从而很快找到这个内容的来源。

Q2、从算法或者基础模型发展来看,在Diffusion之后,您觉得我们还会有下一步大的突破吗?

朱军:肯定会有下一步大的突破,就像Diffusion model出来之前,大家说GAN已经非常好了,但突然有一天Diffusion出来之后,很多人转而拥抱Diffusion model。现在其实Diffusion model从本质上也不是说没有局限,也存在很多开放性的问题。

Q3、吴佳俊教授的报告从知识出发,或者自然的一些规律出发,它有很好的约束能力、控制能力,有很好的泛化性。但是最近也有一种新的方法,类似于大规模预训练模型,两种方法互有优劣,如何看待它们未来的发展前景?

吴佳俊:我不觉得它们有什么原理上的不同,我觉得它们目标相同,只不过出发点不同。它们在很大程度上属于同样抽象的概念。可能抽象的概念实际是一种非常微妙的方式出现的,并不是说它们是互相矛盾的,其实可能只是一个范围。

Q4、以后多模态模型会如何的发展?我们需要做到多少模态?或者说是不同模态之间怎么样去互相提升等等这些问题。

赵洲:我们现在做理解和生成这两个问题都是分别来解的,在大模型的时代下,我们是希望把理解和生成一起放在一个统一的模型中,比如说以人机交互为例,我们输入Talking-face,输出语音等不同的模态。

Q5、下一步生成模型如果再突破,或者未来发展最人激动人心的点是什么?

赵洲:生成模型与大语言模型相结合,能够实现很好的人类和机器的智能交互,会有很多全新的场景可以构思,比如物理空间到虚拟空间智能交互的映射,都是非常有趣的。

吴佳俊:我有两个期待,一个是短期的,可以继续研究的video方向;还有一个怎么更好地做3D方向,到底是选择什么样的数据,处理现有的数据还是实时的数据。从ProlificDreamer开始,能够做得更好,做得更具有泛化性,更有适应性,我觉得这是非常令人激动的。

第二个,我觉得这一个基础研究问题,关于将来的方向,AI把任务完成很好以后,怎么样能够控制住AI的发展方向,让它能够具备持续的生产力。模型要生成的不管是音频、歌曲、视频、文字也好,AI需要把控最好的衡量标准,能够实现人类和设备更好的互联互动,这个还是有很多的工作要做,当然也涉及到很多社会性的问题。

朱军:机器人和实体相结合。将来我们看到的不光是一个模型、一个算法,可能是一个实体的对象,可以和环境、和人、和各个方面来进行交互和演进。

- 点击“查看原文” ,观看完整大会视频回放 -

回放 -

具身智能与强化学习前沿进展丨2023智源大会精彩回顾

大模型与人类的未来丨基于认知神经科学的大模型论坛精彩回顾