MediaCodec是什么

MediaCodec是Android平台上的一个类,用于实现多媒体数据的编解码操作。它提供了对底层硬件编解码器的访问和控制,可以实现高效的音视频编解码处理,包括解码和编码功能。

通过使用MediaCodec,开发人员可以利用硬件加速功能,对音频和视频数据进行实时的解码和编码操作,以实现流畅的媒体播放、录制、转码等功能。

MediaCodec在Android系统中提供了对常见的音视频格式(如H.264、H.265、AAC等)的硬件加速支持,可以利用设备的硬件解码器或编码器来处理媒体数据,提供更高的性能和效率。

使用MediaCodec可以操作音频和视频数据的原始字节流,实现从文件、网络流或其他来源中获取数据,并将处理后的数据输出到指定的目标(如Surface、AudioTrack等)进行后续处理或展示。

MediaCodec解码H265原理步骤解析

- 创建MediaCodec实例:首先,需要创建一个MediaCodec实例来进行H.265解码操作。可以通过调用MediaCodec.createDecoderByType(“video/hevc”)方法创建一个H.265解码器的实例。

- 配置解码器:在创建解码器实例后,需要通过调用MediaCodec.configure()方法来配置解码器的参数,例如输入数据格式、输出数据格式、解码相关的参数等。这是一个必要的步骤,以确保解码器能够正确地处理输入数据。

- 准备解码器:在配置解码器后,需要调用MediaCodec.start()方法来准备解码器,使其进入准备就绪状态,可以开始接受输入数据并进行解码。

- 输入数据:通过调用MediaCodec.dequeueInputBuffer()方法获取一个可用的输入缓冲区,将H.265视频的数据填充到输入缓冲区中。可以从文件、网络流或其他来源中获取H.265视频数据,并将其传递给解码器。

- 解码数据:将填充好数据的输入缓冲区传递给解码器,调用MediaCodec.queueInputBuffer()方法将输入缓冲区提交给解码器进行解码。解码器会将解码后的数据存储在输出缓冲区中。

- 获取解码数据:通过调用MediaCodec.dequeueOutputBuffer()方法获取一个可用的输出缓冲区,这个缓冲区包含了解码后的视频数据。可以通过读取输出缓冲区的数据进行后续处理,如渲染到Surface进行显示。

- 渲染输出数据:将解码后的视频数据进行渲染,可以通过Surface进行显示,或者进行其他处理,如保存到文件、传输到网络等。

- 释放缓冲区:在使用完输出缓冲区后,需要将其释放,以便下次使用。通过调用MediaCodec.releaseOutputBuffer()方法释放输出缓冲区。

- 停止解码器:当解码完成所有输入数据后,可以调用MediaCodec.stop()方法停止解码器的运行,释放相关资源。

- 释放解码器:最后,调用MediaCodec.release()方法释放解码器的实例,释放相关的系统资源。

实战代码示例

使用MediaCodec解码H.265视频的简单示例代码:

import android.media.MediaCodec;

import android.media.MediaExtractor;

import android.media.MediaFormat;

import android.view.Surface;

import java.io.IOException;

import java.nio.ByteBuffer;

public class H265Decoder {

private MediaCodec mediaCodec;

public void decodeH265Video(String videoFilePath, Surface outputSurface) throws IOException {

MediaExtractor extractor = new MediaExtractor();

extractor.setDataSource(videoFilePath);

int videoTrackIndex = getVideoTrackIndex(extractor);

MediaFormat videoFormat = extractor.getTrackFormat(videoTrackIndex);

String mimeType = videoFormat.getString(MediaFormat.KEY_MIME);

mediaCodec = MediaCodec.createDecoderByType(mimeType);

mediaCodec.configure(videoFormat, outputSurface, null, 0);

mediaCodec.start();

ByteBuffer[] inputBuffers = mediaCodec.getInputBuffers();

ByteBuffer[] outputBuffers = mediaCodec.getOutputBuffers();

MediaCodec.BufferInfo bufferInfo = new MediaCodec.BufferInfo();

boolean isInputDone = false;

boolean isOutputDone = false;

while (!isOutputDone) {

if (!isInputDone) {

int inputBufferIndex = mediaCodec.dequeueInputBuffer(10000);

if (inputBufferIndex >= 0) {

ByteBuffer inputBuffer = inputBuffers[inputBufferIndex];

int sampleSize = extractor.readSampleData(inputBuffer, 0);

if (sampleSize < 0) {

mediaCodec.queueInputBuffer(inputBufferIndex, 0, 0, 0, MediaCodec.BUFFER_FLAG_END_OF_STREAM);

isInputDone = true;

} else {

long presentationTimeUs = extractor.getSampleTime();

mediaCodec.queueInputBuffer(inputBufferIndex, 0, sampleSize, presentationTimeUs, 0);

extractor.advance();

}

}

}

int outputBufferIndex = mediaCodec.dequeueOutputBuffer(bufferInfo, 1000);

if (outputBufferIndex >= 0) {

if ((bufferInfo.flags & MediaCodec.BUFFER_FLAG_END_OF_STREAM) != 0) {

isOutputDone = true;

}

ByteBuffer outputBuffer = outputBuffers[outputBufferIndex];

// 处理解码后的视频数据,例如渲染到Surface上

renderOutputBuffer(outputBuffer);

mediaCodec.releaseOutputBuffer(outputBufferIndex, true);

} else if (outputBufferIndex == MediaCodec.INFO_OUTPUT_FORMAT_CHANGED) {

MediaFormat newFormat = mediaCodec.getOutputFormat();

// 可以在这里获取新的格式信息,例如视频宽高等

}

}

mediaCodec.stop();

mediaCodec.release();

extractor.release();

}

private int getVideoTrackIndex(MediaExtractor extractor) {

for (int i = 0; i < extractor.getTrackCount(); i++) {

MediaFormat format = extractor.getTrackFormat(i);

String mimeType = format.getString(MediaFormat.KEY_MIME);

if (mimeType.startsWith("video/")) {

return i;

}

}

return -1;

}

private void renderOutputBuffer(ByteBuffer outputBuffer) {

// 将解码后的视频数据渲染到Surface上

// 这里可以使用OpenGL、SurfaceView或其它渲染方式进行处理

}

}

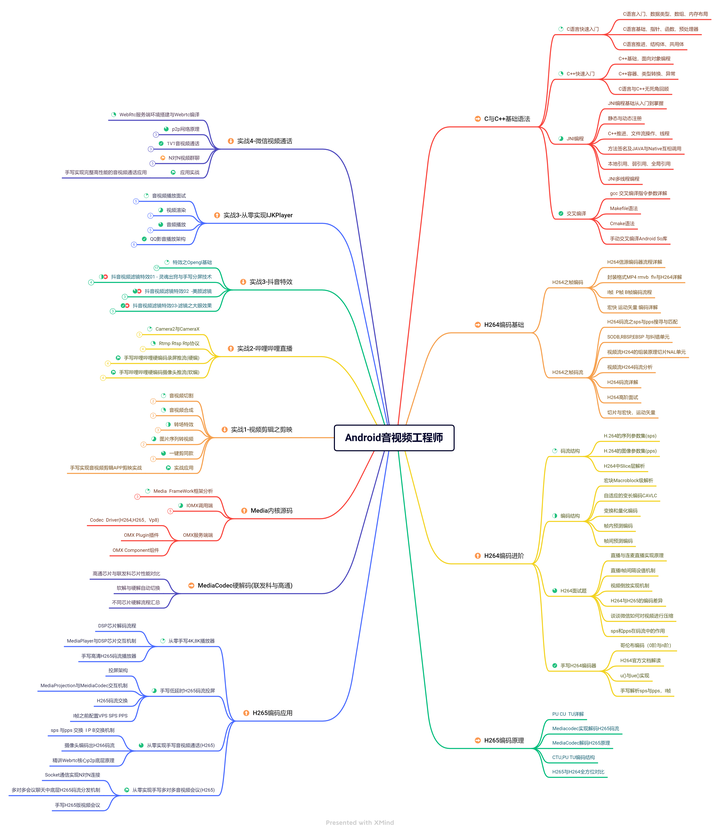

上述示例代码演示了如何使用MediaCodec解码H.265视频。您需要提供视频文件路径和一个预先创建的Surface对象,用于渲染解码后的视频。通过读取文件中的视频轨道数据,将数据传递给MediaCodec进行解码。解码后的视频数据可以通过自定义的renderOutputBuffer方法进行处理,例如渲染到Surface上。本文主要解析了有关MediaCodec解码H265原理从,众所周知在音视频开发当中需要学习的技术远远不止这么点,更多音视频开发内容可以参考《音视频入门到精通手册》点击查看详细类目。

文末

学习音视频开发,需要学习的东西非常之多。不仅技术范围广而且要深入学习。其中原因包括如下:

- 复杂性:音视频处理涉及到多个领域的知识,包括信号处理、数据编解码、网络传输、媒体容器格式等。了解这些领域的基本原理和算法对于进行音视频开发是至关重要的。

- 标准和协议:音视频开发通常需要遵循一些标准和协议,如H.264、H.265、AAC、RTP、RTSP等。掌握这些标准和协议的知识能够更好地理解和操作音视频数据。

- 平台和设备差异:音视频开发需要在不同的平台和设备上进行,如PC、移动设备、嵌入式系统等。每种平台和设备都有自己的特点和限制,需要熟悉不同平台和设备的开发环境、API和工具。

- 编码和解码:音视频开发需要涉及数据编解码的技术。理解常用的音视频编码标准和算法,如H.264、H.265、AAC等,能够有效地进行编解码优化和性能调优。

- 媒体处理和传输:音视频开发需要处理和传输媒体数据,包括音频、视频和字幕等。了解媒体流的处理、编辑、混音、转码、流媒体传输等技术对于实现各种音视频应用至关重要。

- 实时性和性能:音视频开发通常需要具备实时性和高性能。处理音视频数据需要在规定的时间内完成,且要求能够满足实时传输和处理的需求。因此,对于实时性和性能优化的技术也需要掌握。

- 用户体验:音视频是用户感知的重要组成部分,对于音视频开发来说,提供良好的用户体验是至关重要的。了解音视频质量评估、音频增强、视频渲染等技术能够提升用户的感知和满意度。