深度学习实训周报

1、Grad-CAM(Gradient-weighted Class Activation Mapping)

Grad-CAM: Visual Explanations from Deep Networks via Gradient-based Localization

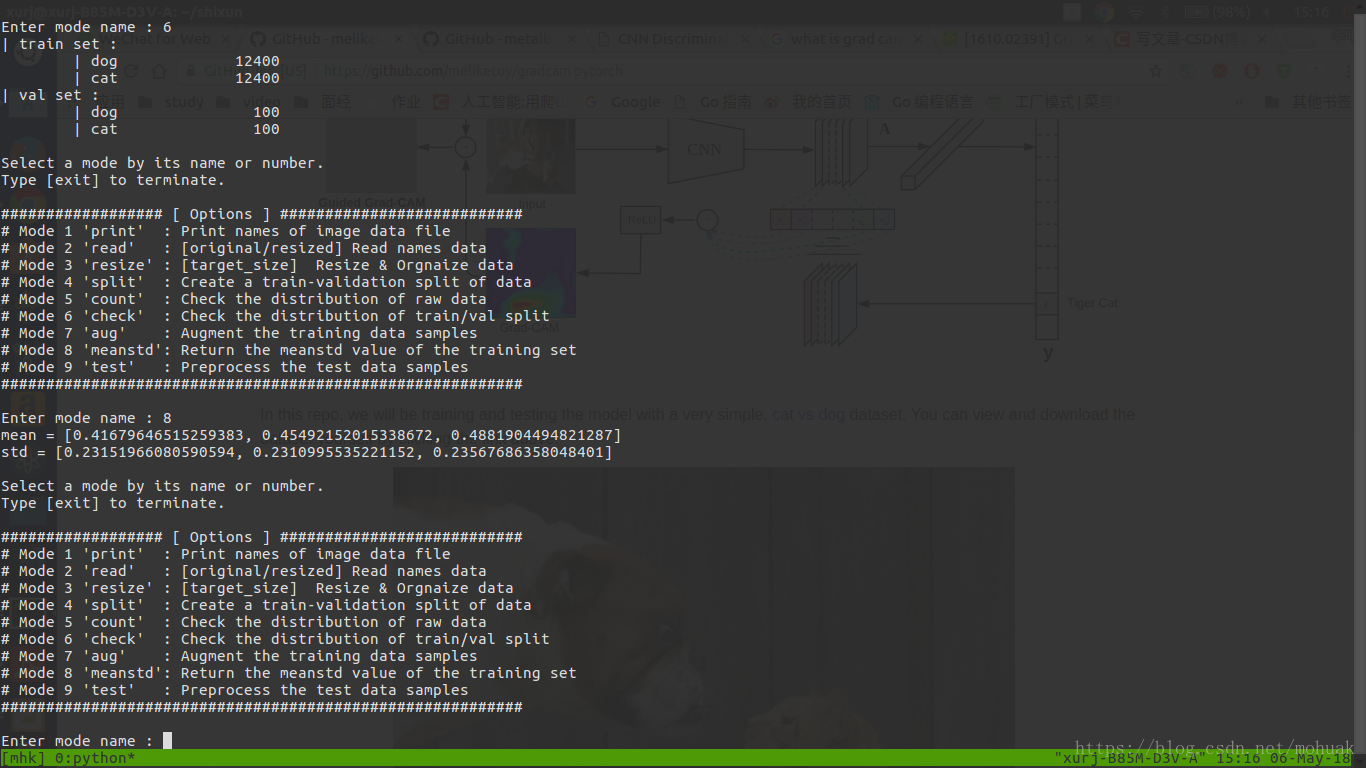

这次的任务 主要是跑代码和理解Grad CAM,通过训练和测试猫和狗的图片集,并且对这些图片进行辨别,可以分辨出哪些是猫哪些是狗。

如:

然后跑了一下Grad-CAM的代码,大概如下,然后查看照片,亦和上图一样。

还有另外一份关于Grad-CAM的github。

大致模型如下,

跑了代码之后,产生如下结果,

test.jpg

result.jpg

很清晰地划分出了人所在的部分。

2.对抗攻击和防守(Adversarial Attacks and Defenses)

初步了解

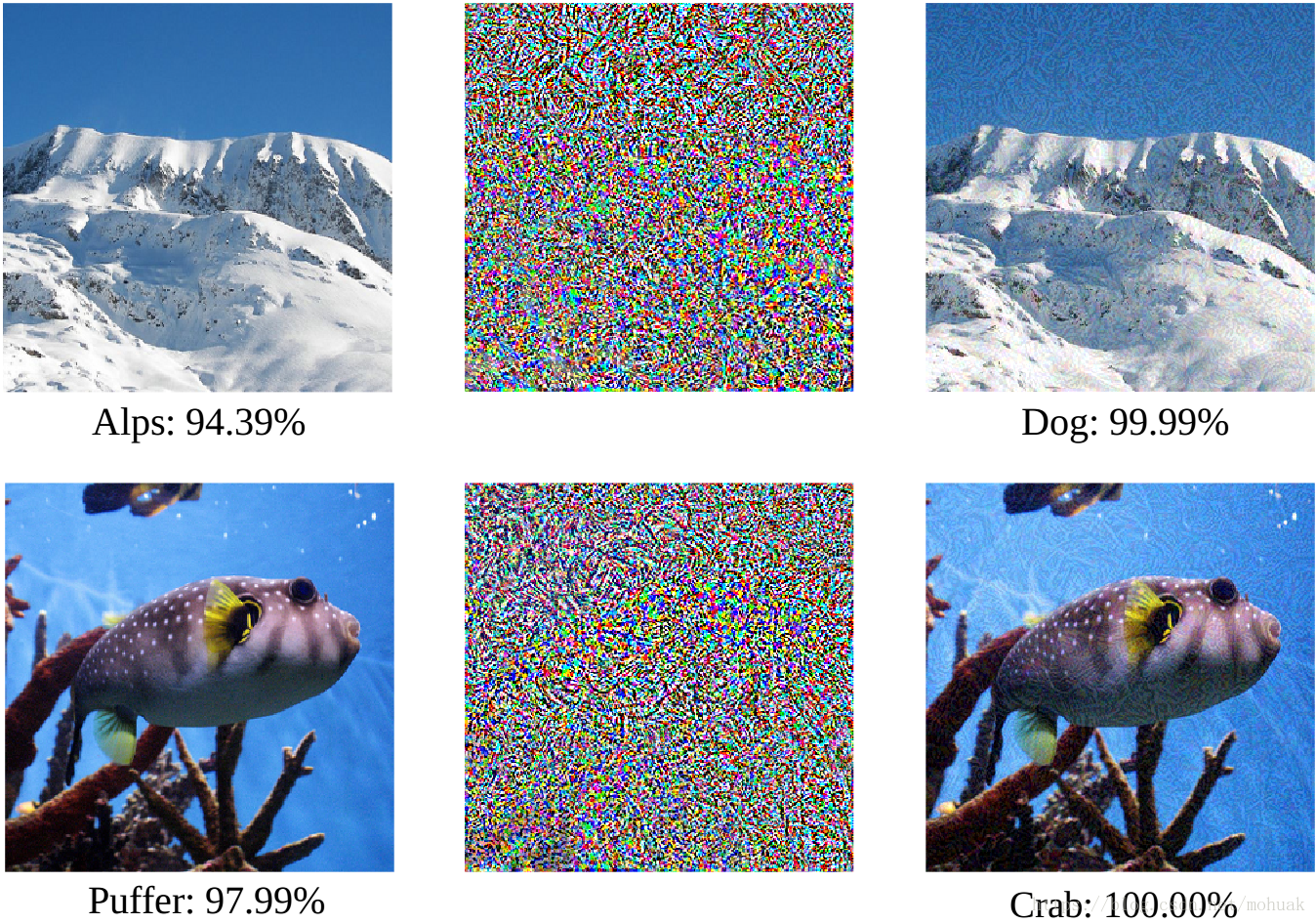

一副图片,经过识别之后,判定为Alps,但是经过一些噪点处理过后,却被判别器判定为Dog而且其精确度极高,这就是对抗攻击的一个简单的例子,同时也是对抗攻击实现的结果。

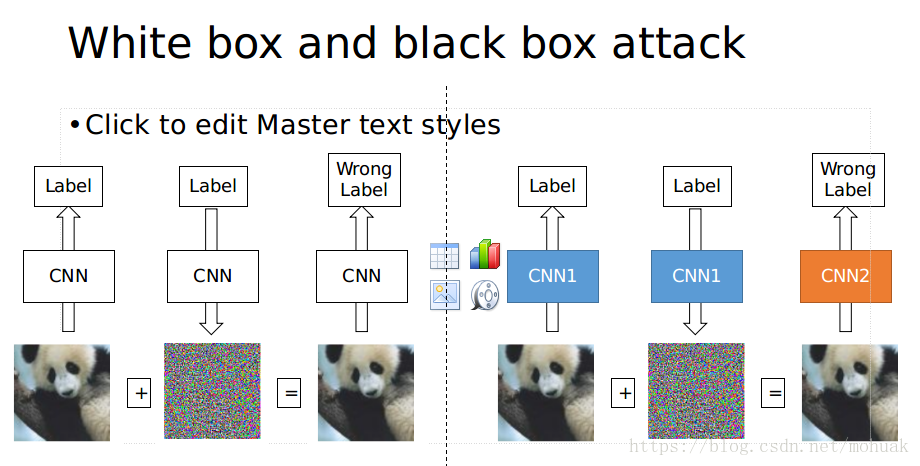

攻击方法(白盒攻击和黑盒攻击)

白盒攻击

攻击者能够获知机器学习所使用的算法,以及算法所使用的参数。攻击者在产生对抗性攻击数据的过程中能够与机器学习的系统有所交互。

黑盒攻击

攻击者并不知道机器学习所使用的算法和参数,但攻击者仍能与机器学习的系统有所交互,比如可以通过传入任意输入观察输出,判断输出。

防守方法(黑盒防守和白盒防守)

黑盒攻击防御策略:训练其他的分类器来检测对抗输入。

白盒攻击防御策略:实行对抗训练程序。

黑盒攻击防御策略不仅可以帮助防止过度拟合,让分类器的鲁棒性变强,还可以让你的模型加速收敛。但是根据最近的研究结果,这也不能消除所有对抗攻击带来的问题。而且,增加一个分类器也会大大降低分类效率,实现这两个分类器也要求你具备更多 GANs 的经验,因此这种解决方案都不是最优的。