教程参考:

https://stable-diffusion-art.com/controlnet

借助 ControlNet,Stable Diffusion 用户终于可以精确地控制对象的位置和外观!

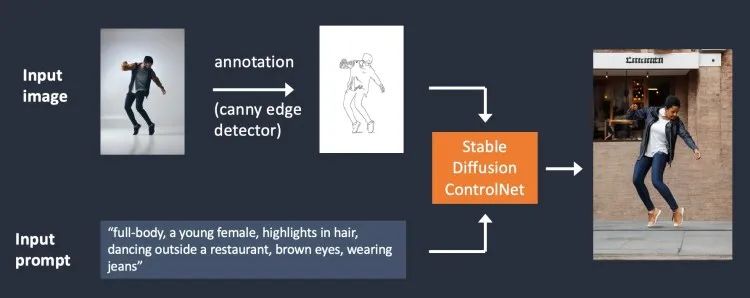

Canny边缘检测示例

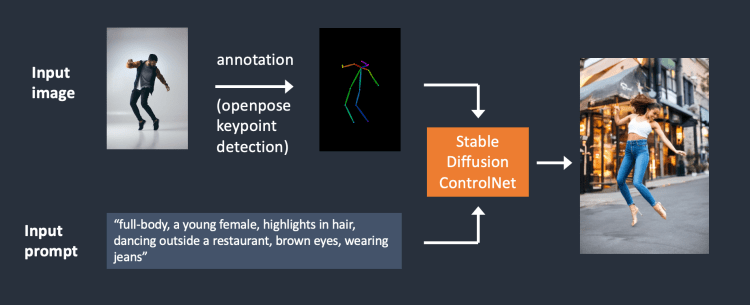

OpenPose 人体姿势检测示例

Canny 边缘检测器提取主体和背景的相似边缘。它倾向于更忠实地翻译场景。可以看到跳舞的男人变成了女人,但轮廓和发型都保留了下来。

OpenPose 只检测人体关键点,如头部、手臂等位置。图像生成更自由,但遵循原始姿势。

在AUTOMATIC1111中安装 ControlNet

https://github.com/AUTOMATIC1111/stable-diffusion-webui

https://github.com/Mikubill/sd-webui-controlnet

T2I 适配器是神经网络模型,用于为扩散模型的图像生成提供额外的控制。它们在概念上类似于 ControlNet,但设计不同。

许多 T2I 适配器的功能与 ControlNet 模型重叠。重点了解以下两个。

t2iadapter_color_sd14v1.pth

t2iadapter_style_sd14v1.pth

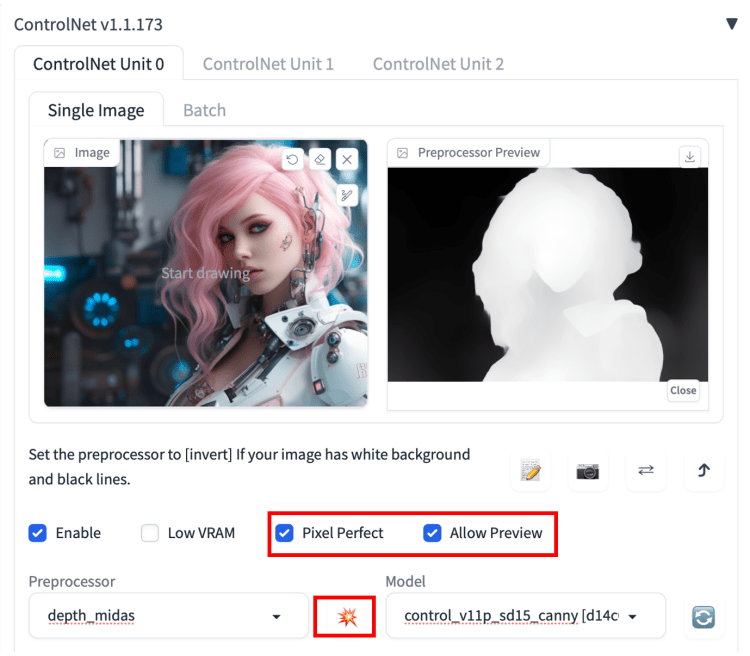

预处理器预览

1/ 选择允许预览。

2/ 或者选择Pixel Perfect。ControlNet 将使用您在文本到图像中指定的图像高度和宽度来生成预处理图像。

3/ 单击预处理器下拉菜单旁边的爆炸图标。

Reference

一组新的预处理器,可让您生成与参考图像相似的图像。图像仍会受到稳定扩散模型和提示的影响。

输入

生成结果

Clip vision 型 T2I 适配器

t2ia_style_clipvision将参考图像转换为 CLIP 视觉嵌入。此嵌入包含有关图像内容和样式的丰富信息。

输入:

输出

该功能与Reference ControlNet非常相似,但 T2IA CLIP vision 似乎效果更好。

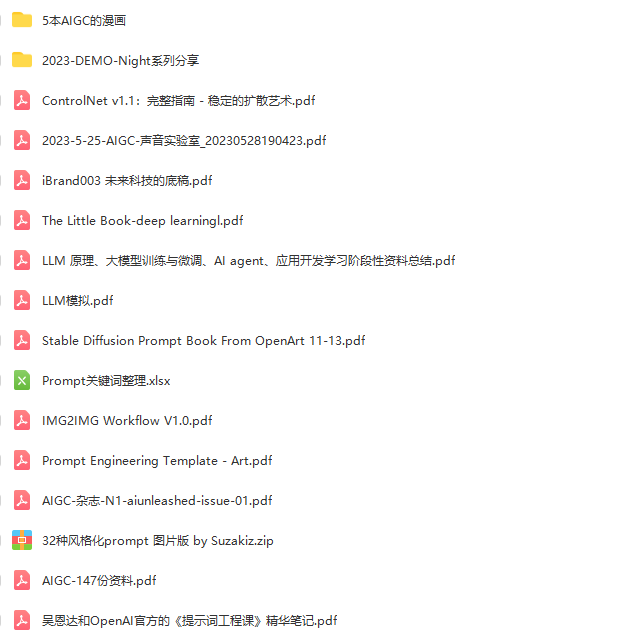

以上为精简的指南,详细的可参考原文or领取资料包

扫码备注:资料包