原创:谭婧+ChatGPT

从“古”至今,AI的世界,是一个开源引领发展的世界。

虽然Stable Diffusion作为开源的图像生成模型,将图像生成提到了全新境界,但是ChatGPT的出现,似乎动摇了一些人的信念。

因为ChatGPT是闭源的,而它又是最先进的。

开源拥趸仰天长啸:

什么时候开源大模型(LLM)赶上ChatGPT?

这时,一个脑洞超大的高校研究团队用一篇学术论文严肃回答了相关问题:

“模仿ChatGPT大模型,到底行不行?”

2023 年 5 月 25 日,美国加州大学伯克利分校的研究团队在国际开源论文网站arxiv提交了一篇学术论文。

论文题目为《The False Promise of Imitating Proprietary LLMs》。

我的翻译是《模仿语言大模型,谁为空头支票负责》。

本文中的英文单词imitating翻译为模仿,在这里是用小模型去学习ChatGPT的输出。不能翻译为“仿制”。

他们先提问:

开源LLMs大模型目前能力比不过闭源的,怎么办?

其次,拿出行动思路:

在最新的研究中,研究团队试图通过让开源语言模型模仿闭源语言模型(比如,ChatGPT),来提高开源大模型的能力。

于是,描述观察:

初步的结果看上去很好,模仿大模型在某些方面的能力与ChatGPT相当。然而,经过深入地分析发现,这些“模仿者”只模仿到表面,缺乏核心的能力。

第四,结论如下:

最有效的方式是,直面ChatGPT的挑战,从根本上提升开源模型的能力,而非简单地模仿。

历史反复证明,学术论文又证明,科研没有近路可抄,唯有脚踏实地,埋头苦干。

论文讲完啦。

谭老师我秉持“AI只会淘汰不会使用AI的人”的理念,公布一下本文幕后学术顾问是ChatGPT。

我和它简单对话,它给予了我极大的,有偿的AI学术支持,我内心那叫一个感谢:

首先,Ctrl+C。

把论文《The False Promise of Imitating Proprietary LLMs》的摘要一键粘贴。

其次,让它翻译。

“一种新兴的方法可以廉价地改进较弱的语言模型,那就是在更强大的模型的输出上进行微调。这种方法旨在使用较弱的开源模型廉价地模仿专有模型的能力。在这项工作中,我们对这种方法进行了严谨的分析。

“我们首先微调了一系列模仿ChatGPT的语言模型,这些模型有不同的基础模型大小(15亿--130亿),数据来源,以及模仿数据量(0.3M--150M tokens)。然后,我们使用群众评估者和权威的NLP基准对模型进行评估。”

“最初,我们对模仿模型的输出质量感到惊讶--它们在遵循指令上似乎更加出色,群众工人将它们的输出评价为可以与ChatGPT竞争。然而,当进行更有针对性的自动评估时,我们发现在模仿数据不大的任务上,模仿模型几乎没有缩小基础语言模型与ChatGPT的差距。

“我们证明,这些性能差异可能会被人类评估者忽视,因为模仿模型擅长模仿ChatGPT的风格,但不是其事实性。总的来说,我们得出的结论是,模型模仿是一种虚假的承诺:存在着开源和闭源语言模型之间的显著能力差距,目前的方法只能通过使用大量的模仿数据或更有能力的基础语言模型来弥补。因此,我们认为,提高开源模型的最高杠杆行动是面对开发更好的基础语言模型的困难挑战,而不是采取模仿专有系统的捷径。”

学术人与普通人的悲喜并不相通,我只觉得啰嗦,作为一名尊贵的付费用户,我放下矜持,直白地说:

“可以把上面的这段学术性的文字讲得更加通俗易懂一些,做为一个公众号可以发表的那种水平吗?”

ChatGPT回答我:

在新的研究方法中,人们发现一种用更小的投资提高语言模型质量的方法。简单说,就是把较弱的语言模型,如开源的,让它学习较强的语言模型的输出,例如ChatGPT。这就好比让开源模型成为专有模型的“影子”,模仿它的行为。

我们对这种方法进行了深入的研究。我们试了一系列的模型,让它们模仿ChatGPT。这些模型有各种各样的大小,来源和模仿数据的数量。

然后我们通过众包和NLP的基准测试,对这些模型进行了评价。

一开始,我们对模仿模型的结果感到惊奇。它们更好地遵循了指令,就像是ChatGPT的克隆版。

然而,当我们用更严格的测试方法,我们发现,在模仿数据不够多的任务上,这些模仿模型并没有达到ChatGPT的效果。

我们发现,这种差距是因为模仿模型只是模仿了ChatGPT的外表,而没有模仿到它的核心。就像人类,我们能模仿一个人的动作和声音,但不能模仿他的思维。

因此,我们认为,只依赖模仿是没有用的。开源和专有的语言模型之间有明显的能力差距,我们不能只通过大量的模仿数据或者更大的基础模型来弥补这个差距。

我们认为,最好的方法是面对挑战,开发更好的基础模型,而不是走捷径,只模仿专有的系统。

是时候让ChatGPT知道什么叫做不厌其烦了。

于是,我说:

请再进一步缩短一下,缩短到3-4句话的样子?

ChatGPT回答:

在最新的研究中,我们试图通过让开源语言模型模仿专有模型(例如ChatGPT)来提高其能力。

初步结果看上去很好,仿制模型在某些方面与ChatGPT相当。

但深入分析发现,这些模仿模型只模仿到了表面,缺乏核心能力。因此,我们认为最有效的方式是直面挑战,从根本上提升开源模型能力,而非简单地模仿。

人工智能很酷,而我觉得自己一点都不酷,日后若是都这样写稿了,扪心自问,我的价值在哪?

好吧,是时候展示真正的技术了(体现我的价值了)。

我分别与美国硅谷、国内某厂的两位顶尖AI科学家聊完之后,了解到这样一些情况。

我国国内也有大模型研发团队采用模仿的方法造大模型,也就是这篇学术论文中所谈到的“模仿”。

具体方法包括,以开源的GPT作为基础模型,也就是以此为基础构架,然后疯狂问ChatGPT提问,以此输出的数据,再输入国产大模型。

在攀登“人类最高智能软件产品”的艰难道路上,这样做到底行不行?

大模型正处在研究前沿的风暴中,学术观点交锋激烈。

美国加州大学伯克利分校作为人工智能研究的前沿阵地,同一所大学,两支不同的研究团队所持观点截然相反。

如前文所示,《The False Promise of Imitating Proprietary LLMs》这篇论文团队不认可这种方法。

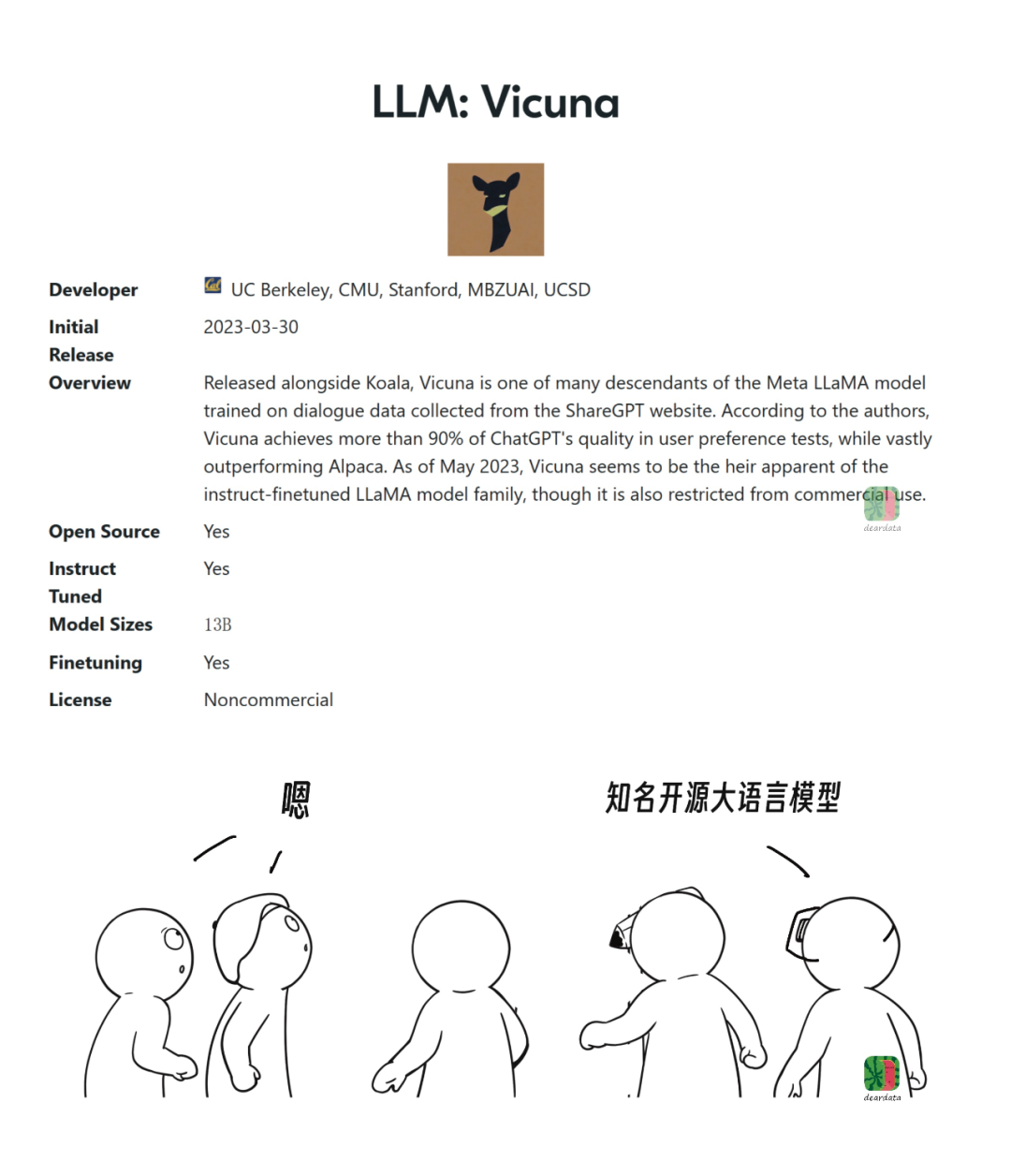

而另一支团队,也就是知名开源大模型小羊驼(Vicuna)背后的研究团队却认可这种方法。

虽然这一学术争论的“战火”虽然还没有燃烧到国内,但是双方分歧已经非常清晰了。

“模仿”就是投机取巧?

不,这是一个学术争论,不能草率下结论。

解疑释结,尚需时日。

-结束-

更多阅读

AI框架系列:

3.搞 AI 框架那帮人(三):狂热的 AlphaFold 和沉默的中国科学家

4.搞 AI 框架那帮人(四):AI 框架前传,大数据系统往事

注:(三)和(四)现在并未公开发表,将会以图书出版的形式与各位见面。

漫画系列

4. AI for Science这事,到底“科学不科学”?

5. 想帮数学家,AI算老几?

11. 强化学习:人工智能下象棋,走一步,能看几步?

14. 云计算Serverless:一支穿云箭,千军万马来相见

15. 数据中心网络:数据还有5纳秒抵达战场

16. 迟到不可怕,可怕的是别人都没迟到, 数据中心网络“卷”AI:

AI大模型与ChatGPT系列:

18. ChatGPT大火,如何成立一家AIGC公司,然后搞钱?

19. ChatGPT:绝不欺负文科生

21. 独家丨从大神Alex Smola与李沐离职AWS创业融资顺利,回看ChatGPT大模型时代“底层武器”演进

22. 独家丨前美团联合创始人王慧文“正在收购”国产AI框架OneFlow,光年之外欲添新大将

24. 大模型“云上经济”之权力游戏

25. 深聊丨第四范式陈雨强:如何用AI大模型打开万亿规模传统软件市场?

26. 云从科技从容大模型:大模型和AI平台什么关系?为什么造行业大模型?

27. 深聊何晓东:一场九年前的“出发”:奠基多模态,逐鹿大模型

最后,再介绍一下主编自己吧,

我是谭婧,科技和科普题材作者。

为了在时代中发现故事,

我围追科技大神,堵截科技公司。

偶尔写小说,画漫画。

生命短暂,不走捷径。

原创不易,多谢转发

还想看我的文章,就关注“亲爱的数据”