文章目录

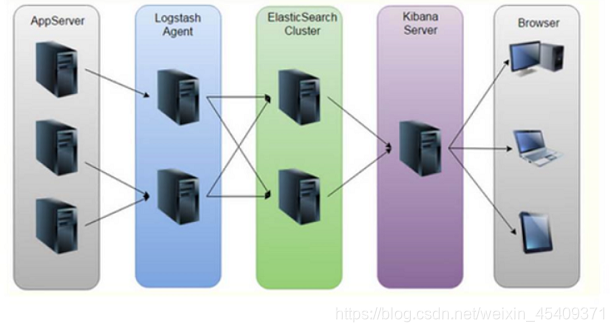

一、ELK 日志分析系统简介:

日志服务器:

- 提高安全性;

- 集中存放日志;

- 缺陷:对日志的分析困难

ELK日志处理步骤:

- 将日志进行集中格式化;

- 将日志格式化(logstash)并输出到 Elasticsearch;

- 对格式化后的数据进行索引和存储(Elasticsearch);

- 前端数据的展示(Kibana)

ELK:Elasticsearch + Logstash + Kibana

ELK是Elasticsearch、Logstash、Kibana的简称,这三者是核心套件,但并非全部。

(1)Elasticsearch 是实时全文搜索和分析引擎,提供搜集、分析、存储数据三大功能;是一套开放REST和JAVA API等结构提供高效搜索功能,可扩展的分布式系统。它构建于Apache Lucene搜索引擎库之上。

(2)Logstash 是一个用来搜集、分析、过滤日志的工具。它支持几乎任何类型的日志,包括系统日志、错误日志和自定义应用程序日志。它可以从许多来源接收日志,这些来源包括 syslog、消息传递(例如 RabbitMQ)和JMX,它能够以多种方式输出数据,包括电子邮件、websockets和Elasticsearch。

(3)Kibana 是一个基于Web的图形界面,用于搜索、分析和可视化存储在 Elasticsearch指标中的日志数据。它利用Elasticsearch的REST接口来检索数据,不仅允许用户创建他们自己的数据的定制仪表板视图,还允许他们以特殊的方式查询和过滤数据。

功能:

- Elasticsearch无缝之集成;

- 整合数据,复杂数据分析;

- 接口灵活,分享更容易;

- 配置简单,可视化多数据源;

- 简单数据导出;

- 让更多团队成员收益。

二、搭建 ELK 日志分析系统:

| 角色 | 主要软件 |

|---|---|

| node1(192.168.220.136) | Elasticsearch、Kibana |

| node2(192.168.220.137) | Elasticsearch、Kibana |

| Apache (192.168.220.135) | Logstash |

第一步:先配置 elasticsearch 环境

(1)修改两台主机名,分别是:node1 和 node2

(2)修改 hosts 文件:

vim /etc/hosts

添加以下主机名和主机IP地址(两台node都需要):

192.168.220.129 node1

192.168.220.130 node2

(3)防火墙都关闭

systemctl stop firewalld.service

setenforce 0

第二步:部署安装 elasticsearch 软件(两台节点都需要)

(1)安装:

rpm -ivh elasticsearch-5.5.0.rpm //安装

systemctl daemon-reload //重新加载服务配置文件

systemctl enable elasticsearch.service //设置为开机自启动

cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

(2)修改配合文件:

注意:第二台节点服务器配置和第一台一样,注意修改一下节点名和ip地址即可。

vim /etc/elasticsearch/elasticsearch.yml

cluster.name: my-elk-cluster //集群名字(自定义)

node.name: node-1 //节点名字

path.data: /data/elk_data //数据存放路径

path.logs: /var/log/elasticsearch/ //日志存放路径

bootstrap.memory_lock: false //不在启动的时候锁定内存

network.host: 192.168.220.136 //提供服务绑定的IP地址(本机地址)

http.port: 9200 //端口

discovery.zen.ping.unicast.hosts: ["node1", "node2"] //集群发现通过单播实现

(3)创建数据存放路径并授权:

mkdir -p /data/elk_data

chown elasticsearch:elasticsearch /data/elk_data/

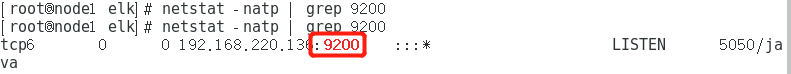

(4)开启服务:

systemctl start elasticsearch.service

netstat -natp | grep 9200

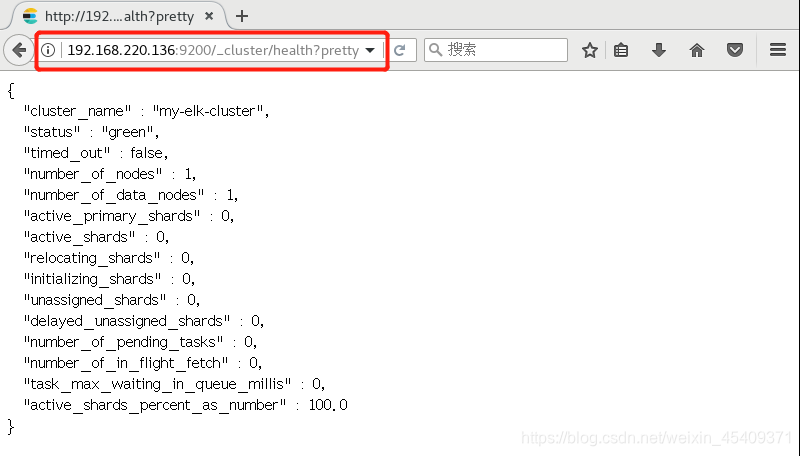

1、浏览器输入以下网址,检查群集健康状态:

http://192.168.220.136:9200/_cluster/health?pretty

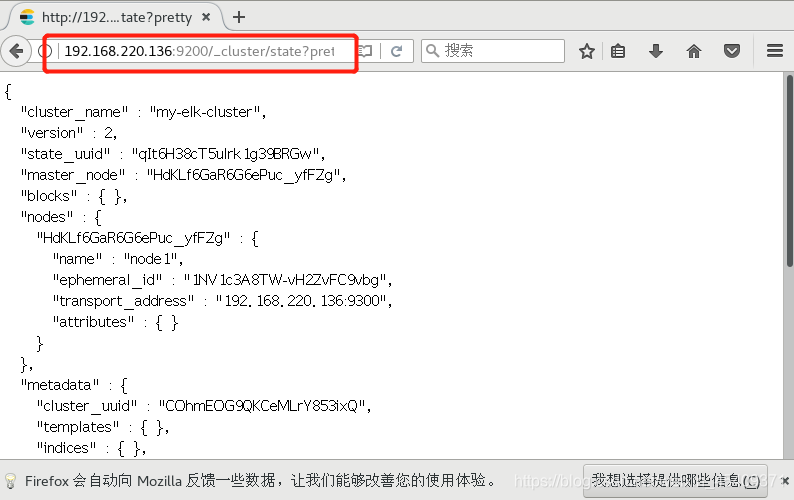

2、检查群集状态信息:

http://192.168.220.136:9200/_cluster/state?pretty

第三步:安装 elasticsearch-head 插件

(1)安装依赖包:

yum install gcc gcc-c++ make -y

(2)编译安装 node 组件:

tar zvxf node-v8.2.1.tar.gz -C /opt/

cd /opt/node-v8.2.1/

./configure

make -j3 //这步耗时较长,耐心等待

make install

(3)安装 phantomjs 前端框架:

tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2 -C /opt/

cd phantomjs-2.1.1-linux-x86_64/bin

cp phantomjs /usr/local/bin/

(4)安装 elasticsearch-head 数据可视化工具:

tar zvxf elasticsearch-head.tar.gz -C /opt/

cd /opt/elasticsearch-head/

npm install

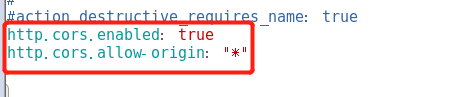

(5)修改主配置文件:

vim /etc/elasticsearch/elasticsearch.yml

末尾插入以下两行代码:

http.cors.enabled: true

http.cors.allow-origin: "*"

(6)启动 elasticsearch-head

cd /opt/elasticsearch-head/

npm run start & //放在后台运行

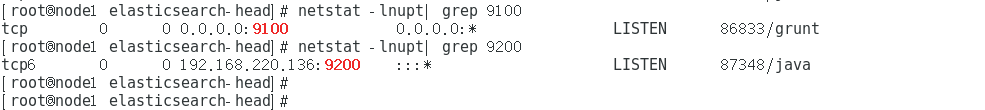

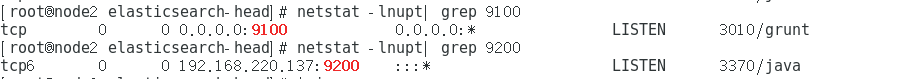

此时,可以检查一下 9100和9200 这个两个端口的状态:

netstat -lnupt |grep 9100

netstat -lnupt |grep 9200

node1:

node2:

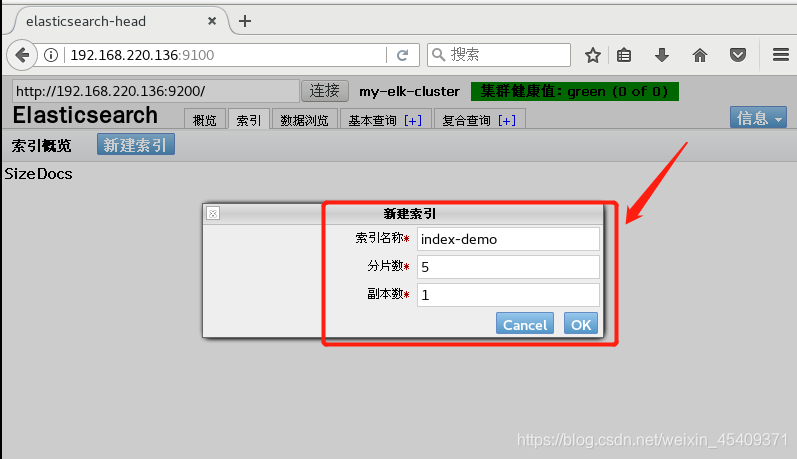

第四步:创建索引

可以直接新建索引:

也可以输入以下命令创建索引:

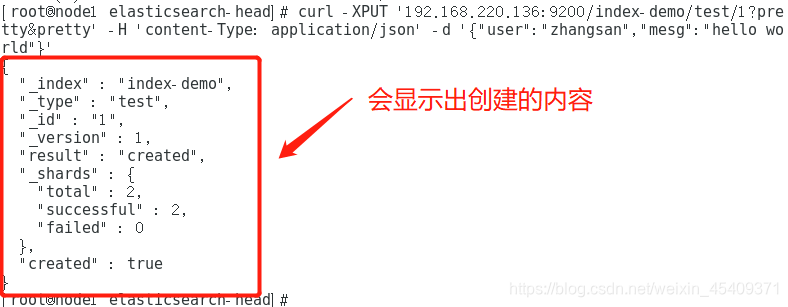

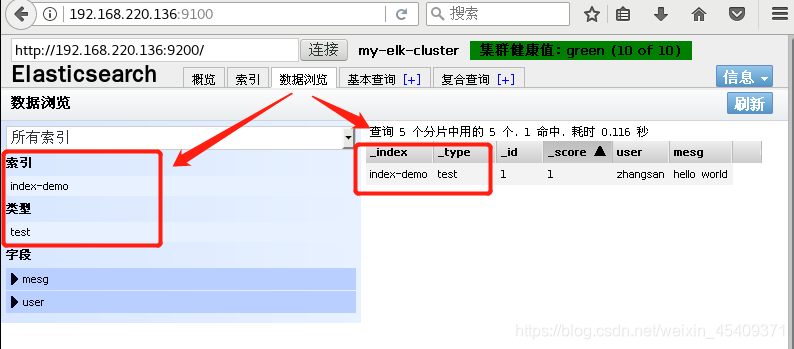

curl -XPUT '192.168.220.136:9200/index-demo/test/1?pretty&pretty' -H 'content-Type: application/json' -d '{"user":"zhangsan","mesg":"hello world"}'

//索引名为 index-demo,类型为test

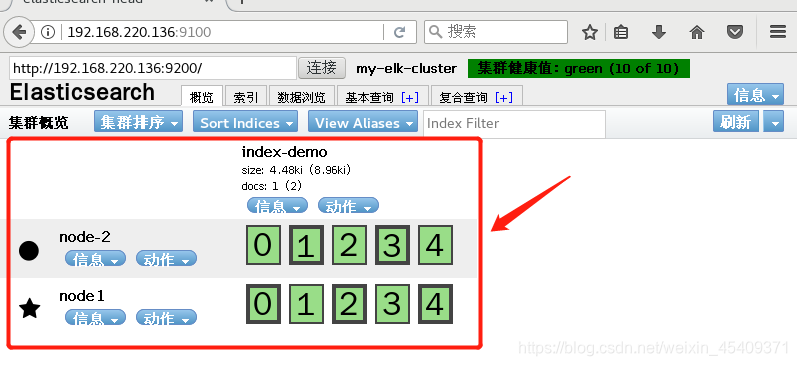

浏览器刷新一下,就会看到刚刚创建的索引信息,可以看出索引默认被分片5个,并且有一个副本。

第五步:安装 logstash 并做一些日志搜集输出到 elasticsearch中

(1)修改主机名

hostname apache

(2)安装Apache服务:

systemctl stop firewalld.service

setenforce 0

yum install httpd -y

systemctl start httpd.service

(3)安装 logstash

rpm -ivh logstash-5.5.1.rpm

systemctl start logstash

systemctl enable logstash

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/ //创建软连接到bin目录下

(4)logstash(Apache)与 elasticsearch(node)功能是否正常,做对接测试:

- 可以用 logstash 这个命令测试:

[root@apache bin]# logstash

-f:可以指定 logstash的配置文件,根据配置文件配置 logstash

-e:后面跟着字符串,该字符串可以被当做 logstash 的配置(如果是“”,则默认使用stdin作为输入、stdout作为输出)

-t:测试配置文件是否正确,然后退出

(5)输入采用标准输入、输出采用标准输出:

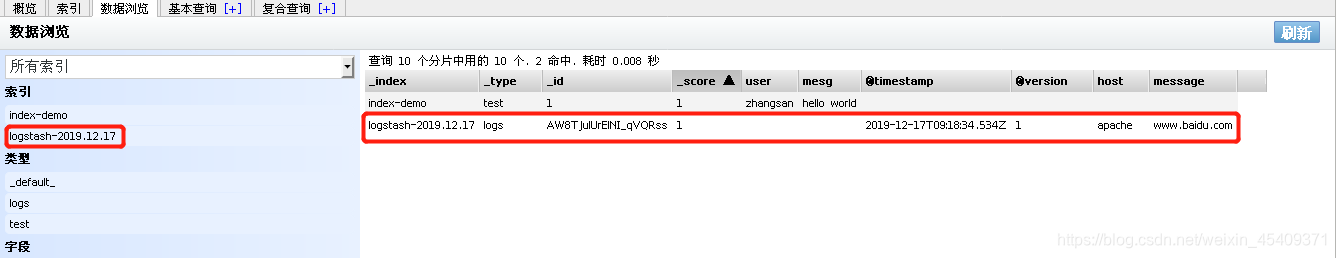

logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["192.168.220.136:9200"] } }'

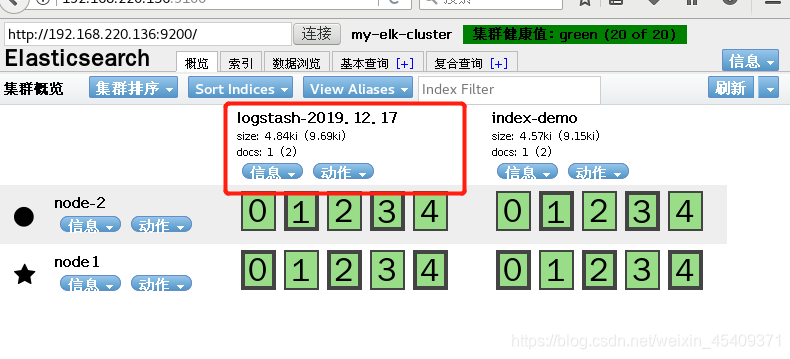

此时,浏览器访问 http://192.168.220.136:9200/ 查看索引信息,就会多出 logstash-2019.12.17

(6)登录Apache主机,做对接配置:

- logstash 配置文件主要由三部分组成:input、output、filter(这个视情况做不做)

给日志文件授权:

chmod o+r /var/log/messages

创建并编辑配置文件:

vim /etc/logstash/conf.d/system.conf

input {

file{

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

}

output {

elasticsearch {

hosts => ["192.168.220.136:9200"]

index => "system-%{+YYYY.MM.dd}"

}

}

重启服务:

systemctl restart logstash.service

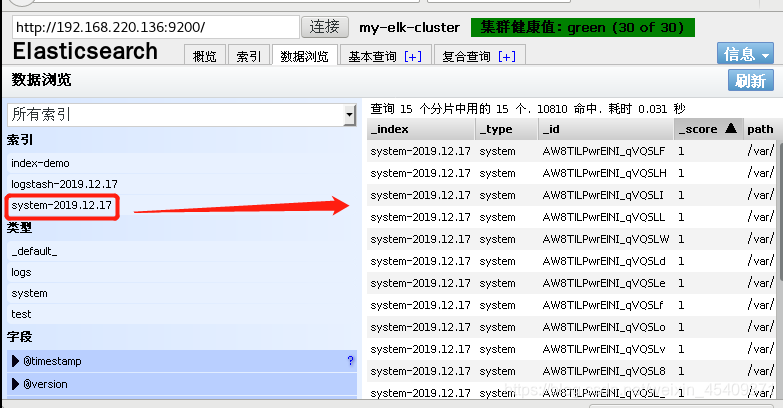

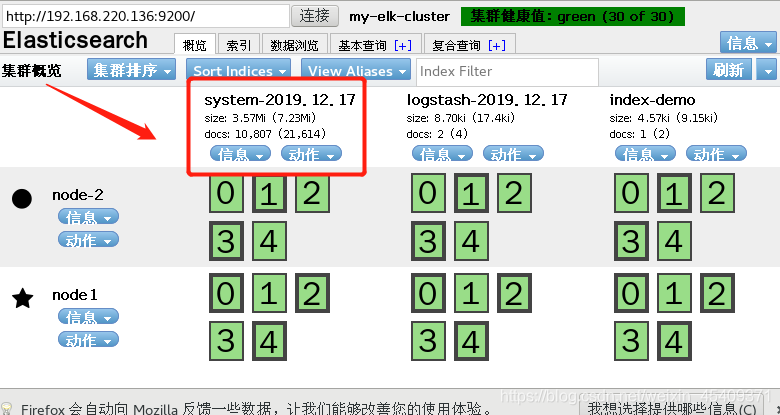

(7)浏览器查看索引信息:会多出 system-2019.12.17

第六步:node1主机安装 kibana

rpm -ivh kibana-5.5.1-x86_64.rpm

cd /etc/kibana/

cp kibana.yml kibana.yml.bak

vim kibana.yml

修改,开放以下功能:

server.port: 5601 //开发端口

server.host: "0.0.0.0" //监听所有

elasticsearch.url: "http://192.168.220.136:9200"

kibana.index: ".kibana"

重启服务:

systemctl start kibana.service

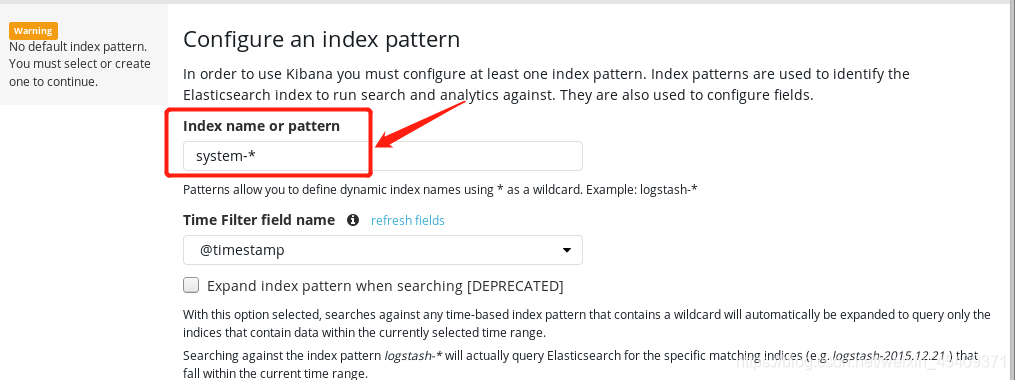

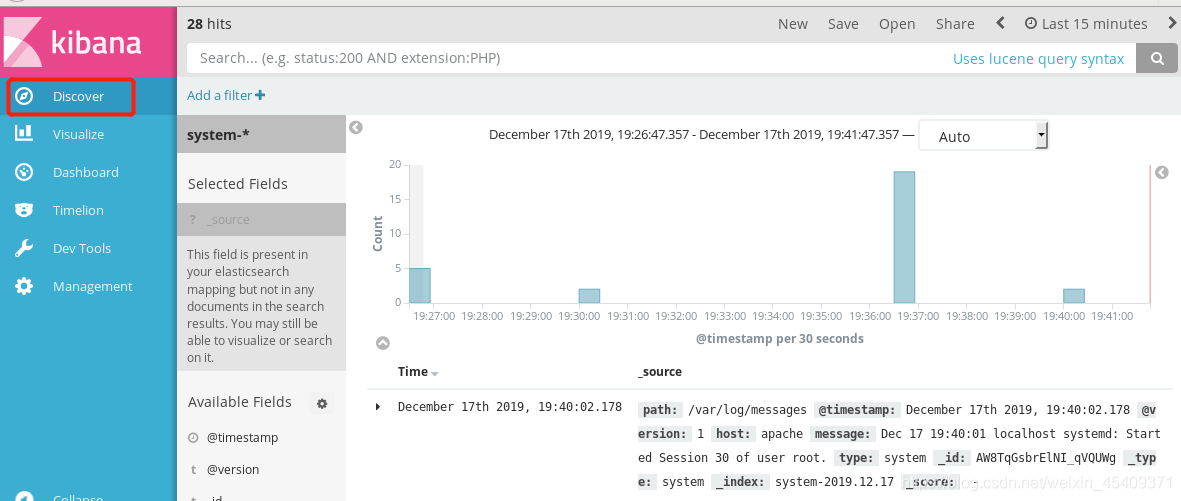

(1)

浏览器访问:192.168.220.136:5601

接下来在可视化界面中创建一个索引名:system-* (对接系统日志文件)

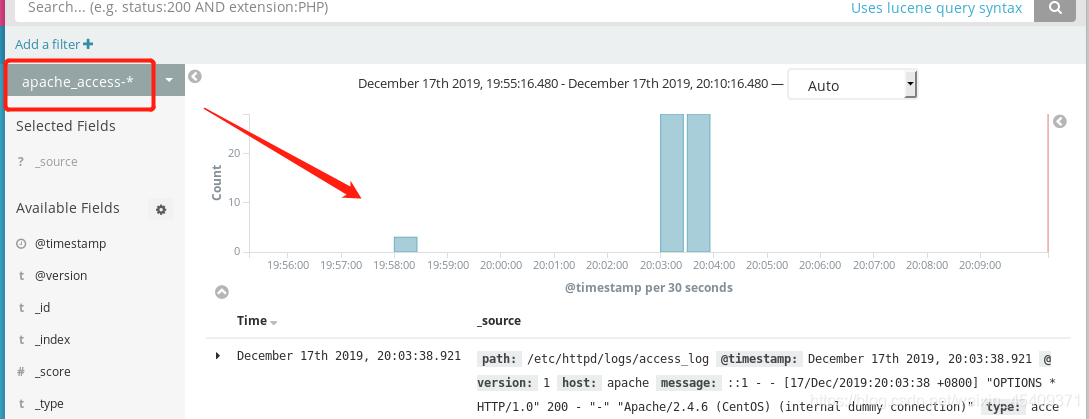

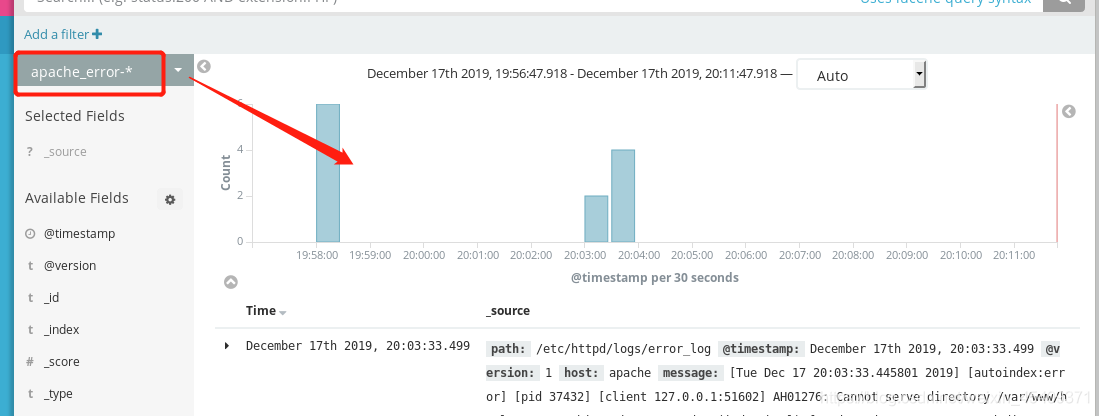

(2)对接 Apache 主机的 Apache 日志文件 (包括正常访问的、错误的)

cd /etc/logstash/conf.d/

vim apache_log.conf //创建配置文件,添加以下代码:

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.220.136:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error"{

elasticsearch {

hosts => ["192.168.220.136:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

重启服务:

/usr/share/logstash/bin/logstash -f apache_log.conf

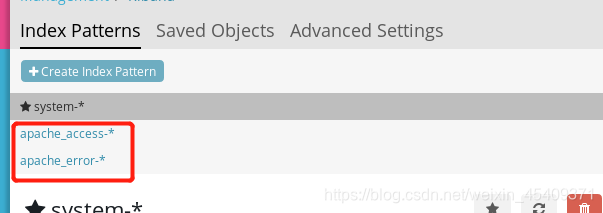

再在可视化界面上, 创建两个索引:

1、apache_access-*

2、apache_error-*

稍等片刻,就可以在Discover 看见这两个日志文件了:

由于,我们之前给node节点都做了同步备份,同时也提高了容灾的能力,一台宕机不会造成数据的丢失。