自成立以来的短时间内,ChatGPT 和其他生成式 AI 平台理所当然地赢得了终极生产力助推器的声誉。 然而,能够按需快速生成高质量文本的技术,可能同时暴露敏感的公司数据。 最近发生的一起事件,三星软件工程师将专有代码粘贴到 ChatGPT 中,清楚地表明该工具很容易成为潜在的数据泄露渠道。 此漏洞给安全利益相关者带来了严峻的挑战,因为现有的数据保护工具都无法确保敏感数据不会暴露给 ChatGPT。 在本文中,我们将详细探讨这一安全挑战,并展示浏览器安全解决方案如何提供解决方案。 同时使组织能够充分发挥 ChatGPT 的生产力潜力,而不必牺牲数据安全性。

ChatGPT 数据保护盲点:如何管理浏览器中的文本插入?

每当员工将文本粘贴或键入到 ChatGPT 中时,该文本就不再受公司数据保护工具和政策的控制。 文本是从传统数据文件、在线文档还是其他来源复制的并不重要。 事实上,这就是问题所在。 数据泄漏防护 (DLP) 解决方案——从本地代理到 CASB——都是面向文件的。 他们根据文件的内容对文件应用策略,同时防止修改、下载、共享等操作。 但是,此功能对于 ChatGPT 数据保护用处不大。 ChatGPT 中没有涉及任何文件。 相反,使用涉及粘贴复制的文本片段或直接键入网页,这超出了任何现有 DLP 产品的治理和控制范围。

浏览器安全解决方案如何防止 ChatGPT 中不安全的数据使用

LayerX 推出了其浏览器安全平台,用于对浏览器会话进行持续监控、风险分析和实时保护。 LayerX 作为浏览器扩展提供,对会话中发生的每个事件具有精细的可见性。 这使 LayerX 能够检测风险行为并配置策略以防止发生预定义的操作。

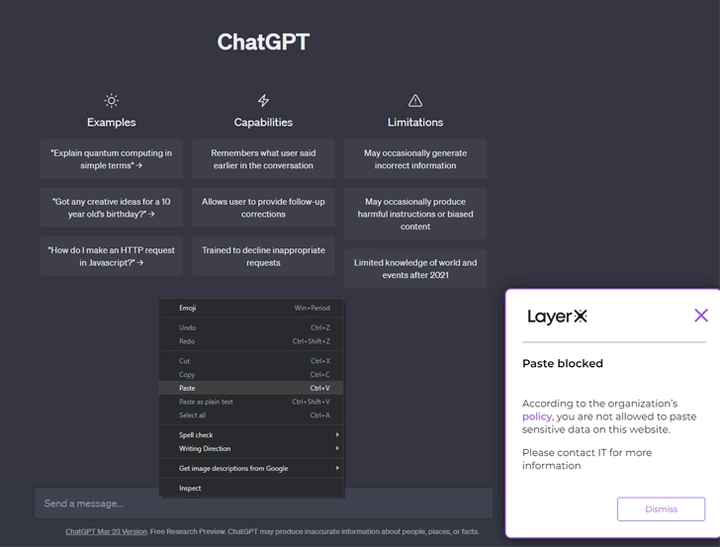

在保护敏感数据不被上传到 ChatGPT 的上下文中,LayerX 利用这种可见性在 ChatGPT 选项卡中挑出尝试的文本插入事件,例如“粘贴”和“类型”。 如果“粘贴”事件中的文本内容违反了公司数据保护政策,LayerX 将完全阻止该操作。

为了启用此功能,使用 LayerX 的安全团队应该定义他们想要防止暴露的短语或正则表达式。 然后,他们需要创建一个 LayerX 策略,只要与这些字符串匹配就会触发该策略。

看看实际效果如何:

在 LayerX 仪表板中设置策略

试图将敏感信息复制到 ChatGPT 的用户被 LayerX 阻止

此外,希望完全阻止其员工使用 ChatGPT 的组织可以使用 LayerX 来阻止访问 ChatGPT 网站或任何其他基于 AI 的在线文本生成器,包括类似 ChatGPT 的浏览器扩展。

在此处了解有关 LayerX ChatGPT 数据保护的更多信息。

使用 LayerX 的浏览器安全平台获得全面的 SaaS 保护#

使 LayerX 成为唯一能够有效解决 ChatGPT 数据保护差距的解决方案的不同之处在于,它放置在浏览器本身中,在实际浏览器会话中具有实时可见性和策略执行。 这种方法还使其成为保护免受任何以浏览器中的数据或用户活动为目标的网络威胁的理想解决方案,就像 SaaS 应用程序一样。

用户通过浏览器与 SaaS 应用程序交互。 这使得 LayerX 可以轻松保护这些应用程序中的数据以及应用程序本身。 这是通过在整个网络会话中对用户活动实施以下类型的策略来实现的:

数据保护策略:在标准的面向文件的保护(防止复制/共享/下载等)之上,LayerX 提供与 ChatGPT 相同的细粒度保护。 事实上,一旦组织定义了禁止粘贴的输入,就可以扩展相同的策略以防止将此数据暴露给任何 Web 或 SaaS 位置。

帐户泄露缓解措施:LayerX 监控每个用户在组织的 SaaS 应用程序上的活动。 该平台将检测任何表明用户帐户被盗用的异常行为或数据交互。 然后,LayerX 策略将触发会话终止或禁用应用程序中用户的任何数据交互能力。