点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

萧箫 发自 凹非寺

转载自:量子位(QbitAI)

图灵奖得主Bengio和Hinton,同时警告AI可能灭绝人类!

就在昨夜,一封签署名单多达350人的公开信迅速传播开去,信中核心只有一句话:

“降低AI灭绝人类的风险”,应该像流行病和核战争等其它社会规模的风险一样,成为全球的优先事项。

签署这封公开信的,既包括三大AI巨头的CEO,即ChatGPT老板、OpenAI的Sam Altman,DeepMind的Demis Hassabis和Anthropic的Dario Amodei;

也包括不少国内外高校的教授,除了Yoshua Bengio和Geoffrey Hinton以外,清华AIR院长张亚勤和斯坦福教授、图灵奖得主Martin Hellman等人也名列其中。

这段时间来,关于AI风险的各种大小讨论也是接连不断,OpenAI CEO Sam Altman前段时间还倡议称,人们应当像对待核设施一样监管AI。

所以,究竟是谁发起的这封公开信倡议,又是否有AI大牛反对这件事?

为何签署这封信?

发布这封公开信的机构名叫Center for AI Safety(CAIS),是一家关于AI安全的非营利组织。

在这封公开信的开头,CAIS反复强调:

包括AI专家、记者、政策制定者和公众在内,越来越多的人开始讨论AI带来的一系列重要和紧迫的风险。

即便如此,要想表达对先进AI的严重风险,可能还是有一定难度。这封公开信旨在克服这一障碍,并展开对相关议题的讨论,让更多专家和公众人物认识到这一点。

事实上,已经有不少签署了这封信的AI大牛,最近发了关于AI风险的博客文章、或是在访谈中谈到了自己的观点。

例如前段时间,Yoshua Bengio就写了一封长信,警告称“人类大脑是生物机器,一定会有超级智能AI超越它”。

除此之外,包括Stability AI的创始人Emad Mostaque、以及剑桥大学助理教授David Krueger等人,也都在最近的访谈中提到了关于AI带来的潜在危害。

例如,Emad Mostaque认为,10年后包括Stability AI、OpenAI和DeepMind在内,这些AI公司的规模甚至会超过谷歌和Facebook。

也正是因此,AI风险是一个必须要考虑的事情:

我们可能正处于全面变革的风口浪尖,这些变革对于任何一家公司或是国家来说都太过庞大,以至于难以管理。

没签的AI大牛怎么说?

当然,这波闹得沸沸扬扬的“请求AI监管”浪潮下,也有不少反对的声音。

目前为止,包括另一位图灵奖得主Yann LeCun、前特斯拉AI总监Andrej Karpathy还有吴恩达等AI大牛在内,都还没签署这封联名信。

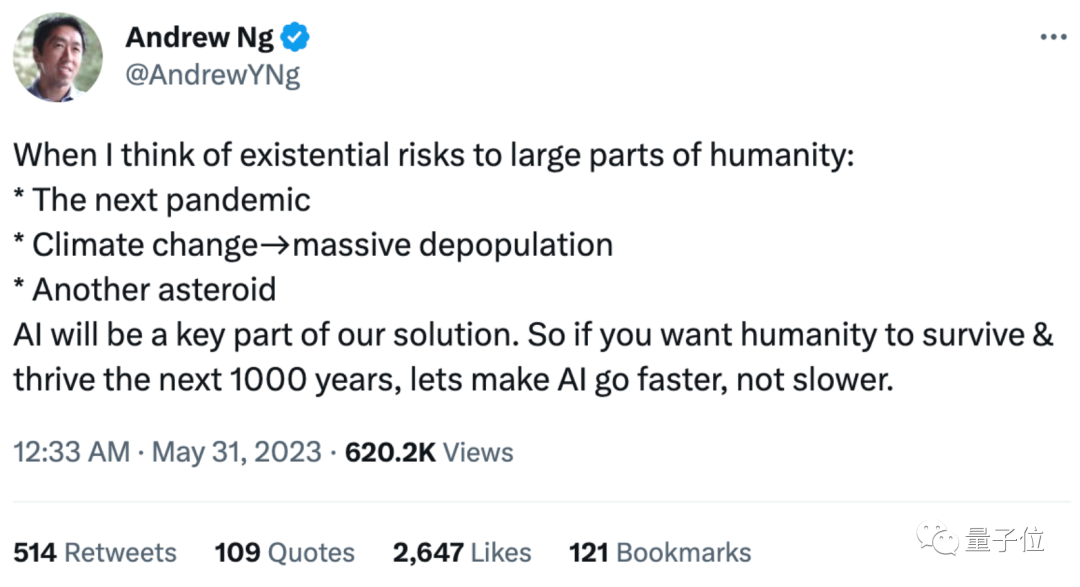

吴恩达发推回应称:

当我想到大部分人类生存面临的风险时:流行病、气候变化导致大规模人口减少、(撞击地球的)小行星……

AI将是我们寻找解决方案的关键部分。所以,如果你想让人类在接下来的1000年里生存和繁荣,那就让AI发展得更快,而不是更慢。

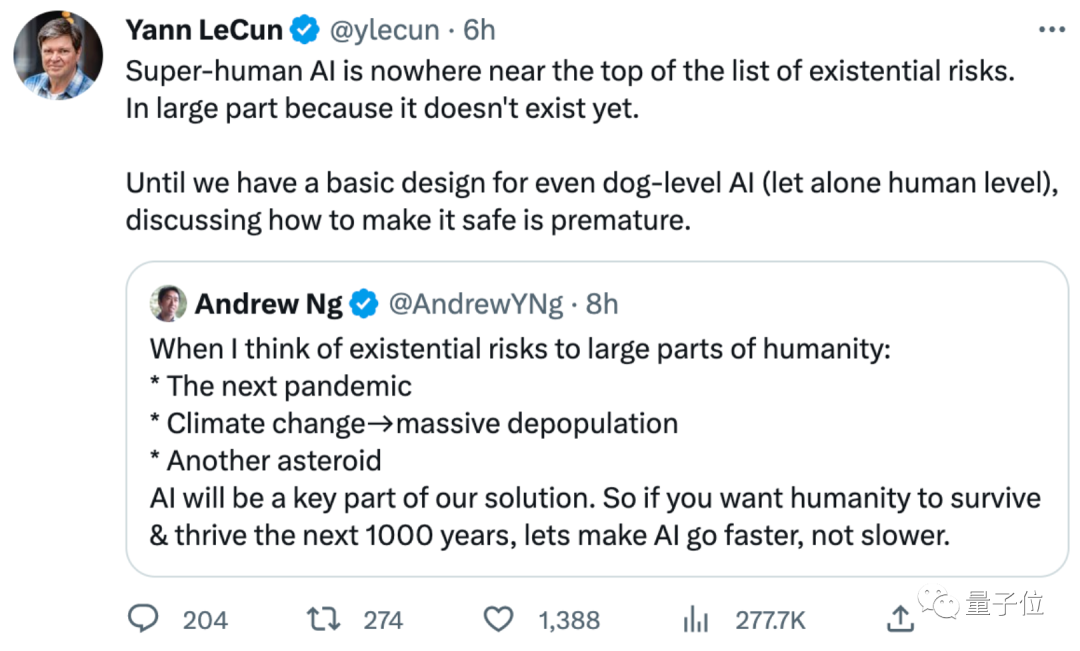

LeCun转发表示同意:

“超人级”AI之所以不在风险列表榜首,很大程度上是因为它还不存在。至少我们在设计出达到狗智商(更不用说人类了)的AI之前,讨论它的安全性还为时过早。

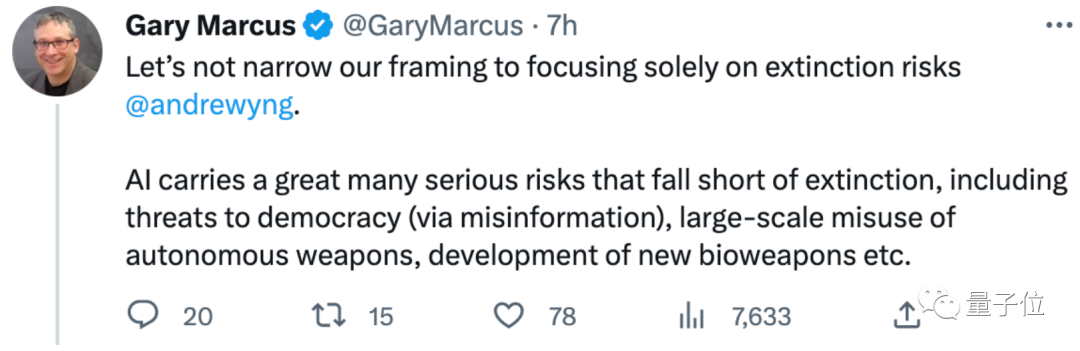

对此,纽约大学教授Gary Marcus补充道:

不要把框架缩小到只关注人类灭绝的风险。AI其实还存在许多其他的严重风险,包括可能帮助开发生物武器等。

不过,Gary Marcus同样没有签署这份350人公开信。

显然包括不少AI大牛在内,反对者主要有两种意见。

一种意见认为,AI技术确实存在风险,但这封公开信涉及到的内容太泛泛。

如果有更精确的声明如“减轻AI技术的潜在风险应该是科技行业、政府和该领域学术研究人员的首要任务”,那么这封信还是可以签署的。

这封公开信中的内容根本就是夸大其词了,而且AI在气候变化等领域甚至可以起到降低风险的作用。

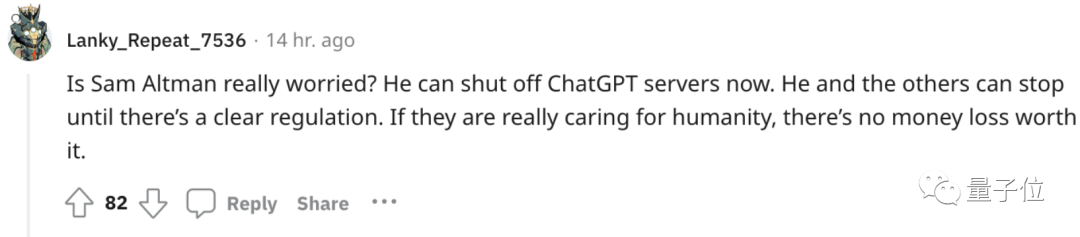

另一类意见则认为,这封信只不过是当前掌握最领先AI技术的人,试图控制AI接下来的走向而已。

以OpenAI的CEO Sam Altman为例:

Sam Altman要是真的担心,大可以现在直接关掉ChatGPT服务器。

所以,你认为按照现在的进度来看,AI有可能灭绝人类吗?

参考链接:

[1]https://www.safe.ai/statement-on-ai-risk

[2]https://www.nytimes.com/2023/05/30/technology/ai-threat-warning.html?smtyp=cur&smid=tw-nytimes

[3]https://twitter.com/AndrewYNg/status/1663584330751561735

[4]https://www.reddit.com/r/MachineLearning/comments/13vls63/n_hinton_bengio_and_other_ai_experts_sign/

最新CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-扩散模型或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看![]()