Word 版Github项目地址: https://github.com/BingLiHanShuang/Chinese-Knowledge-Collation-of-Heterogeneous-Computing-with-OpenCL-2.0

OpenCL 2.0 异构计算 [第三版] (Heterogeneous Computing with OpenCL 2.0)

https://www.bookstack.cn/read/Heterogeneous-Computing-with-OpenCL-2.0/README.md

Intel opencl sdk下载安装

https://software.intel.com/content/www/us/en/develop/tools/opencl-sdk/choose-download.html

目录

OpenCL 2.0 异构计算 [第三版] (Heterogeneous Computing with OpenCL 2.0)

clCreateCommandQueueWithProperties()

clBuildProgram()创建NVIDIA GPU的中间码

clEnqueueWriteBuffer()和clEnqueueReadBuffer()

CLK_FILTER_NEAREST和CLK_FILTER_LINEAR

clEnqueueReadBuffer()中的blocking_read

clEnqueueBarrierWithWaitList()

在数组对象创建和初始化、传递内核参数,从内存对象中读回数据中,数据转移的过程

reserve_read_pipe()和reserve_write_pipe()

commit_read_pipe()和commit_write_pipe()

work_group_reserve_write_pipe()和work_group_reserve_read_pipe()

work_group_commit_read_pipe()和work_group_commit_write_pipe()

atomic_compare_exchange_strong_explicit()

第11章 高级语言映射到OpenCL2.0 —— 从编译器作者的角度

OpenCL较大的改变

1、共享虚拟内存

主机和设备端可以共享复杂数据结构指针,比如:树和链表;以减少花在数据结构转换上的精力。

2、动态并行

可以在不用主机代码参与的情况下,进行内核的加载,为的就是减小加载内核所产生的瓶颈。

3、统一地址空间

这样同样的函数就可以处理GPU和CPU上的数据,以减少编程的难度。

4、C++原子操作

工作项可以跨越工作组共享数据和设备,可以让更多的算法使用OpenCL实现。

第1章 异构计算简介

异构计算:串行处理、并行处理

加速的方法

1、分而治之

将一个问题递归的划分为数个子问题,直到可用的计算资源能够解决划分后的子问题。

2、分散-聚合

先发送一部分输入数据到每个并行资源中,然后将这些输入数据处理后的结果进行收集,再将这些结果合并到一个结果数据集中。

CMOS

互补金属氧化物半导体,Complementary Metal Oxide Semiconductor

并发与并行

并行编程必须是并发的,不过并发编程不一定并行。虽然很多并发程序可以并行执行,但是互相有依赖的并发任务就不能并行了。比如:交错执行就符合并发的定义,而不能并行的执行。所以,并行是并发的一个子集,并发程序是所有程序集的一个子集。

线程

进程中的所有线程都会共享一些资源(比如:内存、打开的文件、全局变量),不过他们也有属于自己的资源(比如:堆栈、自动变量)。

线程使用全局共享地址空间分配出的变量进行通讯。

通讯时需要有同步机制来保证同一个内存区域的内容不会被多个线程更新。

共享内存模型

关键的特性:不需要编程者去管理数据的移动

在这样的系统中,线程如何去更新全局变量,底层硬件和编程者要达成共识,并遵守“内存一致性模型”

瓶颈

内存一致性模型下,能够使用的处理器相对较少,这是因为共享总线和相干性协议将会成为性能瓶颈。

系统中多一些松散的共享内存,相对来说会好一些;当有成规模的内核在共享内存系统中时,其会让系统变得复杂,并且内核间的互相通讯也要付出很高的代价。

大多数多核CPU平台都支持某一种共享内存,OpenCL也可以在支持共享内存的设备上运行。

消息通讯机制

消息传递接口(MPI)库在当今环境下依旧是很受欢迎的消息传递中间件

并行计算的粒度

线程中计算量与通讯量(比如,需要在线程间进行同步的变量)

细粒度并行

使用细粒度并行时,需要考虑如下几点:

1、计算量不要过大,这样每个线程都有足够的工作可做。

2、尽可能减少在数据同步上的开销,这样每个线程能够独立的完成自己的任务。

3、负载的划分也很重要,因为有大量的独立任务需要并行执行,设计良好的任务调度器都能灵活控制负载,并保证在多任务运行的同时,让线程上的达到均衡。

粗粒度并行

使用粗粒度并行时,需要考虑如下几点:

1、计算量肯定要高于细粒度并行时的计算量,因为不会像细粒度并行那样,有很多线程同时执行。

2、编程者使用粗粒度编程时,需要了解应用的整体结构,让粗粒度中的每个线程作为任务,服务于应用。

粗细粒度选择

当同步和通讯的开销大于计算,那么将并行粒度加大,更有利于控制同步和通讯所需的过高开销。

细粒度并行能减少负载不均和访存延迟在性能上的开销(对于GPU来说更是如此,其为粒度之细可以切换线程时达到零开销,同时也能隐藏访存延迟)。

将数据视为向量

当一个算法需要对大量数据进行同一组操作时,就可将数据视为向量,执行同一操作时,多个数据作为输入,经过向量操作后输出多个数据。

这种执行方式就是利用单指令多数据(SIMD)的方式对数据进行处理,可并行硬件可以利用这种执行方式,并行的对不同的数据进行处理。这种粒度的并行与向量的大小有关,通过SIMD执行单元的多数据处理来获得应用性能的提升。

数据共享的用途

1、一个任务中的输入,依赖于另外一个任务的输出——例如:生产者-消费者模型、流水线执行模型。

2、需要将中间结果进行综合(比如:归约,还有图1.5里的例子)。

理想状态下,可以尝试将应用能并行的部分剥离出来,确保并行的部分没有数据依赖,不过这只是理想状态而已。栅栏和锁有时会用来做数据的同步。

OpenCL2.0的三种共享虚拟内存

1、粗粒度共享缓存

2、细粒度共享缓存

3、系统级细粒度共享缓存

使用共享虚拟内存需要OpenCL实现将系统中主机和设备端的地址链接起来。这就允许在OpenCL内核中使用数据结构的指针(比如:链表),之前版本的OpenCL标准是不支持内核中使用自定义数据结构指针。

粗粒度缓存支持通过API的调用,来更新整个缓存的内容。

细粒度缓存和系统级细粒度的粒度为字节级,这就意味着无论是主机端,还是设备端,对数据的更新将会立即同步。

细粒度共享内存是按内存一致模型中定义好的内存序,在同步点对数据进行同步。

OpenCL2.0新特性

1、嵌套并行化

2、共享虚拟内存

3、管道内存对象

4、C11原子操作

5、增强图像支持

OpenCL多级别的并行化

能够将应用高效的映射到同构或异构、单独或多个CPU或GPU上,以及其他硬件供应商提供的硬件系统当中。

OpenCL “设备端-主机端”语言

主机作为对其他设备的管理者。

设备端语言被设计用来映射内存系统和执行模型。

主机端语言用较低的开销,为复杂的并发程序搭建任务管道。

OpenCL基于任务和基于数据的并行

OpenCL的内核类似于SPMD模型,内核就是并行单元(OpenCL称为工作项)中执行的实例,内核实例创建并入队后,会被映射到支持标量和矢量的硬件上运行。

OpenCL2.0共享虚拟内存

共享虚拟内存是一项很重要的特性,其对能减轻编程者的负担,特别是在类似APU这样使用统一物理内存的系统上。

OpenCL2.0内存一致模型

提供“获取/释放”语义以缓解编程者在不明确的锁上耗费不必要的精力

第2章 设备架构

超标量执行方式

VLIW和硬件管理:通过查询地址,并行执行同指令流中不相关的指令

SIMD与向量并行:让指令在数据上并行执行

向量操作

将向量化操作通用化,并且向量操作通常会用来处理较长连续的数据序列,通常会使用流水线的形式进行向量操作,而非同时对多个数据进行操作,并且向量操作对连续、密集的内存读写给予了更多的支持。

并行的三种常见的形式

指令并行,数据并行、线程并行。

并行的方式就是执行多个独立的指令流

两种方式实现硬件多线程

1、并发多线程(SMT)

多线程的指令在执行资源上交替执行(通过超标量扩展的调度逻辑和线程资源)

缺点:需要对更多的状态信息进行保存,并且会让指令间得依赖关系和调度逻辑变得更加复杂

2、时域多线程

每个线程都能通过轮询的方式连续执行

目的:两个线程共享一个ALU。

优势:

1、调度逻辑简单。

2、流水线的延迟可以隐藏对多个线程的切换(调度),减少转发逻辑。

3、当有线程缓存未命中,或等待另一个分支计算的结果等之类事件,都能通过改变线程指令顺序进行掩盖,并且执行更多的线程能更好的掩盖流水线上的延迟。

原理:以延迟换取最大的吞吐量,通过时域多线程的方式,来你做吞吐量的计算:多个线程交替执行,以保证设备处于忙碌状态,不过每个独立线程的执行时间要多于其理论最小执行时间。

片上系统优点

1、将很多元素融合在一个设备上,这样在生产的时候一次就能搞定,避免在制造阶段耗费太多成本。

2、更少的功能将会降低设备上的面积占用率,可以节省功耗和降低设备体积,这对于移动通讯领域很重要。

3、更短的距离意味着数据交互和信息传递完全可以在一个内存系统中进行,并且降低了交互的功耗。

4、低通讯延迟可以增加处理器对负载分发的次数。

内存访问的局部方式

1、空域:两个以上(包括两个)的读或写操作,对内存上(一定程度上)附近的地址。

2、时域:在相对小的时间窗内对同一地址进行两个以上(包括两个)的读或写操作。

第3章 介绍OpenCL

OpenCL标准

1、平台模型

指定一个host处理器,用于任务的调度。以及一个或多个device处理器,用于执行OpenCL任务(OpenCL C Kernel)。这里将硬件抽象成了对应的设备(host或device)。

2、执行模型

定义了OpenCL在host上运行的环境应该如何配置,以及host如何指定设备执行某项工作。这里就包括host运行的环境,host-device交互的机制,以及配置内核时使用到的并发模型。并发模型定义了如何将算法分解成OpenCL工作项和工作组。

3、内核编程模型

定义了并发模型如何映射到实际物理硬件。

4、内存模型

定义了内存对象的类型,并且抽象了内存层次,这样内核就不用了解其使用内存的实际架构。其也包括内存排序的要求,并且选择性支持host和device的共享虚拟内存。

clGetPlatformIDs()

查找制定系统上的可用OpenCL平台的集合。

在具体的OpenCL程序中,这个API一般会调用两次,用来查询和获取到对应的平台信息:

第一次调用这个API需要传入num_platforms作为数量参数,传入NULL作为平台参数。这样就能获取在该系统上有多少个平台可供使用。编程者可以开辟对应大小的空间(指针命名为platforms),来存放对应的平台对象(类型为 cl_platform_id)。

第二次调用该API时,就可将platforms传入来获取对应数量的平台对象。平台查找完成后,使用clGetPlatformInfo()API可以查询对应供应商所提供的平台,然后决定使用哪个平台进行运行OpenCL程序。

clGetPlatformIDs()这个API需要在其他API之前调用。

格式:

cl_int

clGetPlatformIDs(

cl_uint num_entries,

cl_platform_id *platforms,

cl_uint *num_platforms)

clGetDeviceIDs()

查询平台上可用的设备,多了平台对象和设备类型作为入参。

需要三步创建device:

第一,查询设备的数量;

第二,分配对应数量的空间来存放设备对象;

第三,选择期望使用的设备(确定设备对象)。

device_type参数可以将设备限定为GPU(CL_DEVICE_TYPE_GPU),限定为CPU(CL_DEVICE_TYPE_CPU),或所有设备(CL_DEVICE_TYPE_ALL),当然还有其他选项。这些参数都必须传递给clGetDeviceIDs()。相较于平台的查询API,clGetDeviceInfo()API可用来查询每个设备的名称、类型和供应商。

格式:

cl_int

clGetDeviceIDs(

cl_platform_id platform,

cl_device_type device_type,

cl_uint num_entries,

cl_device_id *devices,

cl_uint *num_devices)

clCreateContext()

创建上下文对象。

properties参数用于限制上下文作用的范围。这个参数可由特定的平台提供,其能够使能与图像的互用性,或使能其他能力。

通过限制给定平台的上下文,允许编程者使用多个平台创建的不同的上下文,并且能在一个平台中混用多个供应商提供的设备。

另外,创建上下文时必须要使用设备对象,并且编程者可以设置一个用户回调函数,还可以额外传递一个错误码(需要在错误码对象的生命周期内)用于获取API运行的状态。

格式:

cl_context

clCreateContext(

const cl_context_properties *properties,

cl_uint num_devices,

const cl_device_id *devices,

void (CL_CALL_BACK *pfn_notify)(

const char *errinfo,

const void *private_info,

size_t cb,

void *user_data),

void *user_data,

cl_int *errcode_ret)

clCreateContextFromType()

可以使用所有的设备类型(CPU、GPU和ALL)创建上下文。

clGetContextInfo()

创建上下文之后,可以用来查询上下文中设备的数量,以及具体的设备对象。

命令指定的行为

执行内核、进行数据传递、执行同步

clCreateCommandQueueWithProperties()

创建命令队列,且将命令队列与一个device进行关联。

peoperties参数是由一个位域值组成,其可使能命令性能分析功能(CL_QUEUE_PROFILING_ENABLE),以及/或允许命令乱序执行(CL_QUEUE_OUT_OF_DRDER_EXEC_MODE_ENABLE)。

格式:

cl_command_queue

clCreateCommandQueueWithProperties(

cl_context context,

cl_device_id device,

cl_command_queue_properties peoperties,

cl_int *errcode_ret)

clEnqueue

任何以clEnqueue开头的OpenCL API都能向命令队列提交一个命令,并且这些API都需要一个命令队列对象作为输入参数。例如,clEnqueueReadBuffer()将device上的数据传递到host,clEnqueueNDRangeKernel()申请一个内核在对应device执行。

所有的clEnqueue开头的API,均有三个共同的参数:

1、事件链表的指针,其指定了当前命令依赖的事件列表

2、等待列表的长度

3、表示当前命令执行的事件指针,这个指针用于依赖该命令的其他命令。

clFlush()

对命令队列进行栅栏操作,需要一个命令队列作为参数。

clFlush()将会阻塞host上的执行线程,直到命令队列上的命令都从队列上移出。移出命令队列后的命令,就已经提交到device端,不过不一定完全执行完成。

格式:

cl_int clFlush(cl_command_queue command_queue);

clFinish()

对命令队列进行栅栏操作,需要一个命令队列作为参数。

clFinish()的调用将会阻塞host上的执行线程,直到命令队列上的所有命令执行完毕,其功能就是和同步栅栏操作一样。

格式:

cl_int clFinish(cl_command_queue command_queue);

事件

OpenCL API中,用来指定命令之间依赖关系的对象称为事件(event)

命令状态

1、Queued:命令处于命令队列中。

2、Submitted:命令从命令队列中移除,已经提交到设备端执行。

3、Ready:命令已经准备好在设备上执行。

4、Running:命令正在设备上执行。

5、Ended:命令已经在设备上执行完成。

6、Complete:所有命令以及其子命令都执行完成。

CL_COMPLETE

当命令成功的执行完成,事件的状态将会被设置为CL_COMPLETE。

如果命令非正常终止,事件的状态将会为一个负数值。这种情况下,有非正常终止的命令队列,以及其他在同一上下文上创建的命令队列,都将不能正常使用或运行。

clGetEventInfo()

查询事件

APIclWaitForEvents()

用于和host同步,该API阻塞host的执行线程,等待指定事件队列上的所有命令执行完毕。

格式:

cl_int

clWaitForEvents(

cl_uint num_events,

const cl_event *event_list)

设备端入队

执行中的内核现在可以让另外一个内核进入命令队列中。这种情况下,正在执行的内核可以称为“父内核”,刚入队的内核称为“子内核”。虽然,父子内核是以异步的方式执行,但是父内核需要在子内核全部结束后才能结束。我们可通过与父内核关联的事件对象来对执行状态进行查询,当事件对象的状态为CL_COMPLETE时,就代表父内核结束执行。

设备端的命令队列是无序命令队列,其具有无序命令队列的所有特性。设备端命令会进入到设备端产生的命令队列中,并且使用事件的方式来存储各个命令间的依赖关系。这些事件对象只有执行在设备端的父内核可见。

向量加法

1、串行加法实现

void vecadd(int C, int A, int *B, int N){

for (int i = 0; i < N; ++i){

C[i] = A[i] + B[i];

}

}

2、分块处理向量加法,使用粗粒度多线程(例如,使用POSIX CPU线程)。输入向量上的不同元素被分配到不同的核上

void vecadd(int C, int A, int *B, int N, int NP, int tid){

int ept = N / NP; // 每个线程所要处理的元素个数

for (int i = tid ept; i < (tid + 1) ept; ++i){

C[i] = A[i] + B[i];

}

}

3、OpenCL版向量相加内核

kernel

void vecadd(global int C, __global int A, __global int *B){

int tid = get_global_id(0); // OpenCL intrinsic函数

c[tid] = A[tid] + B[tid];

}

条带处理

对于一个多核设备,我们要不就使用底层粗粒度线程API(比如,Win32或POSIX线程),要不就使用数据并行方式(比如,OpenMP)。

粗粒度多线程需要对任务进行划分(循环次数)。因为循环的迭代次数特别多,并且每次迭代的任务量很少,这时我们就需要增大循环迭代的粒度,这种技术叫做“条带处理”

工作项

OpenCL C上的并发执行单元称为工作项(work-item)。

每一个工作项都会执行内核函数体。OpenCL运行时可以创建很多工作项,其个数可以和输入输出数组的长度相对应,并且工作项在运行时,以一种默认合适的方式映射到底层硬件上(CPU或GPU核)。

当OpenCL设备开始执行内核,OpenCL C中提供的内置函数可以让工作项知道自己的编号。

get_global_id(0)

获取当前工作项的位置,以及访问到的数据位于数组中的位置。get_global_id()的参数用于获取指定维度上的工作项编号,其中“0”这个参数,可获取当前第一维上工作项的ID信息。

每个维度上工作项的数量(NDRange)

当要执行一个内核时,编程者需要指定每个维度上工作项的数量(NDRange)。一个NDRange可以是一维、二维、三维的,其不同维度上的工作项ID映射的是相应的输入或输出数据。

NDRange的每个维度的工作项数量由size_t类型指定。

工作组

为了增加NDRange的可扩展性,需要将工作项继续的划分成更细粒度的线程,那么需要再被划分的工作项就称为工作组(work-group)。

与工作项类似,工作组也需要从三个维度上进行指定,每个维度上的工作项有多少个。为了保证硬件工作效率,工作组的大小通常都是固定的。

在同一个工作组中的工作项具有一些特殊的关系:一个工作组中的工作项可以进行同步,并且他们可以访问同一块共享内存。

工作组的大小在每次分配前就已经固定,所以对于更大规模的任务分配时,同一工作组中的工作项间交互不会增加性能开销。实际上,工作项之间的交互开销与分发的工作组的大小并没有什么关系,这样就能保证在更大的任务分发时,OpenCL程序依旧能保证良好的扩展性。

允许各维度上的工作项和工作组数量不成倍数关系,工作数量被分成两部分:第一部分是编程者指定给工作组的工作项,另一部分是剩余的工作组,这些工作可以没有工作项。

允许编程者不去分配工作组的尺寸,其会在实现中进行自动的划分;这样的话,开发者就可以传递NULL作为工作组数组的尺寸。

使用源码创建内核的步骤

1、将OpenCL C源码存放在一个字符数组中。如果源码以文件的形式存放在硬盘上,那么需要将其读入内存中,并且存储到一个字符数组中。

2、调用clCreateProgramWithSource()通过源码可以创建一个cl_program类型对象。

3、创建好的程序对象需要进行编译,编译之后的内核才能在一个或多个OpenCL设备上运行。调用clBuildProgram()完成对内核的编译,如果编译有问题,该API会将输出错误信息。

4、之后,需要创建cl_kernel类型的内核对象。调用clCreateKernel(),并指定对应的程序对象和内核函数名,从而创建内核对象。

创建内核对象

将内核函数名和程序对象传入clCreateKernel(),如果程序对象是合法的,并且这个函数名是存在的,那么久会返回一个内核对象。

一个程序对象上可以提取多个内核对象。每个OpenCL上下文上可有多个OpenCL程序对象,这些程序对象可由OpenCL源码创建。

格式:

cl_kerenl

clCreateKernel(

cl_program program,

const char *kernel_name,

cl_int *errcode_ret)

clBuildProgram()创建NVIDIA GPU的中间码

NVIDIA这种中间码为并行线程执行(PTX,parallel thread execute)。

好处:如果一个设备上的GPU指令集有所变化,其产生的代码功能依旧不会受到影响。这种产生中间代码的方式,能给编译器的开发带来更大的发展空间。

clGetProgramInfo()

返回一些关于程序对象的信息。这个函数中其中有一个参数可以传CL_PROGRAM_BINARIES,这个参数可以返回供应商指定的二进制程序对象(通过clBuildProgram()编译之后)。

OpenCL程序对象另一个特性是能在构建之后,产生二进制格式的文件,并写入到硬盘。

clCreateProgramWithBinary()

这个函数可以通过一系列编译好的二进制文件直接创建程序对象,对应的二进制文件可以通过clGetProgramInfo()得到。

使用二进制表示的OpenCL内核,因为不需要以源码的方式存储,以及安装编译器,这种方式更容易部署OpenCL程序。

clSetKernelArg()

对内核的参数进行设置。这个API需要传入一个内核对象,指定参数的索引值,参数类型的大小,以及对应参数的指针。内核参数列表中的类型信息,需要一个个的传入内核中。

与调用C函数不同,我们不能直接将参数赋予内核函数的参数列表中。执行一个内核需要通过一个入队函数进行发布。由于核内的语法为C,且内核参数具有持续性(如果我们只改变参数里面的值,就没有必要再重新进行赋值)。

格式:

cl_int

clSetKernelArg(

cl_kernel kernel,

cl_uint arg_index,

size_t arg_size,

const void *arg_value)

clEnqueueNDRangeKernel()

入队一个命令道命令队列。

内核执行时,有四个地方与工作项创建有关:

1、work_dim参数指定了创建工作项的维度(一维,二维,三维)。

2、global_work_size参数指定NDRange在每个维度上有多少个工作项,

3、local_work_size参数指定NDRange在每个维度上有多少个工作组。

4、global_work_offset参数可以指定全局工作组中的ID是否从0开始计算。

和所有clRnqueueAPI相同,需要提供一个event_wait_list,当这个参数不为NULL时,当前的内核要等到等待列表中的所有任务都完成才能执行。

该API也是异步的:命令入队之后,函数会立即返回(通常会在内核执行之前就返回)。OpenCL中clWaitForEvents()和clFinish()可以在host端阻塞等待,直到对应的内核对象执行完成。

格式:

cl_int

clEnqueueNDRangeKernel(

cl_command_queue command_queue,

cl_kernel kernel,

cl_uint work_dim,

const size_t *global_work_offset,

const size_t *global_work_size,

const size_t *local_work_size,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

OpenCL三种内存类型

数组、图像、管道

clCreateBuffer()

为Buffer类型分配内存,并返回一个内存对象。这种类型中数据在内存上是连续的。理论上,这种类型可以在设备端以指针的方式使用。

格式:

cl_mem

clCreateBuffer(

cl_context context,

cl_mem_flags flags,

size_t size,

void *host_ptr,

cl_int *errcode_ret)

创建一个数组需要知道其长度和创建在哪一个上下文对象上;创建之后,与该上下文对象相关联的设备就能看到这个内存对象。

对于第二个标识参数,是用来指定设备端可对内存进行的操作,可以是“只读”、“只写”或“读写”。

其他标识需要在数组创建的时候指定。

clCreateImage()

图像数组数据不能直接访问,因为相邻的数据并不保证在内存上连续存储。图像没有数据类型或维度,图像对象的创建需要通过描述符,让硬件了解这段内存数据的具体信息。

格式:

cl_mem

clCreateImage(

cl_context context,

cl_mem_flags flags,

const cl_image_format *image_format,

const cl_image_desc *image_desc,

void *host_ptr,

cl_int *errcode_ret)

图像对象中的每个元素通过格式描述符来表示(cl_image_format)。格式描述符用于描述图像元素在内存上是如何存储,以及使用通道的信息。

通道序

通道序(channel order)指的是由多少个通道元素组成一个图像元素(例如,RGBA就是由四个通道值组成一个像素,其通道序为4),并且通道类型(channel type)指定了每个元素的大小。大小可以设置为1到4字节中的任意值,这样就能表现多种不同的格式(从整型到浮点)。其他数据元通过图像描述符(cl_image_desc)提供,其包括了图像的类型和维度。

OpenCL读写图像数据的内置函数

图像读写函数需要额外的参数,并且这些函数根据图像的具体数据类型进行使用。

read_imagef()函数就适用于读取浮点型的数值;

read_imageui()函数就使用与读取无符号整型的数值。

这些函数在使用的数据类型上有些不同,但在读取方面至少需要有一组访问坐标和一个采样器对象。采样器可以指定,设备访问到图像外部时,这些不存在的数据应该如何获取,是否使用差值,以及是否对坐标进行归一化。

写入图像需要手动将数据转换成对应的存储数据格式(例如,对应的通道和对应的数据大小),目的坐标也需要手动的进行转换。

clCreatePipe()

创建一个管道对象,需要提供包的大小和管道中可容纳包的最大数量(例如,创建时固定了管道中可容纳包的最大值)。

管道内存对象就是一个数据元素(被称为packets)队列,其和其他队列一样,遵循FIFO(先进先出)的方式。一个管道对象具有一个写入末尾点,用于表示元素由这里插入;并且,有一个读取末尾点,用于表示元素由这里移除。

格式:

cl_mem

clCreatePipe(

cl_context context,

cl_mem_flags flags,

cl_uint pipe_packet_size,

cl_uint pipe_max_packets,

const cl_pipe_properties *properties,

cl_int *errcode_ret)

clGetPipeInfo()

返回管道中包的大小和整体大小(也就是可容纳包的最大值)。

属性参数是一个保留参数,在OpenCL 2.0阶段,这个值只能传NULL。

内核对管道的读写

任意时间点,只能有一个内核向管道中存入包,并且只有一个内核从管道中读取包。

为了支持“生产者-消费者”设计模式,一个内核与写入末尾点连接(生产者),同时另一个内核与读取末尾点连接(消费者)。

同一个内核不能同时对一个管道进行读取和存入。

OpenCL访问管道

图像和管道都是不透明的数据结构,其只能通过OpenCL C的内置函数进行访问(比如,read_pipe()和write_pipe())。OpenCL C也提供相应的函数,可以保留管道的读取点和写入点。

内置函数允许管道在工作组级别上进行访问,而不需要单独访问每个工作项,并且能在工作组级别上执行同步。

clEnqueueWriteBuffer()和clEnqueueReadBuffer()

内存对象是一个数组时,用于主机端和设备端的内存互传。

显式的数据传输也需要检索主机端的内存空间。因此,通常情况下使用显式数据传输命令,在内存对象被内核调用之前,为其写入相应的数据到设备端;以及,在内存对象最后一次使用之后,读取其数据到主机端。

设备端使用的内存与主机内存通常是离散的,当命令执行时,数据可能就已经传输到设备端了(比如,使用PCIe总线)。

clEnqueueWriteBuffer()格式:

cl_int

clEnqueueWriteBuffer(

cl_command_queue command_queue,

cl_mem buffer,

cl_bool blocking_write,

size_t offset,

size_t cb,

const void *ptr,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

除了命令队列,该函数还需要数组型的内存对象,所要传输的数据大小,以及数组的偏移。偏移量和传输数据可以将原始数据的一个子集进行传输。

如果需要数据传输完成再返回,blocking_write参数可以设置成CL_TRUE;如果设置成CL_FALSE,则以更加高效的异步方式进行传输,且函数会立即返回,无需等到数据完全传输完再返回。

OpenCL内存

1、主机内存

主机内存可在主机上使用,其并不在OpenCL的定义范围内。使用对应的OpenCL API可以进行主机和设备的数据传输,或者通过共享虚拟内存接口进行内存共享。

2、设备内存

设备内存,指定是能在执行内核中使用的内存空间。

OpenCL设备内存分类

1、全局内存

全局内存对于执行内核中的每个工作项都是可见的(类似于CPU上的内存)。当数据从主机端传输到设备端,数据就存储在全局内存中。有数据需要从设备端传回到主机端,那么对应的数据需要存储在全局内存中。

其关键字为global或__global,关键字加在指针类型描述符的前面,用来表示该指针指向的数据存储在全局内存中。

2、常量内存

常量内存并非为只读数据设计,但其能让所有工作项同时对该数据进行访问。这里存储的值通常不会变化。OpenCL的内存模型中,常量内存为全局内存的子集,所以内存对象传输到全局内存的数据可以指定为“常量”。

使用关键字constant或__constant将相应的数据映射到常量内存。

3、局部内存

局部内存中的数据,只有在同一工作组内的工作项可以共享。通常情况下,局部内存会映射到片上的物理内存,例如:软件管理的暂存式存储器。

比起全局内存,局部内存具有更短的访问延迟,以及更高的传输带宽。

调用clSetKernelArg()设置局部内存时,只需要传递大小,而无需传递对应的指针,相应的局部内存会由运行时进行开辟。

使用local或__local关键字来描述指针,从而来定义局部内存(例如,local int *sharedData)。不过,数据也可以通过关键字local,静态申明成局部内存变量(例如,local int[64])。

4、私有内存

私有内存只能由工作项自己进行访问。局部变量和非指针内核参数通常都在私有内存上开辟。

实践中,私有变量通常都与寄存器对应。不过,当寄存器不够私有数组使用是,这些溢出的数据通常会存储到非片上内存(高延迟的内存空间)上。

通用地址空间

通用地址空间支持指向私有、局部和全局地址指针的互相转换,这样编程者只需要写一个简单的函数即可,其指针参数可以接受这指向这三种内存区域的指针。

创建并执行OpenCL应用的步骤

1、查询平台和设备信息

cl_int status; // 用于错误检查

// 检索平台的数量

cl_uint numPlatforms = 0;

status = clGetPlatformIDs(0, NULL, &numPlatforms);

// 为每个平台对象分配足够的空间

cl_platform_id platforms = NULL;

platforms = (cl_platform_id )malloc(numPlatforms * sizeof(cl_platform_id));

// 将具体的平台对象填充其中

status = clGetPlatformIDs(numPlatforms, platforms, NULL);

// 检索设备的数量

cl_uint numDevices = 0;

status = clGetDeviceIDs(platforms[0], CL_DEVICE_TYPE_ALL, 0, NULL, &numDevices);

// 为每个设备对象分配足够的空间

cl_device_id devices;

devices = (cl_device_id )malloc(numDevices * sizeof(cl_device_id));

// 将具体的设备对象填充其中

status = clGetDeviceIDs(platforms[0], CL_DEVICE_TYPE_ALL, numDevices, devices, NULL);

2、创建一个上下文

// 创建的上下文包含所有找到的设备

cl_context context = clCreateContext(NULL, numDevices, devices, NULL, NULL, &status);

3、为每个设备创建一个命令队列

// 为第一个发现的设备创建命令队列

cl_command_queue cmdQueue = clCreateCommandQUeueWithProperties(context, devices[0], 0, &status);

4、创建一个内存对象(数组)用于存储数据

// 向量加法的三个向量,2个输入数组和1个输出数组

cl_mem bufA = clCreateBuffer(context, CL_MEM_READ_ONLY, datasize, NULL, &status);

cl_mem bufB = clCreateBuffer(context, CL_MEM_READ_ONLY, datasize, NULL, &status);

cl_mem bufC = clCreateBuffer(context, CL_MEM_WRITE_ONLY, datasize, NULL, &status);

5、拷贝输入数据到设备端

// 将输入数据填充到数组中

status = clEnqueueWriteBuffer(cmdQueue, bufA, CL_TRUE, 0, datasize, A, 0, NULL, NULL);

status = clEnqueueWriteBuffer(cmdQueue, bufB, CL_TRUE, 0, datasize, B, 0, NULL, NULL);

6、使用OpenCL C代码创建并编译出一个程序

// 使用源码创建程序

cl_program program = clCreateProgramWithSource(context, 1, (const char **)&programSource, NULL, &status);

// 为设备构建(编译)程序

status = clBuildProgram(program, numDevices, devices, NULL, NULL, NULL);

7、从编译好的OpenCL程序中提取内核

// 创建向量相加内核

cl_kernel kernel = clCreateKernel(program, “vecadd”, &status);

8、执行内核

// 设置内核参数

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufA);

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufB);

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufC);

// 定义工作项的空间维度和空间大小

// 虽然工作组的设置不是必须的,不过可以设置一下

size_t indexSpaceSize[1],workGroupSize[1];

indexSpaceSize[0] = datasize / sizeof(int);

workGroupSize[0] = 256;

// 通过执行API执行内核

status = clEnqueueNDRangeKernel(cmdQueue, kernel, 1, NULL, indexSpaceSize, workGroupSize, 0, NULL, NULL);

9、拷贝输出数据到主机端

// 将输出数组拷贝到主机端内存中

status = clEnqueueReadBuffer(cmdQueue, bufC, CL_TRUE, 0, datasize, C, 0, NULL, NULL);

10、释放资源

clReleaseKernel(kernel);

clReleaseProgram(program);

clReleaseCommandQueue(cmdQueue);

clReleaseMemObject(bufA);

clReleaseMemObject(bufB);

clReleaseMemObject(bufC);

clReleaseContext(context);

使用C API实现的OpenCL向量相加 完整代码

// This program implements a vector addition using OpenCL

// System includes

// OpenCL includes

// OpenCL kernel to perform an element-wise addition

const char programSouce =

“kernel \n”

“void vecadd(global int A, \n”

“ global int *B, \n”

“ global int *C) \n”

“{ \n”

“ // Get the work-item’s unique ID \n”

“ int idx = get_global_id(0); \n”

“ \n”

“ // Add the corresponding locations of \n”

“ // ‘A’ and ‘B’, and store the reasult in ‘C’ \n”

“ C[idx] = A[idx] + B[idx]; \n”

“} \n”

;

int main(){

// This code executes on the OpenCL host

// Elements in each array

const int elements = 2048;

// Compute the size of the data

size_t datasize = sizeof(int) * elements;

// Allocate space for input/output host data

int A = (int )malloc(datasize); // Input array

int B = (int )malloc(datasize); // Input array

int C = (int )malloc(datasize); // Output array

// Initialize the input data

int i;

for (i = 0; i < elements; i++){

A[i] = i;

B[i] = i;

}

// Use this to check the output of each API call

cl_int status;

// Get the first platforms

cl_platform_id platform;

status = clGetPlatformIDs(1, &perform, NULL);

// Get the first devices

cl_device_id device;

status = clGetDeviceIDs(platform, CL_DEVICE_TYPE_ALL, 1, &device, NULL);

// Create a context and associate it with the device

cl_context context = clCreateContext(NULL, 1, &device, NULL, NULL, &status);

// Create a command-queue and associate it with device

cl_command_queue cmdQueue = clCreateCommandQUeueWithProperties(context, device, 0, &status);

// Allocate two input buffers and one output buffer for the three vectors in the vector addition

cl_mem bufA = clCreateBuffer(context, CL_MEM_READ_ONLY, datasize, NULL, &status);

cl_mem bufB = clCreateBuffer(context, CL_MEM_READ_ONLY, datasize, NULL, &status);

cl_mem bufC = clCreateBuffer(context, CL_MEM_WRITE_ONLY, datasize, NULL, &status);

// Write data from the input arrays to the buffers

status = clEnqueueWriteBuffer(cmdQueue, bufA, CL_FALSE, 0, datasize, A, 0, NULL, NULL);

status = clEnqueueWriteBuffer(cmdQueue, bufB, CL_FALSE, 0, datasize, B, 0, NULL, NULL);

// Create a program with source code

cl_program program = clCreateProgramWithSource(context, 1, (const char**)&programSource, NULL, &status);

// Build(compile) the program for the device

status = clBuildProgram(program, 1, &device, NULL, NULL, NULL);

// Create the vector addition kernel

cl_kernel kernel = clCreateKernel(program, “vecadd”, &status);

// Set the kernel arguments

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufA);

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufB);

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufC);

// Define an incde space of work-items for execution

// A work-group size is not required, but can be used.

size_t indexSpaceSize[1], workGroupSize[1];

// There are ‘elements’ work-items

indexSpaceSize[0] = elements;

workGroupSize[0] = 256;

// Execute the kernel

status = clEnqueueNDRangeKernel(cmdQueue, kernel, 1, NULL, indexSpaceSize, workGroupSize, 0, NULL, NULL);

// Read the device output buffer to the host output array

status = clEnqueueReadBuffer(cmdQueue, bufC, CL_TRUE, 0, datasize, C, 0, NULL, NULL);

// Free OpenCL resouces

clReleaseKernel(kernel);

clReleaseProgram(program);

clReleaseCommandQueue(cmdQueue);

clReleaseMemObject(bufA);

clReleaseMemObject(bufB);

clReleaseMemObject(bufC);

clReleaseContext(context);

// free host resouces

free(A);

free(B);

free(C);

return 0;

}

使用C++ Wapper实现的OpenCL向量相加

int main(){

const int elements = 2048;

size_t datasize = sizeof(int) * elements;

int A = new int[elements];

int B = new int[elements];

int *C = new int[elements];

for (int i = 0; i < elements; i++){

A[i] = i;

B[i] = i;

}

try{

// Query for platforms

std::vector platforms;

cl::Platform::get(&platforms);

// Get a list of devices on this platform

std::vector<cl::Device> devices;

platforms[0].getDevices(CL_DEVICE_TYPE_ALL, &devices);

// Create a context for the devices

cl::Context context(devices);

// Create a command-queue for the first device

cl::CommandQueue queue = cl::CommandQueue(context, devices[0]);

// Create the memory buffers

cl::Buffer bufferA = cl::Buffer(context, CL_MEM_READ_ONLY, datasize);

cl::Buffer bufferB = cl::Buffer(context, CL_MEM_READ_ONLY, datasize);

cl::Buffer bufferC = cl::Buffer(context, CL_MEM_WRITE_ONLY, datasize);

// Copy the input data to the input buffers using the

// command-queue for the first device

queue.enqueueWriteBuffer(bufferA, CL_TRUE, 0, datasize, A);

queue.enqueueWriteBuffer(bufferB, CL_TRUE, 0, datasize, B);

// Read the program source

std::ifstream sourceFile("vector_add_kernel.cl");

std::string sourceCode(std::istreambuf_iterator<char>(sourceFile), (std::istreambuf_iterator<char>()));

cl::Program::Source source(1, std::make_pair(sourceCode.c_str(), sourceCode.length() + 1);

// Create the program from the source code

cl::Program program = cl::Program(context, source);

// Build the program for the devices

program.build(devices);

// Create the kernel

cl::Kernel vecadd_kernel(program, "vecadd");

// Set the kernel arguments

vecadd_kernel.setArg(0, bufferA);

vecadd_kernel.setArg(1, bufferB);

vecadd_kernel.setArg(2, bufferC);

// Execute the kernel

cl::NDRange gloabl(elements);

cl::NDRange local(256);

queue.enqueueNDRangeKernel(vecadd_kernel, cl::NullRange, gloabl, local);

// Copy the output data back to the host

queue.enqueueReadBuffer(bufferC, CL_TRUE, 0, datasize, C);

} catch(cl::Error error){

std::cout << error.what() << “(“ << error.err() << “)” << std::endl;

}

}

第4章 OpenCL案例

OpenCL计算直方图

思路

1、在每个工作组中创建一份局部积分图。【局部内存中的数据,每个工作组中的所有工作项都可以共享访问。局部内存一般会分布在GPU的片上内存中,其访问速度要比访问全局内存快的多。】

2、当工作组完成局部积分图时,其会传递给全局内存,并使用原子加操作将对应位置上的数据原子加到全局内存中。不过,这种实现方式也有问题:对局部内存的访问上存在条件竞争。这里需要你对目标设备的架构有所了解。对于很多GPU来说,原子操作访问局部内存的效率很高。在AMD Radeon GPU上,原子单元位于片上暂存式存储器中。因此,局部内存上的原子操作的效率要比全局原子操作的效率高很多。

计算直方图的OpenCL内核代码

1、初始化局部直方图内的值为0 (第14行)

2、同步工作项,确保相应的数据全部更新完毕 (第23行)

3、计算局部直方图 (第26行)

4、再次同步工作项,确保相应的数据全部更新完毕 (第35行)

5、将局部直方图写入到全局内存中 (第39行)

define HIST_BINS 256

kernel

void histogram(global int data, int numData, __global int histogram){

__local int localHistorgram[HIST_BINS];

int lid = get_local_id(0);

int gid = get_glaobal_id(0);

/ Initialize local histogram to zero /

for (int i = lid; i < HIST_BINS; i += get_local_size(0)){

localHistorgram[i] = 0;

}

/* Wait nutil all work-items within

the work-group have completed their stores */

barrier(CLK_LOCAL_MEM_FENCE);

/ Compute local histogram /

for (int i = gid; i < numData; i += get_glaobal_size(0)){

atomic_add(&localHistorgram[data[i]], 1);

}

/* Wait nutil all work-items within

the work-group have completed their stores */

barrier(CLK_LOCAL_MEM_FENCE);

/* Write the local histogram out to

the global histogram */

for (int i = lid; i < HIST_BINS; i += get_glaobal_size(0)){

atomic_add(&histogram[i], localHistorgram[i]);

}

}

当我们需要工作项需要访问不同的内存位置时,我们可以以工作项的唯一标识ID为基准,然后加上所有工作项的数量作为跨度(例如,工作组内以工作组中工作项的数量,计算对应工作项所要访问的局部内存位置。或以NDRange中的尺寸,访问全局内存)。

内存栅栏

能确保工作组中的所有工作项都要到达该栅栏处,只要有线程没有达到,已达到的线程就不能执行下面的操作。

局部内存栅栏就是用来保证所有工作项都到达栅栏处,以代表局部直方图更新完毕。

clEnqueueFillBuffer()

对数据进行初始化。

该API类似于C中的memset()函数。

buffer参数就是要初始化的数组对象,具体的值由pattern指定。与memset()不同,pattern可以指定为任意的OpenCL支持类型,比如:标量、整型向量或浮点类型。

pattern_size用来指定pattern所占空间。

size参数用来指定数组内初始化的字节数,其值必须是pattern_size的整数倍。

offset参数用来指定数组起始初始化的位置或偏移。

格式:

cl_int

clEnqueueFillBuffer(

cl_command_queue command_queue,

cl_mem buffer,

const void *pattern,

size_t offset,

size_t size,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

直方图统计的主机端代码

注意,check(cl_int status)是用来检查之前执行命令的状态是否为CL_SUCCESS。

/ System includes /

/ OpenCL includes /

/ Utility functions /

include “utils.h”

include “bmp_utils.h”

static const int HIST_BINS = 256;

int main(int argc, char *argv[]){

/ Host data /

int hInputImage = NULL;

int hOutputHistogram = NULL;

/* Allocate space for the input image and read the

data from disk /

int imageRows;

int imageCols;

hInputImage = readBmp(“../../Images/cat.bmp”, &imageRows, &imageCols);

const int imageElements = imageRows imageCols;

const size_t imageSize = imageElements * sizeof(int);

/ Allocate space for the histogram on the host /

const int histogramSize = HIST_BINS sizeof(int);

hOutputHistogram = (int )malloc(histogramSize);

if (!hOutputHistogram){ exit(-1); }

/ Use this check the output of each API call /

cl_int status;

/ Get the first platform /

cl_platform_id platform;

status = clGetPlatformIDs(1, &platform, NULL);

check(status);

/ Get the first device /

cl_device_id device;

status = clGetDeviceIDs(platform, CL_DEVICE_TYPE_GPU, 1, &device, NULL);

check(status);

/ Create a command-queue and associate it with the device /

cl_command_queue cmdQueue;

context = clCreateContext(NULL, 1, &device, NULL, NULL, &status);

check(status);

/ Create a buffer object for the output histogram /

cl_mem bufOutputHistogram;

bufOutputHistogram = clCreateBuffer(context, CL_MEM_WRITE_ONLY, histogramSize, NULL, &status);

check(status);

/ Write the input image to the device /

status = clEnqueueWriteBuffer(cmdQueue, bufInputImage, CL_TRUE, 0, imageSize, hInputImage, 0, NULL, NULL);

check(status);

/ Initialize the output histogram with zero /

int zero = 0;

status = clEnqueueFillBuffer(cmdQueue, bufOutputHistogram, &zero, sizeof(int), 0, histogramSize, 0, NULL, NULL);

check(status);

/ Create a program with source code /

char programSource = readFile(“histogram.cl”);

size_t prograSourceLen = strlen(programSource);

cl_program program = clCreateProgramWithSouce(context, 1, (const char *)&programSource, &prograSourceLen, &status);

check(status);

/ Build (compile) the program for the device /

status = clBuildProgram(program, 1, &device, NULL, NULL, NULL);

if (status != CL_SUCCESS){

printCompilerError(program, device);

exit(-1);

}

/ Create the kernel /

cl_kernel kernel;

kernel = clCreateKernel(program, “histogram”, &status);

check(status);

/ Set the kernel arguments /

status = clSetKernelArg(kernel, 0, sizeof(cl_mem), &bufInputImage);

status |= clSetKernelArg(kernel, 1, sizeof(int), &imageElements);

status |= clSetKernelArg(kernel, 2, sizeof(cl_mem), &bufOutputHistogram);

/ Define the index space and work-group size /

size_t globalWorkSize[1];

globalWorkSize[0] = 1024;

size_t localWorkSize[1];

localWorkSize[0] = 64;

/ Enqueue the kernel for execution /

status = clEnqueueNDRangeKernel(cmdQueue, kernel, 1, NULL, globalWorkSize, localWorkSize, 0, NULL, NULL);

check(status);

/ Read the output histogram buffer to the host /

status = clEnqueuReadBuffer(cmdQueue, bufOutputHistogram, CL_TRUE, 0, histogramSize, hOutputHistogram, 0, NULL, NULL);

check(status);

/ Free OpenCL resources /

clReleaseKernel(kernel);

clReleaseProgram(program);

clReleaseCommandQueue(cmdQueue);

clReleaseMemObject(bufInputImage);

clReleaseMemObject(bufOutputHistogram);

clReleaseContext(context);

/ Free host resource /

free(hInputImage);

free(hOutputHistogram);

free(programSource);

return 0;

}

OpenCL旋转图像

图像旋转内核

__constant sampler_t sampler =

CLK_NORMALIZED_COORDS_FALSE |

CLK_FILTER_LINEAR |

CLK_ADDRESS_CLAMP;

kernel

void rotation( read_only image2d_t inputImage,

__write_only image2d_t ouputImage,

int imageWidth,

int imageHeigt,

float theta)

{

/ Get global ID for ouput coordinates /

int x = get_global_id(0);

int y = get_global_id(1);

/ Compute image center /

float x0 = imageWidth / 2.0f;

float y0 = imageHeight / 2.0f;

/* Compute the work-item’s location relative

to the image center */

int xprime = x - x0;

int yprime = y - y0;

/ Compute sine and cosine /

float sinTheta = sin(theta);

float cosTheta = cos(theta);

/ Compute the input location /

float2 readCoord;

readCoord.x = xprime cosTheta - yprime sinTheta + x0;

readCoord.y = xprime sinTheta + yprime cosTheta + y0;

/ Read the input image /

float value;

value = read_imagef(inputImage, sampler, readCoord).x;

/ Write the output image /

write_imagef(outputImage, (int2)(x, y), (float4)(value, 0.f, 0.f, 0.f));

}

图像采样器(sampler_t sampler)

用来描述如何访问图像。采样器指定如何处理访问到的图像位置,比如,当访问到图像之外的区域,或是当访问到多个坐标时,不进行差值操作。

CLK_NORMALIZED_COORDS_FALSE

标识指定基于像素地址的寻址。

CL_ADDRESS_CLAMP

用于处理跨边界访问寻址方式。CL_ADDRESS_CLAMP表示当访问到图像之外的区域,会将RGB三个通道的值设置成0,并且将A通道设置成1或0(由图像格式决定)。所以,超出范围的像素将会返回黑色。

CLK_FILTER_NEAREST和CLK_FILTER_LINEAR

一种过滤模式。过滤模式将决定将如何返回图像所取到的值。选项CLK_FILTER_NEAREST只是简单的返回离所提供左边最近的图像元素。

或者使用CLK_FILTER_LINEAR将坐标附近的像素进行线性差值。

为旋转例程创建图像对象

/* The image descriptor describes how the data will be stored in memory. This descriptor initializes a 2D image with no pitch */

cl_image_desc desc;

desc.image_type = CL_MEM_OBJECT_IMAGE2D;

desc.image_width = width;

desc.image_height = height;

desc.image_depth = 0;

desc.image_array_size = 0;

desc.image_row_pitch = 0;

desc.image_slice_pitch = 0;

desc.num_mip_levels = 0;

desc.num_samples = 0;

desc.buffer = NULL;

/ The image format descibes the properties of each pixel /

cl_image_format format;

format.image_channel_order = CL_R; // single channel

format.image_channel_data_type = CL_FLOAT;

/* Create the input image and initialize it using a pointer to the image data on the host */

cl_mem inputImage = clCreateImage(context, CL_MEM_READ_ONLY, &format, &desc, NULL, NULL);

/ Create the output image /

cl_mem ouputImage = clCreateImage(context, CL_MEM_WRITE_ONLY, &formatm, &desc, NULL, NULL);

/ Copy the host image data to the device /

size_t origin[3] = {0,0,0}; // Offset within the image to copy form

size_t region[3] = {width, height, 1}; // Elements to per dimension

clEnqueueWriteImage(queue, inputImage, CL_TRUE,

origin, region, 0 / row-pitch /, 0 / slice-pitch /,

hostInputImage, 0, NULL, NULL);

图像旋转主机端的完整代码

/ System includes /

/ OpenCL includes /

/ Utility functions /

include “utils.h”

include “bmp-utils.h”

int main(int argc, char *argv)

{

/ Host data /

float hInputImage = NULL;

float *hOutputImage = NULL;

/ Angle for rotation (degrees) /

const float theta = 45.f;

/* Allocate space for the input image and read the

data from disk /

int imageRows;

int imageCols;

hInputImage = readBmpFloat(“cat.bmp”, &imageRow, &imageCols);

const int imageElements = imageRows imageCols;

const size_t imageSize = imageElements * sizeof(float);

/ Allocate space for the ouput image /

hOutputImage = (float *)malloc(imageSize);

if (!hOutputImage){ exit(-1); }

/ Use this to check the output of each API call /

cl_int status;

/ Get the first platform /

cl_platform_id platform;

status = clGetPlatformIDs(1, &platform, NULL);

check(status);

/ Get the first device /

cl_device_id device;

status = clGetDeviceIDs(platform, CL_DEVICE_TYPE_GPU, 1, &device, NULL);

check(status);

/ Create a context and associate it with the device /

cl_context context;

context = clCreateContext(NULL, 1, &device, NULL, NULL, &status);

check(status);

/ Create a command-queue and associate it with the device /

cl_command_queue cmdQueue;

cmdQueue = clCreateCommandQueue(context, device, 0, &status);

check(status);

/* The image descriptor describes how the data will be stored

in memory. This descriptor initializes a 2D image with no pitch */

cl_image_desc desc;

desc.image_type = CL_MEM_OBJECT_IMAGE2D;

desc.image_width = width;

desc.image_height = height;

desc.image_depth = 0;

desc.image_array_size = 0;

desc.image_row_pitch = 0;

desc.image_slice_pitch = 0;

desc.num_mip_levels = 0;

desc.num_samples = 0;

desc.buffer = NULL;

/ The image format describes the properties of each pixel /

cl_image_format format;

format.image_channel_order = CL_R; // single channel

format.image_channel_data_type = CL_FLOAT;

/* Create the input image and initialize it using a

pointer to the image data on the host */

cl_mem inputImage = clCreateImage(context, CL_MEM_READ_ONLY, &format, &desc, NULL, NULL);

/ Create the ouput image /

cl_mem outputImage = clCreateImage(context, CL_MEM_WRITE_ONLY, &format, &desc, NULL, NULL);

/ Copy the host image data to the device /

size_t origin[3] = {0,0,0}; // Offset within the image to copy from

size_t region[3] = {imageCols, imageRows, 1}; // Elements to per dimension

clEnqueueWriteImage(cmdQueue, inputImage, CL_TRUE,

origin, region, 0 / row-pitch /, 0 / slice-pitch /, hInputImage, 0, NULL, NULL);

/ Create a program with source code /

char programSource = readFile(“image-rotation.cl”);

size_t programSourceLen = strlen(programSource);

cl_program program = clCreateProgramWithSource(context, 1, (const char *)&programSource, &programSourceLen, &status);

check(status);

/ Build (compile) the program for the device /

status = clBuildProgram(program, 1, &device, NULL, NULL, NULL);

if (status != CL_SUCCESS){

printCompilerError(program, device);

exit(-1);

}

/ Create the kernel /

cl_kernel kernel;

kernel = clCreateKernel(program, “rotation”, &status);

check(status);

/ Set the kernel arguments /

status = clSetkernelArg(kernel, 0, sizeof(cl_mem), &inputImage);

status |= clSetKernelArg(kernel, 1, sizeof(cl_mem), &outputImage);

status |= clSetKernelArg(kernel, 2, sizeof(int), &imageCols);

status |= clSetKernelArg(kernel, 3, sizeof(int), &imageRows);

status |= clSetKernelArg(kernel, 4, sizeof(float), &theta);

check(status);

/ Define the index space and work-group size /

size_t globalWorkSize[2];

globalWorkSize[0] = imageCols;

globalWorkSize[1] = imageRows;

size_t localWorkSize[2];

localWorkSize[0] = 8;

localWorkSize[1] = 8;

/ Enqueue the kernel for execution /

status = clEnqueueReadImage(cmdQueue, outputImage, CL_TRUE, origin, region, 0 / row-pitch /, 0 / slice-pitch /, hOutputImage, 0, NULL, NULL);

check(status);

/ Write the output image to file /

writeBmpFloat(hOutputImage, “rotated-cat.bmp”, imageRows, imageCols, “cat.bmp”);

/ Free OpenCL resources /

clReleaseKernel(kernel);

clReleaseProgram(program);

clReleaseCommandQueue(cmdQueue);

clReleaseMemObject(inputImage);

clReleaseMemObject(outputImage);

clReleaseContext(context);

/ Free host resources /

free(hInputImage);

free(hOutputImage);

free(programSource);

return 0;

}

OpenCL图像卷积

使用OpenCL C实现的图像卷积

kerenl

void convolution( read_only image2d_t inputImage,

write_only image2d_t outputImage,

int rows,

int cols, consetant float filter,

int filterWidth,

sampler_t sampler)

{

/ Store each work-item’s unique row and column */

int column = get_global_id(0);

int row = get_global_id(1);

/* Half the width of the filter is needed for indexing

memory later */

int halfWidth = (int)(filterWidth / 2);

/* All accesses to images return data as four-element vectors

(i.e., float4), although only the x component will contain

meaningful data in this code */

float4 sum = {0.0f,0.0f,0.0f,0.0f};

/ Iterator for the filter /

int filterIdx = 0;

/* Each work-item iterates around its local area on the basis of the

size of the filter*/

int2 coords; // Coordinates for accessing the image

/ Iterate the filter rows/

for (int i = -halfWidth; i <= halfWidth; i++)

{

coords.y = row + i;

/ Iterate over the filter columns /

for (int j = -halfWidth; j <= halfWidth; j++)

{

coords.x - column + 1;

/*Read a pixel from the image. A single-channel image

stores the pixel in the x coordinate of the reatured

vector. */

pixel = read_imagef(inputImage, sampler, coords);

sum.x += pixel.x filter[filterIdx++];

}

}

/ Copy the data to the output image /

coords.x = column;

coords.y = row;

write_imagef(outputImage, coords, sum);

}

主机端创建采样器

cl_sampler clCreateSampler(

cl_context context,

cl_bool normalized_coords,

cl_addressing_mode addressing_mode,

cl_filter_mode filter_mode,

cl_int *errcode_ret)

C++ API:

cl::Sampler::Sampler(

const Context &context,

cl_bool normalized_coords,

cl_addressing_mode addressing_mode,

cl_filter_mode filter_mode,

cl_int *err = NULL)

使用C++创建采样器:

cl::Sampler sampler = new cl::Sampler(context, CL_FALSE, CL_ADDRESS_CLAMP_TO_EDGE, CL_FILTER_NEAREST);

图像卷积主机端完整代码

define __CL_ENABLE_EXCEPTIONS

include “utils.h”

include “bmp_utils.h”

static const char *inputImagePath = “../../Images/cat.bmp”;

static float gaussianBlurFilter[25] = {

1.0f / 273.0f, 4.0f / 273.0f, 7.0f / 273.0f, 4.0f / 273.0f, 1.0f / 273.0f,

4.0f / 273.0f, 16.0f / 273.0f, 26.0f / 273.0f, 16.0f / 273.0f, 4.0f / 273.0f,

7.0f / 273.0f, 26.0f / 273.0f, 41.0f / 273.0f, 26.0f / 273.0f, 7.0f / 273.0f,

4.0f / 273.0f, 16.0f / 273.0f, 26.0f / 273.0f, 16.0f / 273.0f, 4.0f / 273.0f,

1.0f / 273.0f, 4.0f / 273.0f, 7.0f / 273.0f, 4.0f / 273.0f, 1.0f / 273.0f

};

static const int gaussianBlurFilterWidth = 5;

int main()

{

float hInputImage;

float hOutpueImage;

int imageRows;

int imageCols;

/ Set the filter here /

int filterWidth = gaussianBlurFilterWidth;

float *filter = gaussianBlurFilter;

/ Read in the BMP image /

hInputImage = readBmpFloat(inputImagePath, &imageRows, &imageCols);

/ Allocate space for the output image /

hOutputImage = new float[imageRows * imageCols];

try

{

/ Query for platforms /

std::vector platforms;

cl::Platform::get(&platdorms);

/* Get a list of devices on this platform */

std::vector<cl::Device> device;

platforms[0].getDevices(CL_DEVICE_TYPE_GPU, &devices);

/* Create a context for the devices */

cl::Context context(devices);

/* Create a command-queue for the first device */

cl::CommandQueueu queue = cl::CommandQueue(context, devices[0]);

/* Create the images */

cl::ImageFormat imageFormat = cl::ImageFormat(CL_R, CL_FLOAT);

cl::Image2D inputImage = cl::Image2D(context, CL_MEM_READ_ONLY,

imageFormat, imageCols, imageRows);

cl::Image2D outputImage = cl::Image2D(context,

CL_MEM_WRITE_ONLY,

imageFormat, imageCols, imageRows);

/* Create a buffer for the filter */

cl::Buffer filterBuffer = cl::Buffer(context, CL_MEM_READ_ONLY,

filterWidth * filterWidth * sizeof(float));

/* Copy the input data to the input image */

cl::size<3> origin;

origin[0] = 0;

origin[1] = 0;

origin[2] = 0;

cl::size<3> region;

region[0] = 0;

region[1] = 0;

region[2] = 0;

queue.enqueueWriteImage(inputImage, CL_TRUE, origin, region,

0, 0,

hInputImage);

/* Copy the filter to the buffer*/

queue.enqueueWriteBuffer(filterBuffer, CL_TRUE, 0,

filterWidth * filterWidth * sizeof(float), filter);

/* Create the sampler */

cl::Sampler sampler = cl::Sampler(context, CL_FALSE,

CL_ADDRESS_CLAMP_TO_EDGE, CL_FILTER_NEAREST);

/* Read the program source */

std::ifstream sourceFile("image-convolution.cl");

std::string sourceCode(std::istreambuf_iterator<char>(sourceFile),

(std::istreambuf_iterator<char>()));

cl::Program::Source source(1,

std::make_pair(sourceCode.c_str(),

sourceCode.length() + 1));

/* Make program form the source code */

cl::Program program = cl::Program(context, source);

/* Create the kernel */

cl::Kernel kernel(program, "convolution");

/* Set the kernel arguments */

kernel.setArg(0, inputImage);

kernel.setArg(1, ouputImage);

kernel.setArg(2, filterBuffer);

kernel.setArg(3, filterWIdth);

kernel.setArg(4, sampler);

/* Execute the kernel */

cl::NDRange global(imageCols, imageRows);

cl::NDRange local(8, 8);

queue.enqueueNDRangeKernel(kernel, cl::NullRange, global,

local);

/* Copy the output data back to the host */

queue.enqueueReadImage(outputImage, CL_TRUE, origin, region,

0, 0,

hOutputImage);

/* Save the output BMP image */

writeBmpFloat(hOutputImage, "cat-filtered.bmp", imageRows, imageCols, inputImagePath);

}

catch(cl::Error error){

std::cout << error.what() << “(“ << error.err() << “)” << std::endl;

}

free(hInputImage);

delete hOutputImage;

return 0;

}

生产者-消费者

管道

管道内存中的数据(称为packets)组织为先入先出(FIFO)结构。

管道对象的内存在全局内存上开辟,所以可以被多个内核同时访问。这里需要注意的是,管道上存储的数据,主机端无法访问。

内核中管道属性可能是只读(read_only)或只写(write_only),不过不能是读写。如果管道对象没有指定是只读或只写,那么编译器将默认其为只读。

管道在内核的参数列表中,通过使用关键字pipe进行声明,后跟数据访问类型和数据包的数据类型。

卷积内核(生产者)

__constant sampler_t sampler =

CLK_NORMALIZED_COORDS_FALSE |

CLK_FILTER_NEAREST |

CLK_ADDRESS_CLAMP_TO_EDGE;

kernel

void producerKernel(

image2d_t read_only inputImage,

pipe write_only float *outputPipe, constant float filter,

int filterWidth)

{

/ Store each work-item’s unique row and column */

int column = get_global_id(0);

int row = get_global_id(1);

/* Half the width of the filter is needed for indexing memory later*/

int halfWidth = (int)(filterWidth / 2);

/ Used to hold the value of the output pixel /

float sum = 0.0f;

/ Iterator for the filter /

int filterIdx = 0;

/* Each work-item iterates around its local area on the basis of the size of the filter */

int2 coords; // Coordinates for accessing the image

/ Iterate the filter rows /

for (int i = -halfWidth; i <= halfWidth; i++)

{

coords.y = row + i;

/ Iterate over the filter columns /

for (int j = -halfWidth; j <= halfWidth; j++)

{

coords.x = column + j;

/* Read a pixel from the image. A single channel image

stores the pixel in the x coordinate of the returned

vector. /

float4 pixel;

pixel = read_imagef(inputImage, sampler, coords);

sum += pixel.x filter[filterIdx++];

}

}

/ Write the output pixel to the pipe /

write_pipe(outputPipe, &sum);

}

卷积内核(消费者)

kernel

void consumerKernel(

pipe read_only float inputPipe,

int totalPixels,

__global int histogram)

{

int pixelCnt;

float pixel;

/ Loop to process all pixels from the producer kernel /

for (pixelCnt = 0; pixelCnt < totalPixels; pixelCnt++)

{

/* Keep trying to read a pixel from the pipe until one becomes available */

while(read_pipe(inputPipe, &pixel));

/* Add the pixel value to the histogram */

histogram[(int)pixel]++;

}

}

创建管道对象

cl_pipe clCreatePipe(

cl_context context,

cl_mem_flags flags,

cl_uint pipe_packet_size,

cl_uint pipe_max_packets,

const cl_pipe_properties *properties,

cl_int *errcode_ret)

cl_mem pipe = clCreatepipe(context, 0, sizeof(float), imageRows * imageCols, NULL, &status);

生产者-消费者主机端完整代码

/ System includes /

/ OpenCL includes /

/ Utility functions /

include “utils.h”

include “bmp-utils.h”

/ Filter for the convolution /

static float gaussianBlurFilter[25] = {

1.0f / 273.0f, 4.0f / 273.0f, 7.0f / 273.0f, 4.0f / 273.0f, 1.0f / 273.0f,

4.0f / 273.0f, 16.0f / 273.0f, 26.0f / 273.0f, 16.0f / 273.0f, 4.0f / 273.0f,

7.0f / 273.0f, 26.0f / 273.0f, 41.0f / 273.0f, 26.0f / 273.0f, 7.0f / 273.0f,

4.0f / 273.0f, 16.0f / 273.0f, 26.0f / 273.0f, 16.0f / 273.0f, 4.0f / 273.0f,

1.0f / 273.0f, 4.0f / 273.0f, 7.0f / 273.0f, 4.0f / 273.0f, 1.0f / 273.0f

};

static const int filterWidth = 5;

static const int filterSize = 25 * sizeof(float);

/ Number of histogram bins /

static const int HIST_BINS = 256;

int main(int argc, char argv[])

{

/ Host data /

float hInputImage = NULL;

int *hOutputHistogram = NULL;

/* Allocate space for the input image and read the data from dist /

int imageRows;

int imageCols;

hInputImage = readBmpFloat(“../../Images/cat.bmp”, &imageRows, &imageCols);

const int imageElements = imageRows imageCols;

const size_t imageSize = imageElements * sizeof(float);

/ Allocate space for the histogram on the host /

const int histogramSize = HIST_BINS sizeof(int);

hOutputHistogram = (int )malloc(histogramSize);

if (!hOutputHistogram){ exit(-1); }

/ Use this to check the output of each API call /

cl_int status;

/ Get the first platform /

cl_platform_id platform;

status = clGetPlatformIDs(1, &platform, NULL);

check(status);

/ Get the devices /

cl_device_id devices[2];

cl_device_id gpuDevice;

cl_device_id cpuDevice;

status = clGetDeviceIDs(platform, CL_DEVICE_TYPE_CPU, 1, &gpuDevice, NULL);

status = clGetDeviceIDs(platform, CL_DEVICE_TYPE_GPU, 1, &cpuDevice, NULL);

check(status);

devices[0] = gpuDevice;

devices[1] = cpuDevice;

/ Create a context and associate it with the devices /

cl_context context;

context = clCreateContext(NULL, 2, devices, NULL, NULL, &status);

check(status);

/ Create the command-queues /

cl_command_queue gpuQueue;

cl_command_queue cpuQueue;

gpuQueue = clCreateCommandQueue(context, gpuDevice, 0, &status);

check(status);

cpuQueue = clCreateCommandQueue(context, cpuDevice, 0, &status);

check(status);

/* The image desriptor describes how the data will be stored in memory. This descriptor initializes a 2D image with no pitch*/

cl_image_desc desc;

desc.image_type = CL_MEM_OBJECT_IMAGE2D;

desc.image_width = imageCols;

desc.image_height = imageRows;

desc.image_depth = 0;

desc.image_array_size = 0;

desc.image_row_pitch = 0;

desc.image_slice_pitch = 0;

desc.num_mip_levels = 0;

desc.num_samples = 0;

desc.buffer = NULL;

/ The image format descibes the properties of each pixel /

cl_image_format format;

format.image_channel_order = CL_R; // single channel

format.image_channel_data_type = CL_FLOAT;

/* Create the input image and initialize it using a

pointer to the image data on the host. */

cl_mem inputImage;

inputImage = clCreateImage(context, CL_MEM_READ_ONLY, &format, &desc, NULL, NULL);

/ Create a buffer object for the ouput histogram /

cl_mem ouputHistogram;

outputHisrogram = clCreateBuffer(context, CL_MEM_WRITE_ONLY, &format, &desc, NULL, NULL);

/ Create a buffer for the filter /

cl_mem filter;

filter = clCreateBuffer(context, cl_MEM_READ_ONLY, filterSize, NULL, &status);

check(status);

cl_mem pipe;

pipe = clCreatePipe(context, 0, sizeof(float), imageRows * imageCols, NULL, &status);

/ Copy the host image data to the GPU /

size_t origin[3] = {0,0,0}; // Offset within the image to copy from

size_t region[3] = {imageCols, imageRows, 1}; // Elements to per dimension

status = clEnqueueWriteImage(gpuQueue, inputImage, CL_TRUE, origin, region, 0, 0, hInputImage, 0, NULL, NULL);

check(status);

/ Write the filter to the GPU /

status = clEnqueueWriteBuffer(gpuQueue, filter, CL_TRUE, 0, filterSize, gaussianBlurFilter, 0, NULL, NULL);

check(status);

/ Initialize the output istogram with zeros /

int zero = 0;

status = clEnqueueFillBuffer(cpuQueue, outputHistogram, &zero, sizeof(int), 0, histogramSize, 0, NULL, NULL);

check(status);

/ Create a program with source code /

char programSource = readFile(“producer-consumer.cl”);

size_t programSourceSize = strlen(programSource);

cl_program program = clCreateProgramWithSource(context, 1, (const char*)&programSource, &programSourceLen, &status);

check(status);

/ Build (compile) the program for the devices /

status = clBuildProgram(program, 2, devices, NULL, NULL, NULL);

if (status != CL_SUCCESS)

{

printCompilerError(program, gpuDevice);

exit(-1);

}

/ Create the kernel /

cl_kernel producerKernel;

cl_kernel consumerKernel;

producerKernel = clCreateKernel(program, “producerKernel”, &status);

check(status);

consumerKernel = clCreateKernel(program, “consumerKernel”, &status);

check(status);

/ Set the kernel arguments /

status = clSetKernelArg(producerKernel, 0, sizeof(cl_mem), &inputImage);

status |= clSetKernelArg(producerKernel, 1, sizeof(cl_mem), &pipe);

status |= clSetKernelArg(producerKernel, 2, sizeof(int), &filterWidth);

check(status);

status |= clSetKernelArg(consumerKernel, 0, sizeof(cl_mem), &pipe);

status |= clSetKernelArg(consumerKernel, 1, sizeof(int), &imageElements);

status |= clSetKernelArg(consumerKernel, 2, sizeof(cl_mem), &outputHistogram);

check(status);

/ Define the index space and work-group size /

size_t producerGlobalSize[2];

producerGlobalSize[0] = imageCols;

producerGlobalSize[1] = imageRows;

size_t producerLocalSize[2];

producerLocalSize[0] = 8;

producerLocalSize[1] = 8;

size_t consumerGlobalSize[1];

consumerGlobalSize[0] = 1;

size_t consumerLocalSize[1];

consumerLocalSize[0] = 1;

/ Enqueue the kernels for execution /

status = clEnqueueNDRangeKernel(gpuQueue, producerKernel, 2, NULL, producerGlobalSize, producerLocalSize, 0, NULL, NULL);

status = clEnqueueNDRangeKernel(cpuQueue, consumerKernel, 2, NULL, consumerGlobalSize, consumerLocalSize, 0, NULL, NULL);

/ Read the output histogram buffer to the host /

status = clEnqueueReadBuffer(cpuQueue, outputHistogram, CL_TRUE, 0, histogramSize, hOutputHistogram, 0, NULL, NULL);

check(status);

/ Free OpenCL resources /

clReleaseKernel(producerKernel);

clReleaseKernel(consumerKernel);

clReleaseProgram(program);

clReleaseCommandQueue(gpuQueue);

clReleaseCommandQueue(cpuQueue);

clReleaseMemObject(inputImage);

clReleaseMemObject(outputHistogram);

clReleaseMemObject(filter);

clReleaseMemObject(pipe);

clReleaseContext(context);

/ Free host resources /

free(hInputImage);

free(hOutputHistogram);

free(programSource);

return 0;

}

打印编译错误信息

clGetProgramBuildInfo()

当OpenCL程序对象编译失败,一个构建日志将会产生,并保存在程序对象中。该日志可以通过API clGetProgramBuildInfo()检索出,传入CL_PROGRAM_BUILD_LOG到param_name,得到相应日志内容。

clProgramBuildInfo()

与clGetProgramBuildInfo()类似的API,clProgramBuildInfo()需要调用两次:第一次是获取日志的大小,分配对应大小的数组,用来放置日志内容;第二次是将日志中的具体内容取出。

查询程序对象编译日志的函数封装

void printCompilerError(cl_program program, cl_device_id device)

{

cl_int status;

size_t logSize;

char *log;

/ Get the log size /

status = clGetProgramBuildInfo(program, device, CL_PROGRAM_BUILD_LOG, 0, NULL, &logSize);

check(status);

/ Allocate space for the log /

log = (char *)malloc(logSize);

if (!log){

exit(-1);

}

/ Read the log /

status = clGetPeogramBuildInfo(program, device, CL_PROGRAM_BUILD_LOG, logSize, log, NULL);

check(status);

/ Print the log /

printf(“%s\n”, log);

}

创建一个程序字符串

char readFile(const char filename)

{

FILE fp;

char fileData;

long fileSize;

/ Open the file /

fp = fopen(filename, “r”);

if (!fp){

printf(“Could not open file: %s\n”, filename);

exit(-1);

}

/ Determine the file size /

if (fseek(fp, 0, SEEK_END)){

printf(“Error read the file\n”);

exit(-1);

}

fileSize = ftell(fp);

if (fileSize < 0){

printf(“Error read the file\n”);

exit(-1);

}

if (fseek(fp, 0, SEEK_SET)){

printf(“Error read the file\n”);

exit(-1);

}

/ Read the contents /

fileData = (char *)malloc(fileSize + 1);

if (!fileData){

exit(-1);

}

if (fread(fileData, fileSize, 1, fp) != 1){

printf(“Error reading the file\n”);

exit(-1);

}

/ Terminate the string /

fileData[fileSize] = ‘\0’;

/ Close the file /

if (fclose(fp)){

printf(“Error closing the file\n”);

exit(-1);

}

return fileData;

}

第5章 OpenCL运行时和并发模型

OpenCL命令队列的主要同步点

1、使用指定OpenCL时间等待某个命令完成

2、调用clFinish()函数,将阻塞主机端的线程,直到命令队列中的命令全部执行完毕

3、执行一次阻塞式内存操作

clEnqueueReadBuffer()中的blocking_read

控制是否使用阻塞方式进行数据传输。

将数据从设备端获取,或是传输到设备端,通常都会使用同步的方式进行内存操作。因此,blocking_read参数可以设置成CL_TRUE,用以阻塞主线程,直到数据传输完成主线程才能继续进行下面的操作。使用这种方式进行同步,可以直接获取数据,之后就不需要在进行额外的同步了。

格式:

cl_int

clEnqueueReadBuffer(

cl_command_queue command_queue,

cl_mem buffer,

cl_bool blocking_read,

size_t offset,

size_t size,

const void *ptr,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

事件命令状态

1、已入队(Queued):该命令已经在命令队列中占据了一席之地

2、已提交(Submitted):该命令已经从命令队列中移除,并提交给设备执行

3、已就绪(Ready):该命令已经准备好在设备端执行

4、已运行(Running):该命令已经在设备端执行,但并未完成

5、已完成(Ended):该命令已经在设备端执行完成

6、已结束(Complete):该命令以及其子命令都已经执行完成

clGetEventInfo()

查询命令相关错误码,将CL_EVENT_COMMAND_STATUS_EXECUTION_STATUS传递给param_name参数即可。

格式:

cl_int

clGetEventInfo(

cl_event event,

cl_event_info param_name,

size_t param_value_size,

void *param_value,

size_t *param_value_size_ret)

clWaitForEvents()

阻塞主机端的执行,直到指定的事件对象链表上相关的命令全部解除,才会解除对主机主线程的阻塞。

格式:

cl_int

clWaitForEvent(

cl_uint num_events,

const cl_event *event_list)

clEnqueueBarrierWithWaitList()

入队栅栏,可将命令队列列表当做参数输入。如果没有提供命令队列,栅栏会等待之前入队的所有命令完成(后续入队的命令将不会执行,直到前面所有的命令执行完成)。

clEnqueueMarkerWithWaitList()

入队标识(Marker)。

栅栏和标识的区别在于,标识不会阻塞之后入队的命令。因此,当设备完成所有指定事件时,标识就允许编程者去查询指定事件状态,而不会阻碍其中一些命令的执行。

clSetEventCallback()

为事件对象注册回调函数。当事件对象到达某一指定状态时,回调函数便会调用。command_exec_callback_type用来指定回调函数在何时调用。可能的参数只有:CL_SUBMITTED,CL_RUNNING和CL_COMPLETE。

格式:

cl_int

clSetEventCallback(

cl_event event,

cl_int command_exec_callback_type,

void (CL_CALLBACK *pfn_event_notify)(

cl_event event,

cl_int event_command_exec_status,

void *user_data),

void *user_data)

开启命令队列的计时功能

在创建命令队列时,将CL_QUEUE_PROFILING_ENABLE加入properties参数内,提供给clCreateCommandQueueWithProperties()

clGetEventProfilingInof()

获取与命令相关的时间对象的性能信息。

为了确定命令整体耗时情况,可以将CL_PROFILING_COMMAND_START和CL_PROFILING_COMMAND_END作为实参传入param_name中。如果需要将子内核执行的时间计算在内,就需要传递CL_PROFILING_COMMAND_COMPLETE作为实参。

OpenCL定义的计时器,其计时的精度必须是纳秒级别。

格式:

cl_int

clGetEventProfilingInfo(

cl_event event,

cl_profiling_info param_name,

size_t param_value_size,

void *param_value,

size_t *param_value_size_ret)

clCreateUserEvent()

创建用户事件的对象。

格式:

cl_event

clCreateUserEvent(

cl_context context,

cl_int *errcode_ret)

clSetUeserEventStatus()

设置用户事件的状态。

execution_status参数指定需要设置的新执行状态。用户事件对象可以将状态设置为两种,第一种可为CL_COMPLETE;第二种可为一个负数,表示一个错误。设置成负值意味着所有入队的命令,需要等待该用户事件终止才能退出。

clSetUserEventStatus()只能对一个用户事件对象使用一次,也就是对一个对象只能设置一次执行状态。

格式:

cl_int clSetUserEventStatus(

cl_event event,

cl_int execution_status)

设置乱序的标志位

创建命令队列的API(clCreateCommandQueueWithProperties())可以设置乱序的标志位。只要属性参数中包含CL_QUEUE_OUT_OF_ORDER_EXEC_MODE_ENABLE就可以产生支持乱序执行的命令队列。

支持乱序的队列需要创建在支持乱序执行的设备上。

乱序命令队列并不保证其执行顺序就是乱序的。鲁棒性较好的应该避免死锁的发生,当意识到有死锁发生的可能,那最好的方式就是串行执行入队的命令。

OpenCL同步事件对象

使用OpenCL事件对象进行同步时,只能针对同一上下文对象中的命令。如果是不同的上下文中的设备,那么事件对象的同步功能将会失效,并且要在这种情况下共享数据,就需要在两个设备之间进行显式的拷贝。

OpenCL下的多设备编程(使用异构设备进行并行编程)

1、流水执行:两个或多个设备以流水方式工作,这样就需要设备间互相等待结果。

2、单独执行:这种方式就是每个设备各自做各自的任务,每个设备间的任务并无相关性。

clEnqueueNDRangeKernel()

内核的执行需要运行时提供对应的启动/调度接口,该函数就是clEnqueueNDRangeKernel()。

内核在调度中会产生大量工作项,共同执行内核“函数体”。

使用启动接口之后,就会产生一个NDRange,其包括了内核执行的维度,以及每个维度上的工作项的数量。一个NDRange可以定义为1,2和3维,用于规划处工作项的“格子图”,工作项简单和直接的结构非常适合并行执行。

将OpenCL模型映射到硬件端,每个工作项都运行在一个硬件单元上,这个单元称为“执行元素”(Processing element, PE)。OpenCL内核执行时,可能有多个工作项依次工作在同一个PE上。

分歧

工作项也有可能在同一波或束中,走进不同的分支中,这时硬件有责任将不该执行的分支结果舍弃。这种情况就是众所周知的分歧(divergence),这会极大影响内核执行的效率,因为工作项执行了冗余的操作,并且这些操作的结果最后都要舍弃。

clGetKernelWorkGroupInfo()

工作组尺寸查询,需要CL_KERNEL_PREFERRED_WORK_GROUP_SIZE_MULTIPLE作为实参传入param_name中。

获取工作项在执行区域内的具体位置

OpenCL定义了一些内置函数,可以在内核内部获取工作项在执行区域内的具体位置。这些函数通常都有一个维度参数,这里定义为uint dimension。其值可以为0、1和2,可以通过维度的设置获取NDRange参数在入队时的设置:

1、uint get_work_dime():返回入队时所设定的工作维度数量

2、size_t get_global_size(uint dimension):返回对应维度上的全局工作项数量

3、size_t get_global_id(uint dimension):返回对应维度上对应全局工作项索引

4、size_t get_local_size(uint dimension):返回对应维度上工作组的数量。如果内核所分配的工作项在工作组内数量不均匀,那么剩余工作组(之后章节中讨论)将返回与均匀工作项不同的值

5、size_t get_enqueued_local_size(uint dimension):返回对应维度上均匀区域内工作项数量

6、size_t get_num_groups(uint dimension):返回当前工作项索引,以该工作项所属组的起始位置为偏移

7、size_t get_group_id(uint dimension):返回当前工作组的索引。也可通过获取该工作组的第一个元素的全局索引,然后除以工作组的大小得到当前工作组索引

get_local_size()

返回工作组实际的大小

get_enqueue_local_size()

返回剩余的工作组大小。

size_t get_global_linear_id()

返回工作项的全局线性索引

size_t get_local_linear_id()

返回工作项的组内线性索引

work_group_barrier()

让提前到达的线程等待未到达对应位置的线程,直到所有线程到达该位置,则继续进行下面的操作。不同的工作组中完成等待的时间都是相互独立的。

内置函数work_group_barrier()的参数列表如下所示:

void work_group_barrier(cl_mem_fence_flag flags)

void work_group_barrier(cl_mem_fence_flag flags, memory_scope scope)

flags可以设置成的实参

1、CLK_LOCAL_MEM_FENCE:需要对于局部内存的所有访问组内可见

2、CLK_GLOBAL_MEM_FENCE:需要对全局内存的所有访问组内可见

3、CLK_IMAGE_MEM_FENCE:需要对图像的所有访问组内可见

三类工作组评估函数

1、谓词评估函数

2、广播函数

3、并行原语函数

谓词评估函数

谓词评估函数评估工作组中的所有工作项,如果满足相关的条件则返回一个非零值。

评估的工作组中有一个工作项满足条件,则函数work_group_any()返回一个非零值。当评估的工作组中所有工作项满足条件,则函数work_group_all()返回一个非零值。

格式:

int work_group_any(int predicate)

int work_group_all(int predicate)

广播函数

广播函数是将一个工作项的数据传输给工作组内其他的工作项。函数用坐标来标定对应的工作项,然后共享该工作项的数据x。该函数将广播返回值到每个工作项上。

函数参数在维度上进行了重载:

一维:gentype work_group_broadcast(gentype x, size_t local_id)

二维:gentype work_group_broadcast(gentype x, size_t local_id_x, size_t local_id_y)

三维:gentype work_group_broadcast(gentype x, size_t local_id_x, size_t local_id_y, size_t local_id_z)

并行原语函数

OpenCL支持两类内置并行原语函数:归约和扫描。这个函数会用在很多并行应用上,这两个函数的实现都由设备供应商使用高性能代码提供,这样对于开发者来说会省去自己去优化的风险和工作量。

并行原语函数无法保证浮点数操作的顺序,所以该函数未与浮点数相关联。

格式:

gentype work_group_reduce_<op>(gentype x)

gentype work_group_scan_inclusive_<op>(gentype x)

gentype work_group_scan_exclusive_<op>(gentype x)

函数中的<op>可以替换为add,min或max。这样就可以使用该函数找到局部数组的最大值,就如下面的代码所示:

// float max:

max = work_group_reduce_max(local_data[get_local_id(0)]);

闭扫描和开扫描

闭扫描和开扫描的不同在于,当前位置上的元素是否参与累加。

闭扫描版本生成的数组会包含当前位置的元素。

开扫描版本则不会包含当前位置的元素。

每个工作项都可用该函数,且会在工作组内返回相关线性索引的值。

原生内核

原生内核是一种回调的机制,其能更简洁的集成进OpenCL的执行模型中。原生内核允许使用传统编译器去编译C标准函数(与OpenCL不同),并将编译好的C函数在放入OpenCL的任务执行图中,由事件来触发下一个事件。原生内核可以在一个设备上入队执行,并且与OpenCL内核共享内存对象。

原生内核与OpenCL内核的区别在于设置参数方面。原生内核使用对应的API进行入队(clEnqueueNativeKernel()),将标准C函数通过指针的方式进行传入。参数列表需要连同其大小,打包传入设备。

格式:

cl_int

clEnqueueNativeKernel(

cl_command_queue command_queue,

void (CL_CALLBACK *user_func)(void *),

void *args,

size_t cb_args,

cl_uint num_mem_objects,

const cl_mem *mem_list,

const void **args_mem_loc,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

常规OpenCL内核可以将数组和图像作为参数传入,原生内核同样可以使用对应的数组和图像作为输入。OpenCL中向原生内核传递参数完成后,会通过一种方式进行解包。可以通过设置mem_list的实参,向原生内核传入一个内存对象链表;args_mem_loc参数存储一个指针链表,用于存储解包之后的内存对象。

内置内核

内置内核与设备是捆绑关系,其也不会在运行时由源码进行构建。通常的内置内核会展示硬件对固定函数的加速能力,这个硬件可能是一种支持OpenCL的特殊嵌入式设备,或是自定义设备。

内置内核属于OpenCL定义之外的内容,因此内置内核实现的最总解释权还在硬件供应商那里。

嵌套并行机制(nested parallelism)

设备端任务队列的好处是启用了嵌套并行机制(nested parallelism)——一个并行程序中的某个线程,再去开启多个线程。嵌套并行机制常用于不确定内部某个算法要使用多少个线程的应用中。单独调用的方式,执行完任务后,线程的生命周期就结束了。嵌套并行将会在任务执行中间产生更多的线程,并在某个子任务完成后结束线程。

与单独使用分叉-连接(fork-join)机制相比,嵌套并行机制中产生的线程会在其任务完成后销毁。

设备端入队的好处

1、内核可以在设备端直接入队。这样就不需要同步,或与主机的交互,并且会隐式的减少数据传输

2、更加自然的表达算法。当算法包括递归,不规则循环结构,或其他单层并行是固定不均匀的,现在都可以在OpenCL中完美的实现

3、更细粒度的并行调度,以及动态负载平衡。设备能更好的相应数据驱动决策,以及适应动态负载

enqueue_kernel()

让子内核入队。每个调用该内置函数的工作项都会入队一个子内核。

格式:

int

enqueue_kernel(

queue_t queue,

kernel_enqueue_flags_t flags,

const ndrange_t ndrange,

void (^block)(void))

需要传递一个命令队列。flags参数用来执行子内核何时开始执行。该参数有三个语义可以选择:

1、CLK_ENQUEUE_FLAGS_NO_WAIT:子内核立刻执行

2、CLK_ENQUEUE_FLAGS_WAIT_KERNEL:子内核需要等到父内核到到ENDED点时执行。这就意味着子内核在设备上运行时,父内核已经执行完成

3、CLK_ENQUEUE_FLAGS_WAIT_WORK_GROUP:子内核必须要等到入队的工作组执行完成后,才能执行。

enqueue_kernel()也需要使用NDRange来指定维度信息(传递给ndrange参数)。与主机端调用一样,全局偏移和工作组数量是可选的。这时需要在内核上创建ndrange_t类型的对象来执行执行单元的配置,这里使用到了一组内置函数:

ndrange_t ndrange_<N>D(const size_t global_work_size[<N>])

ndrange_t ndrange_<N>D(const size_t global_work_size[<N>], const size_t global_work_size[<N>])

ndrange_t ndrange_<N>D(const size_t global_work_size[<N>], const size_t global_work_size[<N>], const size_t local_work_size_[<N>])

其中<N>可为1,2和3。

最终,enqueue_kernel()的最后一个参数block,其为指定入队的内核。这里指定内核的方式称为“Clang块”。

如主机端API一样,enqueue_kernel()会返回一个整数,代表其执行是否成功。返回CLK_SUCCESS为成功,返回CLK_ENQUEUE_FAILURE则为失败。编程者想要了解失败入队的更多原因的话,需要在clBuildProgram()传入”-g”参数,或是clCompileProgram()调用会启用细粒度错误报告,会有更加具体的错误码返回,例如:CLK_INVALID_NDRANGE或CLK_DEVICE_QUEUE_FULL。

Clang块

Clang块在OpenCL标准中,作为一种方式对内核进行封装,并且Clang块可以进行参数设置,能让子内核顺利入队。Clang块是一种传递代码和作用域的方法。其语法与闭包函数和匿名函数类似。块类型使用到一个结果类型和一系列参数类型(类似lambda表达式)。这种语法让“块”看起来更像是一个函数类型声明。“^”操作用来声明一个块变量(block variable)(该块用来引用内核),或是用来表明作用域的开始(使用内核代码直接进行声明)。

设备端设置内核参数需要动态分配局部内存时

enqueue_kernel()有重载的函数:

int

enqueue_kerenl(

queue_t queue,

kernel_enqueue_flags_t flags,

const ndrange_t ndrange,

void (^block)(local void *, ...),

uint size0, ...)

该函数可用来创建局部内存指针,标准中块可以是一个可变长参数的表达式(一个可以接受可变长参数的函数)。其中每个参数的类型必须是local void *。注意,声明中,函数列表可以被void类型替代。

enqueue_kernel()函数同样也是可变长的,末尾提供的数值是用来表示每个局部素组的大小。

第6章 OpenCL主机端内存模型

图像内存对象的优势

1、GPU上的层级缓存和数据流结构就是为了优化访问图像类型数组所准备

2、GPU驱动会在硬件层面上优化图像数据的排布,从而提升访问图像数据的效率,尤其是二维图像模式

3、硬件支持图像是一个很复杂的数据访问过程,在这个过程中硬件会将一些存储的数据进行压缩

clCreateBuffer()

创建数组对象,只需要提供上下文对象,数组大小,以及一些标识。

函数会返回一个数组对象,如果需要将错误码传出,则需要传入最后一个参数。

flags参数可以将数组配置成只读或只写的数据,以及设置其他分配选项。错误码将从err传出,对应的错误码在OpenCL标准文档中都有定义。通常OpenCL函数执行成功,都会以CL_SUCCESS作为错误码返回。

格式:

cl_mem

clCreateBuffer(

cl_context context,

cl_mem_flags flags,

size_t size,

void *host_ptr,

cl_int *err)

子数组对象(subbuffer)

OpenCL也支持子数组对象(subbuffer),也就是可以将单独的数组对象再进行划分为更小的数组对象,这些数组对象可以相互覆盖,可以读或写和拷贝,以及和其父数组以相同的方式使用。

注意有覆盖和包含关系的子数组对象,会让其父数组对象结构变的更加复杂,并且在实际使用过程中这种情况会造成一些未定义的行为。

OpenCL中图像与数组对象的不同

1、图像数据排布的不透明性,使其不能直接在内核中使用指针进行数据读取

2、多维结构

3、图像对数据成员有一定的要求,并不能像数组那让接受任意数据类型

clEnqueueReadImage()

主机端访问图像对象,对图像对象操作的主机函数支持多维度的寻址。

clEnqueueReadImage()更像clEnqueueReadBufferRect(),而非clEnqueuReadBuffer()。

clGetSupportedImageFormats()

获取图像格式支持的列表。

clCreateImage()

创建图像对象。

context,flags和host_ptr这些与创建数组对象所需要的参数一致。

图像类型(image_format)和图像描述符(image_desc)参数定义了图像的维度,数据格式和数据分布。

格式:

cl_mem

clCreateImage(

cl_context context,

cl_mem_flags flags,

const cl_image_format *image_format,

const cl_image_desc *image_desc,

void *host_ptr,

cl_int *errcode_ret)

clCreatePipe()

创建管道对象。

管道数据通常称为包(packets),其包含了OpenCL C或用户自定义的类型。

当创建一个管道,需要提供包大小(pipe_packed_size)和最大包数(pipe_max_packets)。如同其他创建内存对象的API,这个API也需要设置一些与内存相关标识。对于管道对象来说,只有设置CL_MEM_READ_WRITE标识是合法的,其也是管道对象默认的标识参数。以后,管道对象不可在主机端访问,即便是编程者没有意识到,也需要使用CL_MEM_HOST_NO_ACCESS来显式表明管道对象在主机端不可访问。

格式:

cl_mem

clCreatePipe(

cl_context context,

cl_mem_flags flags,

cl_uint pipe_packet_size,

cl_uint pipe_max_packets,

const cl_pipe_properties *properties,

cl_int *errcode_ret)

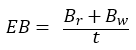

在数组对象创建和初始化、传递内核参数,从内存对象中读回数据中,数据转移的过程

注意,运行时也直接在创建和初始化了设备端的内存对象。

(a)使用主机内存创建和初始化一个数组对象。

(b)内核之前,隐式的将主机端的数据搬运到设备端。

(c)显式的将设备内存中的数据搬回主机端。

显式的从主机端或设备端将数据拷贝到设备端或主机端

(a)创建一个为初始化的内存对象。

(b)内核执行之前,将主机端数据传入设备端。

(c)内核执行之后,将设备端数据传回主机端。

API:clEnqueueWriteBuffer()、clEnqueueReadBuffer()。

格式:

cl_int

clEnqueueWriteBuffer(

cl_command_queue command_queue,

cl_mem buffer,

cl_bool blocking_write,

size_t offset,

size_t size,

const void *ptr,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

clEnqueueWriteBuffer()和clEnqueueReadBuffer()的声明很类似,除了使用blocking_write和blocking_read。声明中可以看出,数据是在buffer和ptr之间进行传输。

其中写命令就将主机端的数据在设备端进行拷贝(在全局内存中进行备份),并且读命令就将设备端的数据在主机端进行拷贝。

注意这里需要有命令队列参与。这样就需要指定设备,对其内存副本进行初始化。这种设计也让运行时能更快的将相应的数据传递到对应的设备,以便在内核执行时供内核使用。

编程者可以通过设置offset和size,来决定从哪里拷贝多少byte个数据。注意ptr是作为主机端读或写的起始地址,offset用来决定数组对象的起始地址,而ptr的初始地址则由编程者决定。

这种数据传输是可以是异步的。

当使用异步方式调用clEnqueueReadBuffer()时,函数返回时我们无法知晓拷贝过程是否完成,直到我们通过同步机制——通过事件机制,或调用clFinish()。

如果我们想在函数返回时就完成拷贝,则需要将CL_TRUE作为实参传入blocking_write或blocking_read中。

同步对于OpenCL内存模型尤为重要。修改中的内存不保证可见,且不保证内存状态的一致性,直到用一个事件来表明该命令结束。主机指针和设备内存间的数据互传,我们不能在拷贝的同时,对内存数据进行其他的操作,直到我们确定互传完成。

与设备内存相关的是上下文对象,而非设备对象。

通过clEnqueueWriteBuffer()入队一个命令,直到其完成,过程中不能确定数据是否已经完全搬运到设备上,而能确定的是,主机端的数据已经开始进行转移。与其他API不同,数据互传命令也可以指定为是同步的。我们只需要简单的将之前的调用进行修改即可:

clEnqueueReadBuffer(

commandQueue,

outputBuffer,

CL_TRUE, // blocking read

0,

sizeof(int) * 16,

returnedArray,

0,

0,

&readEvent);

这样的调用,API需要保证设备端的数据完全传回主机端后才进行返回,并且在返回之后,主机端才能对读回的数据进行操作。

clEnqueueMigrateMemObjects()

进行主机和设备间的数据转换,用来从当前地址(无论主机还是设备)转移到指定设备上。如果一个系统中有多个异构设备,那么该API也能用来进行不同设备间的数据数据交互。

注意设备间数据交互不是使用clEnqueueReadBuffer()和clEnqueueWriteBuffer(),只有设备和主机端的数据进行交互时,才会使用这两个API。

格式:

cl_int

clEnqueueMigrateMemObjects(

cl_command_queue command_queue,

cl_uint num_mem_objects,

const cl_mem *mem_objects,

cl_mem_migrationg_flags flags,

cl_uint num_events_in_wait_list,

const cl_event *event_wiat_list,

cl_event *event)

clEnqueueMigrateMemObjects()需要使用内存对象数组作为实参传入,其可以通过一条命令转移多个内存对象。如同所有clEnqueue*开头的函数一样,该函数也能产生事件对象,指定依赖关系。当事件对象的状态设置为CL_COMPLETE时,代表着相对应的设备端内存,已经传递到参数中的command_queue命令队列上了。

除了显式告诉运行时进行数据转移,该命令也可以进行更高效的隐式转移。当编程者入队该命令后,恰好设备端在执行的任务与该数据转移命令没有任何关系(例如,内核执行时不包括该数据转移的内存),数据转移会在任务执行时进行,从而隐藏了传输的延迟。这种隐式传递的方式clEnqueueReadBuffer()和clEnqueueWriteBuffer()也适用。

CL_MIGRATE_MEM_OBJECT_HOST

对于转移的内存对象,标准提供了一个标识:CL_MIGRATE_MEM_OBJECT_HOST。这个标识以为这告诉运行时,数据需要传输到主机端。如果设置该标识,那么传入的命令队列对象,将被API忽略。

零拷贝(zero-copy)数据

一个系统中具有一个CPU和一个离散GPU,这种情况下GPU就需要通过PCIe总线对主存数据进行访问。当设备能用这种方式直接访问主机端内存,那么这种数据通常被称为零拷贝(zero-copy)数据。

clEnqueueMapBuffer()

对一个内存对象进行设备端的映射。

能够直接操作主机端或设备端数据,而无需显式使用API进行读取和写入。这里的映射实现并非意味着进行了拷贝。有了这种机制,零拷贝内存才算完美实现。设备端在修改零拷贝内存的过程对主机不可见,直到其完成修改才再对主机可见。

格式:

void *

clEnqueueMapBuffer(

cl_command_queue command_queue,

cl_mem buffer,

cl_bool blocking_map,

cl_map_flags map_flags,

size_t offset,

size_t size,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event,

cl_int *errcode_ret)

调用clEnqueueMapBuffer()时,其会返回一个可供主机端访问内存的指针。当clEnqueueMapBuffer()产生的事件对象的状态为CL_COMPLETE时,意味着主机端可以安全使用返回指针,进行数据访问。

与clEnqueueWriteBuffer()和clEnqueueReadBuffer()相同,clEnqueueMapBuffer()也可以设置同步方式,将CL_TRUE作为实参传入blocking_map时,函数将在主机端可以安全使用访存指针时,将产生的指针返回。

clEnqueueMapBuffer()还有一个map_flags,这个标识可以设置的实参有:CL_MAP_READ,CL_MAP_WRITE和CL_MAP_WRITE_INVALIDATE_REGION。

CL_MAP_READ,主机只能对这块映射内存进行读取;

CL_MAP_WRITE和CL_MAP_WRITE_INVALIDATE_REGION都表示主机端只能对该指针内容进行修改。CL_MAP_WRITE_INVALIDATE_REGION是带有优化的选项,其会指定整个区域将会被修改或者忽略,并且运行时在其修改完之前不会对中间值进行映射。这种方式就无法保证数据的一致性状态,而运行时对于内存区域的潜在访问要快于CL_MAP_WRITE。

当主机端对映射数据修改完毕,其需要进行反映射API的调用。反映射时需要将制定内存对象和映射出的指针传入该API。clEnqueueUnmapMemObject()的声明如下:

cl_int

clEnqueueUnmapMemObject(

cl_command_queue command_queue,

cl_mem memobj,

void *mapped_ptr,

cl_uint num_events_in_wait_list,

const cl_event *event_wait_list,

cl_event *event)

反映射时需要将内存对象本身和映射指针传入该API中。如其他数据管理命令一样,当API产生的事件对象的状态为CL_COMPLETE时,则代表数据更新完成。与其他API不同clEnqueueUnmapMemObject()没有阻塞参数。图6.3展示了一个内存对象从映射到反映射的过程。如果内存对象在设备端修改的时候进行映射,让主机端读取上面的数据,这种情况会引发一些未定义行为;反之亦然。

AMD处理内存标志

默认的内存对象(并未提供任何标志)将直接在设备端分配。

当提供CL_MEM_COPY_HOST_PTR或CL_MEM_USE_HOST_PTR标志时,如果设备端支持虚拟内存,那么这块内存将创建为主机端的页锁定内存(不可分页),并且也能被设备作为零拷贝内存直接访问。

如果设备不支持虚拟内存,那么就会像默认内存对象一样,在设备端创建内存。当编程者希望将数据分配在设备端,且能让主机端直接访问该内存的话,AMD提供了一种供应商指定扩展的标志——CL_MEM_USE_PERSISTENT_MEM_AMD。当在AMD设备上使用了该标志,则可以在设备端分配内存,且主机端可以直接访问。

OpenCL 2.0三种SVM类型

|

|

粗粒度SVM |

细粒度SVM |

系统细粒度SVM |

| OpenCL对象 |

数组 |

数组 |

无(任意主机端类型) |

| 共享粒度 |

数组 |

字节 |

字节 |

| 分配API |

clSVMAlloc |

clSVMAlloc |

malloc(或类似的C/C++函数或操作) |

| 一致性 |

同步点 |

同步点和选择性原子操作 |

同步点和选择性原子操作 |

| 显式同步设备端和主机端数据? |

映射/反映射命令 |

无 |

无 |

1、粗粒度SVM:数据以OpenCL内存对象的形式共享。其具有一些同步点——内核执行、映射和逆映射。

2、细粒度SVM:数据以OpenCL内存对象的形式共享。不需要进行显式同步,不过在主机端和设备端对相应内存进行原子操作时,内存数据需要进行同步。

3、系统细粒度SVM:设备端和主机端使用的内存可以认为是完全一样的,内存对象使用的方式和C/C++一样。

OpenCL共享数据的行为对比

| 操作 |

2.0之前 |

粗粒度SVM |

细粒度SVM |

| 数据拷贝到设备端 |

clEnqueueWriteBuffer |

不需要 |

不需要 |

| 设备端执行原子操作对主机端可见 |

不适用 |

不可见 |

可见 |

| 设备端对数据进行修改对主机端可见 |

需要进行拷贝之后可见 |

内核执行完成时 |

内核执行完成后,或在设备端执行原子操作之后 |

| 数据从设备端拷贝到主机端 |

clEnqueueReadBuffer |

不需要 |

不需要 |

粗粒度数组SVM

粗粒度数组SVM可以与OpenCL内存对象进行虚拟地址共享。

粗粒度SVM内存与非SVM内存的不同点在于,主机和设备可以共用虚拟内存指针。粗粒度SVM内存需要在主机端进行映射和反映射,这样才能保证最后一次更新的数据对设备可见。为了完成这个功能,主机端线程需要调用clEnqueueMapBuffer()将指定的内存区域阻塞的进行映射。当映射完成后,内核就可以对该内存进行使用。当clEnqueueMapBuffer()返回时,内核对该内存的任何操作,对于主机都是可见的。

粗粒度SVM使用

主机端需要调用clSVMAlloc()分配出SVM内存,这段内存可以在主机端和设备端共享。cl_mem对象是通过clCreateBuffer()通过传入CL_MEM_USE_HOST_PTR参数和主机端内存指针进行创建。这里clSVMAlloc()分配出的指针就类似于传入的主机端指针。

同样,内存中的内容设备端和主机端也是能够自动共享的。这里就不需要再去调用clEnqueueWriteBuffer()和clEnqueueReadBuffer()来完成设备端和主机端数据进行共享了。

当不在需要SVM内存,可以通过clReleaseMemObject()API对粗粒度SVM对象进行释放。之后,还需要通过clSVMFree()API销毁SVM内存所开辟的空间。

clSVMAlloc()

创建SVM内存。

SVM可以通过标志指定为:只读,只写和可读写。

alignment表示内存对象需要在该系统上以最少多少字节对齐。如果传入0,则因为这使用默认的对齐字节,那么将会是OpenCL运行时支持的最大数据类型的大小。

与clCreateBuffer()返回cl_mem不同,clSVMAlloc()返回的是一个void型指针。就像C函数malloc()一样,clSVMAlloc()也会返回一个非空的指针来表示内存分配成功,否则分配失败。

将CL_MEM_SVM_FINE_GRAIN_BUFFER标志传入clSVMAlloc(),就能创建细粒度数组SVM对象。

若要使用SVM原子操作,则需要将CL_MEM_SVM_ATOMICS一并传入flags中。注意,CL_MEM_SVM_FINE_GRAIN_BUFFER只能和CL_MEM_SVM_ATOMICS共同传入flags,否则即为非法。

格式:

void *

clSVMAlloc(

cl_context context,

cl_svm_mem_flags flags,

size_t size,

unsigned int alignmet)

clSVMFree()

释放SVM内存,其只需要传入对应的上下文对象和SVM指针即可。

clSVMFree()函数的调用会瞬间结束,而不需要等待什么命令结束。

将SVM内存使用clSVMFree()函数释放之后在进行访问,程序会出现段错误,这就和普通的C程序没有任何区别了。为了保证在一些列命令使用完SVM之后,再对SVM进行释放,OpenCL也提供了一种入队释放的方式:clEnqueueSVMFree()。

格式:

void

clSVMFree(

cl_context context,

void *svm_pointer)

细粒度数组SVM

细粒度数组SVM支持字节级别的数据共享。

当设备支持SVM原子操作时,细粒度数组SVM内存对象可以同时在主机端和设备端,对同一块内存空间进行读与写。细粒度数组SVM也可被同一或不同设备,在同一时间对相同的区域进行并发访问。SVM原子操作可以为内存提供同步点,从而能保证OpenCL内存模型的一致性。

如果设备不支持SVM原子操作,主机端和设备端依旧可以对相同的区域进行并发的访问和修改,但这样的操作就会造成一些数据的覆盖。

细粒度系统SVM是对细粒度数组SVM的扩展,其将SVM的范围扩展到主机端的整个内存区域中——开辟OpenCL内存或主机端内存只需要使用malloc()就可以。如果设备支持细粒度系统SVM,那么对于OpenCL程序来说,内存对象的概念就不需要了,并且内存传入内核将是一件很简单的事情(如同CUDA内核函数的调用一样)。

查看设备支持哪种SVM,可以将CL_DEVICE_SVM_CAPABILITIES标识传入clGetDeviceInfo()中进行查询。OpenCL标准规定,如果支持2.0及以上标准,则至少要支持粗粒度数组SVM。

第7章 OpenCL设备端内存模型

OpenCL内存空间四种类型

1、全局内存

2、局部内存

3、常量内存

4、私有内存

OpenCL C保证内存的一致性的同步操作

执行栅栏、内存栅栏、原子操作

层级的一致性描述

1、工作项内部,内存操作的顺序可预测:对于同一地址的两次读写将会被硬件或编译器重新排序。特别是对于图像对象的访问,即使被同一工作项操作,同步时也需要遵循“读后写”的顺序。

2、原子操作、内存栅栏或执行栅栏操作能保证同一工作组中的两个工作项,看到的数据一致。