Pan-Sharpening Based on Transformer With Redundancy Reduction

(基于冗余缩减变换的全色锐化算法)

基于深度神经网络(DNN)的泛锐化方法已经产生了最先进的结果。然而,在全色(PAN)图像和低空间分辨率多光谱(LRMS)图像的共同信息没有得到充分的探讨。由于PAN和LRMS图像是从同一场景采集的,因此除了它们各自的独特信息之外,它们之间还存在一些共同信息。提取的特征的直接级联导致特征空间中的一些冗余。为了减少特征间的冗余,充分利用源图像的全局信息,提出了一种卷积神经网络与Transformer相结合的泛锐化方法。具体地,PAN和LRMS图像通过由卷积块和Transformer块组成的子网络被编码为独特特征和共同特征。然后,将共同特征平均并与来自源图像的独特特征组合以用于融合图像的重构。为了提取准确的共同特征,平等的施加约束在他们身上。实验结果表明,该方法优于最先进的方法在缩小规模和全尺寸的数据集。

介绍

星载成像传感器获取的遥感图像可以为观测场景提供丰富的空间和光谱信息。然而,在空间和光谱分辨率之间的权衡下,我们只能获得低空间分辨率的多光谱(LRMS)图像和全色(PAN)图像。为了产生高空间分辨率多光谱(HRMS)图像,采用全色锐化技术来融合LRMS和PAN图像以合成HRMS图像。

在过去的几十年中,已经提出了大量的泛锐化方法,它们可以分为四类:基于分量替换(CS)的方法、基于多分辨率分析(MRA)的方法、基于模型的方法和基于深度学习(DL)的方法。基于分量替换(CS)的方法,通过特定变换将LRMS图像分离为空间分量和光谱分量。然后,LRMS图像的空间分量被对应的PAN图像替换。最后,利用逆变换合成融合图像。基于MRA的方法,从PAN图像中提取空间细节,然后将其注入上采样的LRMS图像中以产生HRMS图像。与基于CS和基于MRA的方法不同,基于模型的方法假设LRMS和PAN图像分别是HRMS图像在空间域和谱域中的退化结果。HRMS图像是通过在各种先验的正则化下求解空间和光谱退化模型得到的。

近年来,基于深度神经网络(DNN)的泛锐化方法已被广泛研究,以利用DNN强大的非线性能力。例如,Masi等人首先提出了一种泛锐化神经网络(PNN),其中使用具有三层架构的卷积神经网络(CNN)来产生泛锐化MS图像。随后,通过引入不同的损失函数和残差学习,开发了一些高级版本的PNN。Cai和Huang构建了多尺度残差模块,以更好地保留HRMS图像中的空间结构。此外,Xu等人提出了一种基于梯度投影的PNN(GPPNN)。根据空间和光谱退化模型的优化策略设计网络。此外,生成对抗网络(GAN)也被认为是泛锐化任务。例如,Diao等人采用多尺度生成器和鉴别器之间的对抗游戏来生成HRMS图像。此外,Liu等人提出了一种双流融合网络(TFNet),用于提取PAN和LRMS图像中的特征。虽然双流网络可以有效地从源图像中提取的特征,从两个子网络的特征之间的冗余被忽略。由于PAN和LRMS图像是从同一场景捕获的,因此它们往往具有一些共同的特征,例如轮廓和形状。此外,由于PAN和LRMS图像是由不同的成像传感器获得的,因此它们也具有各自的特征。例如,LRMS图像的独特特征记录光谱信息。PAN图像中的空间细节可以被视为其独特的特征。根据分析,公共信息也将同时包含在从PAN和LRMS图像提取的子网络的特征。因此,公共信息在这些特性将导致信息冗余,这削弱了融合图像的质量。

此外,现有的基于CNN的泛锐化方法集中在PAN和LRMS图像中的局部结构的建模。最近,视觉变换器(ViT)已经被改进以通过利用自注意机制来探索图像中的全局属性,但是ViT 具有与图像大小成二次的计算复杂度。为了降低ViT的计算复杂度,提出了具有移位窗口的变换器(Swin Transformer),其中在局部窗口内实现自注意的计算。因此,Swin Transformer的计算复杂度与图像大小呈线性关系,目前正被用作许多计算机视觉任务的骨干。

为了减少子网络中特征间的冗余性,获取源图像的全局信息,提出了一种基于冗余减少变换器的泛锐化网络(TRRNet),该网络通过对公共信息的等式约束来实现。

贡献

1)我们利用CNN中的局部特征和变压器中的全局依赖性,设计了一个由卷积块和Swin Transformer块组成的新网络,用于PAN和LRMS图像的特征提取。

2)我们将每个源图像的特征图分为两部分:共同特征和独特特征。通过对来自PAN和LRMS图像的共同特征进行平均,减轻了特征之间的冗余。

方法

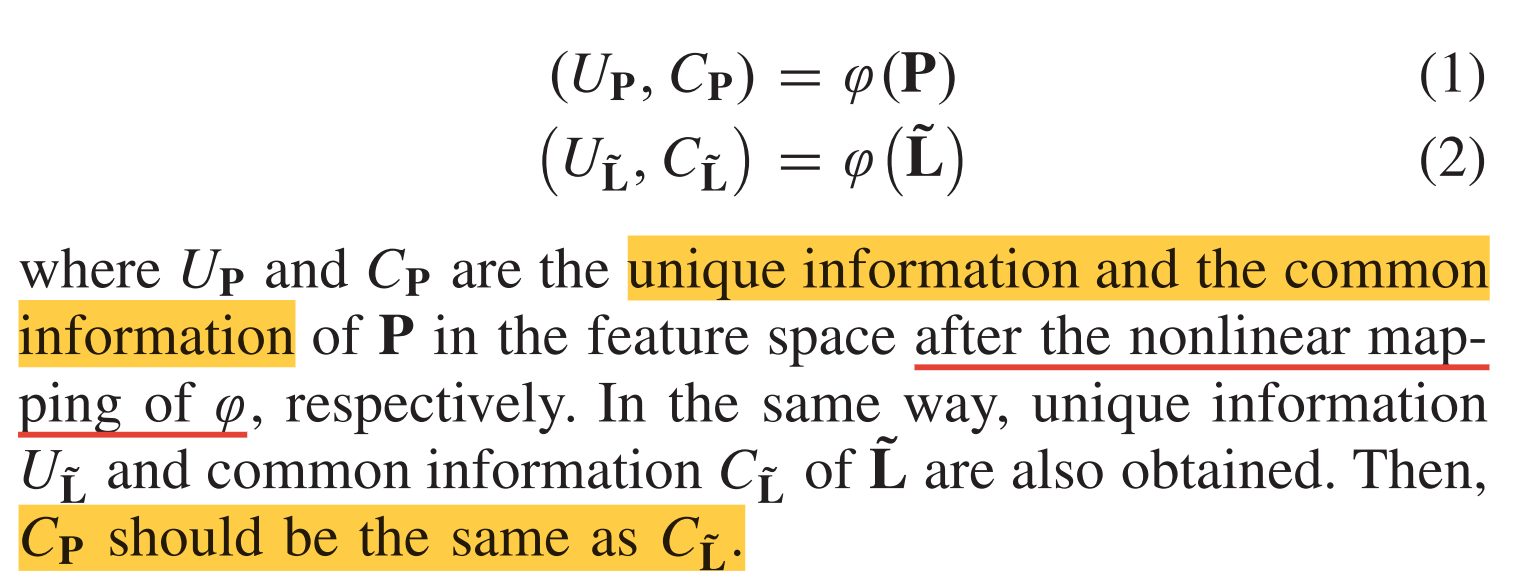

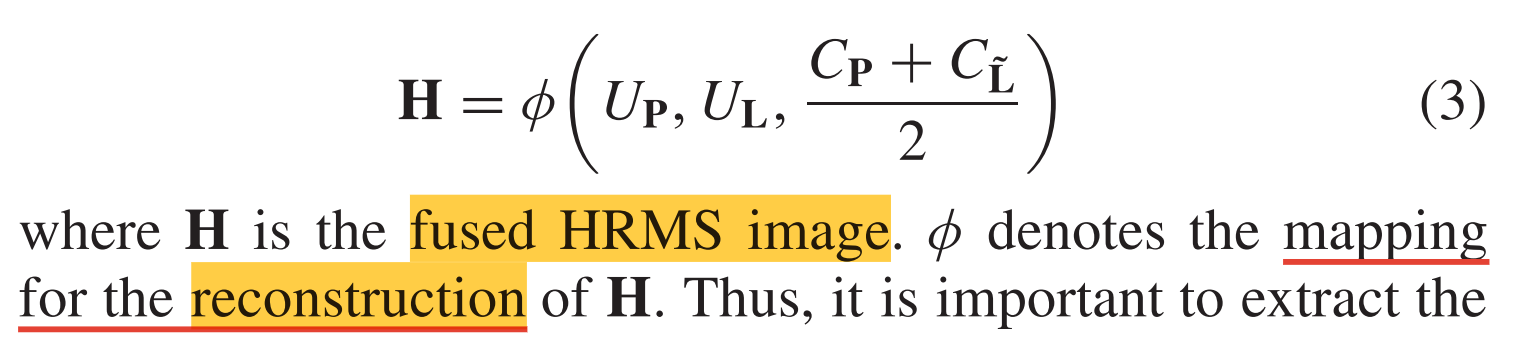

我们将LRMS图像和PAN图像分别表示为L ∈ R h × w × B R^{h×w×B} Rh×w×B和P ∈ R H × W R^{H×W} RH×W。h和w是LRMS图像的空间大小。b是LRMS图像中的条带数。H = rh和W = rw。r代表LRMS和PAN图像之间的空间分辨率的比率。在基于DNN的泛锐化方法中,L通常被上采样到PAN图像的大小。上采样的LRMS图像由L ~ ∈ R H × W × b R^{H×W×b} RH×W×b表示。由于PAN图像和LRMS图像是从同一场景采集的,它们之间除了各自的独特信息之外,还存在一些共同的信息。根据这一假设,在特征空间中将PAN和LRMS图像划分为共同信息和唯一信息。我们将公式写成

基于DNN的泛锐化方法使用DNN作为用于特征提取的非线性映射。然后,来自PAN和LRMS图像的特征被直接连接以用于HRMS图像的重建。然而,共同的信息都在PAN和LRMS图像的特征内。直接拼接会使PAN图像和LRMS图像的特征之间的共同信息在拼接后的特征中重复出现,导致特征之间的冗余。为了减少连接特征中的冗余,我们在特征空间中平均来自PAN和LRMS图像的公共信息,并将它们的唯一信息组合起来以生成HRMS图像。然后,公式被写为

因此,重要的是从PAN和LRMS图像中提取特征,并将其划分为公式下的共同和独特信息。

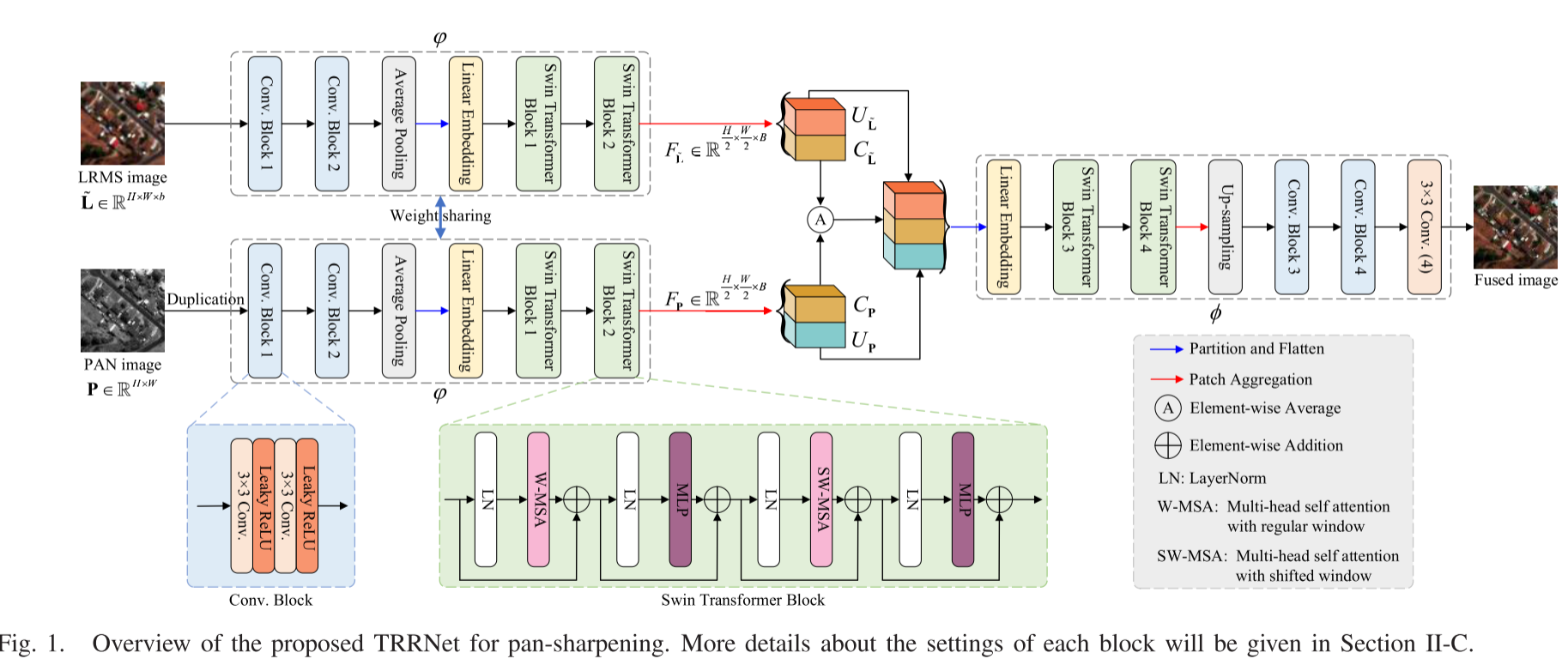

Network Framework

图1展示出了所提出的TRRNet的架构。如图1所示,设计了由卷积块和Swin Transformer块组成的两个子网络,以实现从PAN和LRMS图像中有效提取特征。建立重建网络Φ以生成期望的HRMS图像。

PAN和LRMS图像共享相同的子网和网络参数。当通过相同的子网络从PAN和LRMS图像提取特征时,Swin Transformer块2的输出被整形以获得FP ∈ R ( H / 2 ) × ( W / 2 ) × B R^{(H/2)×(W/2)×B} R(H/2)×(W/2)×B和F~ L ∈ R ( H / 2 ) × ( W / 2 ) × B R^{(H/2)×(W/2)×B} R(H/2)×(W/2)×B。FP和F~ L分别对应于PAN和LRMS图像的特征。在所提出的TRRNet中,我们根据经验将FP划分为公共特征CP ∈ R ( H / 2 ) × ( W / 2 ) × ( B / 2 ) R^{(H/2)×(W/2)×(B/2)} R(H/2)×(W/2)×(B/2)和唯一特征UP ∈ R ( H / 2 ) × ( W / 2 ) × ( B / 2 ) R^{(H/2)×(W/2)×(B/2)} R(H/2)×(W/2)×(B/2)。对F~ L也进行同样的划分,得到共同特征C~ L∈ R ( H / 2 ) × ( W / 2 ) × ( B / 2 ) R^{(H/2)×(W/2)×(B/2)} R(H/2)×(W/2)×(B/2)和唯一特征U~ L ∈ R ( H / 2 ) × ( W / 2 ) × ( B / 2 ) R^{(H/2)×(W/2)×(B/2)} R(H/2)×(W/2)×(B/2)。在本文中,假设PAN和LRMS图像在特征空间中共享相同的公共信息。因此,CP应该等于C ~ L,即

在共同特征和独特特征的组合之后,级联特征被馈送到重构网络Φ中。该网络由两个Swin Transformer块和两个卷积块组成。级联上采样层以将特征内插到H × W的大小。最后,引入具有四个滤波器的卷积层以产生最终的融合结果。

Loss Function

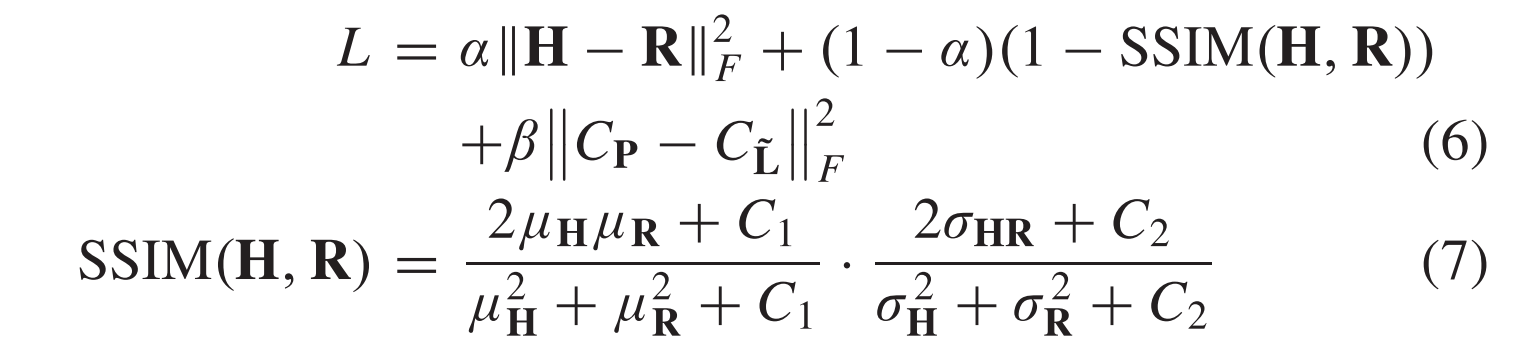

当构建网络时,通过最小化以下损失函数来训练网络:

其中R是参考图像。α和β是折衷参数。在(7)中,μH和μR分别是H和R的平均值。σH和σR是相应的标准差。σHR是两个图像的协方差。C1和C2是预设常数。在(6)中,通过Frobenius范数来测量重构误差。结构相似性损失被认为是描述图像中的结构信息。所以,H和R之间的SSIM损失被用于更好地保存空间信息。根据Zhao等人的建议,(6)中前两项的权重分别设置为α和1-α。为了估计公共信息,将(5)中的等式约束投射在它们上。然后,可以准确地提取公共信息。

Implementation Details

在所提出的TRRNet中,所有卷积块由两个卷积层和两个Leaky ReLU层形成,如图1所示。所有过滤器的尺寸均为3×3。在卷积块1中,第一和第二卷积层包含4个和32个滤波器。卷积块2中的卷积层都包含64个滤波器。我们将卷积块3和4的所有卷积层中的滤波器的数量设置为96。重建网络中的最后一个卷积层包含四个滤波器。该层中的过滤器的数量与MS图像中的条带的数量一致。对于图1中的Swin Transformer块,头部的数量是4,并且头部尺寸是32。我们将Swin变换块中的窗口大小设置为8 × 8。