随着大数据的积累和算法的复杂化,"黑盒"模型已经越来越成为主流。纵观一下预测类文章,很多都是"大而复杂的黑盒模型"。"黑盒模型"固然有其好处,即预测性能高,但缺点很明显,那就是可解释很差。今天,和大家谈谈两个问题,分别是"黑盒模型的危害"以及"可解释模型的意义"。

一、黑盒模型的危害

(1). 无法反映事物间的真实关联

举个简单的例子,我们采用一堆输入变量(如年龄、身高、患病、血液指标等)和深度神经网络预测脑卒中发病风险,结果显示,深度神经网络的AUC达到0.98,说明其预测能力确实很强!但当我们用树模型(如决策树)分析时,发现高血压人群的发病风险更低。为什么会这样?继续挖掘我们发现,原来基线得了高血压的人群,更注重血压管理,其未来脑卒中风险自然降低。如果仅采用深度神经网络,则无法识别这一规则,进而会忽视高血压人群的血压管理。由于我们只能看到"黑盒模型"的输入和输出,中间过程一概不知,就会导致这种重要关联关系被忽视,从而影响疾病干预和治疗。

(2).模型带来的不安全性问题

模型安全性是人工智能的普遍问题,但在"黑盒模型"中更为凸显。这种不安全性体现在两个层面:其一,从建模人员角度来说,由于是"黑盒模型",结构连他自己都搞不明白,当模型受到外界攻击时,会导致应用奔溃,甚至出现重大问题;其二,从应用者角度来说,拿到一个完全看不见、摸不着的"黑盒模型",属实心里没底,尤其是模型的风险点到底在哪?这种不安全性,最直接的后果就是导致使用者的不信任!

(3).模型带来的不公平性问题

这个问题也是人工智能的普遍问题,但在"黑盒模型"中更显著。不公平性指的是模型在不同人群上表现不一样,或者说是模型有"歧视性"。例如,常见的包括性别歧视、年龄歧视、种族歧视等。有歧视咱解决就好了,但难就难在你是"黑盒模型",我压根不知道你在哪发生了歧视。"黑盒模型"的不公平性也是制约其应用的关键因素。

二、可解释模型的重要意义

(1).透明性增强,使用者信心大增

这点自然好理解,就像两个人谈朋友一样,对你充分了解后,才会消除对彼此的戒备心理。如果决策者知道模型是怎么决策的,也就对自己将采取的措施有信心。不然,模型让你采取一项反常举措,你敢不敢?

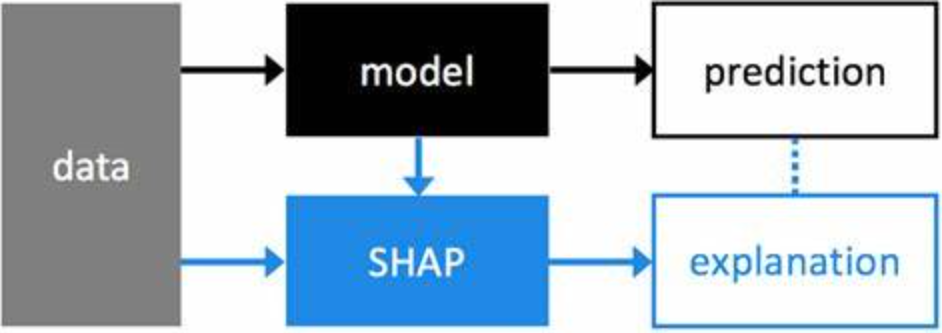

(2).识别重要干预或治疗因素

识别预测模型关键因素是大家常做的工作。这也是可解释性的基础工作,且其识别重要因素的手段众多,有全局的,也有局部的。这些重要因素对于全人群的干预,或者是个体的针对性治疗都具有至关重要的作用。

(3).为因果研究提供关键线索

我们知道预测研究仅仅是关联分析(不排除未来也能做到因果推断,如当下兴起的因果机器学习),发现的所有关系都不是因果。但这些发现却很重要,可以为因果研究提供重要方向和思路。

(4).提升模型预测性能

这个不能说是可解释性的最大优势,因为它主要不是干这个活的。但在一定程度上,利用了可解释性技术就能够发现重要预测因素,那基于最重要因素预测,自然可提升预测效果。

(5).使模型符合道德和法律的需要

模型最终目的是实践,实践就不可避免要涉及法律和道德。如果模型存在不公平性,轻则有违道德,重则触犯法律。因此,可解释性也是未来模型应用的重要考量维度之一。打个比方说,假如未来你还能读到这篇推文,背后的可解释性算法一定会告诉你,是因为你具有"好学......"等特质,才会将该推文呈现在你面前~