本文借鉴了NLP中的少样本困境问题探究,记录读后笔记和感想。

目标:我们希望采取相关数据增强或弱监督技术后

- 在少样本场景下,比起同等标注量的无增强监督学习模型,性能有较大幅度的提升;

- 在少样本场景下,能够达到或者逼近充分样本下的监督学习模型性能;

- 在充分样本场景下,性能仍然有一定提升;

一、NLP文本增强

文本增强根据是否依据文本的标签做数据增强分为无条件的文本增强,和有条件的文本增强。

无条件文本增强

- 词汇短语替换:基于词典的同义词替换(EDA:Easy Data Augmentation),基于词向量的相邻词替换(TinyBERT),Masked Language models,TF-IDF对非核心词,低频词的替换。

- 随机噪声注入:有随机插入(UDA),随机替换,随机删除等操作。

- 混合交叉:混合增强借鉴了图像中混合增强的思路,使用词/句子向量的叠加作为混合(wordMixup,sentMixup)。

混合增强:

交叉增强:

- 回译:使用机器翻译模型对句子多次翻译达到增强效果

- 句法交换:使用句法变化,如主动语态变被动语态

- 对抗增强:不同于CV领域利用GAN生成对抗进行数据增强,NLP中通常在词向量上添加扰动并进行对抗训练,NLP中的对抗训练方法FGM, PGD, FreeAT, YOPO, FreeLB。ref:一文搞懂NLP中的对抗训练

无条件增强的数据在数据标签上不会发生变化,但是增强文本与原文语义有可能会发生偏差,故需要有条件的数据增强对生成本文进行限制。

有条件的文本增强

深度生成模型:既然条件增强需要引入标签信息进行数据增强,那么我们自然就会联想到Conditional变分自编码模型(CVAE),文献[11]就利用CVA进行增强。想生成一个高质量的增强数据,往往需要充分的标注量,但这却与「少样本困境」这一前提所矛盾。这也正是GAN或者CVAE这一类深度生成模型在解决少样本问题时需要考虑的一个现状。

预训练语言模型:众所周知,BERT等在NLP领域取得了巨大成功,特别是其利用大量无标注数据进行了语言模型预训练。如果我们能够结合标签信息、充分利用这一系列语言模型去做文本增强,也许能够克服深度生成模型在少样本问题上的矛盾。近来许多研究者对Conditional Pre-trained Language Models 做文本增强进行了有益尝试:

- Contextual Augment:这是这一系列尝试的开篇之作,其基于LSTM进行biLM预训练,将标签信息融入网络结构进行finetune,是替换生成的词汇与标签信息兼容一致。

- CBERT:其主要思想还是借鉴了Contextual Augment,基于BERT进行finetune,将segment embedding转换融入标签指示的label embedding(如果标签类别数目大于2类,则相应扩充),如下图,替换good生成的funny与标签positive兼容。

- LAMBADA:来自IBM团队,其基于GPT-2将标签信息与原始文本拼接当作训练数据进行finetune(如下图所示,SEP代表标签和文本的分割,EOS是文本结束的标志),同时也采用一个判别器对生成数据进行了过滤降噪。

ref:

Contextual augmentation: Data augmentation by words with paradigmatic relations

Conditional BERT contextual augmentation

Do Not Have Enough Data? Deep Learning to the Rescue!

我们可以发现文本增强技术可以满足本文一开始给出的第一层次评价策略,即:在少样本场景下,采用文本增强技术,比起同等标注量的无增强监督学习模型,性能会有较大幅度的提升。

二、半监督学习

监督学习往往需要大量的标注数据,而标注数据的成本比较高,因此如何利用大量的无标注数据来提高监督学习的效果,具有十分重要的意义。这种利用少量标注数据和大量无标注数据进行学习的方式称为半监督学习(Semi-Supervised Learning,SSL) 。

熵最小化(Entropy Minimization): 根据半监督学习的Cluster假设,决策边界应该尽可能地通过数据较为稀疏的地方(低密度区),以能够避免把密集的样本数据点分到决策边界的两侧。也就是模型通过对未标记数据预测后要作出低熵预测,即熵最小化:

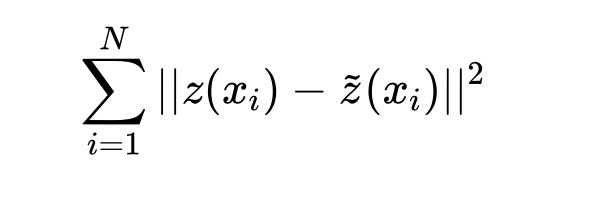

一致性正则(Consistency Regularization): 对于未标记数据,希望模型在其输入受到扰动时产生相同的输出分布。即:

ref:

Pseudo-Label : The Simple and Efficient Semi-Supervised Learning Method for Deep Neural Networks

Temporal ensembling for semi-supervised learning

Mean teachers are better role models: Weight-averaged consistency targets improve semi-supervised deep learning results

Virtual Adversarial Training: a Regularization Method for Supervised and Semi-supervised Learning

MixMatch: A Holistic Approach to Semi-Supervised Learning

ReMixMatch: Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring

FixMatch: Simplifying Semi-Supervised Learning with Consistency and Confidence

三、UDA:文本增强+半监督学习

本文在第1部分重点介绍了文本增强技术,文本增强方法通常针对标注数据(有监督数据增强),我们可以看到其在少样本场景通常会取得稳定的性能提升,但相较于充分样本下的监督学习性能,也许是有限的提升(“cherry on the cake”)。

为克服这一限制,UDA通过一致性训练框架(正如2.2节介绍的那样),将有监督的数据增强技术的发展扩展到了有大量未标记数据的半监督学习,尽可能的去利用大量未标记数据,这也正是论文名字——无监督数据增强(Unsupervised Data Augmentation)的由来。

UDA在六个文本分类任务上结合当前如日中天的BERT迁移学习框架进行了实验。迁移学习框架分别为:(1)Random:随机初始化的Transformer;(2):BERT_base;(3):BERT_large;(4):BERT_finetune:基于BERT_large在domain数据集上继续进行预训练;

四、总结

本文针对「如何解决少样本困境?」,从「文本增强」和「半监督学习」两个角度进行了介绍,简单总结如下:

- 文本增强提供了原有标注数据缺少的归纳偏差,在少样本场景下通常会取得稳定、但有限的性能提升;更高级、更多样化和更自然的增强方法效果更佳。

- 融合文本增强+半监督学习技术是一个不错的选择。半监督学习中一致性正则能够充分利用大量未标注数据,同时能够使输入空间的变化更加平滑,从另一个角度来看,降低一致性损失实质上也是将标签信息从标注数据传播到未标注数据的过程。