机器学习实验报告

〇、实验报告pdf可在该网址下载

机器学习实验二:LDA

这个需要积分下载(因为实验报告后台查重,不建议直接白嫖)。

建议看博客,博客里面会有很多实验报告小说明会用【…】加粗注释。

一、实验目的与要求

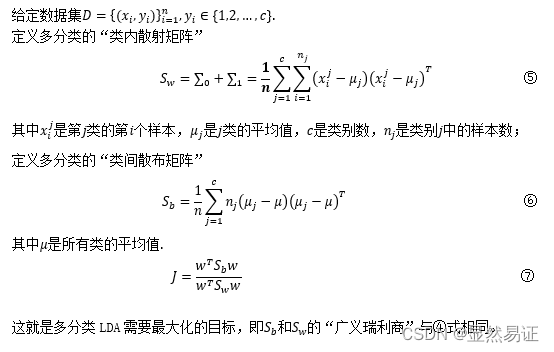

- 简述LDA 原理、算法模型与优化问题,给出全程推导细节;证明St=Sb+Sw;

- 给出LDA的各种等价模型表示(除法的、减法的及其调换位置的等), 在各数据集(不少于3个)比较PCA与“LDA的各种等价模型与正则模型”的人脸识别精度

- 比较eigenface与fisherface的不同,并取3个类的图像投影在二维和三维空间中, 并用不同颜色的点表示不同的类,每个类选3个有代表性的点对应的人脸图像显示在该点的边上(用plot命令或imshow),比较PCA与LDA的结果的不同;

- 参看前人论文,设计一个全新的线性鉴别分析方法或子空间学习方法,把简要内容写在本实验报告中;把长文写好提交到 ”论文提交处“;

二、实验内容与方法

2.1 LDA算法学习与回顾

2.1.1 LDA原理

根据周志华老师的《机器学习》一书中,来阐述LDA的理论。

线性判别分析(Linear Discriminant Analysis,LDA)是一种经典的线性学习方法,在二分类问题上最早由Fisher(1936)提出,亦称“Fisher判别分析”。

LDA的原理如下:

给定训练样例集,设法将样例投影到一条直线上使得同类样例的投影点尽可能接近、异类样例的投影点尽可能远离;在对新样本进行分类时,将其投影到同样的这条直线上,再根据投影点的位置来确定新的样本的类别。

2.1.2 LDA的算法模型

二分类模型

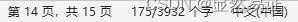

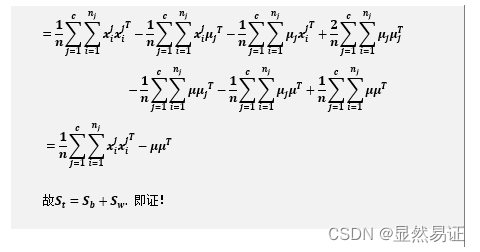

多分类模型

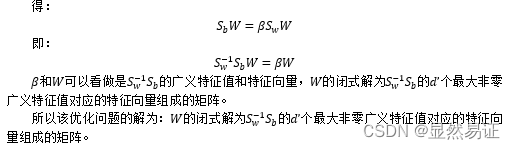

2.1.3 LDA的优化问题

2.2 LDA的算法流程

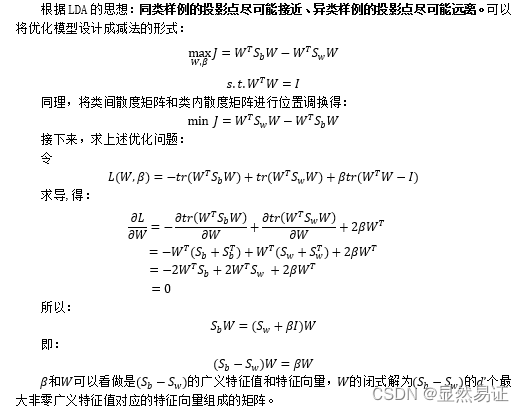

2.3 LDA算法等价模型

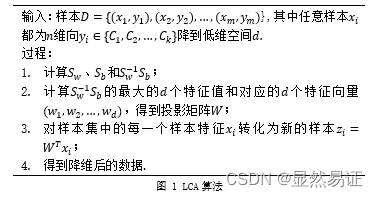

2.3.1 除法及其调换位置

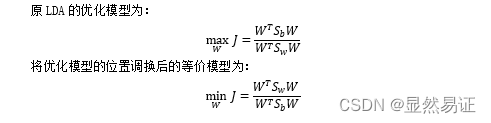

2.3.2 减法模型及其调换位置

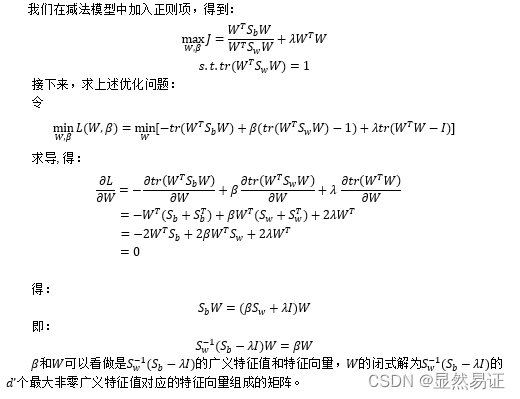

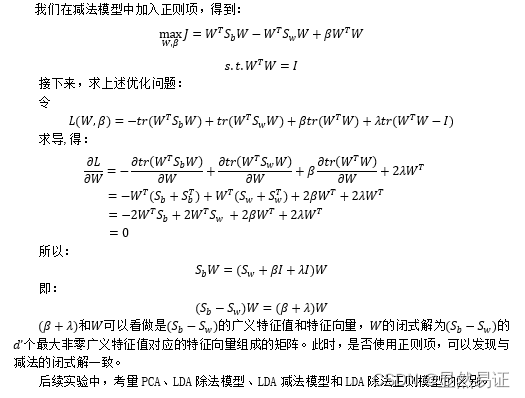

2.3.3 除法正则模型

2.3.4 减法正则模型

三、实验步骤与过程

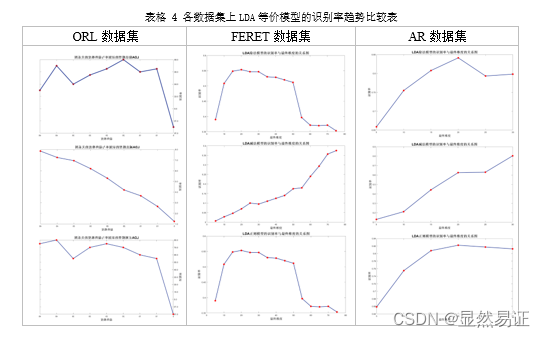

3.1 比较PCA与“LDA的各种等价模型与正则模型”的人脸识别精度

3.1.1 ORL数据集下各种算法的人脸识别精度

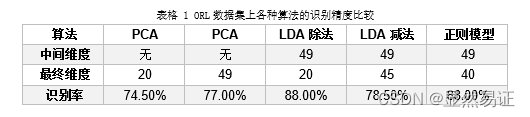

ORL数据集一共40个人,采用每个人训练集为5个样本,测试集为5个样本,LDA算法先采用PCA重构阈值为90%降维再进行特征提取。KNN中使用K=5。

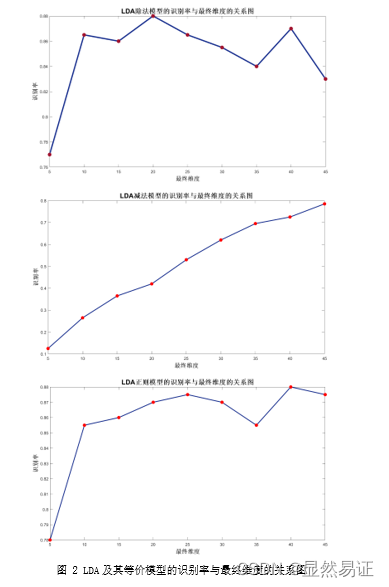

其中LDA算法对于最终维度的考量如下:

然后采用识别最高的最终维度来计算。

实验结果数据如下:

3.1.2 FERET_80数据集下各种算法的人脸识别精度

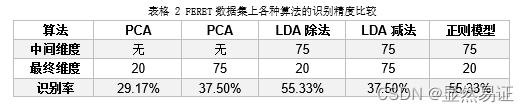

FERET_80数据集一共200个人,采用每个人训练集为4个样本,测试集为3个样本,LDA算法先采用PCA重构阈值为90%降维再进行特征提取。KNN中使用K=3。

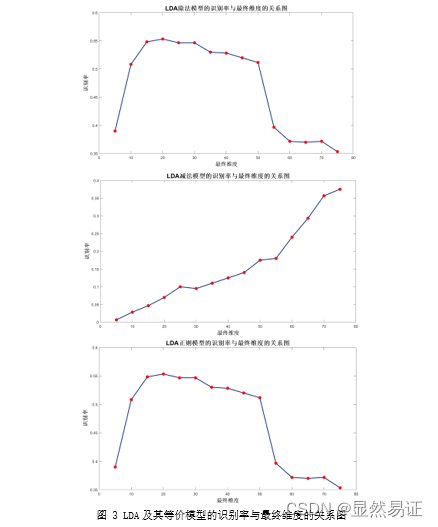

其中LDA算法对于最终维度的考量如下:

然后采用识别最高的最终维度来计算。

实验结果数据如下:

3.1.3 AR人脸数据集下各种算法的人脸识别精度

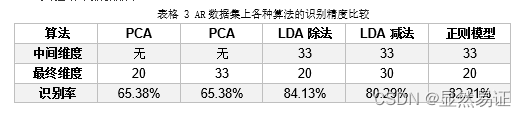

AR数据集一共17个人,采用每个人训练集为4个样本,测试集为3个样本,LDA算法先采用PCA重构阈值为90%降维再进行特征提取。KNN中使用K=3。

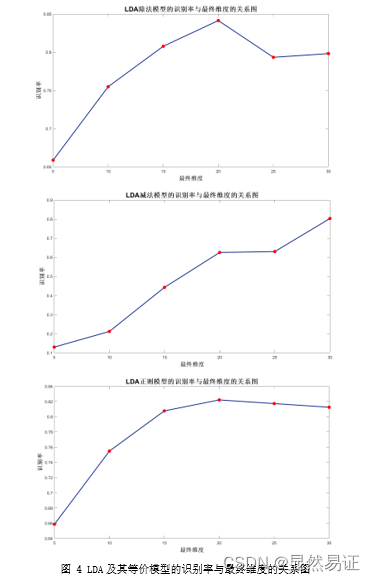

其中LDA算法对于最终维度的考量如下:

然后采用识别最高的最终维度来计算。

实验结果数据如下:

3.2 比较eigenface与fisherface的不同

取3个类的图像投影在二维和三维空间中,并用不同颜色的点表示不同的类,每个类选3个有代表性的点对应的人脸图像显示在该点的边上(用plot命令或imshow),比较PCA与LDA的结果的异不同。

3.2.1 三个数据集降至2,3维的可视化效果图

PCA

LDA

3.2.2 分析

我们发现,对于PCA而言,数据点会比较分散,点与点之间的距离会相对较大;而对于LDA而言,同类数据点会比较集中,异类数据点会相对分散,这种比较明显的结果也反应了两种算法的思想上的侧重点。在上述实验中,相同维度的情况下,LDA之所以会比PCA的识别率更高,是因为LDA在进行人脸特征提取的时候考虑到了类标签信息,可以理解为:LDA比PCA更注重“分类的结果”,而PCA更注重“分散数据点”。所以对于分类任务而言,LDA的效果一般要优胜于PCA。

3.3 设计一个新的LDA算法

加油!!!我就不在这里献丑了!!!

四、实验结论或体会

本次实验的公式推导与证明非常重要,也在本次实验报告中体现了较大的篇幅。把LDA的各种等价模型和正则模型推导之后,也加深了我对优化问题的理解,对拉格朗日乘子法和矩阵求导的操作也更加熟练。

在实验过程中,比较了PCA与LDA及其等价模型的区别,我也发现了一个很有意思的现象,在我实验的三个数据集中,先采用PCA重构阈值为90%降维再进行LDA特征提取,会发现:使用LDA减法模型的时候发现了识别率会随着最终维度单调上升,而除法及其正则模型则是会出现一个识别率的最高点然后随着最终维度的增加识别率会大大下降。

针对本次实验,PCA与LDA的原理和实验更加透彻了。PCA求得的是一个所有样本数据点方差最大的投影;LDA求得的是同类样本尽可能接近、异类样本尽可能远离的投影。综上:LDA比PCA更注重“分类的结果”,而PCA更注重“分散数据点”。所以对于分类任务而言,LDA的效果一般要优胜于PCA。

以上就是本次实验的问题与收获。本次实验还是非常充实的,尤其在数学理论方面,再一次深刻理解数学的重要!