虚拟化是一种历经验证的软件技术,借助这项技术,可在同一台服务器上同时运行多个操作系统和应用。虚拟化可以提高 IT 部门的敏捷性、灵活性和可扩展性,同时大幅节约成本。工作负载的部署速度更快,性能和可用性得到提升,运维实现自动化,所有这一切不仅简化了IT管理,还降低了拥有成本和运维成本。

在规划设计虚拟化数据中心的时候,在产品选型阶段要根据企业的需求和预算,在计算(主要是CPU和内存)、存储、网络三者之间进行合理的选择。

1、VMware 虚拟化基础功能

1. 实时迁移工作负载

vSphere vMotion 使您无需停机,即可使整台正在运行的虚拟机在物理服务器之间迁移。虚拟机将保留其网络标识和连接,从而确保无缝迁移。通过高速网络传输虚拟机的活动内存及精确的执行状态,使该虚拟机可以从在源 vSphere 主机上运行切换到在目标 vSphere 主机上运行。整个过程在千兆位以太网上只需不到两秒钟的时间。可以在虚拟交换机、vCenter Server 甚至是远距离之间使用此功能。

2. 保护虚拟机和数据

vSphere Data Protection 可提供存储到磁盘的无代理映像级虚拟机备份。它还能够为 Microsoft 关键业务应用(例如 Exchange、SQL Server、SharePoint)提供可识别应用的保护,以及高效利用 WAN 的加密备份数据复制功能。这些功能包括可变长度重复数据消除、可识别应用的备份、单步恢复和紧急情况下直接还原到主机。

3. 确保系统正常运行时间

vSphere High Availability (HA) 可针对您的虚拟化环境中的硬件和操作系统故障,提供统一且经济高效的故障转移保护,从而最大限度地降低停机时间。监控主机和虚拟机,并且在检测到故障时自动重新启动集群中其他主机上的虚拟机。HA 可为所有应用提供统一的自动化保护,用户无需对应用或客户操作系统进行任何修改。

4. 共享数据中心资源

从中央位置轻松管理虚拟机模板、vApp、ISO 映像和脚本。将内容分组整理到可单独进行配置和管理的库中。创建库后,即可跨越 vCenter Server 的边界共享内容,并可确保整个数据中心的一致性。直接将虚拟机模板部署到主机或集群以获得一致的调配体验

5. 优先为虚拟机分配资源

vSphere Network I/O Control (NIOC) 和 vSphere Storage I/O Control (SIOC) 监控您的网络和存储,并根据您设定的规则和策略,自动将资源投向优先性高的应用。此功能扩大了 CPU 和内存现有的常用份额和限制参数的构成范围,通过在一组 vSphere 主机集群中动态分配 I/O 容量来解决网络或存储利用率问题。通过减少主动的性能管理,可以提高管理员的工作效率。

6. 集中式网络管理

从一个统一的界面跨多个主机和集群实现虚拟网络连接的调配、管理和监控。vSphere Distributed Switch 具有丰富的监控和故障排除功能,包括从修补回滚和恢复,以及更新网络配置和模板,实现虚拟网络连接配置的备份和还原。

7. 快速部署和调配

可以将保存 vSphere 主机共享的配置设置数值的主机配置文件附加到一个或多个 vSphere 主机或集群上。主机配置会与主机配置文件进行比较,并报告偏差,从而自动纠正配置偏差。管理员可以创建配置文件,然后与 Auto Deploy 配合使用,快速部署和调配多个 vSphere 主机,不需要专用脚本或人工配置。

2、单台服务器虚拟化应用案例

如果企业需要同时运行的虚拟机数量较少,并且在不考虑硬件冗余的前提下,可以配置单台服务器实施虚拟化。单台服务器的硬件选择主要指对服务器的CPU、内存、硬盘和网络进行选择。

单台服务器提供虚拟化应用没有多台服务器的冗余,但服务器本身的配件还是需要有一定的冗余。

例如为服务器配置2个电源和2颗CPU,配置多块硬盘和RAID卡为数据存储提供冗余,还可以通过配置多块网卡或多端口网卡实现网络的冗余。

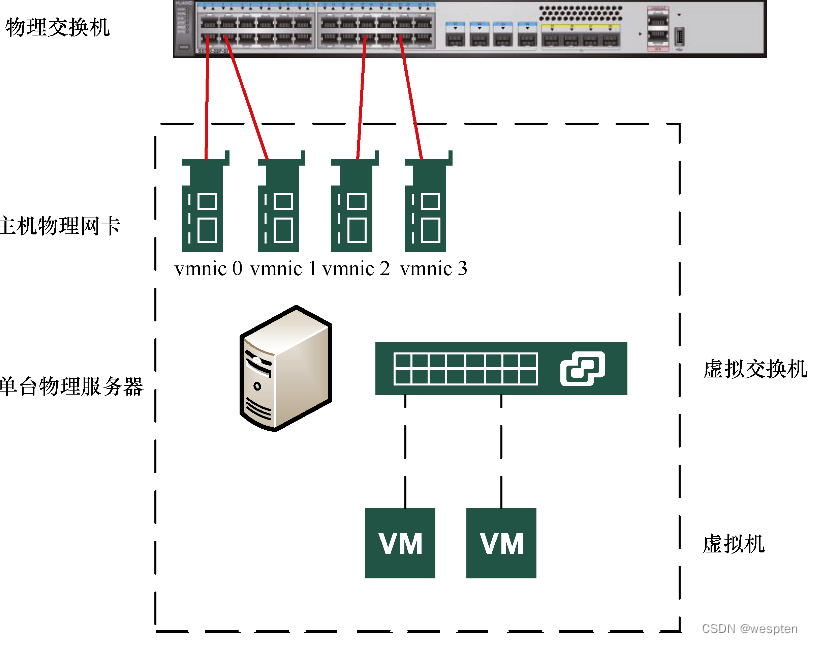

单台服务器虚拟化网络拓扑如图所示:

在实验测试需求或者可靠性要求不高的场合下,单台服务器虚拟化可以不配置冗余硬件,例如服务器可以配置1个电源和1颗CPU,可以配置单条内存和1块硬盘。当中小企业物理服务器数量较少,并且允许服务器硬件故障后停机维修时,单台服务器虚拟化就比较适合。下面介绍一个具体的应用案例。

某单位原有9台物理服务器,这些服务器已经使用多年需要更换。

现有服务器的用途和IP地址等情况整理,如下表所示。

上表所列的现有物理机,如果使用虚拟化技术,一般按如下原则配置。

(1)根据现有业务系统服务器及应用,按1:1的比例配置虚拟机,即原有1台物理机则配置1台对应的虚拟机。

(2)在配置每台虚拟机的时候,CPU资源按原物理机已使用资源3至5倍分配,内存按已使用内存3至5倍分配,虚拟机硬盘容量大小按现有使用空间2至3倍分配。

对于当前应用案例,根据用户现状和预算,配置了一台DELL R740的服务器,该服务器配置了1颗Intel Gold 5218的CPU和128GB内存,系统和数据配置了6块1.2TB的硬盘,数据备份配置了1块12TB的硬盘。当前选择的服务器配置了12个3.5英寸盘位。

配置的6块1.2TB的硬盘是2.5英寸的,SAS接口,采用了3.5英寸转2.5英寸的转换托架。12TB的硬盘是3.5英寸的,NL-SAS接口,用作虚拟机的备份。6块1.2TB的硬盘使用RAID-5划分为2个卷,第1个卷大小为10GB,用于安装VMware ESXi 6.0的虚拟化系统;剩余的空间划分为第2个卷,剩余总空间约为5.45TB,用来保存虚拟机。

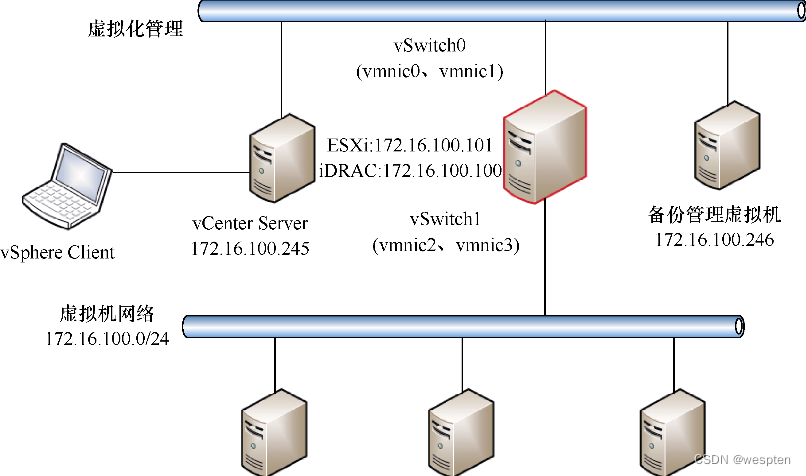

当前选择的服务器配置了4端口1Gbit/s的网卡,其中2个端口配置为vSwitch0虚拟交换机,用于ESXi主机与vCenter Server的管理,另2个端口配置为vSwitch1虚拟交换机,用于虚拟机的流量。

服务器虚拟化拓扑如图所示:

虚拟化平台规划IP地址与用途,如下表所示。

主要安装配置步骤和过程如下。

- 服务器到位之后,将6块1.2TB的硬盘安装在服务器前6个插槽中,将12TB的3.5英寸硬盘安装在第7个插槽中。

- 打开服务器的电源并进入RAID配置界面,将6块1.2TB的硬盘采用RAID-5配置并划分为2个卷。第1个卷大小为10GB,第2个卷使用剩余的空间(大小约为5.45TB),初始化第1个和第2个卷。将12TB的硬盘配置为Non-RAID方式。配置完成后退出RAID配置界面,按Ctrl+Alt+Del组合键重新启动服务器。

- 使用VMware ESXi 6.0的安装盘启动服务器,将VMware ESXi 6.0安装到10GB的卷中。安装完成后重新启动服务器,再次进入ESXi系统后按F2键进入ESXi控制台配置界面,选择vmnic0和vmnic1为管理接口,并设置ESXi服务器的管理IP地址为172.16.100.101。子网掩码与网关根据实际情况设置。

- 将服务器的4块网卡接入网络。在本示例中,4块网卡都连接到交换机的Access端口,并且划分的地址属于172.16.100.0/24的网段。

- 使用网络中一台计算机作为管理工作站,在该计算机中安装vSphere Client 6.0,安装之后运行vSphere Client并连接到VMware ESXi,然后安装vCenter Server 6.0。本示例中vCenter Server的IP地址为172.16.100.245。

- 将6块1.2TB硬盘采用RAID-5配置并划分的第2个卷添加为VMFS数据存储,本示例中数据存储名称为Data。将12TB的硬盘添加为VMFS数据存储,数据存储名称为Veeam-backup。删除安装ESXi系统所在的VMFS卷(该卷剩余大小约为5GB),因为该卷剩余空间很小,后期也不会用到。删除此数据存储不影响ESXi主机的启动。

- 使用vSphere Client连接到vCenter Server,在vCenter Server中创建数据中心,并添加IP地址为172.16.100.101的ESXi。

- 创建名为vSwitch1的虚拟交换机,使用vmnic2和vmnic3的端口,并为vSwitch1创建端口组。

- 使用VMware Converter 迁移物理机到虚拟机。在迁移的过程中,目标虚拟机保存在名为Data的数据存储中,不要保存在12TB的数据存储中。每迁移完成一台虚拟机,把对应的物理机网线拔下或者关闭对应的物理机,进入虚拟机控制台,在虚拟机中设置原来的物理机对应的IP地址、子网掩码、网关与域名服务器(Domain Name Server,DNS),用虚拟机代替原来物理机对外提供服务。如果虚拟机对外服务正常,下架原来的物理机。这样一一将所有的物理机迁移到虚拟机。

- 创建一台基于Windows Server 2016或Windows Server 2019的虚拟机,安装Veeam 10.0备份软件,以复制的方式将生产虚拟机复制到名为Veeam-backup的数据存储中。

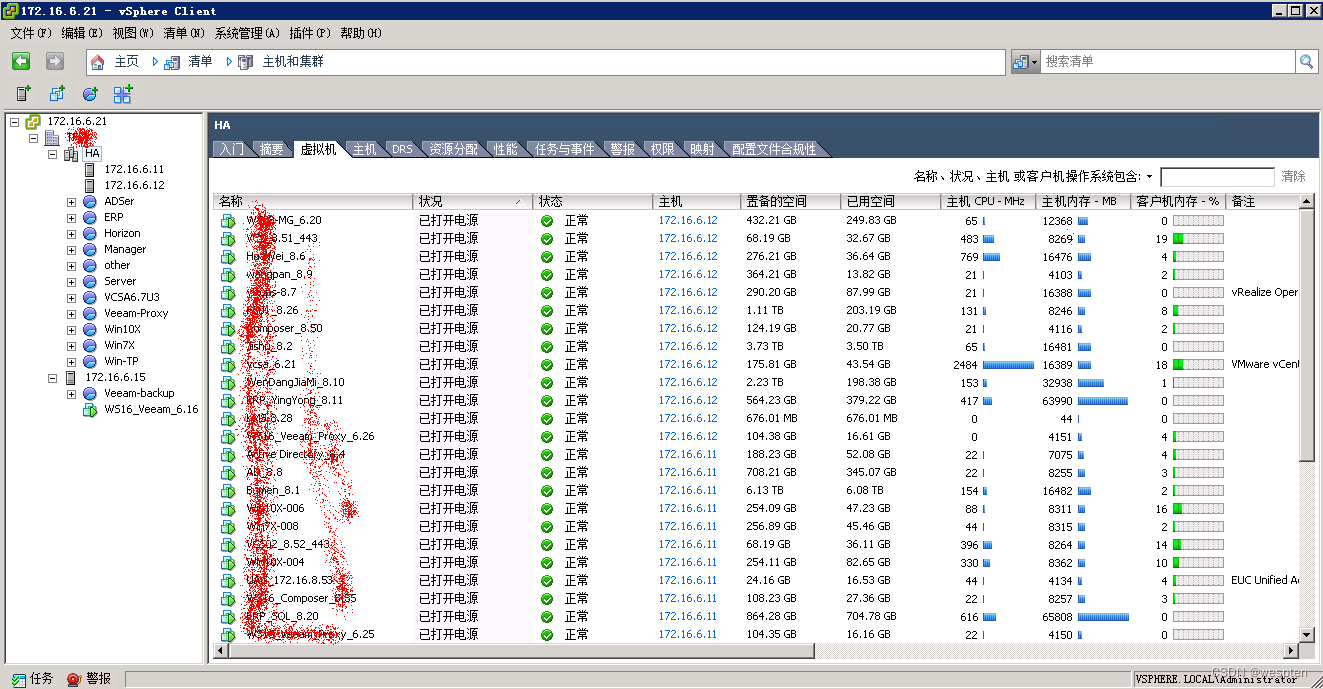

项目完成后,如下图所示:

在图中可以看到已经将原有物理机迁移到虚拟机,并且当前有2个数据存储,名称分别为Data和Veeam-backup。如果由于病毒、误操作或其他故障导致虚拟机出问题或数据丢失、数据损坏,可以通过备份进行恢复。

3、共享存储虚拟化应用案例介绍

在分布式软件共享存储推出之前,虚拟机系统运行在物理服务器上,而虚拟机数据保存在共享存储中。服务器本身不配硬盘(使用共享存储分配的小容量卷)或者配容量较小的磁盘用于安装虚拟化系统。

使用共享存储的虚拟化拓扑,如下图所示。

图中画出了2台服务器和1台共享存储的连接示意。在使用共享存储的虚拟化架构中可以配置更多数量的物理服务器,其连接方式与2台物理服务器的连接相同。

每台服务器一般配置至少4块网卡和2块FC HBA接口卡。4块网卡中每2块组成一组,其中一组用于虚拟化主机的管理,另一组用于虚拟机的流量。2块FC HBA接口卡分别连接到2台光纤存储交换机。共享存储配置2个控制器,每个控制器至少有2个FC HBA接口,每个控制器的不同接口分别连接到2台不同的光纤存储交换机。在此种连接方式下,服务器到存储是冗余连接的。

任何一台光纤存储交换机、任何一条链路和任何一台服务器的任何一块FC HBA接口卡故障都不会导致服务器到存储的连接中断。同样,在网络方面,2台网络交换机采用堆叠方式(或者采用其他冗余方式)连接到核心交换机。任意一台服务器到核心交换机都是用2条独立的链路连接,任何一处的故障都不会导致管理网络或虚拟机业务网络中断。这样就形成了网络与存储的全冗余连接。

在中小企业虚拟化环境中,使用共享存储的虚拟化架构,一般配置3至10台服务器和1至2台共享存储。在服务器与存储配置足够的前提下,可以提供30至150台左右的虚拟机,这可以满足大多数中小企业的需求。下面介绍一个使用共享存储的虚拟化案例。

某企业配置2台联想3650 M5的服务器(每台服务器配置2颗Intel Xeon E5-2650 V4处理器、512GB内存、4端口1Gbit/s网卡、2端口8Gbit/s FC HBA接口卡)和1台IBM V3500存储(配置了11块900GB的2.5英寸SAS磁盘和13块1.2TB的2.5英寸磁盘)组成虚拟化环境,该硬件配置同时运行了30多台虚拟机,用于企业的办公自动化(Office Automation,OA)、企业资源计划(Enterprise Resource Planning,ERP)、文件服务器、文档加密服务器等应用。

虚拟机列表如下图所示:

另外配置了一台1U的机架式服务器(图中左侧IP地址为172.16.6.15的主机)用于备份,这台备份主机配置了4块12TB的硬盘,使用RAID-5划分为2个卷,第1个卷大小为10GB用于安装ESXi系统,剩余的大约32.05TB划分为第2个卷用于备份。

如下图所示,名为Data-esx15的VMFS卷是备份服务器存储空间。

在图中,名为fc-data01的卷是IBM V3500存储设备中11块900GB SAS磁盘的空间(1块为全局热备磁盘,另外10块配置了2组RAID-5),名为fc-data03的卷是IBM V3500存储设备中13块1.2TB磁盘的空间(1块为全局热备磁盘,另外12块配置了2组RAID-5)。

在IBM V3500存储管理界面可以看到磁盘的配置情况,如图所示。

4、分布式软件共享存储虚拟化案例

通过分析共享存储作为虚拟化服务器的载体可知,共享存储是单点故障和性能瓶颈可能产生处。如果共享存储出现问题,保存在共享存储上的所有的虚拟机都无法访问。

随着同一集群中物理服务器以及虚拟机数量的增加,每台虚拟机的性能受限于存储控制器性能、存储接口、存储磁盘数量等参数。VMware从vSphere 5.5 U1开始推出vSAN架构,该架构使用服务器本地硬盘和传统以太网组成分布式软件共享存储,很好地解决了传统共享存储的缺点。

这一架构的网络拓扑如图所示:

分布式软件共享存储架构中不需要配置传统的共享存储,也不需要传统的光纤存储交换机,而是使用服务器本地硬盘,以软件的方式通过传统的以太网络交换机组成分布式共享存储。

传统共享存储中采用的是光纤存储交换机,而分布式软件共享存储架构中采用的是以太网交换机。

vSAN架构中不配备共享存储,采用服务器本地硬盘先组成磁盘组,然后通过网络组成分布式软件共享存储。虚拟机在磁盘组中以RAID-0、RAID-5或RAID-6的方式保存数据,服务器之间通过网络实现类似RAID-10、RAID-50或RAID-60的整体效果。

多台服务器的多块磁盘共同组成可以在服务器之间共享的 vSAN 存储。任何一台虚拟机保存在其中一台主机的1块或多块磁盘中,并且至少有1个完全相同的副本保存在另一台主机中,同时有1个见证文件保存在第3台主机中。虚拟机在不同主机的磁盘组中的数据是使用vSAN流量的VMkernel进行同步的,vSAN架构(图中右边的网络交换机)为vSAN流量推荐采用10Gbit/s网络或更快的网络,例如40Gbit/s和100Gbit/s的网络,vSAN也支持使用1Gbit/s的网络。

在vSAN架构中,每台虚拟化主机可以配置1至5个磁盘组。每个磁盘组中至少1块固态盘(Solid State Disk,SSD)用作缓存磁盘,1块硬盘(Hard Disk Drive,HDD)或1块SSD用作容量磁盘。推荐每台主机配置不少于2个磁盘组,每个磁盘组配备1块SSD和4至7块HDD(或SSD)。基于vSAN架构的分布式软件共享存储,根据虚拟机存储策略的不同,整体相当于RAID-10、RAID-5、RAID-6或RAID-50、RAID-60的效果。

无论是传统数据中心还是超融合架构的数据中心,用于虚拟机流量的网络交换机可以采用同一个标准进行选择。

对于物理主机的选择,在传统数据中心中可以不考虑或少考虑本机磁盘的数量。但如果采用vSAN架构,则应尽可能选择支持较多盘位的服务器。物理主机的CPU、内存、本地网卡等其他配件选择方式相同。

传统架构中需要为物理主机配置FC或SAS HBA接口卡,并配置FC或SAS存储交换机。vSAN架构中需要为物理主机配置10Gbit/s或更高速度的以太网卡,并且配置10Gbit/s或更高速度的以太网交换机。

无论是在传统架构还是在vSAN架构中,对RAID卡的要求都比较低。前者是因为采用共享存储(虚拟机保存在共享存储,不保存在服务器本地硬盘),不需要为服务器配置过多磁盘,所以不需要RAID-5等方式的支持,最多2块磁盘配置RAID-1用于安装VMware ESXi系统。而在vSAN架构中,VMware ESXi Hypervisor直接控制每块磁盘,不再需要阵列卡这一级。

如果服务器已经配置RAID卡,则需要将每块磁盘配置为直通模式或Non-RAID模式,如果RAID卡不支持这2种模式,可以将每块磁盘配置为RAID-0。在vSAN架构中,选择RAID卡的时候要考虑队列深度,不要采用队列深度太低的RAID卡。

VMware vSAN可以组成标准vSAN集群、2节点直连延伸集群或双活数据中心集群,其中标准vSAN集群应用最广。要组成标准vSAN集群,一般是从4台提供计算、存储和网络的服务器起配。在4节点vSAN标准集群中,一般每台服务器配置至少1颗CPU,内存最小从128GB甚至256GB起配,配置至少1个磁盘组,每个磁盘组至少有1个缓存磁盘和4至6个容量磁盘,每台服务器配置至少4个1Gbit/s的网卡。

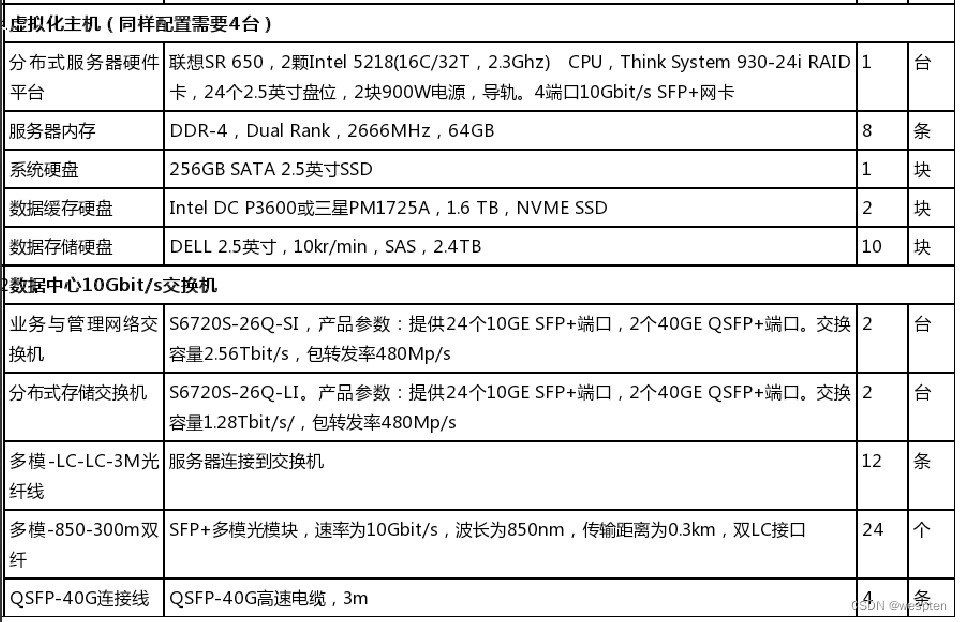

下表是某企业4节点vSAN标准集群的硬件配置:

这是2019年的配置清单。如果是在2021年开始采购,数据缓存硬盘推荐使用三星PM1735 1.6TB NVME SSD。

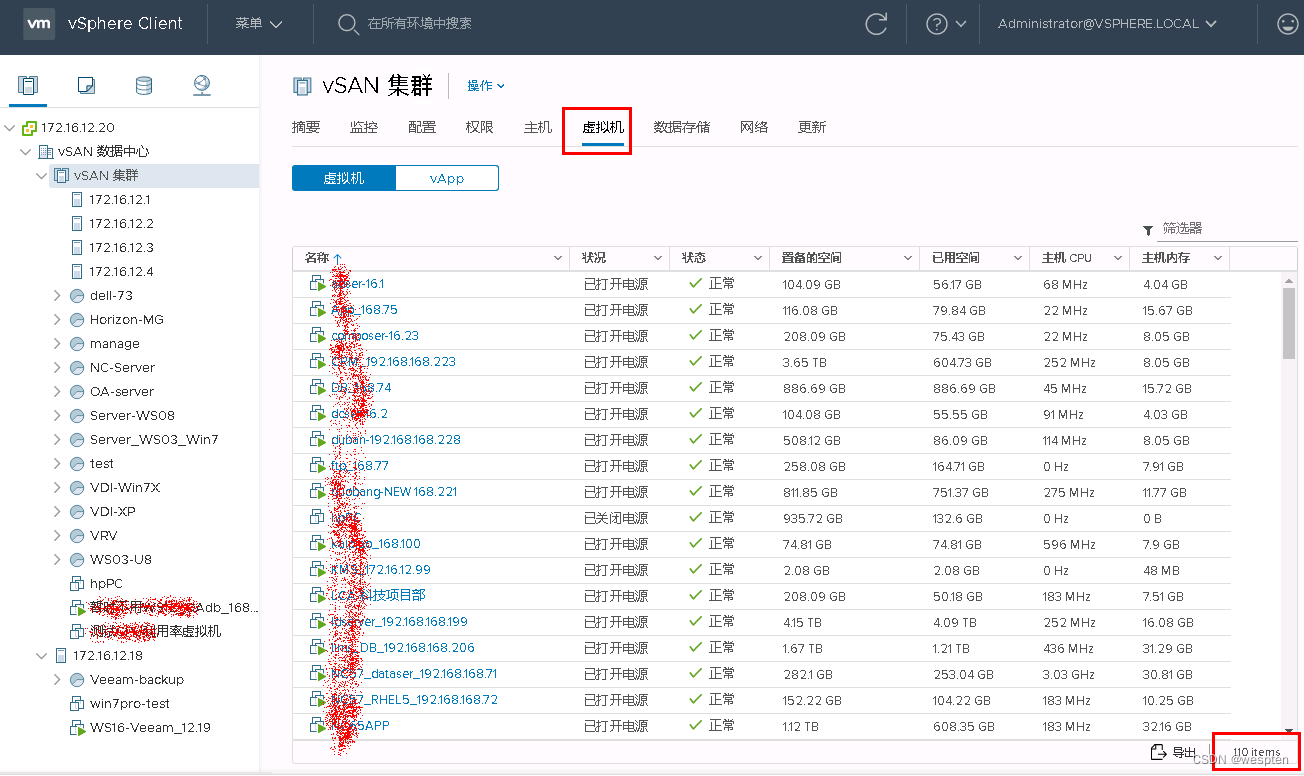

在用上表所列的配置组成的VMware vSphere虚拟化项目中,运行了110台各种应用的虚拟机,如下图所示。

在运行了110台各种应用虚拟机的前提下,主机的资源使用率比较低,CPU使用率平均不到6%,内存使用率平均不到32%,系统整体负载较轻,如下图所示。