引言

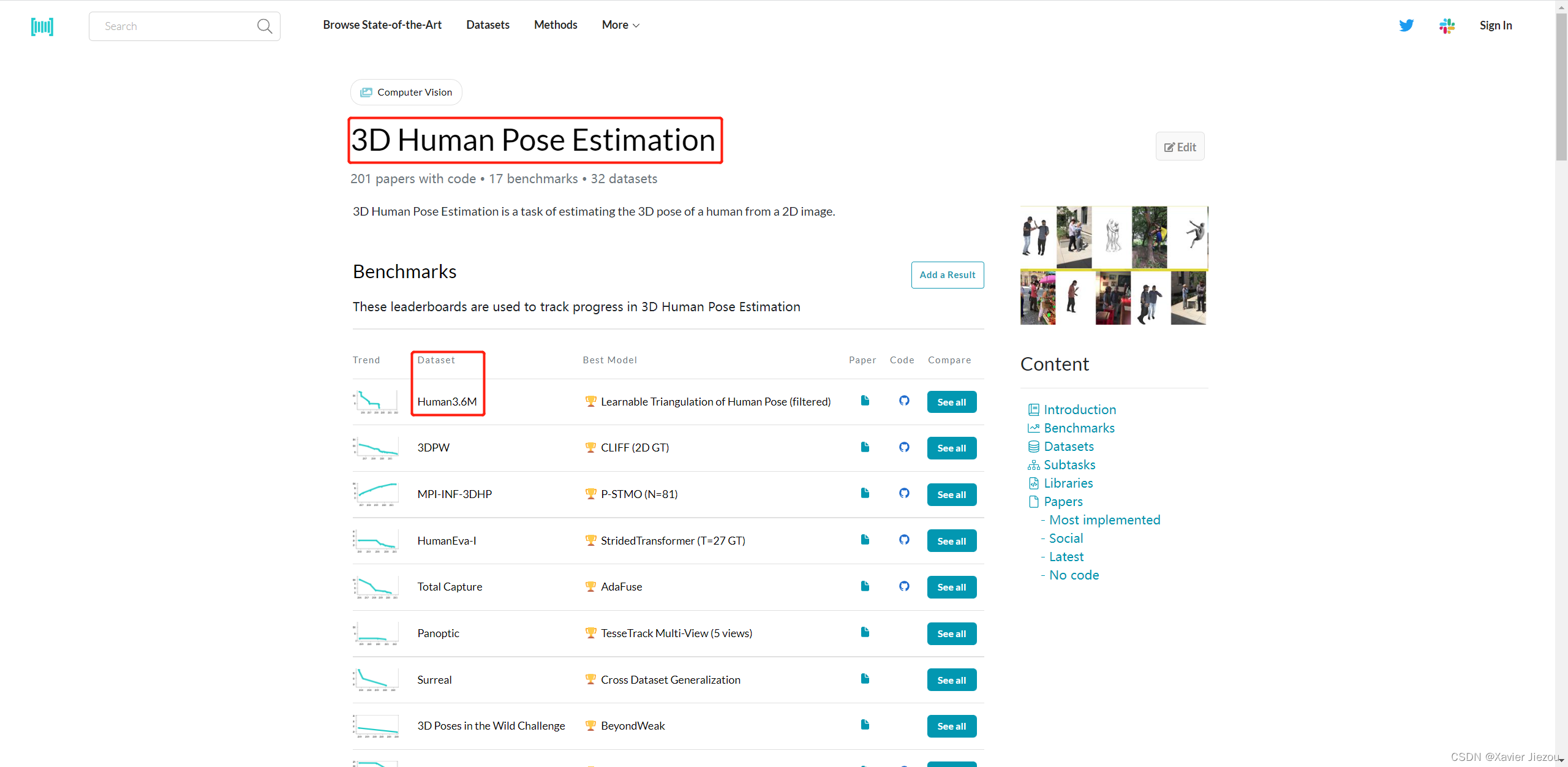

Human3.6M 是一个用于 3D 人体位姿估计研究的大型公开数据集,在 paperswithcode 中可以看到在此数据集上提出的各种 SOTA 算法及模型,是目前基于多视图的 3D 人体位姿研究最为重要的一个数据集,没有之一。

下载

在官网下载的话需要使用教育邮箱注册账号并等待审核,审核速度非常慢。这里推荐直接使用如下方式下载:

# Download H36M annotations

mkdir data

cd data

wget http://visiondata.cis.upenn.edu/volumetric/h36m/h36m_annot.tar

tar -xf h36m_annot.tar

rm h36m_annot.tar

# Download H36M images

mkdir -p h36m/images

cd h36m/images

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S1.tar

tar -xf S1.tar

rm S1.tar

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S5.tar

tar -xf S5.tar

rm S5.tar

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S6.tar

tar -xf S6.tar

rm S6.tar

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S7.tar

tar -xf S7.tar

rm S7.tar

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S8.tar

tar -xf S8.tar

rm S8.tar

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S9.tar

tar -xf S9.tar

rm S9.tar

wget http://visiondata.cis.upenn.edu/volumetric/h36m/S11.tar

tar -xf S11.tar

rm S11.tar

cd ../../..

当然,wget 是单线程下载,可以考虑使用 NDM 多线程下载来提高速度。此外,该数据集文件是放在国外的服务器上,因此有条件的可以开个网络代理。

概述

数据规模和多样性

- 360 万张 3D 人体姿势和对应图像

- 11 名专业演员(6 男 5 女)

- 7 个场景(讨论、吸烟、拍照以及打电话等等)

准确捕捉和同步

- 来自 4 个标定的高分辨率 50HZ 相机拍摄的视频

- 来自高速运动捕捉系统的精准 3D 关节位置和角度

- 单次配置 24 个身体部位标签

- Time-of-flight 范围数据

- 对每个演员进行 3D 激光扫描

- 精准的背景去除和人体边界框

演示

Video for Human3.6M Dataset

角色

这些动作是由 11 名专业的演员(6 男 5 女)来完成的,它们的 BMI 指数范围是 17~29,这保证了适度的身体形状可变性以及不同的活动范围。受试者穿着的是自己的日常服装,而不是特殊的动作捕捉服,以尽可能保持真实感。其中,对 7 名受试者(4 男 3 女)采集的数据进行训练和验证,4 名受试者(2 男 2 女)采集的数据进行测试。

场景

该数据集由 4 台数码相机收集的 360 万个不同的人体姿势组成。数据被组织成 15 个训练动作,其中包含多种不对成的行走姿势(例如手插口袋走路,肩扛包走路)、坐姿、躺姿、各种等待姿势以及其他类型的姿势。演员们被赋予了带有示例的详细任务,以帮助它们在重复之间规划一组稳定的姿势,以创建训练、验证和测试集。然后,在执行这些任务时,演员们也有相当多的自由,可以自由地超越对任务严格的解释。

| Directions | Discussion | Eating | Activities while seated | Greeting |

|---|---|---|---|---|

|

|

|

|

|

| Taking photo | Posing | Making purchases | Smoking | Waiting |

|

|

|

|

|

| Walking | Sitting on chair | Talking on the phone | Walking dog | Walking together |

|

|

|

|

|

数据

实验环境

实验室设置如上图。使用 15 个传感器(4 个数码相机、1 个 time-of-flight 传感器,10 个动捕相机)来捕获数据。拍摄区域约为 6mx5m,其中有效拍摄空间是 4mx3m,所有的相机都能完全看到拍摄对象。4 台数码相机(DV)放置在拍摄空间的角落。time-of-flight(TOF) 传感器放置在其中一个数码相机的旁边。墙壁上安装了一组 10 个动作捕捉(MX)相机,以最大限度地提高有效实验体积,左右两侧各 4 个,底部水平边缘大约中间位置有 2 个。

图像数据

使用 4 台 basler 高分辨率逐行扫描相机来采集 50HZ 的视频数据。他们与动作捕捉系统处于相同的时钟和出发状态,从而确保视频和姿势数据之间的完美同步。系统的默认校准程序执行起来非常简单,但相机模型不包含径向和切向畸变参数。由于我们力求获得高质量的姿势信息,因此使用了一个更复杂、稳健的程序。整个数据集的视频帧总数超过 360 万。

姿势数据

姿势数据是相对于骨架给出的。处于一致性和方便考虑,对所有参数化使用相同的 32 个关节骨架。在测试中,我们减少了相关关节的数量,例如每只手和每只脚只留下一个关节。

注意

使用该数据集请在参考文献出引用如下两篇文献:

@article{h36m_pami,

author = {Ionescu, Catalin and Papava, Dragos and Olaru, Vlad and Sminchisescu, Cristian},

title = {Human3.6M: Large Scale Datasets and Predictive Methods for 3D Human Sensing in Natural Environments},

journal = {IEEE Transactions on Pattern Analysis and Machine Intelligence},

publisher = {IEEE Computer Society},

volume = {36},

number = {7},

pages = {1325-1339},

month = {jul},

year = {2014}

}

@inproceedings{IonescuSminchisescu11,

author = {Catalin Ionescu, Fuxin Li, Cristian Sminchisescu},

title = {Latent Structured Models for Human Pose Estimation},

booktitle = {International Conference on Computer Vision},

year = {2011}

}