第一章内容

信息熵:表示信源的信息选择的不定度的测度

信号:是消息的载体,表示消息的物理量

信源编码器:数据压缩,提高有效性

信道编码:加入纠错元素,提高可靠性,抗干扰能力加强

方差公式:

D(X)=E{[x-E(X)2]}=E(X2)-E2(X)

第二章内容

自信息量:I(xi)=-log p(xi)

自信息量的定义反映了时间自身的不确定性

小概率事件包含的不确定性大,其自信息量大,而大概率事件则相反

联合自信息量:

I(xiyj)=-log p(xiyj)

若两事件独立,则I(xiyj)=I(xi)+I(yj)

条件自信息量:在一事件给定条件下的条件自信息量

I(xi|yj)=-log p(xi|yj)

I(xiyj)=I(xi|yj)+I(yj)

I(x1x2…xn)=I(x1)+I(x2|x1)+…I(xn|x1x2…xn-1)

即xi的发生将帮助减小或增大yj自身的不确定性

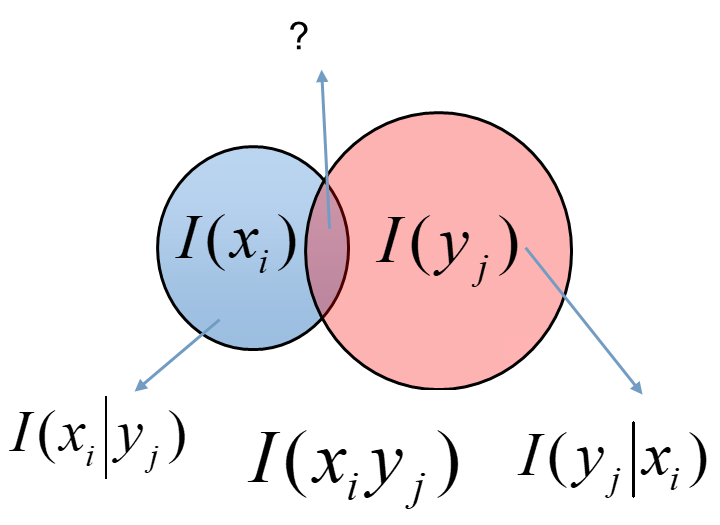

维拉图

互信息量:事件一发生给出关于事件二的信息量

I ( x i ; y j ) = p ( x i ∣ y j ) p ( x i ) = l o g 1 p ( x i ) − l o g 1 p ( x i ∣ y j ) = I ( x i ) − I ( x i ∣ y j ) I(x_i;y_j)=\frac{p(x_i|y_j)}{p(x_i)}=log\frac{1}{p(x_i)}-log\frac{1}{p(x_i|y_j)}=I(x_i)-I(x_i|y_j) I(xi;yj)=p(xi)p(xi∣yj)=logp(xi)1−logp(xi∣yj)1=I(xi)−I(xi∣yj)

表明在yj发生的情况下xi仍具有的不确定性

互信息量可正可负

离散集的平均自信息量,也叫做信息熵

H ( X ) = − ∑ i = 1 q p ( x i ) l o g p ( x i ) H(X)=-\sum_{i=1}^{q}p(x_i)log p(x_i) H(X)=−i=1∑qp(xi)logp(xi)

熵具有对称性,各分量角换次序,熵不变

熵具有非负性,确定场的熵最小,为0

熵具有扩展性,增加极小概率事件,熵值可看作不变

熵具有可加性:H(XY)=H(X)+H(Y|X)

熵具有极值性,最大熵定理,等概场的熵最大,即H(X)=log n

熵具有上凸性,Hn(p1,p2,…pq)是概率分布(p1,p2,…pq)的严格上凸函数