2016

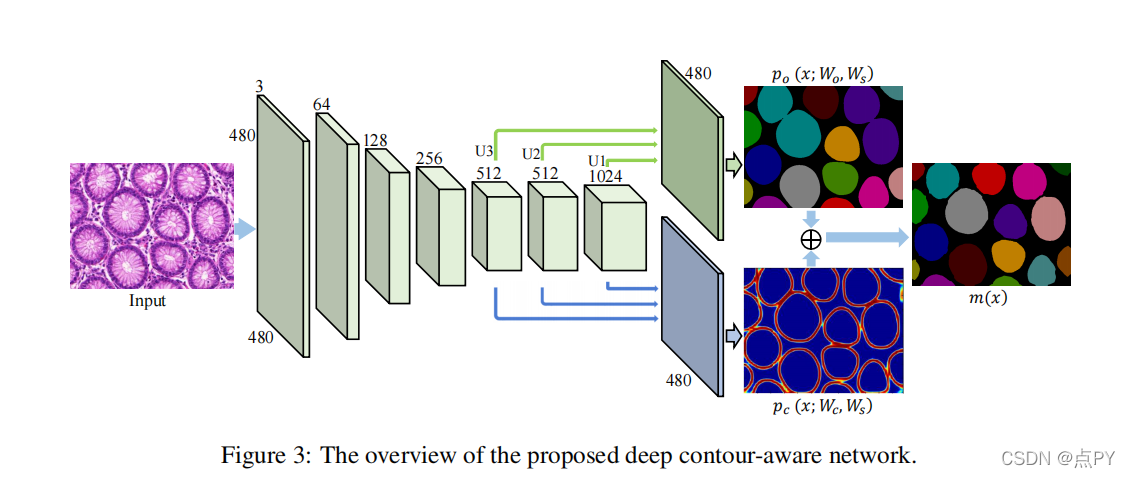

DCAN: Deep Contour-Aware Networks for Accurate Gland Segmentation

摘要: 腺体的形态已被病理学家常规用于评估腺癌的恶性程度。从组织学图像中准确分割腺体是获得可靠的形态学统计数据以进行定量诊断的关键步骤。在本文中,我们提出了一个有效的深度轮廓感知网络(DCAN)来解决这个在统一的多任务学习框架下具有挑战性的问题。在所提出的网络中,从层次结构的多层上下文特征被探索与辅助监督精确的腺体分割。在训练过程中加入多任务正则化后,可以进一步提高中间特征的鉴别能力。此外,我们的网络不仅可以输出准确的腺体概率图,还可以同时描绘清晰的轮廓来分离聚类对象,这进一步提高了腺体的分割性能。这种统一的框架在应用于大规模的组织病理学数据时可以有效地,而无需求助于其他步骤来生成基于低水平线索的轮廓。我们的方法在13个竞争团队中赢得了2015年的MICCAI腺体分割挑战,以显著的优势超过了所有其他方法。

2018

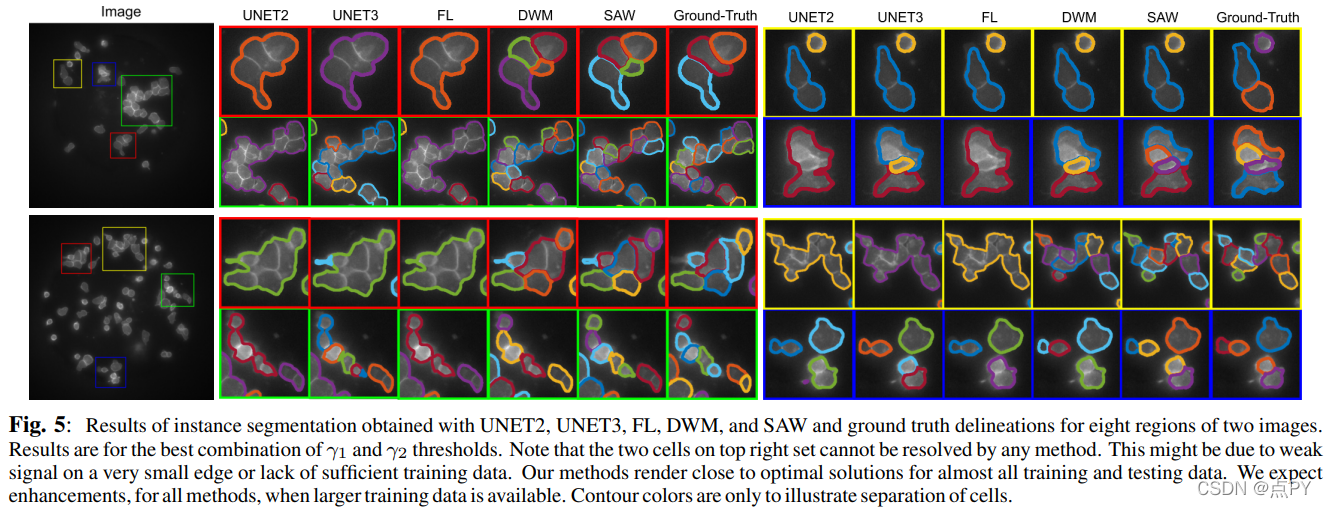

Multiclass Weighted Loss for Instance Segmentation of Cluttered Cells

code : https://github.com/juglab/VoidSeg

摘要: 我们提出了一种新的多类加权损失函数用于杂波细胞的实例分割。我们的动机主要是发育生物学家需要量化和建模血液t细胞的行为,这可能有助于我们理解它们的调节机制,并最终帮助研究人员开发有效的免疫疗法癌症治疗。分割杂乱区域中的单个接触单元具有挑战性,因为共享边界和单元前景上的特征分布相似,因此很难将像素区分为适当的类。我们提出了两种新的权映射应用于加权交叉熵损失函数,它们考虑了类的不平衡和单元几何形状。增强了二值真实训练数据,使学习模型不仅可以处理前景和背景,还可以处理第三类触摸课程。这个框架允许使用U-Net进行培训。实验表明,与其他类似的算法相比,我们的算法在边界充分性和实例检测方面都有显著提高,优于二进制类模型。我们在人工标注的t细胞显微镜图像上验证了我们的结果。

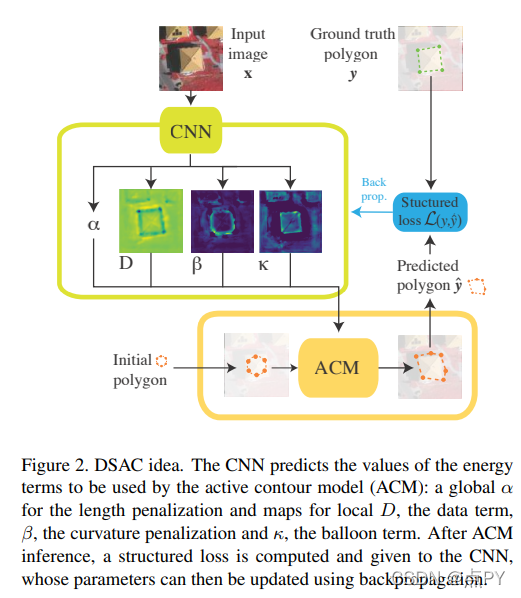

Learning deep structured active contours end-to-end

code : https://github.com/dmarcosg/DSAC

摘要: 世界上覆盖着数以百万计的建筑,精确地了解每个实例的位置和范围对于众多的应用程序是至关重要的。最近,由于使用了卷积神经网络(CNN),自动构建足迹分割模型显示出了卓越的检测精度。然而,即使是最新的演变也难以精确划定边界,这经常导致几何扭曲和相邻建筑实例的无意融合。我们建议利用建筑独特的几何属性来解决这个问题。为此,我们提出了一种新的框架——深度结构化活动轮廓(DSAC),该框架将先验和约束整合到分割过程中,例如连续边界、平滑边缘和锐角。为此,DSAC采用了主动轮廓模型(ACM),这是一组基于约束和先验的多边形模型。我们使用CNN学习每个实例的ACM参数化,并展示如何将所有组件合并到一个结构化输出模型中,使DSAC可以端到端进行培训。我们在三个具有挑战性的构建实例分割数据集上对DSAC进行了评估,在这些数据集上,DSAC的表现优于最先进的技术。将提供代码。

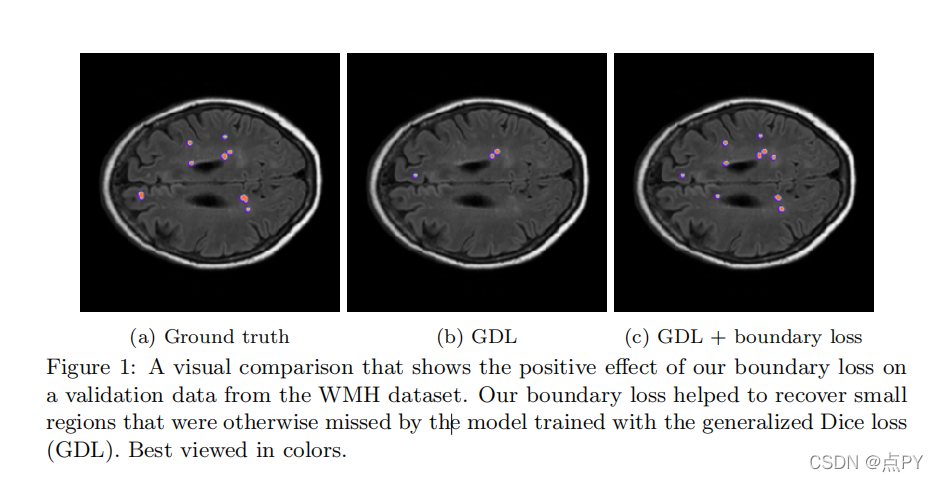

Boundary loss for highly unbalanced segmentation

code: https://github.com/LIVIAETS/boundary-loss

摘要: 广泛用于CNN分割的损失函数,如骰子或交叉熵,都是基于分割区域上的积分。不幸的是,对于高度不平衡的分割,这种区域总和的值在不同的班级之间相差几个数量级,这影响了训练的表现和稳定性。我们提出了一个边界损失,它采用了在等高线空间上的距离度量的形式,而不是区域。这可以减轻高度不平衡问题的困难,因为它使用了区域之间的界面上的积分,而不是区域上的不平衡积分。此外,边界损失还补充了区域信息。受基于图的计算主动轮廓流优化技术的启发,我们将等高线空间上的非对称l2距离表示为区域积分,从而避免了涉及轮廓点的完全局部微分计算。这产生了一个用网络的区域软最大概率输出表示的边界损失,可以很容易地与标准区域损失相结合,并与任何现有的深度网络结构实现N-D分割。我们报告了对不同的不平衡问题的综合评估和比较,表明我们的边界损失可以在提高训练稳定性的同时显著提高性能。

论文的贡献: 在本文中,我们提出了一种边界损失,它在轮廓(或形状)的空间上采用距离度量的形式,而不是区域。我们认为,边界损失可以缓解高度不平衡分割问题中的区域损失相关问题。边界损失不是使用区域上的不平衡积分,而是使用区域之间的边界(界面)上的积分。此外,它提供对区域损失的补充。然而,要表示与CNN的区域软最大输出对应的边界点是具有挑战性的。这一困难可以解释为什么在深度分割网络的背景下避免了边界损失。我们的边界损失是受基于离散图的优化技术计算曲线演化梯度流的[21]。

采用计算边界变化的积分方法,我们将形状(或轮廓)空间上的非对称l2距离表示为区域积分,从而避免了涉及轮廓点的完全局部微分计算。这产生一个边界损失表示为网络区域软最大概率输出的线性函数的和。因此,它可以很容易地与标准的区域损失相结合,并与任何现有的深度网络架构一起实现,用于N-D分割。

2019

Boundary and Entropy-driven Adversarial Learning for Fundus Image Segmentation

code: https://github.com/EmmaW8/BEAL

在来自不同数据集的眼底图像中,准确地分割视盘(OD)和杯状体(OC)对于青光眼疾病的筛查至关重要。跨域差异(域移)阻碍了深度神经网络在不同域数据集上的泛化。在这项工作中,我们提出了一个无监督的领域自适应框架,称为边界和熵驱动的对抗学习(BEAL),以提高OD和OC分割性能,特别是在模糊的边界区域。特别是,我们提出的BEAL框架利用对抗性学习来鼓励目标域的边界预测和掩模概率熵图(不确定性图)与源域相似,产生更准确的边界,抑制OD和OC分割的高不确定性预测。我们在两个公共视网膜眼底图像数据集(Drishti-GS和RIM-ONE-r3)上评估了所提出的BEAL框架,实验结果表明,我们的方法优于最先进的无监督领域自适应方法。

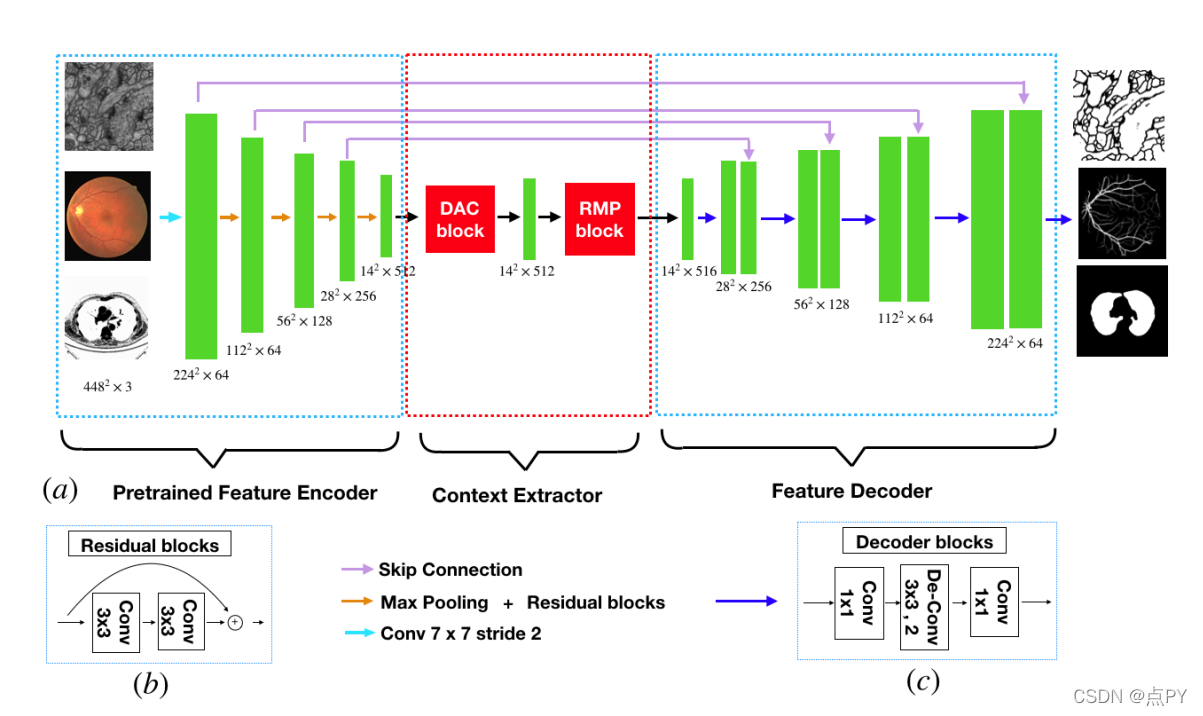

CE-Net: Context Encoder Network for 2D Medical Image Segmentation

code: https://paperswithcode.com/paper/ce-net-context-encoder-network-for-2d-medical

摘要: 医学图像分割是医学图像分析中的一个重要步骤。随着卷积神经网络在图像处理中的快速发展,深度学习已被应用于医学图像分割,如视盘分割、血管检测、肺分割、细胞分割等。以前,已经提出了基于U-net的方法。然而,连续池化和串串卷积操作会导致一些空间信息的丢失。在本文中,我们提出了一种上下文编码器网络(称为CE-Net)来捕获更多的高级信息和保存空间信息,用于二维医学图像分割。CENet主要包含三个主要组件:特征编码器模块、上下文提取器和特征解码器模块。我们使用预训练好的ResNet块作为固定的特征提取器。上下文提取器模块由一个新提出的密集无核卷积(DAC)块和残余多核池(RMP)块组成。我们将所提出的CE-Net应用于不同的二维医学图像分割任务。综合结果表明,该方法在视盘分割、血管检测、肺分割、细胞轮廓分割和视网膜光学相干断层层扫描层分割方面优于原来的U-Net方法和其他最先进的方法。

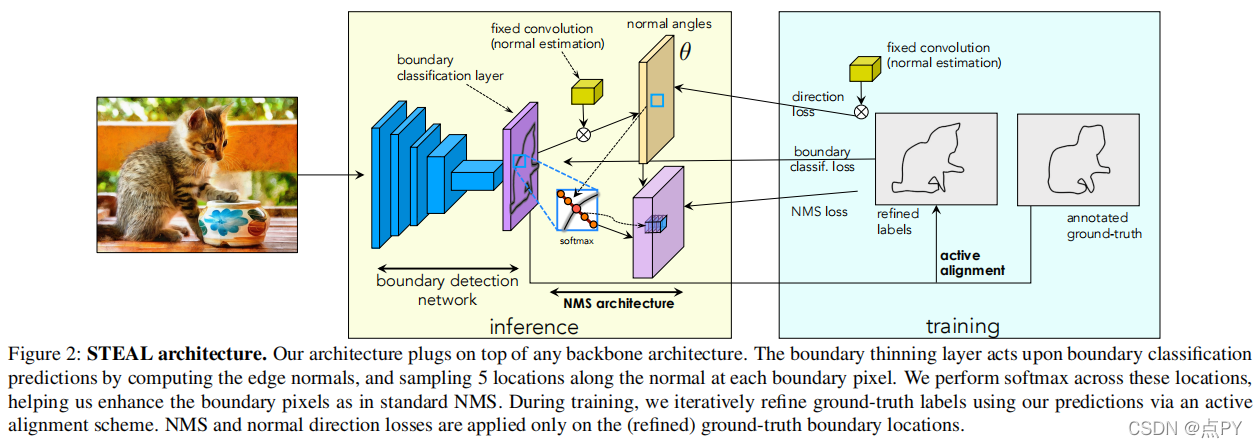

Devil Is in the Edges: Learning Semantic Boundaries from Noisy Annotations

code: https://github.com/nv-tlabs/STEAL

摘要: 我们解决了语义边界预测的问题,其目的是识别属于对象(类)边界的像素。我们注意到,相关数据集包含了相当高水平的标签噪声,这反映了精确的注释是费力的,因此注释者在质量和效率进行权衡。我们的目标是通过在训练过程中明确地推理注释噪声来学习尖锐和精确的语义边界。我们提出了一个简单的新层和损失,可以用于现有的基于学习的边界检测器。我们的层/损耗迫使探测器预测沿法向方向的最大响应,同时也规范其方向。我们在训练过程中使用水平集公式进一步解释了真实的对象边界,该公式允许网络以端到端方式从不对齐的标签中学习。实验表明,我们在MF(ODS)方面比CASENet[36]主干网络提高了4%以上,在AP方面提高了18.61%,优于目前所有最先进的方法,包括那些处理对齐的方法。此外,我们还表明,我们的学习网络可以用来显著改善粗分割标签,使自己成为一种有效的方法来标记新数据。

2020

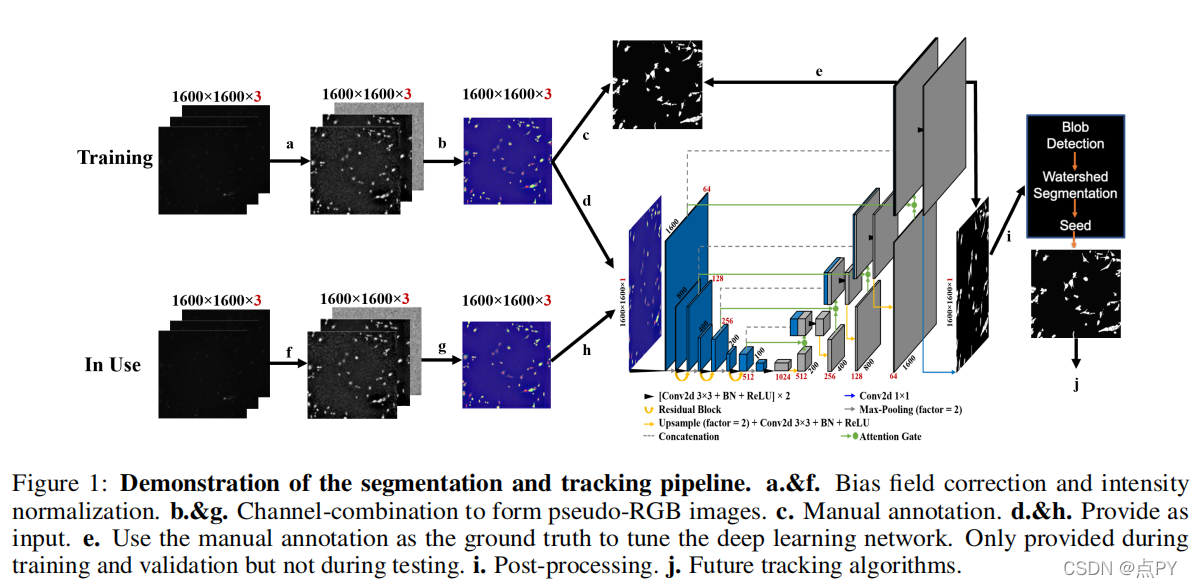

SEGMENTATION WITH RESIDUAL ATTENTION U-NET AND AN EDGE-ENHANCEMENT APPROACH PRESERVES CELL SHAPE FEATURES

code: https://github.com/SAIL-GuoLab/Cell_Segmentation_and_Tracking

摘要: 在活的单个细胞中推断基因表达动态的能力需要强大的细胞分割,而其中一个挑战是无定形或不规则形状的细胞边界。为了解决这个问题,我们修改了U-Net结构,以在荧光广角显微镜图像中分割细胞,并定量评估了其性能。我们还提出了一种新的损失函数方法,强调在细胞边界上的分割精度,并鼓励形状特征的保存。我们提出的灵敏度为97%,93%的特异性,91%的Jaccard相似度和95%的骰子系数,我们提出的边缘增强残差注意力U-Net的分割性能超过了传统指标评估的最先进的U-Net。更值得注意的是,同样的候选方案在保存有价值的形状特征方面也表现最好,即面积、偏心度、主轴长度、坚固度和方向。这些形状特征保存的改进可以作为下游细胞跟踪和量化细胞统计或特征变化的有用资产。

Improving Semantic Segmentation via Decoupled Body and Edge Supervision

code: https://github.com/lxtGH/DecoupleSegNets

摘要: 现有的语义分割方法要么通过建模全局上下文来提高对象的内部一致性,要么通过多尺度特征融合沿着其边界细化对象的细节。本文提出了一种新的语义分割范式。我们的见解是,语义分割的吸引力性能需要明确地建模物体体和边缘,这对应于图像的高频率和低频率。为此,我们首先通过学习一个流场来扭曲图像特征,以使物体的部分更加一致。在解耦监督下,通过明确地采样不同的部分(身体或边缘)像素,进一步优化得到的身体特征和残边特征。我们表明,所提出的框架与不同的基线或骨干网络导致更好的对象内部一致性和对象边界。在城市景观、CamVid、KIITI和BDD等四大道路场景语义分割基准上进行的大量实验表明,我们提出的方法在保持高推理效率的同时,建立了新的技术水平。特别是,我们在只有精细注释的数据下实现了83.7mIoU%。

论文的贡献:

- 我们提出了一种新的语义分割任务框架,通过解耦身体和边缘与不同的监督。

- 我们提出了一个轻量级的基于流的聚合模块,通过学习到的偏移场将每个像素扭曲到对象的内部部分,以保持每个对象的身体部分的一致性。

- 我们提出的模块可以插入到最先进的分割方法中,以提高它们的性能,而成本可以忽略不计。我们在四个竞争的场景解析数据集上进行了广泛的实验,并取得了最佳的性能。

2021

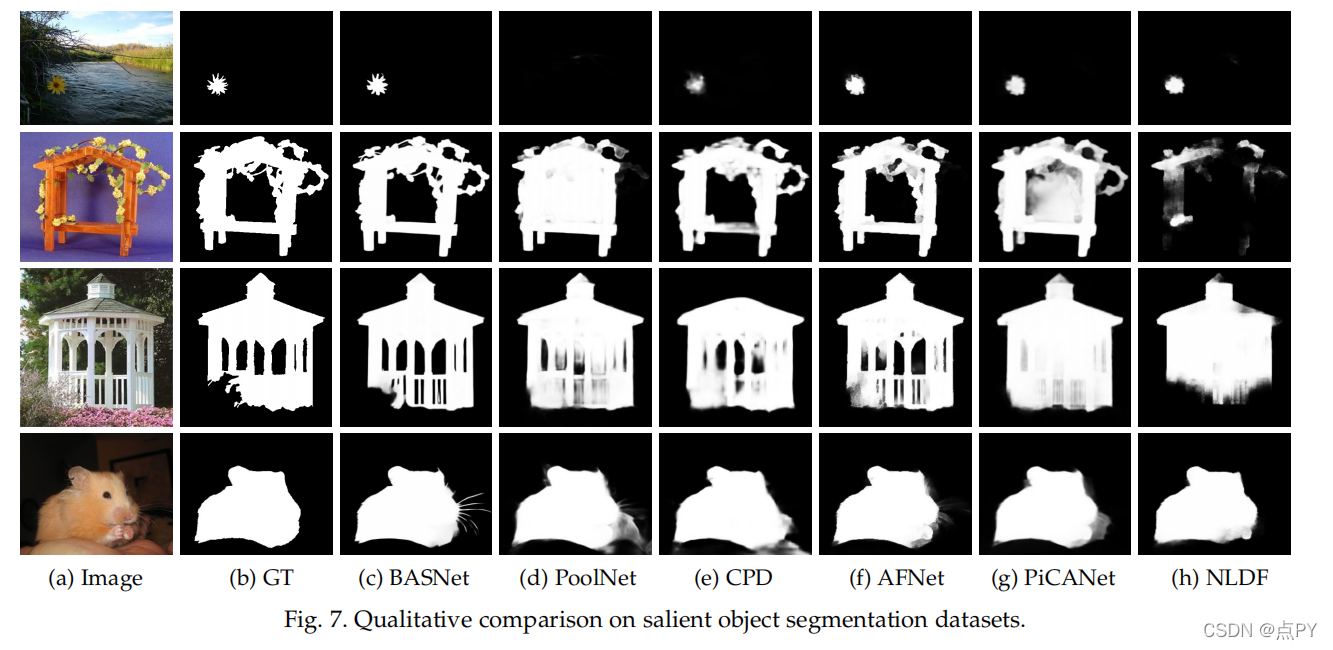

Boundary-Aware Segmentation Network for Mobile and Web Applications

code: https://github.com/NathanUA/BASNet

摘要: 虽然深度模型极大地提高了图像分割的准确性和鲁棒性,但获得具有高精度边界和精细结构的分割结果仍然是一个具有挑战性的问题。在本文中,我们提出了一个简单而强大的边界感知分割网络(BASNet),它包括一个预测-细化架构和一个混合损失,用于高精度的图像分割。该预测-细化体系结构由密集监督的编解码器网络和残差细化模块组成,分别用于预测和细化分割概率图。混合损失是二进制交叉熵、结构相似性和交叉过并损失的组合,它指导网络学习三级(即像素级、补丁级和地图级)层次表示。我们评估了我们的BASNet在两个反向任务,包括突出的目标分割,伪装的目标分割,表明它具有非常激烈的分割边界的性能。重要的是,BASNet在单个GPU上以超过70帧每秒的速度运行,这有利于许多潜在的实际应用程序。基于BASNet,我们进一步开发了两个(接近)商业应用:ARCOPY&Paste,其中BASNet与增强现实集成以“复制”和“粘贴”现实对象,以及对象切割,这是一个基于web的自动去除对象背景的工具。这两种应用程序已经引起了大量的关注,并对现实世界产生了重要的影响。

论文的贡献:

- 我们开发了一种新的边界感知图像分割网络BASNet,它包括一个深度监督的编解码器和一个残差细化模块,以及一种新的混合损失,融合BCE、SSIM和IoU,在像素级、补丁级和地图级三个层次上监督精确图像分割的训练过程。

- 我们进行全面的评估提出的方法包括比较25最先进的(SOTA)方法在六个广泛使用的公共突出对象分割数据集,与16模型SOC(突出对象杂乱)数据集和比较13伪装对象检测(COD)模型在三个公共鳕鱼数据集。BASNet在区域评价指标方面取得了极具竞争力的性能,而在边界评价指标方面则优于其他模型。

- 我们开发了两个(接近)商业应用程序,AR复制和粘贴和对象切割,基于我们的基础网。这两个应用程序进一步证明了我们的模型的简单性、有效性和效率。

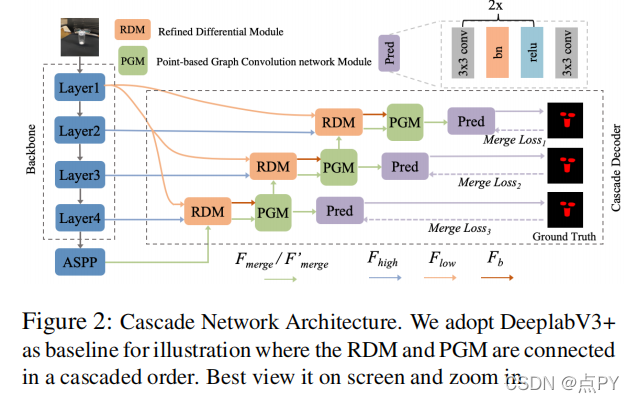

Enhanced Boundary Learning for Glass-like Object Segmentation(ICCV)

code : https://github.com/hehao13/EBLNet

摘要:类似玻璃的物体,如窗户、瓶子和镜子,在现实世界中广泛存在。感知这些物体有很多应用,包括机器人的导航和抓取。然而,由于玻璃状物体背后的任意场景,这项任务是非常具有挑战性的。本文旨在通过增强的边界学习来解决玻璃样目标分割问题。特别地,我们首先提出了一个新的改进的微分模块,输出更精细的边界线索。然后,我们引入了一个基于边缘感知点的图卷积网络模块来建模沿边界的全局形状。我们使用这两个模块来设计一个解码器,产生准确和干净的分割结果,特别是在物体轮廓上。这两个模块都是轻量级和有效的:它们可以嵌入到各种分割模型中。在三个最近的玻璃样物体分割数据集上的广泛实验中,包括Trans10k,MSD和GDD,我们的方法建立了新的最先进的结果。我们还说明了我们的方法在三个一般的分割数据集上的强泛化特性,包括城市景观,BDD,和COCO的东西。

论文的贡献:

- 我们分析了一些现有的方法,如DANet[13],Trans10k[55]和GDNet[40],然后确定了它们在玻璃样物体分割任务中的缺点。

- 我们提出了一个精确的微分模块(RDM)来生成精确的边和一个有效的基于点的图卷积网络模块(PGM)用于全局边缘特征学习。然后提出了一个联合损失函数来对整个模型进行监督。

- 大量的实验和分析表明了我们的模型的有效性和泛化性。我们在三个具有挑战性的最近提出的玻璃样物体分割基准上取得了最先进的结果。

Boundary Guided Context Aggregation for Semantic Segmentation

code: https://github.com/mahaoxiang822/Boundary-Guided-Context-Aggregation

摘要: 近年来关于语义分割的研究开始注意到边界信息的重要性,大多数方法都将边界视为语义细节的补充。然而,简单地结合边界和主流特征并不能保证语义建模的整体改进。与之前的研究相比,我们利用边界作为上下文聚合的重要指导,以促进对图像的整体语义理解。为此,我们提出了一种边界引导上下文聚合网络(BCANet),其中多尺度边界提取器借用主干特征(MSB)被专门用于精确的边界检测。在此基础上,进一步提出了一种由非局部网络改进的边界引导上下文聚合模块(BCA),以捕获边界区域内像素与对象内像素之间的长期依赖关系。通过沿着边界聚合上下文信息,同一类别的内部像素获得了相互的收益,从而增强了类内的一致性。我们在城市景观和ADE20K数据库上进行了广泛的实验,并通过最先进的方法获得了可比较的结果,清楚地证明了所提出的方法的有效性。

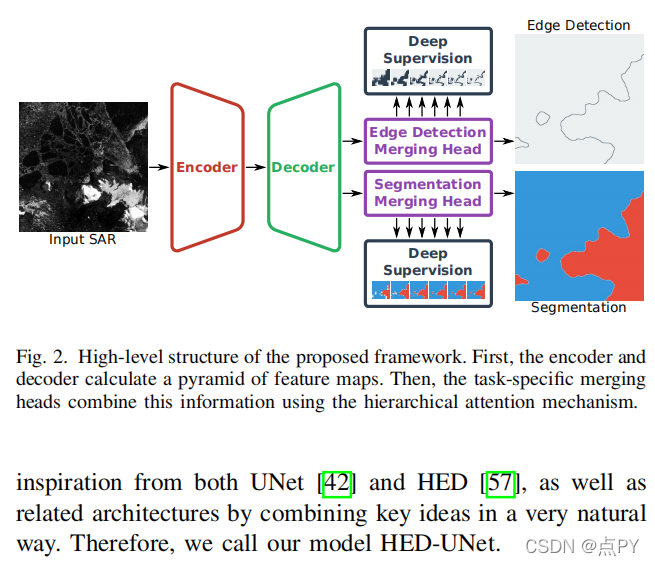

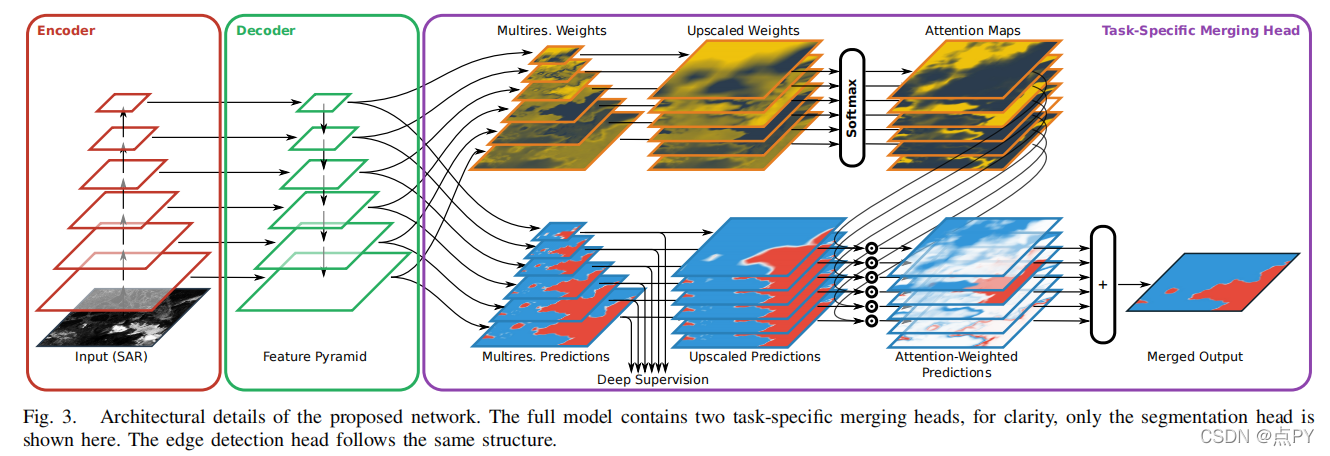

HED-UNet: Combined Segmentation and Edge Detection for Monitoring the Antarctic Coastline

code: https://github.com/khdlr/HED-UNet

摘要: 近年来,基于深度学习的海岸线检测算法已经开始超越传统的统计方法。然而,它们通常只被训练为单一目的的模型,以分割陆地和水或划定海岸线。与此相反,在执行人工海岸线检测时,人类注释者通常会保留分割和轮廓的心理地图。为了考虑这一任务二偶性,我们设计了一个新的模型,将这两种方法结合在一个深度学习模型中。通过从语义分割框架(UNet)和边缘检测框架(HED)的主要构件中获得灵感,这两个任务以一种自然的方式结合起来。通过在多分辨率下对侧预测进行深度监督,使训练有效。最后,引入一种层次注意机制,将这些多尺度预测合并到最终的模型输出中。这种方法比其他传统的和基于深度学习的海岸线检测方法的优势在覆盖南极海岸部分地区的哨兵-1图像数据集上得到了证明,那里的海岸线检测是出了名的困难。