背景:在云服务器上,使用logstash进行两个es之间的数据同步,刚开始同步不到半分钟(很短的时间),然后就提示

[2019-02-27T15:09:38,036][INFO ][logstash.pipeline ] Pipeline started successfully {:pipeline_id=>"main", :thread=>"#<Thread:0x1306ccff sleep>"}

[2019-02-27T15:09:38,369][INFO ][logstash.agent ] Pipelines running {:count=>1, :running_pipelines=>[:main], :non_running_pipelines=>[]}

[2019-02-27T15:09:41,835][INFO ][logstash.agent ] Successfully started Logstash API endpoint {:port=>9600}

Killed

以前是需要经过很长时间才会结束,现在是直接运行很短时间,就结束了,而且显示了 killed。同步到的数据量,很少。猜测是OOM溢出。

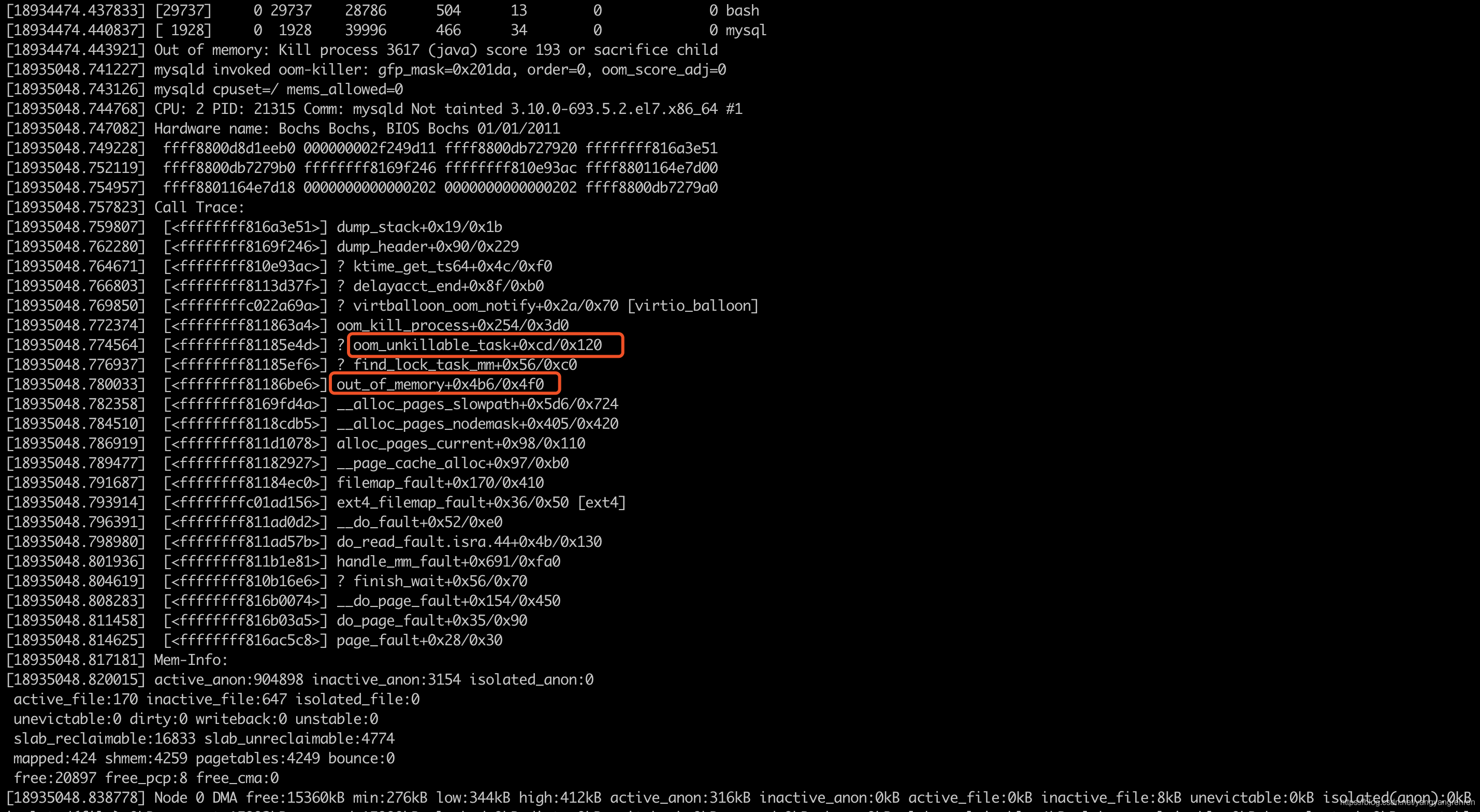

使用dmesg | more命令查看具体信息,然后按enter看向下内容,或者ctrl + F 向下滚动一屏。

‘more’。 ‘tail’, ‘less ’或者‘grep’文字处理工具来处理‘dmesg’命令的输出。由于dmesg日志的输出不适合在一页中完全显示,因此我们使用管道(pipe)将其输出送到more或者less命令单页显示。

dmesg | head -20

dmesg | tail -20

最终发现,的确是OOM了。

htop命令查看后,总共3.7G内存,已用了2.8G,可用内存较少。kill掉一些占内存较大的进程,然后重新执行logstash命令,正常了,之后数据量也能核对一致。

[2019-02-27T18:54:21,971][INFO ][logstash.pipeline ] Pipeline started successfully {:pipeline_id=>"main", :thread=>"#<Thread:0x1152ebe2 run>"}

[2019-02-27T18:54:22,103][INFO ][logstash.agent ] Pipelines running {:count=>1, :running_pipelines=>[:main], :non_running_pipelines=>[]}

[2019-02-27T18:54:22,645][INFO ][logstash.agent ] Successfully started Logstash API endpoint {:port=>9600}

[2019-02-27T19:24:02,937][INFO ][logstash.pipeline ] Pipeline has terminated {:pipeline_id=>"main", :thread=>"#<Thread:0x1152ebe2 run>"}

参考:

dmesg七种用法