贴一下汇总贴:论文阅读记录

论文链接:《BERT Post-Training for Review Reading Comprehension and Aspect-based Sentiment Analysis》

一、摘要

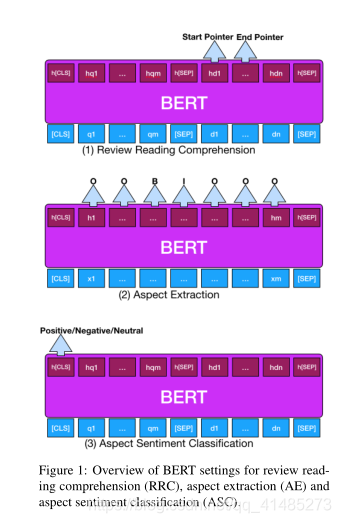

问答在电子商务中扮演着重要的角色,因为它允许潜在客户积极地寻找有关产品或服务的关键信息,以帮助他们作出购买决定。受最近在正式文档上取得成功的机器阅读理解(MRC)的启发,本文探讨了将客户评论转化为可用于回答用户问题的大量知识来源的潜力。我们把这个问题称为复习阅读理解(RRC)。据我们所知,目前还没有对RRC进行任何研究。在这项工作中,我们首先建立了一个RRC数据集,称为viewrc基于一个流行的基于方面的情感分析基准。在回顾RChas有限的RRC(以及基于方面的情感分析)训练实例之后,我们在流行的BERT语言模型上探索了一种新的训练后方法,以提高BERT对RRC的微调性能。为了证明该方法的通用性,本文提出的后训练方法还被应用于其他基于评论的任务,如基于方面的情感分析中的方面抽取和方面情感分类。实验结果表明,所提出的后训练方法是有效的。

二、结论

我们提出了一个新的任务叫做阅读理解(RRC),并研究了将评论作为回答用户问题的宝贵资源的可能性。我们采用BERT作为基础模型,提出了一种联合后训练方法来增强领域知识和任务知识。我们进一步探索了该方法在另外两个基于评论的任务:方面提取和方面情感分类。实验结果表明,微调前的后训练方法是有效的。

三、BERT

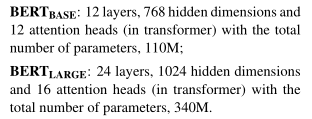

BERT有两个参数密集设置:

四、RRC(Review Reading Comprehension)

训练RRC模型包括最小化损失,设计为两个指针的平均交叉熵:

L R R C = − ∑ log l 1 I ( s ) + ∑ log l 2 I ( e ) 2 L_{RRC}=-\frac{\sum\log l_1I(s)+\sum\log l_2I(e)}2 LRRC=−2∑logl1I(s)+∑logl2I(e)RRC可能会因为对覆盖广泛领域的大规模训练数据进行注释而产生高昂的成本。而BERT严重缺乏两种先验知识:

- 大规模的领域知识(例如,关于特定产品类别的知识);

- 任务意识知识(本例中为MRC/RRC)。

五、Post-training Algorithm