前言

从本文开始逐渐学习iOS自带的多媒体处理框架,例如AVFoundation,VideoToolbox,CoreMedia,CoreVideo实现多媒体的处理,并且将实现方式以及效果和ffmpeg的方式做对比

从一个视频文件中提取出指定时间或者多个指定时间处的视频帧然后转换为图片是很常见的需求,AVFoundation就提供了这样的接口。

本文的目的:

1、提取一个视频文件中10秒处的所有视频帧并且以JPG格式保存到本地

2、提取一个视频文件中某一个时刻的一帧视频并且以JPG格式保存到本地

3、提取一个视频文件中某一个时刻的一帧视频压缩到指定大小并且以JPG格式保存到本地

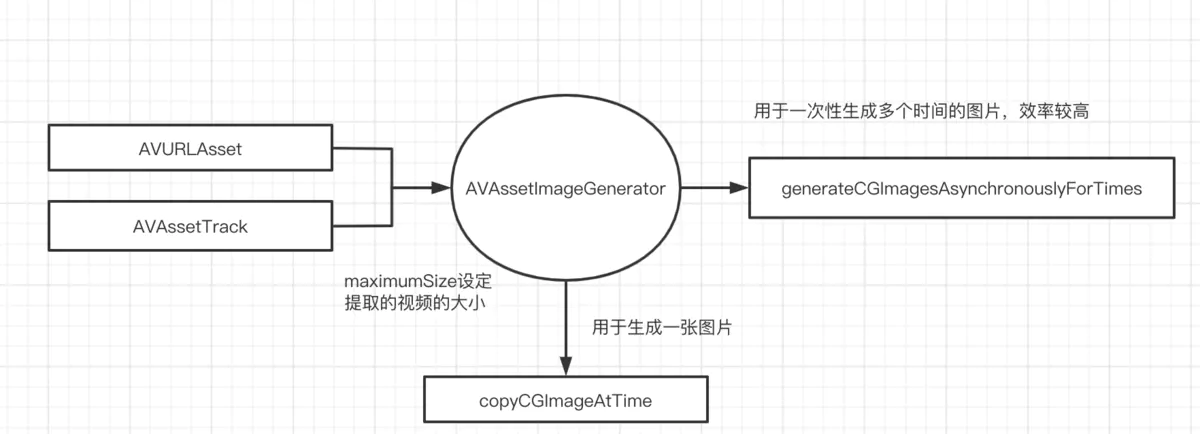

从视频中提取视频帧相关流程

image.png

上图介绍了AVFoundation框架中从视频中提取视频帧的相关对象关系图,可以看到使用AVFoundation从视频中提取视频帧还是相对比较简单的。这套流程同样适用于远程的文件

相关对象及函数介绍

-

1、AVURLAsset

容器对象,代表了要操作的容器。封装,解封装,音视频播放,以及音视频合并等等操作的基础都涉及到这个对象。 -

2、AVAssetTrack

音视频轨道对象,代表了文件中的一路音频流或者一路视频流,它作为每一个要被合并的音频或者视频流被添加到组合对象中最终进行合并 -

3、AVAssetImageGenerator

视频帧提取对象,它用于从本地或者远程视频中提取指定时间处的视频帧。支持对提取的视频进行压缩后输出,通过maximumSize属性来设定最后输出视频帧的分辨率,默认maximumSize为CGSizeZero代表不压缩按照原始大小输出 -

4、-(nullable CGImageRef)copyCGImageAtTime:(CMTime)requestedTime actualTime:(nullable CMTime *)actualTime error:(NSError * _Nullable * _Nullable)outError CF_RETURNS_RETAINED;

提取指定时刻的一帧视频 -

5、-(void)generateCGImagesAsynchronouslyForTimes:(NSArray<NSValue *> *)requestedTimes completionHandler:(AVAssetImageGeneratorCompletionHandler)handler;

当提取多个时间处的视频帧时用此方法比较效率

实现代码

#import <Foundation/Foundation.h>

@interface AVGetImage : NSObject

/** 实现功能:

* 从视频文件中截图指定时间段的视频帧所有视频帧,并最终以JPG的格式保存到指定目录中

*/

- (void)getImageFromURL:(NSURL*)srURL saveDstPath:(NSString*)dstPath;

@end

#import "AVGetImage.h"

#import <AVFoundation/AVFoundation.h>

#import <UIKit/UIKit.h>

@implementation AVGetImage

{

// 视频处理队列信号量

dispatch_semaphore_t processSemaphore;

}

- (void)getImageFromURL:(NSURL*)srURL saveDstPath:(NSString*)dstPath

{

processSemaphore = dispatch_semaphore_create(0);

AVURLAsset *asset = [[AVURLAsset alloc] initWithURL:srURL options:nil];

// 从视频中提取视频帧同样适用于远程文件

// asset = [[AVURLAsset alloc] initWithURL:[NSURL URLWithString:@"https://images.flypie.net/test_1280x720_3.mp4"] options:nil];

[asset loadValuesAsynchronouslyForKeys:@[@"tracks",@"duration"] completionHandler:^{

NSError *error = nil;

AVKeyValueStatus status = [asset statusOfValueForKey:@"tracks" error:&error];

if (status != AVKeyValueStatusLoaded) {

NSLog(@"key value load error %@",error);

return;

}

[self processAsset:asset dst:dstPath];

dispatch_semaphore_signal(self->processSemaphore);

}];

dispatch_semaphore_wait(processSemaphore, DISPATCH_TIME_FOREVER);

NSLog(@"结束了。。。");

}

- (void)processAsset:(AVAsset*)asset dst:(NSString*)path

{

NSArray *videoTracks = [asset tracksWithMediaType:AVMediaTypeVideo];

if (!videoTracks) {

return;

}

AVAssetTrack *track = videoTracks[0];

// 获取视频的帧率信息

CGFloat fps = track.nominalFrameRate;

NSLog(@"formats %f",track.nominalFrameRate);

/** AVAssetImageGenerator 用来从视频中提取图片的一个对象

* 本地和远程文件都可以用该方法进行提取

*/

AVAssetImageGenerator *imageGen = [[AVAssetImageGenerator alloc] initWithAsset:asset];

// 定义请求指定时间上的误差范围,这里设置为0,代表尽量精确

imageGen.requestedTimeToleranceAfter = kCMTimeZero;

imageGen.requestedTimeToleranceBefore = kCMTimeZero;

// 构建10秒处的所有视频帧然后转换成图像

CMTime start = CMTimeMake(10000, 1000);

if (CMTimeGetSeconds(start) > CMTimeGetSeconds(asset.duration)) {

start = CMTimeMake((CMTimeGetSeconds(asset.duration) - 1) * 1000, 1000);

}

NSMutableArray *times = [NSMutableArray array];

for (int i=0; i<fps; i++) {

CMTime oneFps = CMTimeMake(i/fps * 1000, 1000);

CMTime time = CMTimeAdd(start, oneFps);

NSValue *timeValue = [NSValue valueWithCMTime:time];

[times addObject:timeValue];

}

__block BOOL finish = NO;

__block int num = 0;

// 1、此方法用于请求多个视频帧,效率比较高,备注:返回的image由系统自动释放内存

[imageGen generateCGImagesAsynchronouslyForTimes:times completionHandler:^(CMTime requestedTime, CGImageRef _Nullable image, CMTime actualTime, AVAssetImageGeneratorResult result, NSError * _Nullable error) {

NSLog(@"actual time %f",CMTimeGetSeconds(actualTime));

num++;

if (num == fps) {

finish = YES;

}

@autoreleasepool {

UIImage *imageObj = [[UIImage alloc] initWithCGImage:image];

NSData *jpgData = UIImageJPEGRepresentation(imageObj, 1.0);

NSString *spath = [path stringByAppendingFormat:@"/%d.JPG",num];

[jpgData writeToFile:spath atomically:YES];

}

}];

while (!finish) {

usleep(1000);

}

NSLog(@"写入时间段结束了");

// 2、提取指定时间的一个视频帧

CMTime atime = CMTimeMake(5*1000, 1000);

CMTime actime = kCMTimeZero;

NSError *error = nil;

CGImageRef cgimage = [imageGen copyCGImageAtTime:atime actualTime:&actime error:&error];

NSLog(@"need time %f actual time %f",CMTimeGetSeconds(atime),CMTimeGetSeconds(actime));

UIImage *uiimage = [[UIImage alloc] initWithCGImage:cgimage];

NSData *jpgData = UIImageJPEGRepresentation(uiimage, 1.0);

NSString *atPath = [path stringByAppendingPathComponent:@"at.JPG"];

[jpgData writeToFile:atPath atomically:YES];

CGImageRelease(cgimage);

// 3、提取指定时间的一个视频帧,并且进行压缩后输出

// 默认maximumSize为CGSizeZero代表不压缩按照原始大小输出

imageGen.maximumSize = CGSizeMake(300, 150);

cgimage = [imageGen copyCGImageAtTime:atime actualTime:&actime error:&error];

NSLog(@"need time %f actual time %f",CMTimeGetSeconds(atime),CMTimeGetSeconds(actime));

uiimage = [[UIImage alloc] initWithCGImage:cgimage];

jpgData = UIImageJPEGRepresentation(uiimage, 1.0);

atPath = [path stringByAppendingPathComponent:@"at_scale.JPG"];

[jpgData writeToFile:atPath atomically:YES];

CGImageRelease(cgimage);

}

@end

备注:这套从视频中提取视频帧的流程也同样适用于远程的视频文件,将上面中/ asset = [[AVURLAsset alloc] initWithURL:[NSURL URLWithString:@"https://images.flypie.net/test_1280x720_3.mp4"] options:nil];解注释 发现运行结果一样

项目地址

https://github.com/nldzsz/ffmpeg-demo

位于AVFoundation目录下文件AVGetImage.h/AVGetImage.m中