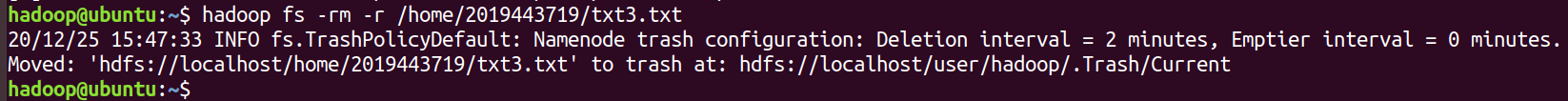

先在 Linux 本地创建三个文本文件: txt1.txt、 txt2.txt、 txt3.txt。 文件文件里面随意输入些内容

gedit txt1.txt

gedit txt2.txt

gedit txt3.txt

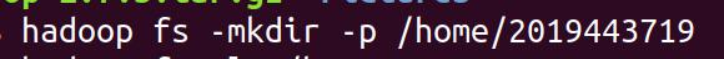

(1) 创建目录(-p 表示父目录都会创建), 创建/home/学号 目录。

先启动服务: start-dfs.sh start-yarn.sh

hadoop fs -mkdir -p /home/2019443719

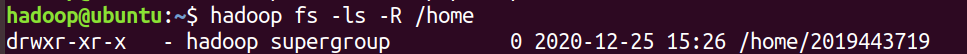

(2) 列出 HDFS 文件下名为/home/学号的文件夹中的文件(-R 表示列出所有子目录)

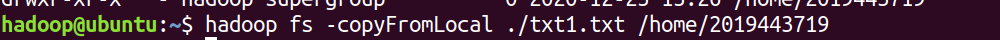

(3) 上传文件, 将本地目录 txt1.txt 文件上传到 HDFS 上/home/学号 目录:

hadoop fs -copyFromLocal ./txt1.txt /home/2019443719

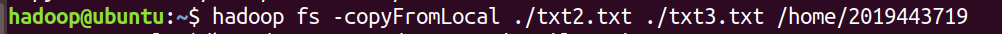

(4) 本地文件 txt2.txt、 txt3.txt 同时上传移动到 HDFS 的/home/学号 目录

hadoop fs -copyFromLocal ./txt2.txt ./txt3.txt /home/2019443719

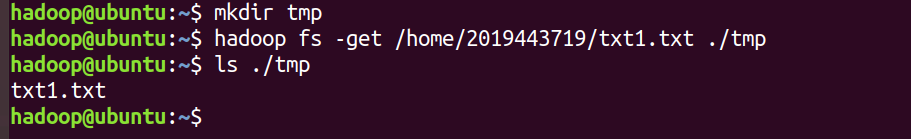

(5)下载文件, 将 HDFS 中的 txt1.txt 文件复制到本地系统/home/hadoop/tmp 目录下。(先在本地创建 tmp)

mkdir tmp

hadoop fs -get /home/2019443719/txt1.txt ./tmp

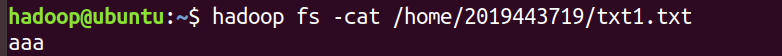

查看文件内容, 查看 HDFS 下的 txt2.txt 文件中的内容.

hadoop fs -cat /home/2019443719/txt1.txt

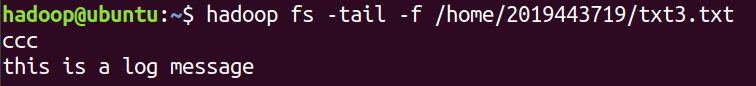

(8) 监视 hdfs 下 txt3.txt 文件的改变

hadoop fs -tail -f /home/2019443719/txt3.txt

(9) 另开一个终端, 往 hdfs 下的 txt3.txt 添加一条消息“this is log message”

cat >> txt4.txt

hadoop fs -appendToFile ./txt4.txt /home/2019443719/txt3.txt

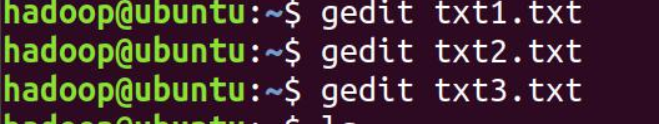

(10) 删除文档, 删除 HDFS 下名为 txt3.txt 的文件(参数 r 为递归删除)

hadoop fs -rm -r /home/2019443719/txt3.txt