全部笔记的汇总贴:统计学习方法读书笔记汇总贴

PDF免费下载:《统计学习方法(第二版)》

支持向量机(support vector machines, SVM)是 一种二类分类模型。它的基本模型是定义在特征空间上的间隔最大的线性分类器,间隔最大使它有别于感知机;支持向量机还包括核技巧,这使它成为实质上的非线性分类器。

本文的大体内容可以参考白板推导系列笔记(六)-支持向量机和白板推导系列笔记(七)-核方法

一、线性可分的支持向量机与硬间隔最大化

支持向量机就是找到最大的间隔分离超平面。

构造一个约束最优化问题并求解

{ m i n w , b 1 2 w T w s . t . y i ( w T x i + b ) ≥ 1 , i = 1 , 2 , ⋯ , N \left\{\begin{matrix} \underset{w,b}{min}\frac{1}{2}w^{T}w \\ s.t.\; y_{i}(w^{T}x_{i}+b)\geq 1,i=1,2,\cdots ,N \end{matrix}\right. { w,bmin21wTws.t.yi(wTxi+b)≥1,i=1,2,⋯,N

求解得到最优的 w ∗ , b ∗ w^*,b^* w∗,b∗

从而得到分离超平面 w ∗ T ⋅ x + b ∗ = 0 {w^*}^T\cdot x+b^*=0 w∗T⋅x+b∗=0以及分类决策函数 f ( x ) = s i g n ( w ∗ T ⋅ x + b ∗ ) f(x)=sign({w^*}^T\cdot x+b^*) f(x)=sign(w∗T⋅x+b∗)

线性可分训练数据集的最大间隔分离超平面是存在且唯一的。

求解可以用对偶法,找寻KKT条件。

二、线性支持向量机与软间隔最大化

很多时候的数据都有一些特异点,除掉这些点以后的数据才是线性可分的,意味着就找不到一条这样的超平面将数据分离成两部分,所以我们需要引进一个松弛量 ξ i ≥ 0 \xi_i\ge0 ξi≥0,这样约束条件就变为 y i ( w T ⋅ x i + b ) ≥ 1 − ξ i y_i(w^T\cdot x_i+b)\ge1-\xi_i yi(wT⋅xi+b)≥1−ξi

所以 1 2 w T w \frac12w^Tw 21wTw变成 1 2 w T w + C ∑ i = 1 N ξ i \frac12w^Tw+C\sum_{i=1}^N \xi_i 21wTw+Ci=1∑Nξi这里 C > 0 C>0 C>0为惩罚参数。

三、非线性支持向量机与核函数

将低维问题转化到更高维来进行分割。

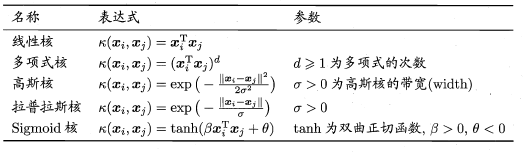

常用的核函数有:

- 线性核函数

- 多项式核函数

- 高斯核函数

- 拉普拉斯核函数

- sigmoid核函数

四、序列最小最优化算法

下一章传送门:统计学习方法读书笔记(八)-提升方法