一、启动方式

要启动Hadoop集群,需要启动HDFS和YARN两个集群。

注意:首次启动HDFS时,必须对其进行格式化操作。本质上是一些清理和准备工作,因为此时的HDFS在物理上还是不存在的。

在node1上执行格式化指令

hadoop namenode -format

二、单节点逐个启动

在node1主机上使用以下命令启动HDFS NameNode:

hadoop-daemon.sh start namenode

在node2主机上使用以下命令启动secondarynamenode:

hadoop-daemon.sh start secondarynamenode

在node1、node2、node3三台主机上,分别使用以下命令启动HDFS DataNode:

hadoop-daemon.sh start datanode

在node1主机上使用以下命令启动YARN ResourceManager:

yarn-daemon.sh start resourcemanager

在node1、node2、node3三台主机上使用以下命令启动YARN nodemanager:

yarn-daemon.sh start nodemanager

以上脚本位于/export/server/hadoop-2.7.5/sbin目录下。如果想要停止某个节点上某个角色,只需要把命令中的start改为stop即可。

三、脚本一键启动——分模块启动(推荐)

启动HDFS

start-dfs.sh

启动Yarn

start-yarn.sh

启动历史任务服务进程

mr-jobhistory-daemon.sh start historyserver

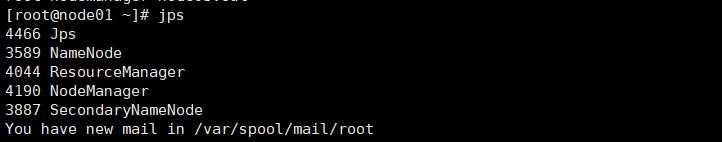

启动之后,使用jps命令查看相关服务是否启动,jps是显示Java相关的进程命令。

node1:

四、遇到的问题

1.问题描述

hadoop启动start-all.sh出错

(master: ssh: connect to host master port 22: Connection refused)

2.原因

不能访问node01、02和03

因为hosts文件中映射未设置对

3.解决

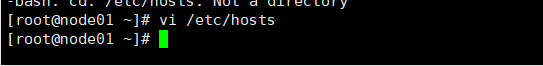

修改hosts文件:

改成虚拟机的静态地址:

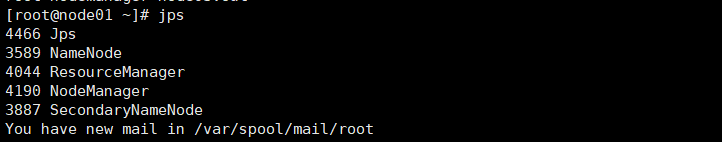

修改后,重新启动集群,jps查看进程:

启动成功!