- 感知机的解不唯一,与初始值和选取的误分类点有关

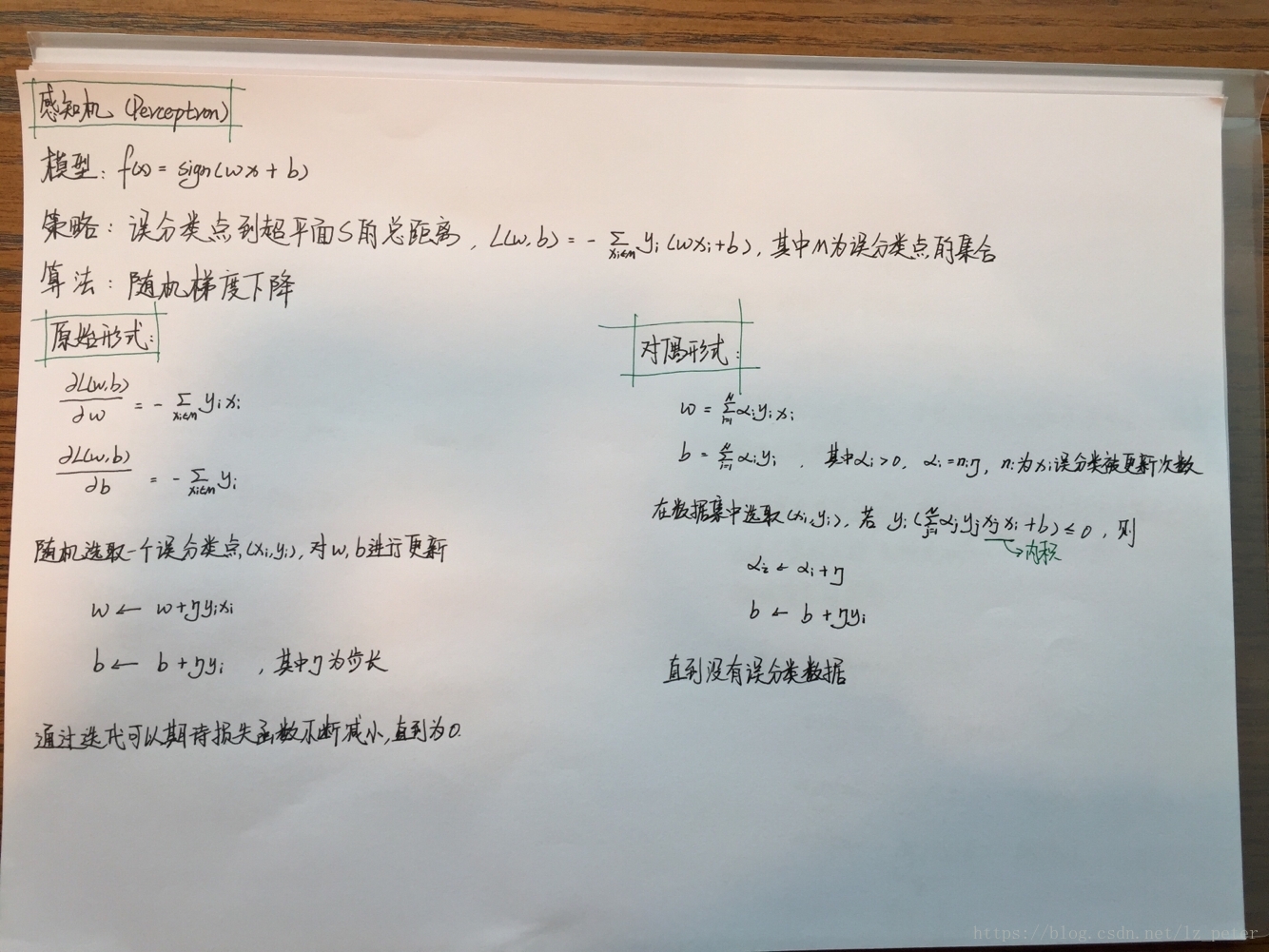

- 感知机学习算法包括原始形式和对偶形式

- 对偶形式是对算法执行速度的优化,引入了Gram矩阵,达到一次计算,多次使用的效果

- 损失函数为误分类点到超平面距离之和(凸函数)

- 参数通过随机梯度下降法来确定(每次使用一个误分类点)

- 对线性可分数据集,感知机算法收敛,即经过有限次迭代可以得到一个将训练数据集完全正确划分的分离超平面及感知机模型

- 当训练集线性不可分时,感知机算法不收敛,迭代结果会发生震荡

- 感知机的分类条件是线性条件,其损失函数也是线性的,所以是一个比较简单的凸优化问题

- 感知机算法规定了θ的更新步骤,它导致θ不能取到中的任意值,而只能取各个数据向量的整系数线性组合。这个限制使得感知机往往会错过最优解。同时,感知机算法的终止条件是所有数据均正确分类,并不是最小化J(θ),所以它只会找到一个可行解,而不是使得J(θ)最小的最优解