目录

Nginx 的常用的命令

sbin目录下:

1、查看 nginx 版本号

./nginx -v

2、启动 nginx

./nginx

或指定配置文件启动

./nginx -c /root/nginx/nginx-1.18.0/conf/nginx.conf

3、停止 nginx

./nginx -s stop

4、重新加载 nginx

./nginx -s reload

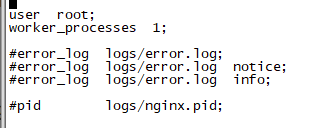

nginx配置文件nginx.conf

组成

包含三部分内容

(1)全局块:配置服务器整体运行的配置指令

比如:worker_processes 1;处理并发数的配置

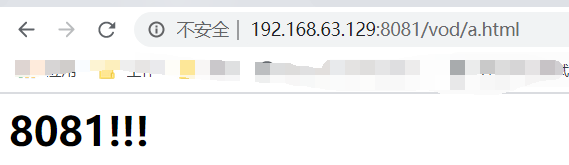

(2)events 块:影响 Nginx 服务器与用户的网络连接

比如:worker_connections 1024; 支持的最大连接数为 1024

(3)http 块

还包含两部分:

http全局块:包括文件引入,MIME-TYPE定义,日志自定义,连接超时时间,单链接请求数上限等。server块:这块和虚拟主机有密切关系,虚拟主机从用户角度看,和一台独立的硬件主机是完全一样的,该技术的产生是为了

节省互联网服务器硬件成本。

每个http块可以包括多个server块,而每个server块就相当于一个虚拟主机。

而每个server块也分为全局server块,以及可以同时包含多个locaton块。

Nginx配置实例——反向代理

反向代理是对服务器的代理,由服务器设立,客户端不了解真正的服务器是谁,使用反向代理可达到负载均衡、保障服务端安全、对客户端隐藏服务器IP等目的。

需求1

打开浏览器。在浏览器地址栏输入地址www.123.com,跳转到linux系统tomcat主页面中。

1.安装tomcat,把tomcat放到linux,解压,bin目录下,./startup.sh 启动即可。8080端口开放一下。

我这里是把tomcat放到另一台机器上。

http://192.168.63.129:8080/

2.访问过程分析

客户端浏览器,实际上访问的是对外暴露的Nginx反向代理,客户端浏览器并不知道真正的服务器是谁

3.在 windows 系统的 host 文件进行域名和 ip 对应关系的配置

ip是nginx的ip与tomcat部署在不同的机器

192.168.63.131 www.123.com

4.修改配置文件nginx.conf

server {

#改为80端口,80端口在访问时,可以不加端口号

listen 80;

#或者直接写当前机器的ip

#当前nginx服务器的地址

server_name localhost;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

root html;

index index.html index.htm;

#需要代理的服务器的地址

proxy_pass http://192.168.63.129:8080/;

#proxy_pass http://cluster;

}

5.重启nginx

./nginx -s reload

6.访问

http://www.123.com/

访问:http://www.123.com/实际上是访问,192.168.63.131:80也就是访问的nginx,然后nginx把这个请求转发到http://192.168.63.129:8080/,所以页面展示的是tomcat的主页。实际上对于用户只知道nginx服务器的ip,并不知道服务器到底是谁,nginx把服务器给隐藏起来了,起到保护作用。

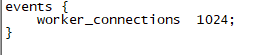

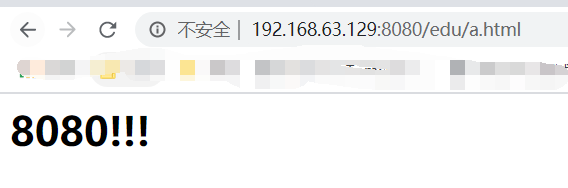

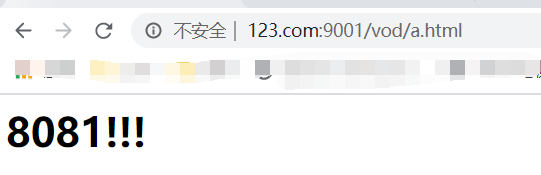

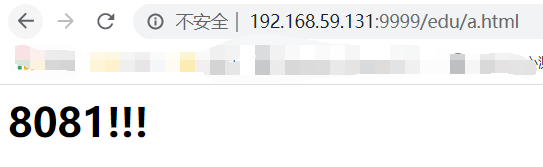

需求2

使用 nginx 反向代理,根据访问的路径跳转到不同端口的服务,nginx 监听端口为 9001,

访问 http://192.168.63.131:9001/edu/ 直接跳转到 127.0.0.1:8080

或者访问 http://www.123.com:9001/edu/ 直接跳转到 127.0.0.1:8080

访问 http:// 192.168.17.129:9001/vod/ 直接跳转到 127.0.0.1:8081

或访问 http:// www.123.com:9001/vod/ 直接跳转到 127.0.0.1:8081

1.准备工作

(1)准备两个 tomcat 服务器,一个 8080 端口,一个 8081 端口

只需要修改:conf目录下的server.xml ,就可以在准备出一个tomcat

修改端口:8009->8019 8080->8081 8005->8015 即可

(2)创建文件夹和测试页面

新建一个a.html

<h1>8081!!!</h1>

放到tomcat8080的webapps下,先新建一个文件夹edu,在把a.html放进去。

http://192.168.63.129:8080/edu/a.html

tomcat8081,操作同上。不过新建的文件名叫vod

http://192.168.63.129:8081/vod/a.html

3.具体配置

再编写一个server块,之前的server块监听的是80端口。开放端口9001

server {

#监听9001端口

listen 9001;

#或者直接写当前机器的ip

server_name localhost;

#访问路径包含edu转发到http://192.168.63.129:8080

location ~ /edu/ {

proxy_pass http://192.168.63.129:8080;

}

location ~ /vod/ {

proxy_pass http://192.168.63.129:8081;

}

}

4.最终测试

http://www.123.com:9001/edu/a.html

http://www.123.com:9001/vod/a.html

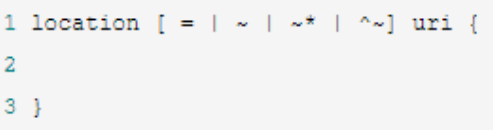

location 指令说明

该指令用于匹配 URL。

语法如下:

1、= :用于不含正则表达式的 uri 前,要求请求字符串与 uri 严格匹配,如果匹配成功,就停止继续向下搜索并立即处理该请求。

2、~:用于表示 uri 包含正则表达式,并且区分大小写。

3、~*:用于表示 uri 包含正则表达式,并且不区分大小写。

4、^~:用于不含正则表达式的 uri 前,要求 Nginx 服务器找到标识 uri 和请求字符串匹配度最高的 location 后,立即使用此 location 处理请求,而不再使用 location 块中的正则 uri 和请求字符串做匹配。

注意:如果 uri 包含正则表达式,则必须要有 ~ 或者 ~* 标识

Nginx配置实例——负载均衡

增加服务器的数量,然后将请求分发到各个服务器上,将原先请求集中到单个服务器上的情况改为将请求分发到多个服务器上,将负载分发到不同的服务器,也就是我们所说的负载均衡。

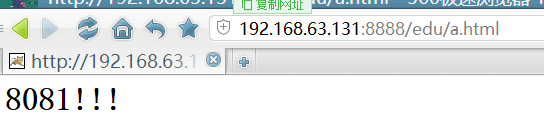

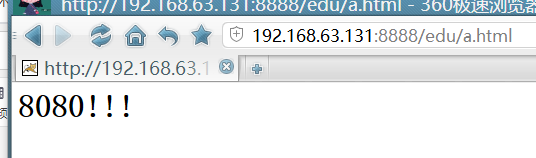

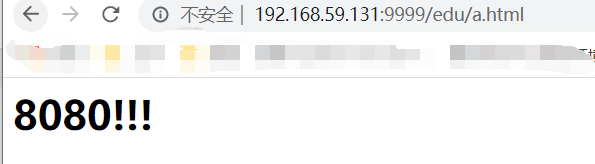

需求1

浏览器地址栏输入地址http://www.123.com:9001/edu/a.html,负载均衡效果,即可以转发到tomcat8080,又可以转发到tomcat8081中去。

1.准备工作

(1)准备两台 tomcat 服务器,一台 8080,一台 8081

(2)在两台 tomcat 里面 webapps 目录中,创建名称是 edu 文件夹,在 edu 文件夹中创建页面 a.html,用于测试

之前已经在8080的webapps目录下准备了edu,现在到8081下的webapps准备edu目录并把a.html放进去,即可。

2.在ngixn配置文件中进行nginx负载均衡配置

#upstream实现负载均衡

upstream myserver{

server 192.168.63.129:8080;

server 192.168.63.129:8081;

}

server {

#监听端口

listen 8888;

#nginx ip

server_name localhost;

#转发的地址

location / {

proxy_pass http://myserver;

}

}

3.重启nginx

./nginx -s reload

访问:http://192.168.63.131:8888/edu/a.html

请求被平均分摊到了8080 8081中

nginx 分配服务器策略

第一种 轮询(默认)

每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器 down 掉,能自动剔除。

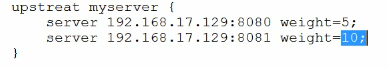

第二种 weight

weight 代表权重默认为 1,权重越高被分配的客户端越多

例如:第二个机器分到的请求比第一个多一倍

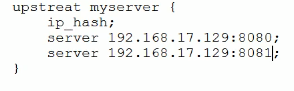

第三种 ip_hash

每个请求按访问 ip 的 hash 结果分配,这样每个访客固定访问一个后端服务器

例如:

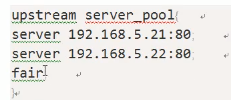

第四种 fair(第三方)

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

Nginx配置实例——动静分离

Nginx 动静分离简单来说就是把动态跟静态请求分开,不能理解成只是单纯的把动态页面和静态页面物理分离。

严格意义上说应该是动态请求跟静态请求分开,可以理解成使用 Nginx 处理静态页面,Tomcat 处理动态页面。

动静分离实现方式:

- 一种是纯粹把静态文件独立成单独的域名,放在独立的服务器上,也是目前主流推崇的方案;

- 另外一种方法就是动态跟静态文件混合在一起发布,通过 nginx 来分开。

1.准备工作

(1)在 liunx 系统中准备静态资源,用于进行访问。

在 /root目录下,创建目录data,data下创建image目录以及www目录

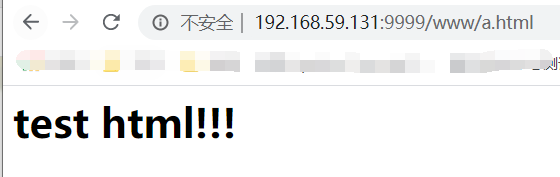

www目录下放置文件a.html

<h1>test html!!!</h1>

image目录下放置一张图片。

注意:这里的静态资源和nginx是同一台机器

2.具体配置

#负载均衡动态资源

upstream tomcat{

server 192.168.59.129:8080;

server 192.168.59.129:8081;

}

server {

#监听端口9999

listen 9999;

server_name localhost;

#转发动态资源

location / {

proxy_pass http://tomcat;

}

#转发静态资源

location ~ .*/(css|js|img|images|www) {

root /root/data/;

index index.html index.htm;

}

}

3.重启nginx,测试

静态资源:

http://192.168.59.131:9999/img/fish3.jpg

访问img和www目录下的静态资源成功。

动态资源:

nginx配置高可用集群

架构图:

(1)需要两台 nginx 服务器

(2)需要 keepalived

(3)需要虚拟 ip

1.配置高可用的准备工作

(1)需要两台服务器 192.168.59.129 和 192.168.59.131

(2)在两台服务器安装 nginx,131之前已经装过了,只需要在129上装,即可。

(3)在两台服务器安装 keepalived

2.在两台服务器安装 keepalived

(1)使用 yum 命令进行安装

yum install keepalived –y

(2)安装之后,在 etc 里面生成目录 keepalived,有文件 keepalived.conf

3.完成高可用配置(主从配置)

(1)修改/etc/keepalived/keepalivec.conf 配置文件

主节点192.168.59.129

vi keepalivec.conf 的时候检测一下 set ff是不是unix,不是的话设置为unix

global_defs { #全局定义

notification_email {

[email protected]

[email protected]

[email protected]

}

notification_email_from [email protected]

smtp_server 192.168.59.129

smtp_connect_timeout 30

router_id LVS_DEVEL #访问到主机,在linux下的host配置 127.0.0.1 LVS_DEVEL

}

vrrp_script chk_http_port

{

script "/etc/keepalived/nginx_check.sh" #检测脚本

interval 3 #(检测脚本执行的间隔) 每隔3秒检测一次,要比监控脚本里的睡眠时间长

weight 2 #设置当前服务器的权重

}

vrrp_instance VI_1 {

state MASTER #当前服务器是主服务器还是从服务器,主MASTER,从BACKUP

interface ens33 #当前服务器绑定的网卡 ,通过ifconfig查看

virtual_router_id 51 # 主、备机的 virtual_router_id 必须相同

priority 100 # 主、备机取不同的优先级,主机值较大,备份机值较小

advert_int 1 #每隔多长时间发一个心跳

authentication {

auth_type PASS #校验权限的方式用密码

auth_pass 1111 #密码

}

virtual_ipaddress {

192.168.59.50 #VRRP H 虚拟地址

}

track_script { #以脚本为监控chk_http_port是前面填写的

chk_http_port

}

}

从节点: 192.168.59.131

vi keepalivec.conf 的时候检测一下 set ff是不是unix,不是的话设置为unix

global_defs {

notification_email {

[email protected]

[email protected]

[email protected]

}

notification_email_from [email protected]

smtp_server 192.168.59.129

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_script chk_http_port

{

script "/etc/keepalived/nginx_check.sh"

interval 3

weight 2

}

vrrp_instance VI_1 {

state BACKUP #改这

interface ens33

virtual_router_id 51

priority 90 #改这

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.59.50

}

track_script { #以脚本为监控chk_http_port是前面填写的

chk_http_port

}

}

(2)在/etc/keepalived添加检测脚本nginx_check.sh

129节点131节点都一样。

vi keepalivec.conf的时候检测一下set ff是不是unix,不是的话设置为unix。chmod +x nginx_check.sh使sh脚本有执行权限yum install psmisc使用killall命令

这个监控脚本的意思是如果nginx挂了,监控到后,就重启nginx,如果重启失败,就把当前节点的keepalived关了。然后就自动切换到从节点上去了。

#!/bin/bash

A=`ps -C nginx ¨Cno-header |wc -l`

if [ $A -eq 0 ];then

/root/nginx/nginx-1.18.0/sbin/nginx

sleep 2

if [ `ps -C nginx --no-header |wc -l` -eq 0 ];then

killall keepalived

fi

fi

(3)把两台服务器上 nginx 和 keepalived 启动,

启动 nginx:./nginx

启动 keepalived:systemctl start keepalived.service

keepalived看日志:tail -500f /var/log/messages

(4)Keepalived监测脚本想要执行,还得关闭selinux

临时关闭:setenforce 0

永久关闭:sed -i "s/^SELINUX=.*/SELINUX=disabled/g" /etc/selinux/config,重启机器

4.最终测试

测试1:试试通过keepalive的虚拟地址能不能访问到nginx

浏览器输入:虚拟地址 http://192.168.59.50/

是通过keepalive的虚拟地址能不能访问到nginx。

测试2:

主节点 192.168.59.129 输入ip a

能看到虚拟ip绑定了主节点

从节点目前虚拟ip是没绑定的

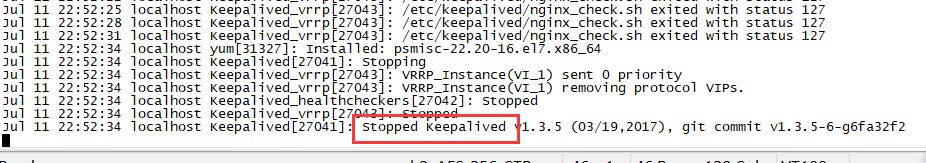

测试3:把主节点停了,模拟宕机

./nginx -s stop

systemctl stop keepalived.service

访问虚拟地址:http://192.168.59.50/

还是能访问,说明从节点起作用了。

从节点 192.168.59.131 输入ip a

能看到虚拟ip绑定了从节点

如果把主节点重新启动,那么虚拟地址会重新绑定回主节点。访问也是访问的主节点。

测试4:关闭主节点nginx,看看keepalived监控脚本会不会重新把nginx启动。

[root@localhost sbin]# ./nginx -s stop

[root@localhost sbin]# ps -ef|grep nginx

root 30106 30047 0 22:44 pts/1 00:00:00 grep --color=auto nginx

[root@localhost sbin]# ps -ef|grep nginx

root 30108 30107 0 22:44 ? 00:00:00 /bin/bash /etc/keepalived/nginx_check.sh

root 30113 1 0 22:44 ? 00:00:00 nginx: master process /root/nginx/nginx-1.18.0/sbin/nginx

root 30115 30113 0 22:44 ? 00:00:00 nginx: worker process

root 30117 30047 0 22:44 pts/1 00:00:00 grep --color=auto nginx

ok的

测试5:模拟nginx挂了并且启动失败,按照预期,应该会执行监控脚本里的关闭keepalived,然后切换到从节点。

[root@localhost sbin]# mv nginx nginx1

将nginx启动脚本改个名

关闭nginx

[root@localhost sbin]# ps -ef|grep nginx

root 30113 1 0 22:44 ? 00:00:00 nginx: master process /root/nginx/nginx-1.18.0/sbin/nginx

root 30115 30113 0 22:44 ? 00:00:00 nginx: worker process

root 30553 30047 0 22:49 pts/1 00:00:00 grep --color=auto nginx

[root@localhost sbin]# kill -9 30113

[root@localhost sbin]# kill -9 30115

因为ngixn启动脚本改名了,那么keepalived监控启动nginx肯定失败,那么keepalived也要关闭

[root@localhost sbin]# ps -ef|grep keepalived

root 31356 30047 0 22:54 pts/1 00:00:00 grep --color=auto keepalived

tail -500f /var/log/messages

看日志也显示关闭了keepalived

访问页面还是能访问,应该用的是从节点了

到从节点里看看:虚拟地址绑定到从节点了

测试通过。

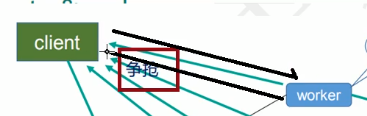

原理

mater 和 worker

worker 如何进行工作的

worker 如何进行工作的

一个 master 和多个 woker 有好处?

(1)可以使用 nginx –s reload 热部署,利用 nginx 进行热部署操作

(2)每个 woker 是独立的进程,如果有其中的一个 woker 出现问题,其他 woker 独立的,继续进行争抢,实现请求过程,不会造成服务中断

设置多少个 woker 合适?

worker 数和服务器的 cpu 数相等是最为适宜的。

连接数 worker_connection?

第一个:发送请求,占用了 woker 的几个连接数?

答案:2 或者 4 个

访问的是静态资源,2个:

访问的是动态资源,4个:

第二个:nginx 有一个 master,有四个 woker,每个 woker 支持最大的连接数 1024,支持的最大并发数是多少?

普通的静态访问最大并发数是: worker_connections * worker_processes /2, 而如果是 HTTP 作 为反向代理来说,最大并发数量应该是 worker_connections * worker_processes/4。worker_processes CPU核数,worker_connections 最大连接数

补

加载外部配置文件

如果配置太多,配置文件会先得很臃肿,可以抽离部分配置到外面。

例如:

vi nginx.conf:

user nginx;

worker_processes 1;

error_log /var/log/nginx/error.log warn;

pid /var/run/nginx.pid;

events {

worker_connections 1024;

}

http {

include /etc/nginx/mime.types;

default_type application/octet-stream;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

sendfile on;

#tcp_nopush on;

keepalive_timeout 65;

#gzip on;

##配置一个上游服务器

upstream gulimall{

server 192.168.43.208:88;

}

##合并其他配置文件

include /etc/nginx/conf.d/*.conf;

}

合并其他配置文件

include /etc/nginx/conf.d/*.conf;

/etc/nginx/conf.d/a.conf:

server {

##监听gulimall.com:80

listen 80;

server_name gulimall.com *.gulimall.com;

location / {

#ngix代理给网关的时候,会丢失请求的host信息

#得重新设置上

proxy_set_header Host $host;

##反向代理到下面的地址

proxy_pass http://192.168.43.208:10000;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/share/nginx/html;

}

}

丢失请求的host信息

ngix代理给网关的时候,会丢失请求的host信息,如果需要,得重新设置上

location / {

#ngix代理给网关的时候,会丢失请求的host信息

#得重新设置上

proxy_set_header Host $host;

##反向代理到下面的地址

proxy_pass http://192.168.43.208:10000;

}