1. 要先搭建zookeeper 在再搭建hbase 而且搭建hbase的时候

hbase_env.sh 里面的 HBASE_MANAGES_ZK=false 不能等于true ,因为hbase本身自带zookeeper,所以要把hbase里面的zookeeper关掉,,,才可以。

2. 在一些配置conf里,有的有两个 bin sbin 所以在配置环境变量的时候要写全!!!

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/sbin:$SPARK_HOME/bin

3. 配置spark: 这是个大活!

你会看到这样的报错:

at io.netty.channel.AbstractChannelHandlerContext$WriteAndFlushTask.write(AbstractChannelHandlerContext.java:1116)

at io.netty.channel.AbstractChannelHandlerContext$AbstractWriteTask.run(AbstractChannelHandlerContext.java:1051)

at io.netty.util.concurrent.SingleThreadEventExecutor.runAllTasks(SingleThreadEventExecutor.java:399)

就是各种 at ,不要惊慌,这是python找库,,,,他找不到库就报这样的错误

q首先确定Java版本,,,#Java -version #javac -version 是否一样

不一样:https://blog.csdn.net/Vast_Wang/article/details/81249038

再就是 先运行pyspark 要是报错 一般是 找不到本地库: 要确定 anaconda(或者是其他库)再每个节点上都安装了,,环境变量也都配置了

再运行 HADOOP_CONF_DIR=/usr/local/bd/hadoop/etc/hadoop pyspark --master yarn --deploy-mode client

要是报错 ,再要是这个错 :

18/08/09 16:02:46 ERROR cluster.YarnSchedulerBackend$YarnSchedulerEndpoint:

Sending RequestExecutors(0,0,Map(),Set()) to AM was unsuccessful

java.io.IOException:Failed tosend RPC 8631251511338434358 to

java.nio.channels.ClosedChannelException

解决办法是

修改yarn-site.xml,添加下列property

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

一定要确保每个节点 都修改 了,,,,,关闭集群,,,启动集群,,,启动spark

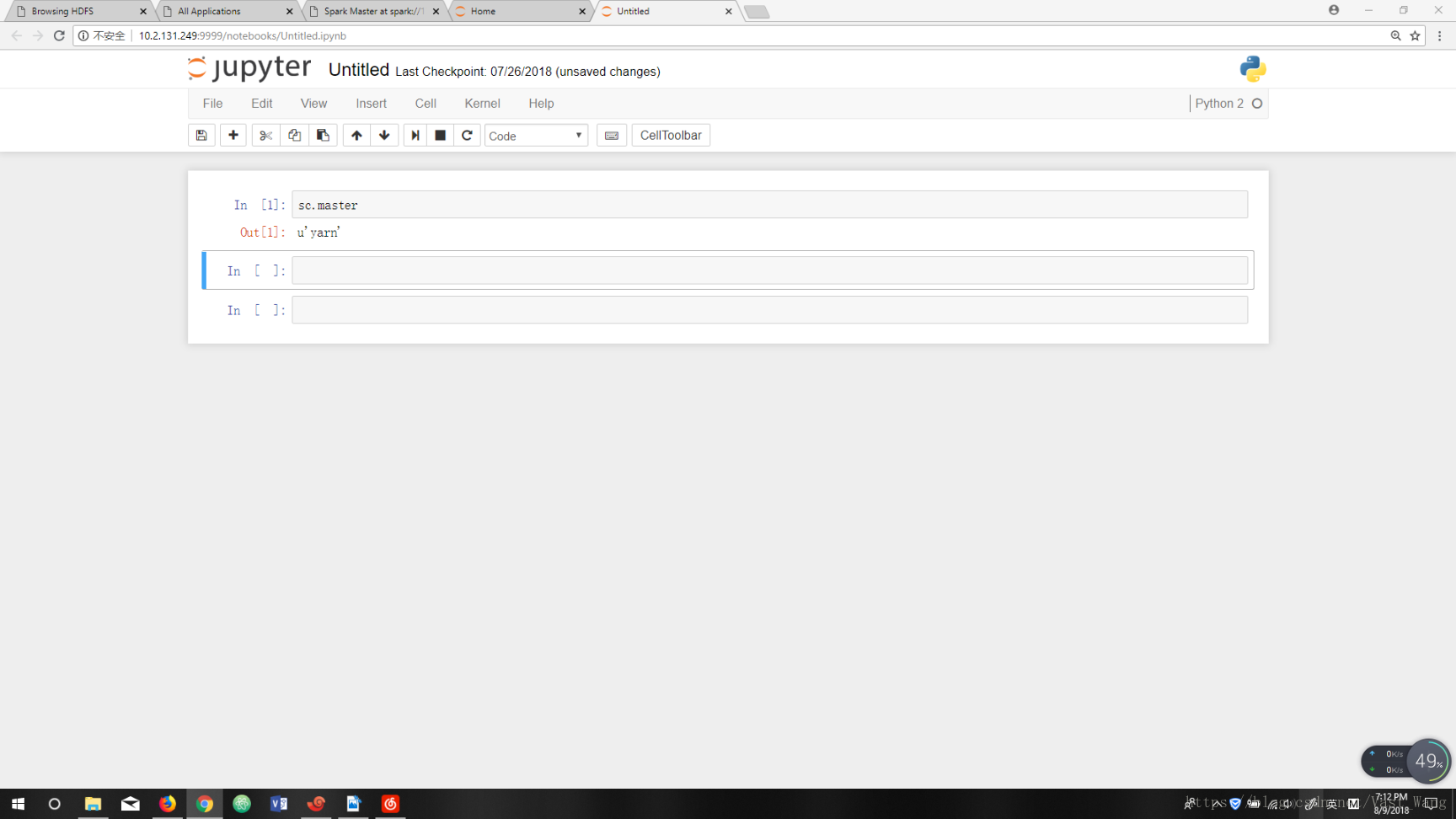

最后这样就是成功了!