https://mp.weixin.qq.com/s/9nf0HCeFS65t4esoRlZN9A

By 超神经

场景描述:近日,IJCAI 2019 的评审结果遭到吐槽,我们对此进行了深度剖析,看看 IJCAI 到底是不是如广大网友说得那样不堪。另外,为了提高论文审稿效率,中国已经在试用 AI 工具协助评审。

关键词:顶级会议 论文审核IJCAI 2019 论文录用结果最近在网络上掀起了一波吐槽浪潮。

5 月 9 日,人工智能领域顶级会议 IJCAI 2019 论文录取结果公布:今年共接收 4752 篇有效提交论文,最终收录 850 篇,录用率为 17.9%,低于历年平均 20% 的录用率。

结果公布后,一时间引起众多投稿者的不满。被拒稿的作者在网上晒出自己的「遭遇」,对评审、打分和 rebuttal 等环节表示质疑。

对此,IJCAI 2019 的程序主席 Sarit Kraus 在 5 月 10 日发表公开信做了回应。她在信中表示:

我很能理解大家对审稿过程、公平性和随机性太强的质疑,我也曾收到很多拒稿信。而此次审稿,我已在尽力降低评议过程的随机性,减少每位 PC 和 SPC 收到的论文数量,增加审稿时间。

然而,面对本次大会总共提交的 4752 篇论文,审稿任务极其困难。我认为, 需要对严格审稿的学术会议的概念进行重新思考和创新。IJCAI 也会听取大家想法,把期刊建设得更好。

一些学者认为这个回应比较中肯,是可以理解并接受的。毕竟,这么多年了,也应该有更多的创新。

愤懑平息之后,我们需要冷静、客观地分析一下,IJCAI 究竟如何?它真的如一些作者所抱怨的「越来越水」了吗?

客观对待,听听多个声音

对于任何争议,我们都不应该只听一面之词。总体来看,IJCAI 这次有点冤枉。

1

国内怨声鼎沸,国外反响平平

首先,怨气最重的地带集中在国内问答社区「知乎」,而国外 Twitter、Reddit 以及 Quaro 等平台上并没有看到相关质疑。

有用户在微博上说,国内学术圈有圈子文化,审稿人会给熟人作者高分,对于没有关系的作者,可能就会给出不够客观公正的评价。此外,今年第一次听说 AAAI 和 IJCAI 查 reviewer interest conflict(审稿人利益斗争),结果找出来 90% 高度嫌疑人都是华人。

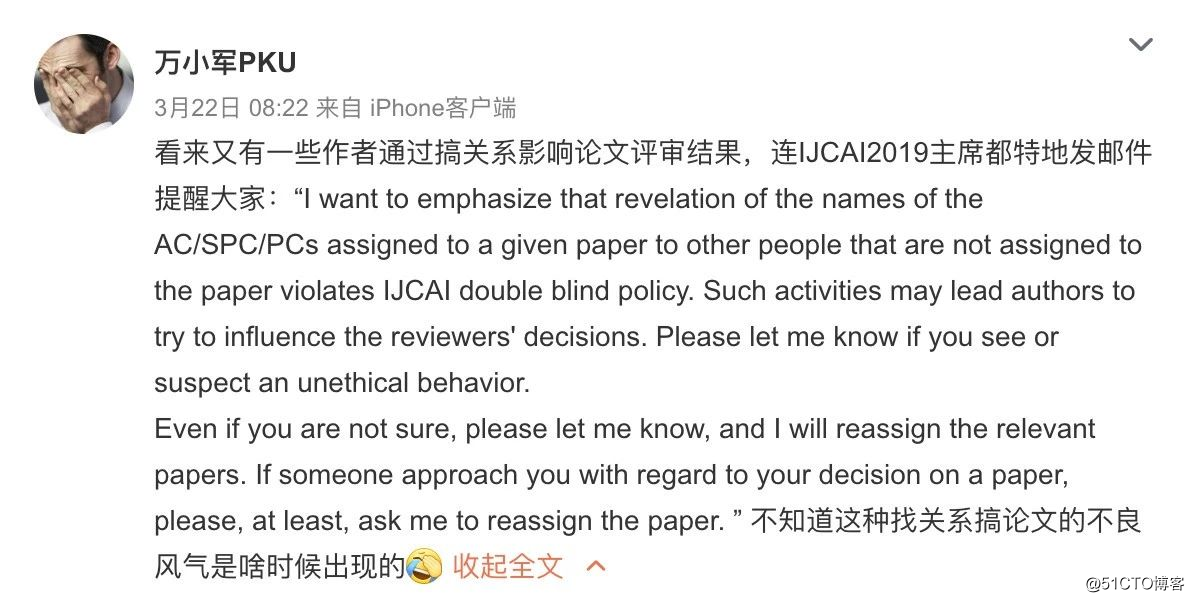

北大万小军老师也曾在微博上提到:「看来又有一些作者通过搞关系影响论文评审结果……不知道什么时候搞的这种不良风气。」

北大万小军老师研究领域为自然语言处理、文本挖掘、人工智能

由此可猜测,也许正是由于自己搞不良风气,才使得审稿人对华人有了偏见,从而没有做到客观评审?

2

中了就是好,不中就不好?

其次,在关于「如何看待 IJCAI 2019 录用结果」的评论中,并不完全一边倒地声讨 IJCAI。总的来说,大部分的埋怨还是来自论文没中的作者。

有用户表示:

「投稿 IJCAI 之前,就应该做好审稿随机化的准备。审稿结果并不是今年才这样的。另外,因为 IJCAI 的论文主题太多,不够聚焦,才会出现审稿人看不懂的情况。因此,投稿人应该往自己研究领域更专业的会议去投。在论文通货膨胀的今天,还是努力写出好文章吧。」

该条评论收到了80多个赞同。而其他网友也对此回应:

「论文中不了就说审稿差,但是为什么不想想自己的工作是否做得足够好。」

一位论文被录用的作者表示:

「看到自己辛苦工作得到的成果被贬低,还是很伤心的。客观地说,我自己的审稿质量还是挺好的,要求很严格。而且我遇到的 reviewer 也比较负责。」

清华大学刘知远老师在评论中回复他:

「不靠谱的审稿毕竟还是少数。不必太在意。」

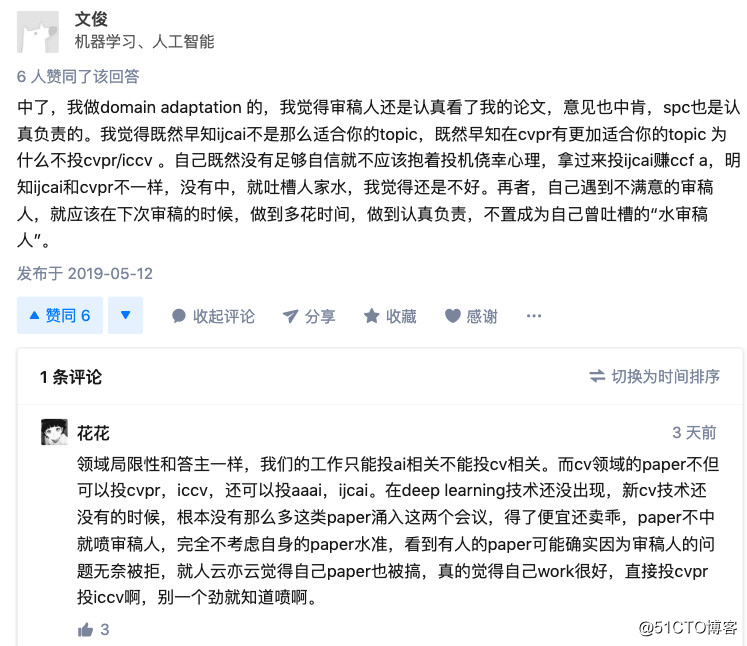

另一位被录用的作者也对吐槽者们提出了意见:

另外还有网友表示,很多人一边说 IJCAI 和 AAAI 太水,一边又把自己明显不够 A 级顶会水平的文章投进去,才会造成这样的情况。

从数据上看,近几年来, IJCAI 的投稿量和录用数量都呈增长趋势,今年接受论文数量更是比去年增加了 37%,达到历史最高。然而,与之相反的是,今年录用率却是近几年来最低,首次低于往年 20% 的平均录用率。

参考数据( IJCAI 近 4 年论文接收量与录用率):

2015 年,共收到 1996 篇投稿,录用 575 篇,录用率 28.8%;

2016 年,共收到 2294 篇投稿,录用率低于 25%;

2017 年,共收到 2540篇投稿,录用 660 篇,录用率为 25.9%,且这 2540 篇论文投稿中,来自中国的最多,占投稿总数的 37%;欧洲、美国均为 18%;

2018 年,共收到 3470 篇投稿,接收论文 710 篇,接收率 20.5%。接收论文中作者来自中国的有 325 篇,占总数的 46%,遥遥领先其他所有国家和地区。

也许正如上文网友所说,由于太多研究者对自己论文质量把握不大,但抱着搏一搏的心态的作者投稿,造成了 IJCAI 审稿资源浪费,这也是造成评审bug 增多的原因之一。

所以,对于本次的录用结果,理性批判是合理的,但是盲目跟风去抱怨就不好了。无论是审稿人和投稿人,都应该好好反省一下。

一则被拒多次的网友评论 IJCAI

没有不被吐槽的顶会

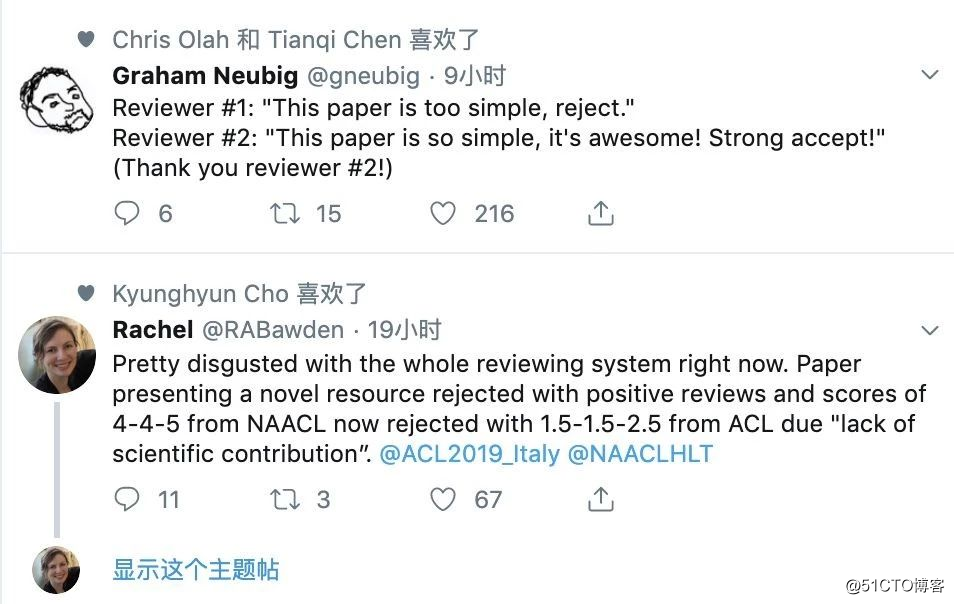

其实,被吐槽的顶会又岂止 IJCAI 一个。我们看到 ICML、AAAI 、NeurlPS 也都有过同样的「遭遇」。似乎放榜后评审被吐槽已经成为惯例。

这不,就在今天,NLP 会议 ACL 刚刚放榜,又引来了一堆诟病。而前不久,在 3 月初放榜的 ICML 2019 同样让 Twitter 上的网友炸开了锅,对评审结果狠狠嘲讽了一番。

ACL 是目前公认的最大规模 NLP 会议,依然难逃被吐槽

所以,面对 AI 领域顶会整体都难逃被吐槽的情况,我们还是花更多时间去寻找自身的不足,写出更优秀的论文。

周志华老师之前曾对 AI 领域的各个会议做过点评,这里引用他对 IJCAI 的评价如下,供大家参考:

IJCAI : AI 最好的综合性会议, 1969 年开始, 每两年开一次, 奇数年开。因为 AI 实在太大,所以虽然每届基本上能录 100 多篇(现在已经到 200 多篇了),但分到每个领域就没几篇了,像 Machine Learning、Computer Vision 这么大的领域每次大概也就 10 篇左右, 所以难度很大。

不过从录用率上来看倒不太低,基本上 20% 左右,因为内行人都会掂掂分量,没希望的就别浪费 reviewer 的时间了。

最近中国大陆投往国际会议的文章像潮水一样,而且因为国内很少有能自己把关的研究组, 所以很多会议都在complain 说中国的低质量文章严重妨碍了 PC 的工作效率。在这种情况下,估计这几年国际会议的录用率都会降下去。

IJCAI 可谓 AI 领域顶会元老

按资历算,IJCAI 可谓众多 AI 领域顶级会议中的元老。

纵观国际人工智能领域顶级会议,IJCAI 是历史最悠久的会议之一,自 1969 年起在美国举行第一届,此后每两年开一次,直到 2015 年起改为每年召开。今年刚好是它的 50 岁生日。

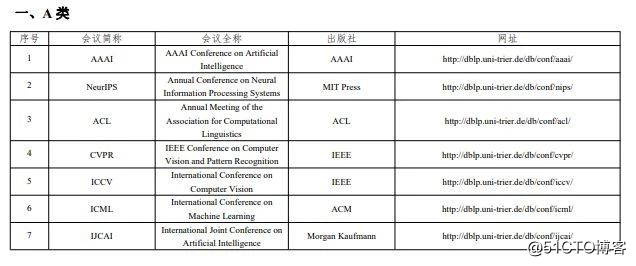

IJCAI 被中国计算机学会(CCF)推荐国际学术会议列表认定为 A 类会议,一直以来在人工智能领域占据非常权威的地位。它的录用标准始终比较严苛,一般保持在 20% 左右。

被 CCF 认定的 AI 领域七大 A 类会议

在 IJCAI 历年最高荣誉奖「卓越研究奖」获奖名单中,一眼望去,基本都是业界名号响亮的大人物。比如他们:

1985 年,John McCarthy,人工智能之父,1971 年图领奖获得者。(有趣的是,IJCAI 还有一个奖项就是以他的名字命名,旨在表彰处于职业中期的研究人员。)

2005 年,Geoffrey E.Hinton,神经网络之父,2018 年图领奖获得者。

2016 年,Michael I.Jordan,美国三院院士,人工智能泰斗。

详细的历届获奖名单,大家有兴趣可以去搜索一下,都是令人膜拜的 AI 界大神。

另外,会议的赞助商也能从一定程度上反应其水平。从 IJCAI 今年的赞助商来看,不乏巨头科技公司,国内有百度、华为、阿里、腾讯等,国外有 IBM Research AI、SONY、BOSCH、HITACHI 以及微软。阵容还是十分强大的。

IJCAI 2019 赞助商列表(部分)

解决方案:用 AI 审 AI 论文

对于这次 IJCAI 2019 录用结果的讨论登上知乎热榜,有人感叹:看来真是进入全民 AI 时代了。

近年来,中国在 AI 领域的发展突飞猛进。在各 AI 顶会不断增长的论文数量中,很大一部分是来自国内的贡献。近 20 年来,中国共累计产出人工智能领域论文 36.9 万篇,产出量位于全球第一,美国第二,是第三位英国的 3.8 倍。

这也难怪 IJCAI 会抱怨巨量的论文降低了 PC 的工作效率。

针对现状,研究者们推出了高效又无偏见的 AI 资助评审人。

昨日,Nature 上发表文章称,中国国家自然科学基金委员会( NSFC )正在试用一个 AI 工具,这个工具可以选择研究人员来审查资助申请,从而让这个过程更有效、更快捷、更公平。

Nature 上昨日发表的文章,地址:

https://www.nature.com/articles/d41586-019-01517-8

该系统将利用自然语言处理技术收集线上科学文献数据库和科学家的个人网页,收集潜在评审人员的出版物或研究项目的详细信息。在使用文本的语义分析来比较资助申请,并确定对审稿人的最佳匹配。

一些研究人员表示,NSFC 采用的方法是世界领先的,不过对于 AI 是否真的能够改善这一过程,他们仍持怀疑态度。

更多顶会都在使用 AI

上个月,挪威研究委员会开始使用自然语言处理技术,将大约 3000 份研究提案分组,并将它们与最佳评审小组进行匹配。

总部位于瑞士的学术出版商 Frontiers(《前沿》)通过 AI 工具 AIRA( Artificial Intelligence Review Assistant )协助审稿人和编辑,以提高效率。

AIRA 系统由内部自定义算法以及行业领先的工具构建,例如 Google,Cro***ef 的 iThenticate 和 Editage 的 Ada。

AIRA 目前主要进行两项关键同行评审任务:质量控制和评审员识别。其算法根据一组质量指标(包括文本重叠、语言、人体图像的存在和其他伦理考虑),来快速准确地评估提交的稿件。达到既定质量门槛的稿件将被传递给编辑,而有任何潜在问题的都会被送到审查团队进行进一步调查。

我们期待,当 AI 工具加入论文评审大军后,审稿人能够从其他环节中节省更多时间,从而认真评审我们的论文,给每位投稿人一个满意的答复。

IJCAI 2019 将于今年 8 月 10 日至 16 日在中国澳门召开,这是在 2013 年北京之后会,第二次在国内召开。

目前距离会议开幕还有 3 个月,就已经如此热闹,届时估计也会很有看头,所以,要去参加吗?

超神经百科

归纳偏好 Inductive bias

归纳偏好是在进行归纳过程中进行选择的考量,对应了学习算法「什么样的模型更好」的假设。

归纳偏好可以看作学习算法自身在一个庞大的假设空间中对假设进行选择的启发式或者 「价值观」。

在具体的现实问题中,这个假设是否成立,即算法的归纳偏好是否与问题本身匹配,大多数时候直接决定了算法能否取得好的性能。