解决Apache Hadoop启动时DataNode没有启动的问题(注意这会删除HDFS中原有的所有数据,如果原有的数据很重要请不要这样做)

1、依次在Hadoop安装目录下执行以下指令启动HDFS并显示当前所有Java进程:

./bin/hdfs namenode -format #格式化NameNode

./sbin/start-dfs.sh #启动HDFS

jps #显示当前所有的Java进程

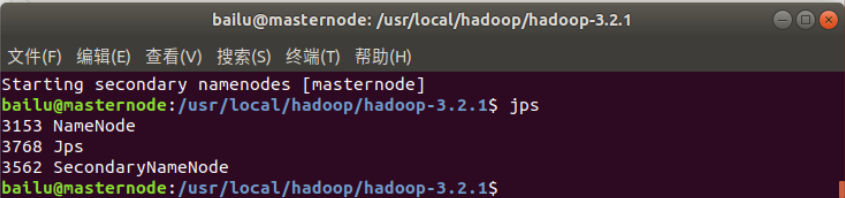

2、当DataNode启动异常时或者没有启动时我们调用jps命令不会显示其进程,如下图所示:

解决方式:

./sbin/stop-dfs.sh #关闭HDFS

rm -r ./tmp #删除tmp文件,注意这会删除HDFS中原有的所有数据,tmp文件目录根据本地目录寻找

./bin/hdfs namenode -format #重新格式化NameNode

./sbin/start-dfs.sh #重启HDFS

jps #显示当前所有的Java进程

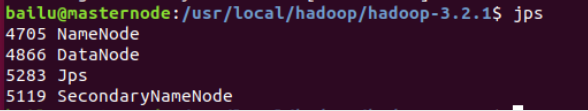

3、成功启动后我们可以看到DataNode的进程:

同时,可以通过Linux本地浏览器访问Web界面(http://localhost:9870)来查看Hadoop的信息:

大家如果还有什么问题、建议或者补充可以留言,看到了我会及时回复!一手资讯请关注本人公众号:WDeerCode代码圈哦!