本节目录

1 架构说明(standalone模式)

2 机器分布

3 安装 Flink 集群前提

4 搭建步骤

5 启动Flink集群

1 架构说明(standalone模式)

standalone 是 Flink 自带的一个分布式集群,它不依赖其他的资源调度框架、不依赖 yarn 等。Spark也有一个自带的分布式资源调度模型,也叫作 standalone。

standalone模式进程名介绍:

JobManager------->进程名字:StandaloneSessionClusterEntrypoint 我们又叫它:Master

TaskManager----->进程名字:TaskManagerRunner 我们又叫它:Worker

2 机器分布

| 机器名(域名) | IP | 角色 |

| lx01 | 192.168.133.3 | JobManager |

| lx02 | 192.168.133.4 | TaskManager |

| lx03 | 192.168.133.5 | TaskManager |

3 安装 Flink 集群前提

- 已安装 JDK

- 关闭防火墙

- 最好是有hadoop环境

- 最好kafka环境

4 搭建步骤

1 下载 Flink 安装包,请点击链接下载:我是下载地址(Flink版本选择:使用最新的 1.9.1 版本;与hadoop整合:选择 2.7.5版本整合包)

2 上传 Flink 安装包至 Linux 服务器 master 节点。使用 tar 命令解压安装包

tar -zxvf

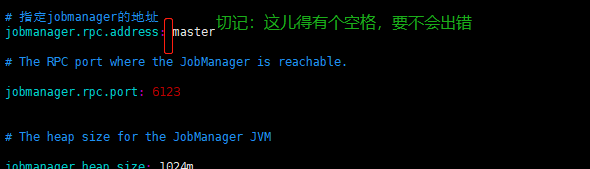

3 修改 conf 目录下的 flink-conf.yaml 配置文件

# 指定jobmanager的地址(此处可使用ip/别名)

jobmanager.rpc.address: master

# 指定 taskmanager 的可用槽位的数量(槽位越多,运行的subTask就越多)

taskmanager.numberOfTaskSlots: 24 修改 conf 目录下的 slaves 配置文件,指定 taskmanager 的所在节点

[root@lx01 conf]# cat slaves

lx01

lx02

lx035 分发安装包

将配置好的 Flink ,拷贝到其他节点(slave01,slave02 节点)

前提:已配置免密登录。免密登录,请参考:我是参考链接

命令:scp -r /usr/local/env/flink-1.9.1 root@slave01:/usr/local/env

scp -r /usr/local/env/flink-1.9.1 root@slave02:/usr/local/env5 启动Flink集群

[root@lx01 bin]# ./start-cluster.sh

Starting cluster.

Starting standalonesession daemon on host lx01.

Starting taskexecutor daemon on host lx01.

Starting taskexecutor daemon on host lx02.

Starting taskexecutor daemon on host lx03.[root@lx01 bin]# jps

2661 Jps

2569 TaskManagerRunner TaskManager进程

2106 StandaloneSessionClusterEntrypoint JobManager进程6 访问web页面

访问URL http://lx01:8081