链接

http://arxiv.org/abs/2004.01980

作者

Di Jin | MIT

主题

标题生成,Stylistic Headline Generation 风格化标题生成

摘要

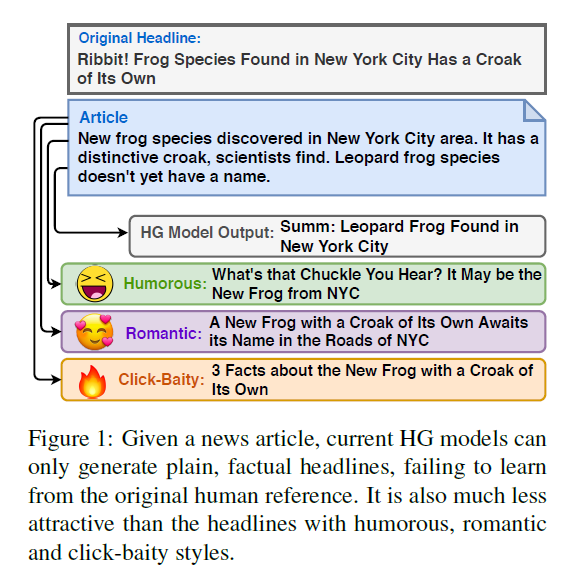

- 提出了一个新任务:Stylistic Headline Generation (SHG)

- 三种风格的标题:romantic,humorous,clickbait

- 没有带风格的article-title对,只有标准的标题摘要数据集和mono-style corpus(单一风格的语料)

- 提出了一个模型:结合了标题摘要任务和重构任务变成一个多任务学习框架

- 还引入了一个新的参数共享方案,进一步将样式从文本中分离出来。

- 效果很好,超过了以前的摘要模型,还超过了人类水平

引言

- 利用多任务框架训练标题文章对上的摘要模型和样式语料库上的去噪自动编码器(DAE)

- 基于transformer,设计style-dependent layer normalization和the style-guided encoder-attention来从文本中解耦风格

- 这种设计使我们能够使用共享内容来生成与文章更相关的标题,以及通过插入一组特定于样式的参数来控制样式

相关工作

该工作和两个topic相关:Summarization和text style transfer

Headline Generation as Summarization

- 传统的标题生成方法多侧重于使用语言特征和手工规则的抽取策略(Luhn, 1958; Edmundson, 1964; Mathis et al., 1973; Salton et al., 1997; Jing and McKeown, 1999; Radev and McKeown, 1998; Dorr et al., 2003)

- 为了丰富提取式摘要的多样性,提出了生成式摘要模型。在神经网络的帮助下,Rush et al. (2015)提出了基于注意力的摘要模型(ABS)使Banko et al. (2000)的摘要框架更强大。最近的许多作品通过利用额外的特征来扩展ABS (Chopra et al., 2016;Takase等,2016;Nallapati等,2016;沈等,2016,2017a;Tan等人,2017;郭等,2017)。标准标题生成设置的其他变体包括用于

- headlines for community question answering(Higurashi et al., 2018)

- multiple headline generation (Iwama and Kano, 2019)

- user-specific generation using user embeddings in recommendation systems (Liu et al., 2018)

- bilingual headline generation (Shen et al., 2018)

- question-style headline generation (Zhang et al., 2018a).

- 最近,只有少数作品开始关注如何增加标题的吸引力(Fan et al., 2018; Xu et al.,2019年)。

- Fan et al. (2018) 重点控制摘要文本的几个特征,如“文本长度”和两个不同的新闻媒体,CNN和DailyMail的“风格”。这些控件作为一种提高模型性能的方法,而CNN和DailyMailstyle控件显示出微不足道的改进。hhhhh微不足道可还行!

- Xu et al. 利用强化学习鼓励标题生成系统通过利用读者的评论率作为奖励,生成更多的耸人听闻的标题,但不能明确地控制或操纵标题的风格。

- Shu et al. (2018) 提出了一种风格转换方法,将非标题党-标题转换为标题党-标题。这种方法需要成对的(新闻文章—特定目标样式的标题)数据;然而,对于许多风格,如幽默和浪漫,没有可用的标题。

text style transfer

- 所有这些方法都需要一个针对目标样式的文本语料库;然而,在我们的案例中,收集带有幽默和浪漫风格的新闻标题既昂贵又在技术上具有挑战性,这使得这类方法不适用于我们的问题。

方法

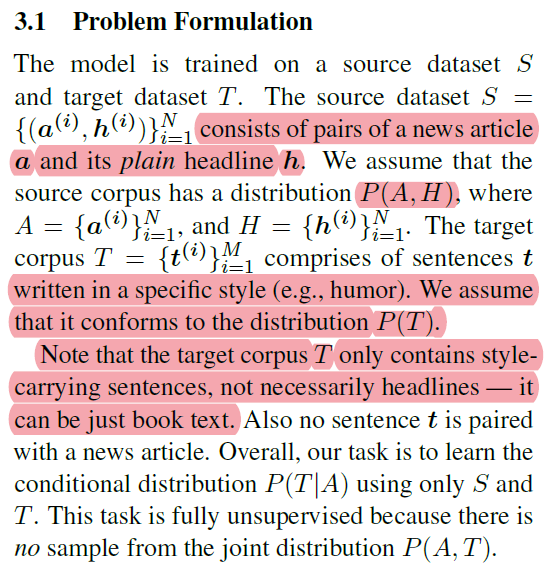

问题定义

S: 文章-plain标题数据集:A,H;| T:带风格的句子(不必要是标题,可以是book text)

要学的是\(P(T|A)\),没有从\(P(A,T)\)去采样,所以就是一个完全无监督的方法

Seq2Seq

用了MASS

多任务学习方案

用了多任务学习,还有一个降噪自编码器,输入是乱序+UNK的句子

- 学P(H|A);

- 降噪自编码器:在T上面,构造含噪音样本\(\widetilde{t}\):随机删除或删除某些单词并打乱单词顺序,去学\(P(t|\widetilde{t})\)

- 多任务损失函数:

参数共享方案

(方法好像和Unsupervised Stylish Image Description Generation via Domain Layer Norm差不多)

目标是P(T|A), 但是without sample from P(T,A), 如果\(E_S\)和\(E_T\)不相关,或者\(G_S\)和\(G_T\)不相关,那就不可能实现目标。必须要多加约束使两个任务相关。最简单的方案是在两个E之间共享参数,在两个G上应用相同的策略。本设计的直观之处在于,通过将模型同时暴露于摘要任务和携带样式的文本重构任务中,模型可以在总结文章的同时获得目标样式的一些感觉。然而,为了鼓励模型更好地分离文本的内容和样式,更明确地学习目标语料库T中包含的样式,我们在两个域之间共享编码器的所有参数。

- 说白了就是除了independent的层以外,其他结构都共用

- 受到image style transfer的启发,加了个style layer normalization层(\(\gamma_s\), \(\beta_s\))就这个参数是独立的,就和stylnet里面的LSTM的\(s\)矩阵一样。

- 还有一个:摘要归纳和重构任务的注意模式因其内在属性的不同而有所不同。所以提出了一个style encoder-decoder attention