目前,网络上有很多重复的信息,论文查重是怎么查的。当用户输入关键词进行搜索时,总会有许多重复或非常相似的网页。这是搜索引擎不想看到的,也是用户不想看到的。然后,我们需要仔细检查搜索到的网页,然后删除重复的网页,并将尽可能少的重复信息返回给用户的结果集!目前,我们只关心网页的内容,文本信息,而忽略了多媒体信息,如图片和视频,这是基于内容的研究。当然,我只对它感兴趣,我可能对它知之甚少。毕竟,我的水平有限。我心血来潮记起了这篇文章,自娱自乐,也许我会遇到一些专家寻求建议。

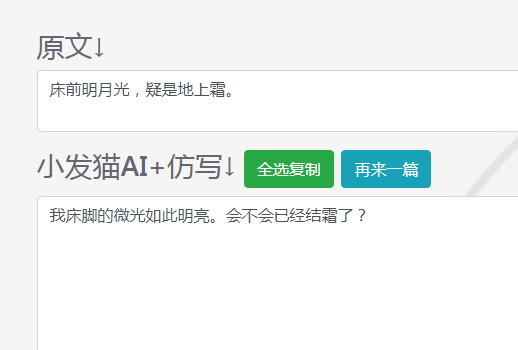

查重的算法,下面会继续介绍,这里先说说如何降低论文重复率,其实也不难,对付机器就用机器方法:

保留前戏,直奔主题,尽管前戏非常重要!没有解释。

几乎所有的重复数据消除技术都基于这一核心理念:为每个文档计算一组指纹。如果两个文件有一定数量的相同指纹,那么我们认为这两个文件的内容非常重叠,我们可以认为这两个文件是复制的。

目前,有许多重复数据删除方法,基于词频、特征码、标点符号、内容、摘要等。

以下两种方法使用分词,也可以说是一种基于分词的重复检查方法。

在[之前,我用词频法做了一些实验。词频法描述:如果两个文档之间的相似度很高,那么它们的词频,即文档中出现全文的词频,应该相差不大。有些人用这种统计方法来证明红楼梦的前80次和后40次不是来自同一个作家,因为每个作家在描述一个事物时都有不同的词汇习惯。也许不同的作家用不同的方式描述事物,从不同的角度看待问题。这种方法仍然非常有效,并且实现起来相对简单。对文档进行分词,然后计算词频,然后进行比较。只是对于短文,它经常判断错误。将几乎重复的文档转换成不同的文档。因此,这种方法是不稳定的。

如果您有互联网问题,也可以咨询我,谢谢!如果你也想一起学习人工智能,欢迎留言交流。