1 环境软件简介

hadoop2.6

zookeeper3.3.6

openSUSE 操作系统

前提:Hadoop zookeeper已经安装完毕~

下载hbase hbase-1.1.10-bin.tar.gz(去官网下载就好了~)

解压,并将hbase的文件夹放到/usr/local/文件夹下

2配置hbase

- 进入到hbase-1.1.10/conf目录下,vi ./hbase-env.sh打开文件

- export JAVA_HOME=/usr/lib/jvm/java-1.7.0-openjdk-1.7.0.45.x86_64 #java安装目录

- export HBASE_LOG_DIR=/home/hadoop2/softwares/hbase-1.1.10/logs #Hbase日志目录

- export HBASE_MANAGES_ZK=false #如果使用HBase自带的Zookeeper值设成true 如果使用自己安装的Zookeeper需要将该值设为false

- 注意:java_home是系统安装的jdk的实际路径,HBASE_LOG_DIR是hbase第一步中hbase的解压目录,目录下默认是没有logs文件的(不用自己新建,安装过程中会自动新建)

- export HBASE_PID_DIR=/usr/local/hbase-1.1.10/logs #指定pid的目录,

进入到hbase-1.1.10/conf目录下,vi ./hbase-site.xml打开文件

在 <configuration> </configuration> 中添加如下内容:

- <configuration>

- <property>

- <name>hbase.cluster.distributed</name>

- <value>true</value>

- </property>

- //Here you have to set the path where you want HBase to store its files.

- <property>

- <name>hbase.rootdir</name>

- <value>hdfs://localhost:8030/hbase</value>

- </property>

- //Here you have to set the path where you want HBase to store its built

- in zookeeper files.

- <property>

- <name>hbase.zookeeper.property.dataDir</name>

- <value>/usr/local/zookeeper-3.3.6/var/data</value>

- </property>

- <property>

- <name>hbase.zookeeper.quorum</name>

- <value>master,slave01</value>

- </property>

- </configuration>

- hbase.rootdir指定Hbase数据存储目录

- hbase.cluster.distributed 指定是否是完全分布式模式,单机模式和伪分布式模式需要将该值设为false

- hbase.master指定Master的位置

- hbase.zookeeper.quorum 指定zooke的集群,多台机器以逗号分隔

进入到hbase-1.1.10/conf目录下,vi ./regionservers打开文件,修改文件内容如下图所示

master

slave01

文件中保存的是hadoop集群的 namenode节点和datanode节点的主机名,需要根据实际情况修改。

2.4 修改hadoop的配置文件hdfs-site.xml(选填,此次没有执行)

进入到hadoop的配置文件目录,vi ./hdfs-site.xml打开文件。

在文件中添加一下内容

<property>

<name>dfs.datanode.max.xcievers</name>

<value>4096</value>

</property>

该参数限制了datanode所允许同时执行的发送和接受任务的数量,缺省为256,hadoop-defaults.xml中通常不设置这个参数。这个限制看有些偏小。

注意:这一步需要在hadoop集群的所有主机上都执行该操作。

scp -r hbase-1.1.10 hadoop@slave01:/usr/local/

注意:如果权限不足,换成scp -r hbase-1.1.10hadoop@slave01:/usr/local/ 然后去slave01机器上更改hbase-1.1.10的拥有者~

3 验证

启动顺序: hadoop->zookeeper->hbase。停止顺序与启动顺序正好相反

启动hadoop 略~

启动 zookeeper #/usr/local/zookeeper-3.3.6/bin/zkServer.shstart

注意:zookeeper需要在master和slave01上都启动一下,hadoop和hbase只需要在master上启动一下就OK

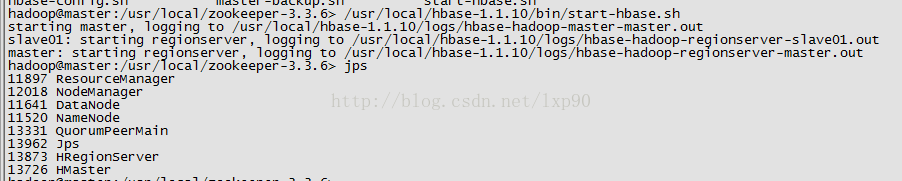

启动 Hbase #进入hbase的bin目录,执行 ./start-hbase.sh

slave01节点显示如下进程:

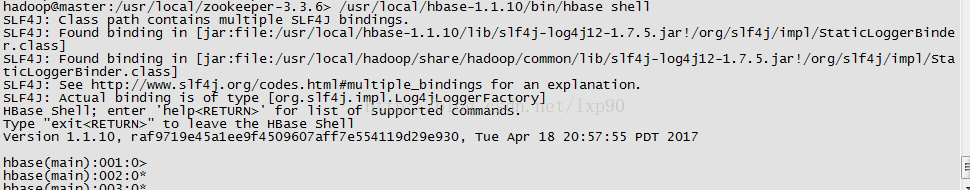

3.2.2 在master节点进入到hbase的bin目录下,运行./hbase shell

出现如下图所示结果,表示hbase安装成功。

3.2.3 在master节点用浏览器访问:http://master:16030可以看到hbase的管理页面

注意:hbse1.0以前端口是60010。hbase1.0以后端口是16030.

参考资料来源:http://blog.csdn.net/gyqjn/article/details/49402769