说明

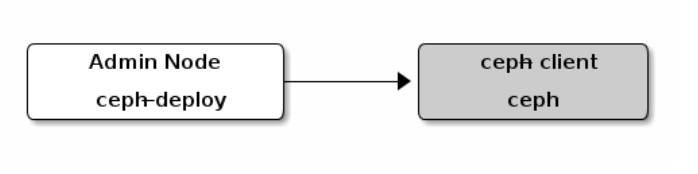

部署完ceph集群(active+clean状态)之后,

我们来实践下ceph block device(即RBD或RADOS block device)。

我们需要在一台新的client节点上,初始化、使用ceph集群创建的卷(image)

在ceph-client节点,安装ceph

1、在admin节点为ceph-client安装ceph

ceph-deploy install ceph-client

2、分发ceph.conf和ceph.client.admin.keyring到ceph-client节点

ceph-deploy admin

3、确认keyring 文件有读权限

chmod +r /etc/ceph/ceph.client.admin.keyring

在admin节点,创建一个块设备pool

1、在admin节点,创建一个名为rbd的pool

1. ceph osd pool create rbd 8

2、在admin节点,初始化pool

rbd pool init rbd

在ceph-client节点,配置,使用块设备

1、在ceph-client节点,创建块设备image

rbd create foo --size 4096 --image-feature layering [-m {mon-IP}] [-k /path/to/ceph.client.admin.keyring]

2、在ceph-client节点,映射 image到 块设备

rbd map foo --name client.admin [-m {mon-IP}] [-k /path/to/ceph.client.admin.keyring]

3、在ceph-client节点,给块设备创建文件系统

mkfs.ext4 -m0 /dev/rbd/rbd/foo

4、在ceph-client节点,挂载块设备

mkdir /mnt/ceph-block-devicemount /dev/rbd/rbd/foo /mnt/ceph-block-devicecd /mnt/ceph-block-device

5、

将块设备配置为在引导时自动映射和挂载(并且在关闭时卸载/取消映射) - 请参考:http://docs.ceph.com/docs/master/man/8/rbdmap/