1生成模型generative model和判别模型 discriminative model

已知输入变量x,生成模型通过对观测值和标注数据计算联合概率分布P(x,y)来达到判定估算y的目的。判别模型通过求解条件概率分布P(y|x)或者直接计算y的值来预测y。

常见的判别模型有线性回归(Linear Regression),逻辑回归(Logistic Regression),支持向量机(SVM), 传统神经网络(Traditional Neural Networks),线性判别分析(Linear Discriminative Analysis),条件随机场(Conditional Random Field);常见的生成模型有朴素贝叶斯(Naive Bayes), 隐马尔科夫模型(HMM),贝叶斯网络(Bayesian Networks)和隐含狄利克雷分布(Latent Dirichlet Allocation)。

2中文分词的基本方法

中文分词的基本方法可以分为基于语法规则的方法、基于词典的方法和基于统计的方法。

基于语法规则的分词法基本思想是在分词的同时进行句法、语义分析, 利用句法信息和语义信息来进行词性标注, 以解决分词歧义现象。因为现有的语法知识、句法规则十分笼统、复杂, 基于语法和规则的分词法所能达到的精确度远远还不能令人满意, 目前这种分词系统应用较少。

在基于词典的方法中,可以进一步分为最大匹配法,最大概率法,最短路径法等。最大匹配法指的是按照一定顺序选取字符串中的若干个字当做一个词,去词典中查找。根据扫描方式可细分为:正向最大匹配,反向最大匹配,双向最大匹配,最小切分。最大概率法指的是一个待切分的汉字串可能包含多种分词结果,将其中概率最大的那个作为该字串的分词结果。最短路径法指的是在词图上选择一条词数最少的路径。

基于统计的分词法的基本原理是根据字符串在语料库中出现的统计频率来决定其是否构成词。词是字的组合,相邻的字同时出现的次数越多, 就越有可能构成一个词。因此字与字相邻共现的频率或概率能够较好的反映它们成为词的可信度。常用的方法有HMM(隐马尔科夫模型),MAXENT(最大熵模型),MEMM(最大熵隐马尔科夫模型),CRF(条件随机场)。

3CRF模型、HMM模型和MEMM模型的比较分析

参考https://www.cnblogs.com/hellochennan/p/6624509.html

4维特比算法

5ID3算法

ID3算法的核心思想是以信息增益度量属性选择,选择分裂后信息增益最大的属性进行分裂。ID3算法的局限是它的属性只能取离散值,为了使决策树能应用于连续属性值情况,可以使用ID3的一个扩展算法C4.5算法。BC选项都是ID3算法的特点。ID3算法生成的决策树是一棵多叉树,分支的数量取决于分裂属性有多少个不同的取值。

6过拟合问题

机器学习中发生过拟合的主要原因有:(1)使用过于复杂的模型;(2)数据噪声较大;(3)训练数据少。

由此对应的降低过拟合的方法有:(1)简化模型假设,或者使用惩罚项限制模型复杂度;(2)进行数据清洗,减少噪声;(3)收集更多训练数据。

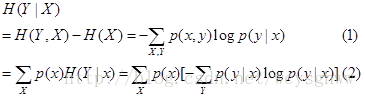

7计算条件熵H(Y|X)

条件熵的计算公式有两种

根据题目给出的概率选择合适的公式进行计算即可

8Fisher线性判别函数

http://blog.csdn.net/yujianmin1990/article/details/48007589

Fisher线性判别函数是将多维空间中的特征矢量投影到一条直线上,也就是把维数压缩到一维。寻找这条最优直线的准则是Fisher准则:两类样本在一维空间的投影满足类内尽可能密集,类间尽可能分开,也就是投影后两类样本均值之差尽可能大,类内部方差尽可能小。一般而言,对于数据分布近似高斯分布的情况,Fisher线性判别准则能够得到很好的分类效果。

9HMM的参数估计方法

EM算法: 只有观测序列,无状态序列时来学习模型参数,即Baum-Welch算法

维特比算法: 用动态规划解决HMM的预测问题,不是参数估计

前向后向算法:用来算概率

极大似然估计:即观测序列和相应的状态序列都存在时的监督学习算法,用来估计参数

10对于朴素贝叶斯分类器的理解

朴素贝叶斯的条件就是每个变量相互独立。在贝叶斯理论系统中,都有一个重要的条件独立性假设:假设所有特征之间相互独立,这样才能将联合概率拆分。

此外,若高度相关的特征在模型中引入两次, 这样增加了这一特征的重要性, 则它的性能因数据包含高度相关的特征而下降。正确做法是评估特征的相关矩阵,并移除那些高度相关的特征。

11马氏距离的应用

马氏距离是基于卡方分布的,度量多元outlier离群点的统计方法。

若协方差矩阵是单位矩阵(各个样本向量之间独立同分布),则就是欧氏距离了。

若协方差矩阵是对角矩阵,公式变成了标准化欧氏距离。

(2)马氏距离的优缺点:量纲无关,排除变量之间的相关性的干扰。

12“bootstrap”和“boosting”区别

13 对过拟合(overfit/high variance)和欠拟合(underfit/high bias)问题的理解

过拟合是训练出的模型太复杂了,在训练集上的误差很小但是泛化能力弱,一般的解决办法有:

收集更多的训练数据;简化特征;增加正则化项的系数lambda

欠拟合是模型没有充分学到数据中的信息,在训练集和测试集上的误差都很大,一般的解决办法有:

增加特征;增加多项式特征;减小正则化项的系数。

14对svm常用的几种核函数的理解

SVM核函数包括线性核函数、多项式核函数、径向基核函数、高斯核函数、幂指数核函数、拉普拉斯核函数、ANOVA核函数、二次有理核函数、多元二次核函数、逆多元二次核函数以及Sigmoid核函数. 核函数的定义并不困难,根据泛函的有关理论,只要一种函数 K ( x i , x j ) 满足Mercer条件,它就对应某一变换空间的内积.对于判断哪些函数是核函数到目前为止也取得了重要的突破,得到Mercer定理和以下常用的核函数类型: (1)线性核函数 K ( x , x i ) = x ⋅ x i (2)多项式核 K ( x , x i ) = ( ( x ⋅ x i ) + 1 ) d (3)径向基核(RBF) K ( x , x i ) = exp ( − ∥ x − x i ∥ 2 σ 2 ) Gauss径向基函数则是局部性强的核函数,其外推能力随着参数 σ 的增大而减弱。多项式形式的核函数具有良好的全局性质。局部性较差。 (4)傅里叶核 K ( x , x i ) = 1 − q 2 2 ( 1 − 2 q cos ( x − x i ) + q 2 ) (5)样条核 K ( x , x i ) = B 2 n + 1 ( x − x i ) (6)Sigmoid核函数 K ( x , x i ) = tanh ( κ ( x , x i ) − δ ) 采用Sigmoid函数作为核函数时,支持向量机实现的就是一种多层感知器神经网络,应用SVM方法,隐含层节点数目(它确定神经网络的结构)、隐含层节点对输入节点的权值都是在设计(训练)的过程中自动确定的。而且支持向量机的理论基础决定了它最终求得的是全局最优值而不是局部最小值,也保证了它对于未知样本的良好泛化能力而不会出现过学习现象。 核函数的选择 在选取核函数解决实际问题时,通常采用的方法有: 一是利用专家的先验知识预先选定核函数; 二是采用Cross-Validation方法,即在进行核函数选取时,分别试用不同的核函数,归纳误差最小的核函数就是最好的核函数.如针对傅立叶核、RBF核,结合信号处理问题中的函数回归问题,通过仿真实验,对比分析了在相同数据条件下,采用傅立叶核的SVM要比采用RBF核的SVM误差小很多. 三是采用由Smits等人提出的混合核函数方法,该方法较之前两者是目前选取核函数的主流方法,也是关于如何构造核函数的又一开创性的工作.将不同的核函数结合起来后会有更好的特性,这是混合核函数方法的基本思想.

15KNN算法的适用场景:

样本较少但典型性好

16对随机森林参数的理解

增加树的深度可能导致过拟合;增加树的数目可能导致欠拟合。

17对时间序列模型的理解

AR模型是一种线性预测,即已知N个数据,可由模型推出第N点前面或后面的数据(设推出P点),所以其本质类似于插值。

MA模型(moving average model)滑动平均模型,其中使用趋势移动平均法建立直线趋势的预测模型。

ARMA模型(auto regressive moving average model)自回归滑动平均模型,模型参量法高分辨率谱分析方法之一。这种方法是研究平稳随机过程有理谱的典型方法。它比AR模型法与MA模型法有较精确的谱估计及较优良的谱分辨率性能,但其参数估算比较繁琐。

GARCH模型称为广义ARCH模型,是ARCH模型的拓展,由Bollerslev(1986)发展起来的。它是ARCH模型的推广。GARCH(p,0)模型,相当于ARCH(p)模型。GARCH模型是一个专门针对金融数据所量体订做的回归模型,除去和普通回归模型相同的之处,GARCH对误差的方差进行了进一步的建模。特别适用于波动性的分析和预测,这样的分析对投资者的决策能起到非常重要的指导性作用,其意义很多时候超过了对数值本身的分析和预测。

本题题目及解析来源:@刘炫320

链接:http://blog.csdn.net/column/details/16442.html