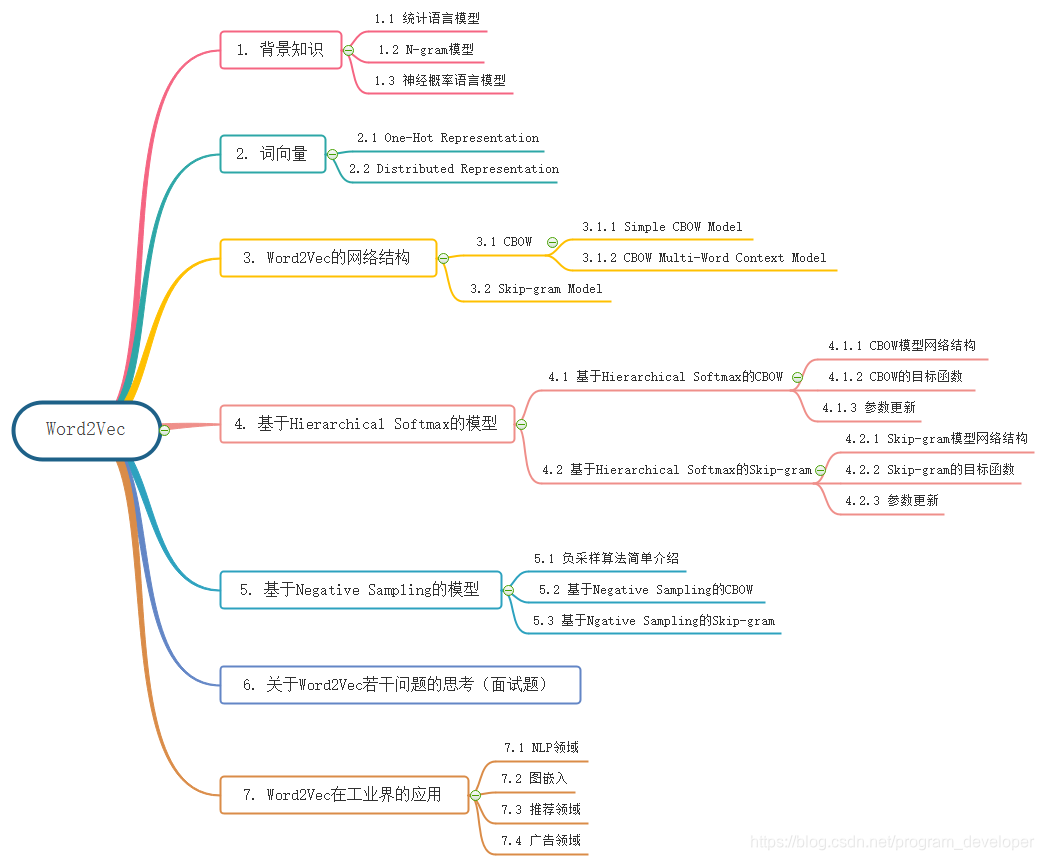

本文概览:

Word2Vec是语言模型中的一种,它是从大量文本预料中以无监督方式学习语义知识的模型,被广泛地应用于自然语言处理中。

Word2Vec是用来生成词向量的工具,而词向量与语言模型有着密切的关系。因此,我们先来了解一些语言模型方面的知识。

统计语言模型是用来计算一个句子的概率的概率模型,它通常基于一个语料库来构建。那什么叫做一个句子的概率呢?假设

W

=

(

w

1

,

w

2

,

.

.

.

,

w

T

)

W = (w_{1}, w_{2}, ..., w_{T})

W = ( w 1 , w 2 , . . . , w T )

T

T

T

w

1

,

w

2

,

.

.

.

,

w

T

w_{1},w_{2},...,w_{T}

w 1 , w 2 , . . . , w T

w

1

,

w

2

,

.

.

.

,

w

T

w_{1},w_{2},...,w_{T}

w 1 , w 2 , . . . , w T

p

(

W

)

=

p

(

w

1

,

w

2

,

.

.

.

,

w

T

)

p(W) = p(w_{1},w_{2},...,w_{T})

p ( W ) = p ( w 1 , w 2 , . . . , w T )

p

(

W

)

p(W)

p ( W )

p

(

W

)

=

p

(

w

1

)

p

(

w

2

∣

w

1

)

p

(

w

3

∣

w

1

,

w

2

)

.

.

.

p

(

w

T

∣

w

1

,

w

2

,

.

.

.

,

w

T

−

1

)

(1)

p(W) = p(w_{1})p(w_{2}|w_{1})p(w_{3}|w_{1},w_{2})...p(w_{T}|w_{1},w_{2},...,w_{T-1}) \tag{1}

p ( W ) = p ( w 1 ) p ( w 2 ∣ w 1 ) p ( w 3 ∣ w 1 , w 2 ) . . . p ( w T ∣ w 1 , w 2 , . . . , w T − 1 ) ( 1 )

p

(

w

1

)

,

p

(

w

2

∣

w

1

)

,

.

.

.

,

p

(

w

T

∣

w

1

,

w

2

,

.

.

.

,

w

T

−

1

)

p(w_{1}),p(w_{2}|w_{1}),...,p(w_{T}|w_{1},w_{2},...,w_{T-1})

p ( w 1 ) , p ( w 2 ∣ w 1 ) , . . . , p ( w T ∣ w 1 , w 2 , . . . , w T − 1 )

W

W

W

p

(

W

)

p(W)

p ( W )

看起来好像很简单,是吧?但是,具体实现起来还是有点麻烦。例如,先来看看模型参数的个数。刚才是考虑一个给定的长度为T的句子,就需要计算T个参数。不防假设语料库对应词典

D

D

D

N

N

N

T

T

T

N

T

N^{T}

N T

T

T

T

T

N

T

TN^{T}

T N T

此外,这些参数如何计算呢?常见的方法有n-gram模型、决策树、最大熵模型、最大熵马尔可夫模型、条件随机场、神经网络等方法。本文只讨论n-gram模型和神经网络两种方法。

考虑

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

p(w_{k}|w_{1},..., w_{k-1})

p ( w k ∣ w 1 , . . . , w k − 1 )

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

=

p

(

w

1

,

.

.

.

,

w

k

)

p

(

w

1

,

.

.

.

,

w

k

−

1

)

p(w_{k}|w_{1},...,w_{k-1}) = \frac{p(w_{1},...,w_{k})}{p(w_{1},...,w_{k-1})}

p ( w k ∣ w 1 , . . . , w k − 1 ) = p ( w 1 , . . . , w k − 1 ) p ( w 1 , . . . , w k )

根据大数定理,当语料库足够大时,

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

p(w_{k}|w_{1},...,w_{k-1})

p ( w k ∣ w 1 , . . . , w k − 1 )

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

≈

c

o

u

n

t

(

w

1

,

.

.

.

,

w

k

)

c

o

u

n

t

(

w

1

,

.

.

.

,

w

k

−

1

)

(2)

p(w_{k}|w_{1},...,w_{k-1}) \approx \frac{count(w_{1},...,w_{k})}{count(w_{1},...,w_{k-1})} \tag{2}

p ( w k ∣ w 1 , . . . , w k − 1 ) ≈ c o u n t ( w 1 , . . . , w k − 1 ) c o u n t ( w 1 , . . . , w k ) ( 2 )

c

o

u

n

t

(

w

1

,

.

.

.

,

w

k

)

count(w_{1},...,w_{k})

c o u n t ( w 1 , . . . , w k )

w

1

,

.

.

.

,

w

k

w_{1},...,w_{k}

w 1 , . . . , w k

c

o

u

n

t

(

w

1

,

.

.

.

,

w

k

−

1

)

count(w_{1},...,w_{k-1})

c o u n t ( w 1 , . . . , w k − 1 )

w

1

,

.

.

.

,

w

k

−

1

w_{1},...,w_{k-1}

w 1 , . . . , w k − 1

k

k

k

c

o

u

n

t

(

w

1

,

.

.

.

,

w

k

)

count(w_{1},...,w_{k})

c o u n t ( w 1 , . . . , w k )

c

o

u

n

t

(

w

1

,

.

.

.

,

w

k

−

1

)

count(w_{1},...,w_{k-1})

c o u n t ( w 1 , . . . , w k − 1 )

从公式(1)可以看出:一个词出现的概率与它前面的所有词都相关。如果假定一个词出现的概率只与它前面固定数目的词相关呢?这就是n-gram模型的基本思想,它做了一个

n

−

1

n-1

n − 1

n

−

1

n-1

n − 1

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

≈

p

(

w

k

∣

w

k

−

n

+

1

,

.

.

.

,

w

k

−

1

)

p(w_{k}|w_{1},...,w_{k-1}) \approx p(w_{k}|w_{k-n+1},...,w_{k-1})

p ( w k ∣ w 1 , . . . , w k − 1 ) ≈ p ( w k ∣ w k − n + 1 , . . . , w k − 1 )

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

≈

c

o

u

n

t

(

w

k

−

n

+

1

,

.

.

.

,

w

k

)

c

o

u

n

t

(

w

k

−

n

+

1

,

.

.

.

,

w

k

−

1

)

(3)

p(w_{k}|w_{1},...,w_{k-1}) \approx \frac{count(w_{k-n+1},...,w_{k})}{count(w_{k-n+1},...,w_{k-1})} \tag{3}

p ( w k ∣ w 1 , . . . , w k − 1 ) ≈ c o u n t ( w k − n + 1 , . . . , w k − 1 ) c o u n t ( w k − n + 1 , . . . , w k ) ( 3 )

以

n

=

2

n = 2

n = 2

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

≈

c

o

u

n

t

(

w

k

−

1

,

.

.

.

,

w

k

)

c

o

u

n

t

(

w

k

−

1

)

p(w_{k}|w_{1},...,w_{k-1}) \approx \frac{count(w_{k-1},...,w_{k})}{count(w_{k-1})}

p ( w k ∣ w 1 , . . . , w k − 1 ) ≈ c o u n t ( w k − 1 ) c o u n t ( w k − 1 , . . . , w k )

这样简化,不仅使得单个参数的统计变得更容易(统计时需要匹配的词串更短),也使得参数的总数变少了。

那么,n-gram中的参数

n

n

n

表1:模型参数数量与n的关系

n

模型参数的数量

1(unigram)

2

×

1

0

5

2 \times 10^{5}

2 × 1 0 5

2(bigram)

4

×

1

0

10

4 \times 10^{10}

4 × 1 0 1 0

3(trigram)

8

×

1

0

15

8 \times 10^{15}

8 × 1 0 1 5

4(4-gram)

16

×

1

0

20

16 \times 10^{20}

1 6 × 1 0 2 0

在计算复杂度方面,表1给出了n-gram模型中模型参数数量随着

n

n

n

N

=

200000

N=200000

N = 2 0 0 0 0 0

N

N

N

O

(

N

n

)

O(N^{n})

O ( N n )

n

n

n

n

=

3

n=3

n = 3

在模型效果方面,理论上是

n

n

n

n

>

10

n>10

n > 1 0

n

n

n

n

n

n

1

1

1

2

2

2

2

2

2

3

3

3

3

3

3

4

4

4

另外,n-gram模型中还有一个叫做平滑化的重要环节。回到公式(3),考虑两个问题:

若

c

o

u

n

t

(

w

k

−

n

+

1

,

.

.

.

,

w

k

)

=

0

count(w_{k-n+1},..., w_{k}) = 0

c o u n t ( w k − n + 1 , . . . , w k ) = 0

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

p(w_{k} | w_{1},...,w_{k-1})

p ( w k ∣ w 1 , . . . , w k − 1 )

0

0

0

若

c

o

u

n

t

(

w

k

−

n

+

1

,

.

.

.

,

w

k

)

count(w_{k-n+1},..., w_{k})

c o u n t ( w k − n + 1 , . . . , w k )

c

o

u

n

t

(

w

k

−

n

+

1

,

.

.

.

,

w

k

−

1

)

count(w_{k-n+1}, ..., w_{k-1})

c o u n t ( w k − n + 1 , . . . , w k − 1 )

p

(

w

k

∣

w

1

,

.

.

.

,

w

k

−

1

)

p(w_{k}|w_{1},...,w_{k-1})

p ( w k ∣ w 1 , . . . , w k − 1 )

1

1

1

显然不能,但这是一个无法回避的问题,哪怕你的预料库有多么大。平滑化技术就是用来处理这个问题的,这里不展开讨论。

总结起来,n-gram模型是这样一种模型,其主要工作是在语料中统计各种词串出现的次数以及平滑化处理。概率值计算好之后就存储起来,下次需要计算一个句子的概率时,只需找到相关的概率参数,将它们连乘起来就好了。

然而,在机器学习领域有一种通用的解决问题的方法:对所考虑的问题建模后先为其构造一个目标函数,然后对这个目标函数进行优化,从而求得一组最优的参数,最后利用这组最优参数对应的模型来进行预测。

对于统计语言模型而言,利用最大似然,可把目标函数设为:

∏

w

∈

C

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

\prod_{w \in C}^{} p(w|Context(w))

w ∈ C ∏ p ( w ∣ C o n t e x t ( w ) )

C

C

C

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

w

w

w

w

w

w

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

=

p

(

w

)

p(w|Context(w))= p(w)

p ( w ∣ C o n t e x t ( w ) ) = p ( w )

C

o

n

t

e

x

t

(

w

i

=

w

i

−

n

+

1

,

.

.

.

,

w

i

−

1

)

Context(w_{i} = w_{i-n+1},...,w_{i-1})

C o n t e x t ( w i = w i − n + 1 , . . . , w i − 1 )

当然,实际应用中常采用最大对数似然,即把目标函数设为

L

=

∑

w

∈

C

l

o

g

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

(4)

L = \sum_{w \in C}^{}{log p(w|Context(w))} \tag{4}

L = w ∈ C ∑ l o g p ( w ∣ C o n t e x t ( w ) ) ( 4 )

从公式(4)可见,概率

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

p(w|Context(w))

p ( w ∣ C o n t e x t ( w ) )

w

w

w

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

=

F

(

w

,

C

o

n

t

e

x

t

(

w

)

,

θ

)

p(w|Context(w)) = F(w, Context(w), \theta)

p ( w ∣ C o n t e x t ( w ) ) = F ( w , C o n t e x t ( w ) , θ )

θ

\theta

θ

θ

∗

\theta^{ *}

θ ∗

F

F

F

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

p(w|Context(w))

p ( w ∣ C o n t e x t ( w ) )

F

(

w

,

C

o

n

t

e

x

t

(

w

)

,

θ

∗

)

F(w, Context(w), \theta^{ *})

F ( w , C o n t e x t ( w ) , θ ∗ )

θ

\theta

θ

很显然,对于这样一种方法,最关键的地方就在于函数

F

F

F

F

F

F

本小节介绍 Bengio 等人于2003年在论文《A Neural Probabilistic Language Model》中提出的一种神经概率语言模型。该论文首次提出用神经网络来解决语言模型的问题,虽然在当时并没有得到太多的重视,却为后来深度学习在解决语言模型问题甚至很多别的nlp问题时奠定了坚实的基础,后人站在Yoshua Bengio的肩膀上,做出了更多的成就。包括Word2Vec的作者Tomas Mikolov在NNLM的基础上提出了RNNLM和后来的Word2Vec。文中也较早地提出将word表示一个低秩的向量,而不是One-Hot。word embedding作为一个language model的副产品,在后面的研究中起到了关键作用,为研究者提供了更加宽广的思路。值得注意的是Word2Vec的概念也是在该论文中提出的。

什么是词向量呢?简单来说就是,对词典

D

D

D

w

w

w

v

(

w

)

∈

ℜ

m

v(w) \in \Re ^{m}

v ( w ) ∈ ℜ m

v

(

w

)

v(w)

v ( w )

w

w

w

m

m

m

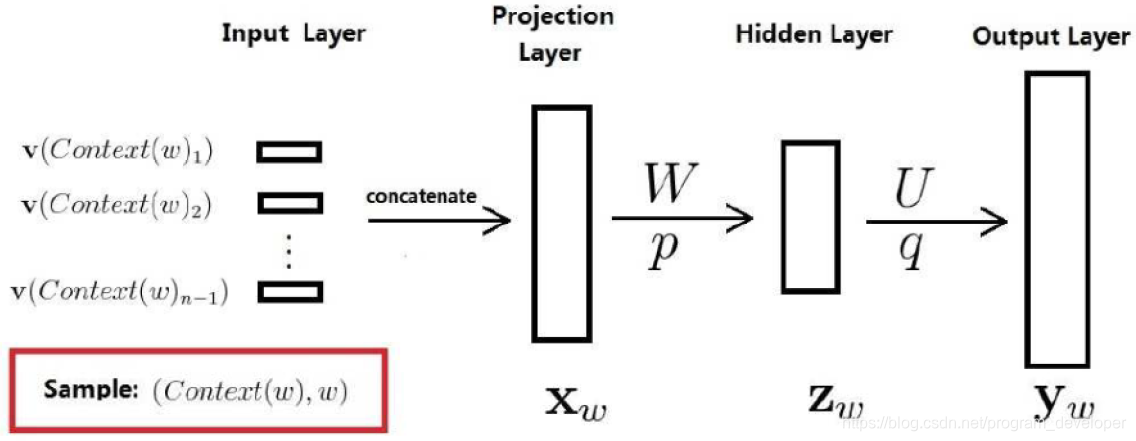

既然是神经概率语言模型,其中当然要用到神经网络了。 下图给出了神经网络的结构示意图。模型一共三层,第一层是映射层,将

n

n

n

t

a

n

h

tanh

t a n h

n

n

n

S

o

f

t

m

a

x

Softmax

S o f t m a x

经过上面步骤的计算得到的

y

w

=

(

y

w

,

1

,

y

w

,

2

,

.

.

.

,

y

w

,

N

)

T

y_{w} = (y_{w,1}, y_{w,2},...,y_{w,N})^{T}

y w = ( y w , 1 , y w , 2 , . . . , y w , N ) T

N

N

N

y

w

y_{w}

y w

y

w

,

i

y_{w,i}

y w , i

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

D

D

D

i

i

i

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

=

e

y

w

,

i

w

∑

i

=

1

N

e

y

w

,

i

(5)

p(w|Context(w)) = \frac{e^{y_{w,i_{w}}}}{ \sum_{i=1}^{N}{e^{y_{w,i}}}} \tag{5}

p ( w ∣ C o n t e x t ( w ) ) = ∑ i = 1 N e y w , i e y w , i w ( 5 )

i

w

i_{w}

i w

w

w

w

D

D

D

这里,需要注意的是需要提前初始化一个word embedding矩阵,每一行表示一个单词的向量。词向量也是训练参数,在每次训练中进行更新。这里可以看出词向量是语言模型的一个副产物,因为语言模型本身的工作是为了估计给定的一句话有多像人类的话,但从后来的研究发现,语言模型成了一个非常好的工具。

Softmax是一个非常低效的处理方式,需要先计算每个单词的概率,并且还要计算指数,指数在计算机中都是用级数来近似的,计算复杂度很高,最后再做归一化处理。此后很多研究都针对这个问题进行了优化,比如层级softmax、softmax tree。

当然NNLM的效果在现在看来并不算什么,但对于后面的相关研究具有非常重要的意义。论文中的Future Work提到了用RNN来代替MLP作为模型可能会取得更好的效果,在后面Tomas Mikolov的博士论文中得到了验证,也就是后来的RNNLM。

与n-gram模型相比,神经概率语言模型有什么优势呢?主要有以下两点:

举例来说,如果某个(英语)语料中

S

1

=

"

A

d

o

g

i

s

r

u

n

n

i

n

g

i

n

t

h

e

r

o

o

m

"

S_{1} = "A dog is running in the room"

S 1 = " A d o g i s r u n n i n g i n t h e r o o m "

10000

10000

1 0 0 0 0

S

2

=

"

A

c

a

t

i

s

r

u

n

n

i

n

g

i

n

t

h

e

r

o

o

m

"

S_{2} ="A cat is running in the room"

S 2 = " A c a t i s r u n n i n g i n t h e r o o m "

1

1

1

p

(

S

1

)

p(S_{1})

p ( S 1 )

p

(

S

2

)

p(S_{2})

p ( S 2 )

S

1

S_{1}

S 1

S

2

S_{2}

S 2

p

(

S

1

)

p(S_{1})

p ( S 1 )

p

(

S

2

)

p(S_{2})

p ( S 2 )

p

(

S

1

)

p(S_{1})

p ( S 1 )

p

(

S

2

)

p(S_{2})

p ( S 2 )

A dog is running in the room

基于词向量的模型自带平滑化功能(由公式(5)可知,

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

∈

(

0

,

1

)

p(w|Context(w)) \in (0,1)

p ( w ∣ C o n t e x t ( w ) ) ∈ ( 0 , 1 )

最后,我们回过头来想想,词向量在整个神经概率语言模型中扮演了什么角色呢?训练时,它是用来帮助构造目标函数的辅助参数,训练完成后,它也好像只是语言模型的一个副产品。但这个副产品可不能小觑,下一节将对其作进一步阐述。

自然语言处理相关任务中要将自然语言交给机器学习中的算法来处理,通常需要将语言数学化,因为机器不是人,机器只认数学符号。向量是人把自然界的东西抽象出来交给机器处理的东西,基本上可以说向量是人对机器输入的主要方式了。

词向量就是用来将语言中的词进行数学化的一种方式,顾名思义,词向量就是把一个词表示成一个向量。 我们都知道词在送到神经网络训练之前需要将其编码成数值变量,常见的编码方式有两种:One-Hot Representation 和 Distributed Representation。

一种最简单的词向量方式是One-Hot编码 ,就是用一个很长的向量来表示一个词,向量的长度为词典的大小,向量中只有一个

1

1

1

0

0

0

1

1

1

举个例子:I like writing code,那么转换成独热编码就是:

词

One-Hot 编码

I

1 0 0 0

like

0 1 0 0

writing

0 0 1 0

code

0 0 0 1

这种One Hot编码如果采用稀疏方式存储,会是非常的简洁:也就是给每个 词分配一个数字 ID 。比如上面的例子中,code记为

1

1

1

4

4

4

但这种词表示有三个缺点:

(1)容易受维数灾难的困扰,尤其是将其用于 Deep Learning的一些算法时;

当你的词汇量达到千万甚至上亿级别的时候,你会遇到一个更加严重的问题,维度爆炸了.这里举例使用的是

4

4

4

1

1

1

1

1

1

0.12

0.12

0 . 1 2

( 2 )词汇鸿沟,不能很好地刻画词与词之间的相似性;

任意两个词之间都是孤立的,从这两个向量中看不出两个词是否有关系。比如说,I、like之间的关系和like、writing之间的关系,通过

0001

0001

0 0 0 1

0010

0010

0 0 1 0

0010

0010

0 0 1 0

0100

0100

0 1 0 0

1

1

1

(3)强稀疏性;

当维度过度增长的时候,你会发现0特别多,这样造成的后果就是整个向量中有用的信息特别少,几乎就没法做计算。

由于One-hot编码存在以上种种问题,所以研究者就会寻求发展,用另外的方式表示,就是Distributed Representation。

Distributed Representation最早是Hinton于1986年提出的,可以克服One-Hot Representation的上述缺点。其基本想法是:通过训练将某种语言中的每一个词 映射成一个固定长度的短向量(当然这里的“短”是相对于One-Hot Representation的“长”而言的),所有这些向量构成一个词向量空间,而每一个向量则可视为 该空间中的一个点,在这个空间上引入“距离”,就可以根据词之间的距离来判断它们之间的语法、语义上的相似性了。Word2Vec中采用的就是这种Distributed Representation 的词向量。

为什么叫做 Distributed Representation?很多人问到这个问题。一个简单的解释是这样的:对于One-Hot Representation,向量中只有一个非零分量,非常 集中(有点孤注一掷的感觉);而对于Distributed Representation,向量中有大量非零分量,相对分散(有点风险平摊的感觉),把词的信息分布到各个分量 中去了。这一点,跟并行计算里的分布式并行很像。

如何获取词向量呢?有很多不同模型可以用来估计词向量,包括有名的LSA(Latent Semantic Analysis)和LDA(Latent Dirichlet Allocation)。此外,利用神经 网络算法也是一种常用的方法,上一节介绍的神经概率语言模型就是一个很好的实例。当然,在那个模型中,目标是生成语言模型,词向量只是一个副产品。事实上, 大部分情况下,词向量和语言模型都是捆绑在一起的,训练完成后两者同时得到。在用神经网络训练语言模型方面,最经典的论文就是Bengio于2003年发表的《A Neural Probabilistic Language Model》 ,其后有一系列相关的研究工作,其中也包括谷歌Tomas Mikolov团队的Word2Vec。

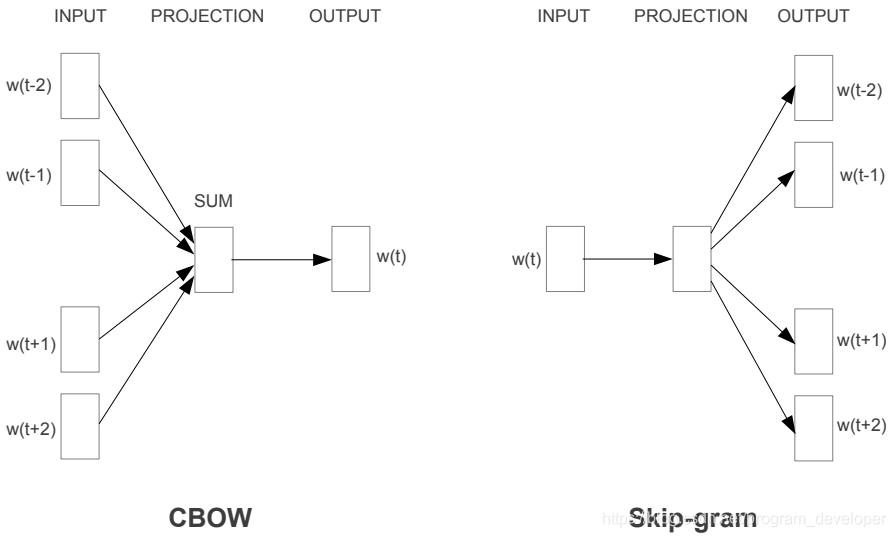

Word2Vec是轻量级的神经网络,其模型仅仅包括输入层、隐藏层和输出层,模型框架根据输入输出的不同,主要包括CBOW和Skip-gram模型。 CBOW的方式是在知道词

w

t

w_t

w t

w

t

−

2

,

w

t

−

1

,

w

t

+

1

,

w

t

+

2

w_{t-2},w_{t-1},w_{t+1},w_{t+2}

w t − 2 , w t − 1 , w t + 1 , w t + 2

w

t

w_t

w t

w

t

w_t

w t

w

t

w_t

w t

w

t

−

2

,

w

t

−

1

,

w

t

+

1

,

w

t

+

2

w_{t-2}, w_{t-1}, w_{t+1}, w_{t+2}

w t − 2 , w t − 1 , w t + 1 , w t + 2

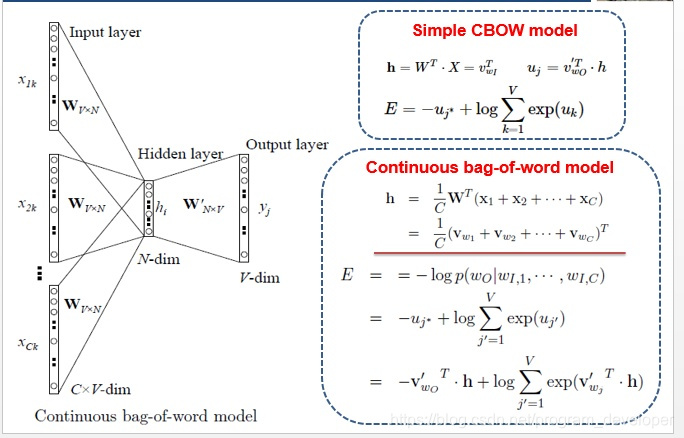

为了更好的了解模型深处的原理,我们先从Simple CBOW model(仅输入一个词,输出一个词)框架说起。

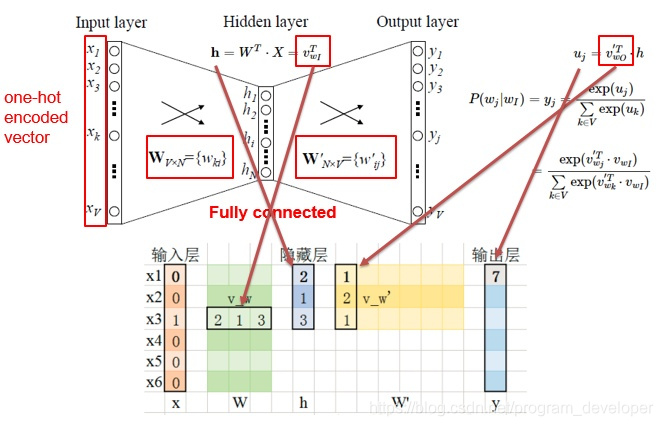

如上图所示:

input layer输入的X是单词的one-hot representation(考虑一个词表

V

V

V

w

i

w_{i}

w i

i

∈

1

,

.

.

.

,

∣

V

∣

i∈{1,...,|V|}

i ∈ 1 , . . . , ∣ V ∣

w

i

w_{i}

w i

∣

V

∣

|V|

∣ V ∣

i

i

i

0

0

0

w

2

=

[

0

,

1

,

0

,

.

.

.

,

0

]

T

w_2=[0,1,0,...,0]^T

w 2 = [ 0 , 1 , 0 , . . . , 0 ] T

输入层到隐藏层之间有一个权重矩阵

W

W

W

X

X

X

0

−

1

0-1

0 − 1

X

X

X

[

0

,

0

,

1

,

0

,

0

,

0

]

[0,0,1,0,0,0]

[ 0 , 0 , 1 , 0 , 0 , 0 ]

W

W

W

X

X

X

3

3

3

[

2

,

1

,

3

]

[2,1,3]

[ 2 , 1 , 3 ]

隐藏层到输出层也有一个权重矩阵

W

′

W'

W ′

y

y

y

W

′

W'

W ′

7

7

7

[

2

,

1

,

3

]

[2,1,3]

[ 2 , 1 , 3 ]

[

1

,

2

,

1

]

[1,2,1]

[ 1 , 2 , 1 ]

最终的输出需要经过softmax函数,将输出向量中的每一个元素归一化到

0

−

1

0-1

0 − 1

了解了Simple CBOW model的模型框架之后,我们来学习一下其目标函数。

L

=

m

a

x

l

o

g

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

=

m

a

x

log

(

y

j

∗

)

=

m

a

x

l

o

g

(

e

x

p

(

u

j

∗

)

∑

e

x

p

(

u

k

)

)

\begin{aligned} L &= max \ log \ p(w|Context(w)) \\ &= max \log \ (y_{j}^{*}) \\ &= max \ log ( \frac{exp(u_{j}^{*})}{\sum {exp(u_{k}) } }) \end{aligned}

L = m a x l o g p ( w ∣ C o n t e x t ( w ) ) = m a x log ( y j ∗ ) = m a x l o g ( ∑ e x p ( u k ) e x p ( u j ∗ ) )

u

u

u

a

l

o

g

a

(

N

)

=

N

a^{loga(N)} =N

a l o g a ( N ) = N

m

a

x

l

o

g

(

e

x

p

(

u

j

∗

)

∑

e

x

p

(

u

k

)

)

=

m

a

x

u

j

∗

−

l

o

g

∑

k

=

1

V

e

x

p

(

u

k

)

max \ log ( \frac{exp(u_{j}^{*})}{\sum {exp(u_{k}) } }) = max \ u_{j}^{*} - log \sum_{k=1}^{V}{exp(u_{k})}

m a x l o g ( ∑ e x p ( u k ) e x p ( u j ∗ ) ) = m a x u j ∗ − l o g k = 1 ∑ V e x p ( u k )

了解了Simple CBOW model之后,扩展到CBOW就很容易了,只是把单个输入换成多个输入罢了(划红线部分)。

对比可以发现,和simple CBOW不同之处在于,输入由

1

1

1

C

C

C

X

i

k

X_{ik}

X i k

W

W

W

h

h

h

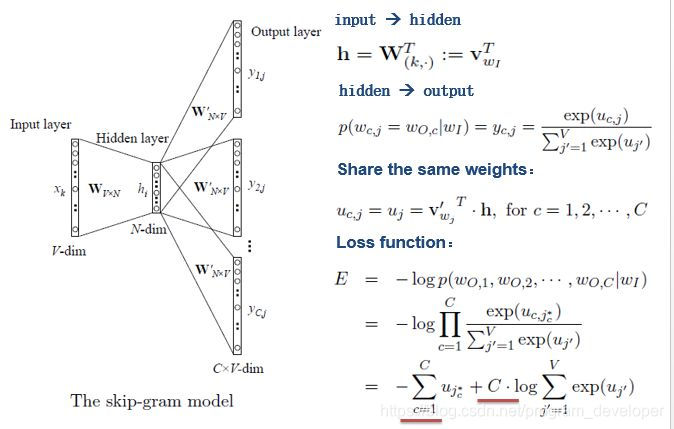

有了CBOW的介绍,对于Skip-gram model 的理解应该会更快一些。

如上图所示,Skip-gram model是通过输入一个词去预测多个词的概率。输入层到隐藏层的原理和simple CBOW一样,不同的是隐藏层到输出层,损失函数变成了

C

C

C

W

′

W'

W ′

一般神经网络语言模型在预测的时候,输出的是预测目标词的概率,也就是说我每一次预测都要基于全部的数据集进行计算,这无疑会带来很大的时间开销。不同于其他神经网络,Word2Vec提出两种加快训练速度的方式,一种是Hierarchical softmax,另一种是Negative Sampling。

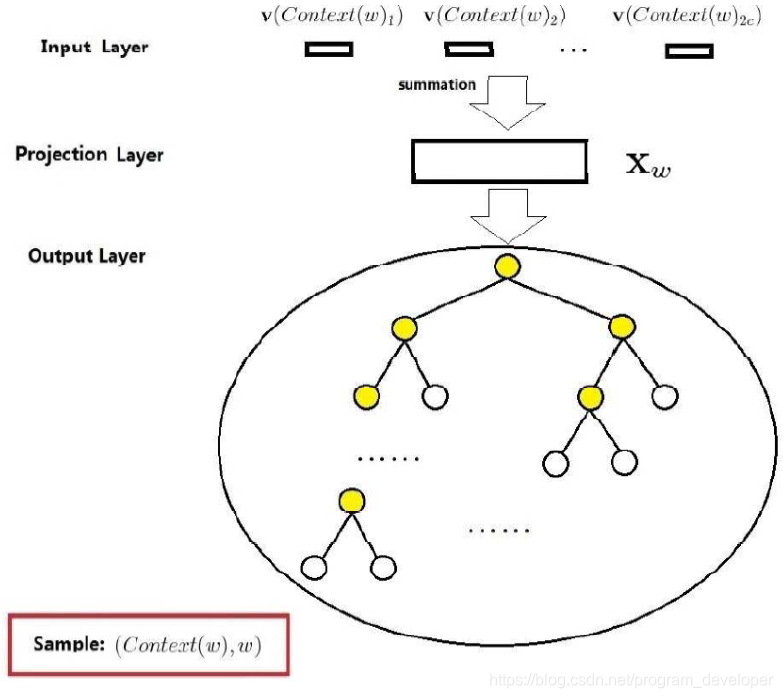

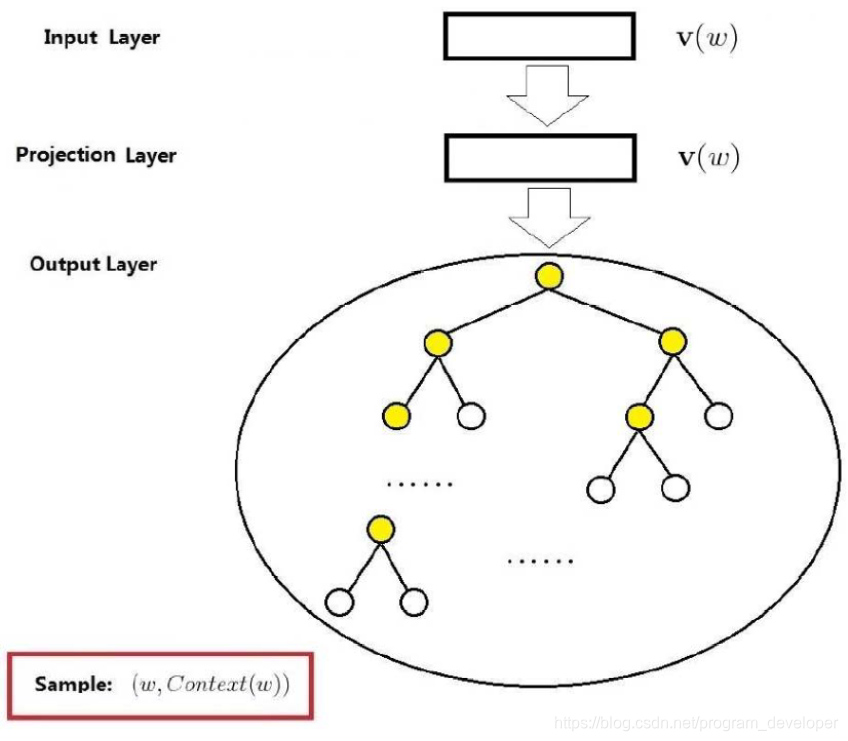

基于层次Softmax的模型主要包括输入层、投影层(隐藏层)和输出层,非常的类似神经网络结构。对于Word2Vec中基于层次Softmax的CBOW模型,我们需要最终优化的目标函数是 :

L

=

∑

log

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

(6)

L=\sum \log p(w|Context(w)) \tag{6}

L = ∑ log p ( w ∣ C o n t e x t ( w ) ) ( 6 )

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

w

w

w

L

=

∑

log

p

(

C

o

n

t

e

x

t

(

w

)

∣

w

)

(7)

L=\sum \log p(Context(w)|w) \tag{7}

L = ∑ log p ( C o n t e x t ( w ) ∣ w ) ( 7 )

下图给出了基于层次Softmax的CBOW的整体结构,首先它包括输入层、投影层和输出层:

输入层:是指

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

2

c

2c

2 c

v

(

C

o

n

t

e

x

t

(

w

)

1

)

,

v

(

C

o

n

t

e

x

t

(

w

)

2

)

,

.

.

.

,

v

(

C

o

n

t

e

x

t

(

w

)

2

c

)

v(Context(w)_1),v( Context(w)_2), ..., v(Context(w)_{2c})

v ( C o n t e x t ( w ) 1 ) , v ( C o n t e x t ( w ) 2 ) , . . . , v ( C o n t e x t ( w ) 2 c )

投影层:指的是直接对

2

c

2c

2 c

X

w

=

∑

i

=

1

2

c

v

(

C

o

n

t

e

x

t

(

w

)

i

)

X_w=\sum_{i=1}^{2c}v(Context(w)_i)

X w = i = 1 ∑ 2 c v ( C o n t e x t ( w ) i )

输出层:是一个Huffman树,其中叶子节点共

N

N

N

N

N

N

N

−

1

N-1

N − 1

为了便于下面的介绍和公式的推导,这里需要预先定义一些变量:

p

w

p^w

p w

w

w

w

l

w

l^w

l w

p

w

p^w

p w

p

1

w

,

p

2

w

,

.

.

.

,

p

l

w

w

p^w_1, p^w_2, ..., p^w_{l^w}

p 1 w , p 2 w , . . . , p l w w

p

w

p^w

p w

p

1

w

p^w_1

p 1 w

p

l

w

w

p^w_{l^w}

p l w w

w

w

w

d

2

w

,

d

3

w

.

.

.

,

d

l

w

w

∈

{

0

,

1

}

d^w_2, d^w_3 ..., d^w_{l^w}\in \{0, 1 \}

d 2 w , d 3 w . . . , d l w w ∈ { 0 , 1 }

w

w

w

l

w

−

1

l^w-1

l w − 1

d

j

w

d^w_j

d j w

p

w

p^w

p w

j

j

j

θ

1

w

,

θ

2

w

,

.

.

.

,

θ

l

w

−

1

w

∈

ℜ

m

\theta^w_1, \theta^w_2, ..., \theta^w_{l^w-1}\in \Re^{m}

θ 1 w , θ 2 w , . . . , θ l w − 1 w ∈ ℜ m

p

w

p^w

p w

θ

j

w

\theta^w_j

θ j w

p

w

p^w

p w

j

j

j

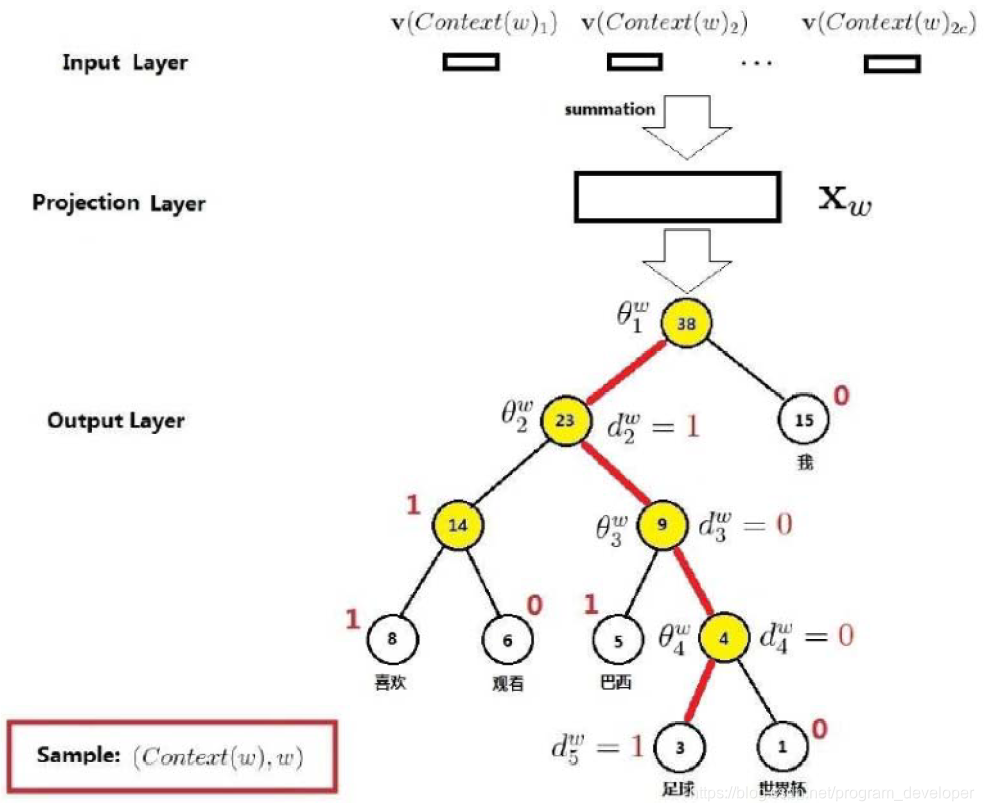

既然已经引入了那么多符号,我们通过一个简单的例子把它们落到实处吧,我们考虑单词w="足球"的情形。下图中红色线路就是我们的单词走过的路径,整个路径上的

5

5

5

p

w

p^w

p w

l

w

=

5

l^w=5

l w = 5

p

1

w

,

p

2

w

,

p

3

w

,

p

4

w

,

p

5

w

p^w_1, p^w_2,p^w_3,p^w_4,p^w_{5}

p 1 w , p 2 w , p 3 w , p 4 w , p 5 w

p

w

p^w

p w

p

1

w

p_{1}^{w}

p 1 w

d

2

w

,

d

3

w

,

d

4

w

,

d

5

w

d^w_2,d^w_3,d^w_4,d^w_5

d 2 w , d 3 w , d 4 w , d 5 w

1

,

0

,

0

,

1

1,0,0,1

1 , 0 , 0 , 1

1001

1001

1 0 0 1

θ

1

w

,

θ

2

w

,

θ

3

w

,

θ

4

w

\theta^w_1, \theta^w_2, \theta^w_3,\theta^w_4

θ 1 w , θ 2 w , θ 3 w , θ 4 w

p

w

p^w

p w

4

4

4

下面我们需要开始考虑如何构建条件概率函数

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

p(w|Context(w))

p ( w ∣ C o n t e x t ( w ) )

4

4

4

4

4

4

既然是二分类,那么我们可以定义一个为正类,一个为负类。我们的"足球"的哈夫曼编码为

1001

1001

1 0 0 1

1

1

1

0

0

0

1

1

1

0

0

0

L

a

b

e

l

(

p

i

w

)

=

1

−

d

i

w

,

i

=

2

,

3

,

4

,

.

.

.

,

l

w

Label(p^w_i)=1-d^w_i, i=2, 3, 4, ..., l^w

L a b e l ( p i w ) = 1 − d i w , i = 2 , 3 , 4 , . . . , l w

在进行二分类的时候,这里选择了Sigmoid函数。那么,一个结点被分为正类的概率就是:

σ

(

x

w

T

θ

)

=

1

1

+

e

−

x

w

t

θ

\sigma (x^T_w\theta)=\frac{1}{1+e^{-x^t_w\theta}}

σ ( x w T θ ) = 1 + e − x w t θ 1

被分为负类的概率就是

1

−

σ

(

x

w

T

θ

)

1-\sigma (x^T_w\theta)

1 − σ ( x w T θ )

θ

\theta

θ

θ

i

w

\theta_{i}^{w}

θ i w

对于从根节点出发到达“足球”这个叶子节点所经历的4次二分类,将每次分类的概率写出来就是:

第一次分类:

p

(

d

2

w

∣

x

w

,

θ

1

w

)

=

1

−

σ

(

x

w

T

θ

1

w

)

p(d^w_2|x_w,\theta^w_1)=1-\sigma(x^T_w\theta^w_1)

p ( d 2 w ∣ x w , θ 1 w ) = 1 − σ ( x w T θ 1 w )

第二次分类:

p

(

d

3

w

∣

x

w

,

θ

2

w

)

=

σ

(

x

w

T

θ

2

w

)

p(d^w_3|x_w,\theta^w_2)=\sigma(x^T_w\theta^w_2)

p ( d 3 w ∣ x w , θ 2 w ) = σ ( x w T θ 2 w )

第三次分类:

p

(

d

4

w

∣

x

w

,

θ

3

w

)

=

σ

(

x

w

T

θ

3

w

)

p(d^w_4|x_w,\theta^w_3)=\sigma(x^T_w\theta^w_3)

p ( d 4 w ∣ x w , θ 3 w ) = σ ( x w T θ 3 w )

第四次分类:

p

(

d

5

w

∣

x

w

,

θ

4

w

)

=

1

−

σ

(

x

w

T

θ

4

w

)

p(d^w_5|x_w,\theta^w_4)=1-\sigma(x^T_w\theta^w_4)

p ( d 5 w ∣ x w , θ 4 w ) = 1 − σ ( x w T θ 4 w )

但是,我们要求的是

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

p(w|Context(w))

p ( w ∣ C o n t e x t ( w ) )

p

(

足

球

∣

C

o

n

t

e

x

t

(

足

球

)

)

p(足球|Context(足球))

p ( 足 球 ∣ C o n t e x t ( 足 球 ) )

4

4

4

p

(

足

球

∣

C

o

n

t

e

x

t

(

足

球

)

)

=

∏

j

=

2

5

p

(

d

j

w

∣

x

w

,

θ

j

−

1

w

)

p(足球|Context(足球))=\prod_{j=2}^{5}p(d^w_j|x_w,\theta^w_{j-1})

p ( 足 球 ∣ C o n t e x t ( 足 球 ) ) = j = 2 ∏ 5 p ( d j w ∣ x w , θ j − 1 w )

至此,通过w="足球"的小例子,Hierarchical Softmax的基本思想就已经介绍完了。小结一下:对于词典中的任意一个单词

w

w

w

w

w

w

p

w

p^w

p w

p

w

p^{w}

p w

l

w

−

1

l^{w} -1

l w − 1

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

p(w|Context(w))

p ( w ∣ C o n t e x t ( w ) )

条件概率

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

p(w|Context(w))

p ( w ∣ C o n t e x t ( w ) )

p

(

w

∣

C

o

n

t

e

x

t

(

w

)

)

=

∏

j

=

2

l

w

p

(

d

j

w

∣

x

w

,

θ

j

−

1

w

)

(8)

p(w|Context(w))=\prod_{j=2}^{l^w}p(d^w_j|x_w,\theta^w_{j-1}) \tag{8}

p ( w ∣ C o n t e x t ( w ) ) = j = 2 ∏ l w p ( d j w ∣ x w , θ j − 1 w ) ( 8 )

p

(

d

j

w

∣

x

w

,

θ

j

−

1

w

)

=

{

σ

(

x

w

T

θ

j

−

1

w

)

,

d

j

w

=

0

1

−

σ

(

x

w

T

θ

j

w

−

1

)

,

d

j

w

=

1

p(d^w_j|x_w,\theta^w_{j-1})= \left\{ \begin{matrix} \sigma(x^T_w\theta^w_{j-1}), & d^w_j=0 \\ 1 - \sigma(x^T_w\theta^w_j-1), & d^w_j=1 \end{matrix} \right.

p ( d j w ∣ x w , θ j − 1 w ) = { σ ( x w T θ j − 1 w ) , 1 − σ ( x w T θ j w − 1 ) , d j w = 0 d j w = 1

或者写成整体表达式:

p

(

d

j

w

∣

x

w

,

θ

j

−

1

w

)

=

[

σ

(

x

w

T

θ

j

−

1

w

)

]

1

−

d

j

w

⋅

[

1

−

σ

(

x

w

T

θ

j

−

1

w

)

]

d

j

w

p(d^w_j|x_w,\theta^w_{j-1})=[\sigma(x^T_w\theta^w_{j-1})]^{1-d^w_j}\cdot [1-\sigma(x^T_w\theta^w_{j-1})]^{d^w_j}

p ( d j w ∣ x w , θ j − 1 w ) = [ σ ( x w T θ j − 1 w ) ] 1 − d j w ⋅ [ 1 − σ ( x w T θ j − 1 w ) ] d j w

L

=

∑

w

∈

C

log

∏

j

=

2

l

w

[

σ

(

x

w

T

θ

j

−

1

w

)

]

1

−

d

j

w

⋅

[

1

−

σ

(

x

w

T

θ

j

−

1

w

)

]

d

j

w

=

∑

w

∈

C

∑

j

=

2

l

w

(

1

−

d

j

w

)

⋅

log

[

σ

(

x

w

T

θ

j

−

1

w

)

]

+

d

j

w

⋅

log

[

1

−

σ

(

x

w

T

θ

j

−

1

w

)

]

(9)

\begin{aligned} L &=\sum_{w \in C} \log \prod_{j=2}^{l^w}{ { [\sigma(x^T_w\theta^w_{j-1})]^{1-d^w_j}\cdot [1-\sigma(x^T_w\theta^w_{j-1})]^{d^w_j}} } \\ &= \sum_{w \in C} \sum_{j=2}^{l^w}{(1-d^w_j) \cdot \log [\sigma(x^T_w \theta ^w_{j-1})] + d^w_j \cdot \log [1-\sigma(x^T_w \theta ^w_{j-1})] } \end{aligned} \tag{9}

L = w ∈ C ∑ log j = 2 ∏ l w [ σ ( x w T θ j − 1 w ) ] 1 − d j w ⋅ [ 1 − σ ( x w T θ j − 1 w ) ] d j w = w ∈ C ∑ j = 2 ∑ l w ( 1 − d j w ) ⋅ log [ σ ( x w T θ j − 1 w ) ] + d j w ⋅ log [ 1 − σ ( x w T θ j − 1 w ) ] ( 9 )

为了梯度推导方便起见,将上式中双重求和符号下的内容简记为

L

(

w

,

j

)

L(w,j)

L ( w , j )

L

(

w

,

j

)

=

(

1

−

d

j

w

)

⋅

log

[

σ

(

x

w

T

θ

j

−

1

w

)

]

+

d

j

w

⋅

log

[

1

−

σ

(

x

w

T

θ

j

−

1

w

)

]

L(w,j)=(1-d^w_j) \cdot \log [\sigma(x^T_w \theta ^w_{j-1})] + d^w_j \cdot \log [1-\sigma(x^T_w \theta ^w_{j-1})]

L ( w , j ) = ( 1 − d j w ) ⋅ log [ σ ( x w T θ j − 1 w ) ] + d j w ⋅ log [ 1 − σ ( x w T θ j − 1 w ) ]

首先考虑

L

(

w

,

j

)

L(w,j)

L ( w , j )

θ

j

−

1

w

\theta^{w}_{j-1}

θ j − 1 w

Δ

L

(

w

,

j

)

Δ

θ

j

−

1

w

=

{

(

1

−

d

j

w

)

[

1

−

σ

(

x

w

T

θ

j

−

1

w

)

]

x

w

−

d

j

w

σ

(

x

w

T

θ

j

−

1

w

)

}

x

w

=

[

1

−

d

j

w

−

σ

(

x

w

T

θ

j

−

1

w

)

]

x

w

\begin {aligned} \frac{\Delta L(w,j)}{\Delta \theta ^w_{j-1}} &= \left\{ (1-d^w_j)[1- \sigma(x^T_w \theta ^w_{j-1})]x_w - d^w_j \sigma (x^T_w \theta^w_{j-1}) \right\}x_w \\ &= [1-d^w_j- \sigma(x^T_w \theta^w_{j-1})]x_w \end {aligned}

Δ θ j − 1 w Δ L ( w , j ) = { ( 1 − d j w ) [ 1 − σ ( x w T θ j − 1 w ) ] x w − d j w σ ( x w T θ j − 1 w ) } x w = [ 1 − d j w − σ ( x w T θ j − 1 w ) ] x w

θ

j

−

1

w

\theta^{w}_{j-1}

θ j − 1 w

θ

j

−

1

w

=

θ

j

−

1

w

+

η

[

1

−

d

j

w

−

σ

(

x

w

T

θ

j

−

1

w

)

]

x

w

\theta ^ w_{j-1}= \theta^w_{j-1}+ \eta [1-d^w_j- \sigma(x^T_w \theta^w_{j-1})]x_w

θ j − 1 w = θ j − 1 w + η [ 1 − d j w − σ ( x w T θ j − 1 w ) ] x w

L

(

w

,

j

)

L(w,j)

L ( w , j )

x

w

x_{w}

x w

Δ

L

(

w

,

j

)

Δ

x

w

=

[

1

−

d

j

w

−

σ

(

x

w

T

θ

j

−

1

w

)

]

θ

j

−

1

w

\frac{\Delta L(w,j)}{\Delta x_w} = [1-d^w_j- \sigma(x^T_w \theta^w_{j-1})] \theta^w_{j-1}

Δ x w Δ L ( w , j ) = [ 1 − d j w − σ ( x w T θ j − 1 w ) ] θ j − 1 w

x

w

x_w

x w

x

w

x_w

x w

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

x

w

x_w

x w

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

v

(

w

~

)

v(\widetilde{w})

v ( w

)

x

w

x_w

x w

v

(

w

~

)

v(\widetilde{w})

v ( w

)

v

(

w

~

)

=

v

(

w

~

)

+

η

∑

j

=

2

l

w

Δ

L

(

w

,

j

)

Δ

x

w

,

w

~

∈

C

o

n

t

e

x

t

(

w

)

v(\widetilde{w}) = v(\widetilde{w}) + \eta \sum^{l^w}_{j=2} \frac{\Delta L(w,j)}{\Delta x_w}, \ \ \widetilde{w} \in Context(w)

v ( w

) = v ( w

) + η j = 2 ∑ l w Δ x w Δ L ( w , j ) , w

∈ C o n t e x t ( w )

本小节介绍Word2Vec中的另一个模型-Skip-gram模型,由于推导过程与CBOW大同小异,因此会沿用上小节引入的记号。

下图给出了Skip-gram模型的网络结构,同CBOW模型的网络结构一样,它也包括三层:输入层、投影层和输出层。下面以样本

(

w

,

C

o

n

t

e

x

t

(

w

)

)

(w, Context(w))

( w , C o n t e x t ( w ) )

输入层:只含当前样本的中心词

w

w

w

v

(

w

)

∈

ℜ

m

v(w) \in \Re^{m}

v ( w ) ∈ ℜ m

投影层:这是个恒等投影,把

v

(

w

)

v(w)

v ( w )

v

(

w

)

v(w)

v ( w )

输出层:和CBOW模型一样,输出层也是一颗Huffman树。

对于Skip-gram模型,已知的是当前词

w

w

w

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

p

(

C

o

n

t

e

x

t

(

w

)

∣

w

)

p(Context(w)|w)

p ( C o n t e x t ( w ) ∣ w )

p

(

C

o

n

t

e

x

t

(

w

)

∣

w

)

=

∏

u

∈

C

o

n

t

e

x

t

(

w

)

p

(

u

∣

w

)

p(Context(w)|w)= \prod_{u \in Context(w)}p(u|w)

p ( C o n t e x t ( w ) ∣ w ) = u ∈ C o n t e x t ( w ) ∏ p ( u ∣ w )

p

(

u

∣

w

)

p(u|w)

p ( u ∣ w )

p

(

u

∣

w

)

=

∏

j

=

2

l

u

p

(

d

j

u

∣

v

(

w

)

,

θ

j

−

1

u

)

p(u|w)= \prod^{l^u}_{j=2}{p(d^u_j|v(w), \theta^u_{j-1}) }

p ( u ∣ w ) = j = 2 ∏ l u p ( d j u ∣ v ( w ) , θ j − 1 u )

p

(

d

j

u

∣

v

(

w

)

,

θ

j

−

1

u

)

=

[

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

1

−

d

j

w

⋅

[

1

−

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

d

j

u

(10)

p(d^u_j|v(w), \theta^u_{j-1})=[\sigma(v(w)^T \theta^u_{j-1})]^{1-d^w_j} \cdot [1- \sigma(v(w)^T \theta^u_{j-1})]^{d^u_j} \tag{10}

p ( d j u ∣ v ( w ) , θ j − 1 u ) = [ σ ( v ( w ) T θ j − 1 u ) ] 1 − d j w ⋅ [ 1 − σ ( v ( w ) T θ j − 1 u ) ] d j u ( 1 0 )

L

=

∑

w

∈

C

log

∏

u

∈

C

o

n

t

e

x

t

(

w

)

∏

j

=

2

l

u

[

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

1

−

d

j

w

⋅

[

1

−

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

d

j

u

=

∑

w

∈

C

∑

u

∈

C

o

n

t

e

x

t

(

w

)

∑

j

=

2

l

u

(

1

−

d

j

u

)

⋅

log

[

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

+

d

j

u

log

[

1

−

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

(11)

\begin {aligned} L &= \sum_{w \in C} \log \prod_{u \in Context(w)} \prod_{j=2}^{l^u} { [\sigma(v(w)^T \theta^u_{j-1})]^{1-d^w_j} \cdot [1- \sigma(v(w)^T \theta^u_{j-1})]^{d^u_j} } \\ &= \sum_{w \in C} \sum_{u \in Context(w)} \sum_{j=2}^{l^u}{ (1-d^u_j) \cdot \log [\sigma(v(w)^T\theta^u_{j-1})] + d^u_j \log [1- \sigma(v(w)^T \theta^u_{j-1})] } \end {aligned} \tag{11}

L = w ∈ C ∑ log u ∈ C o n t e x t ( w ) ∏ j = 2 ∏ l u [ σ ( v ( w ) T θ j − 1 u ) ] 1 − d j w ⋅ [ 1 − σ ( v ( w ) T θ j − 1 u ) ] d j u = w ∈ C ∑ u ∈ C o n t e x t ( w ) ∑ j = 2 ∑ l u ( 1 − d j u ) ⋅ log [ σ ( v ( w ) T θ j − 1 u ) ] + d j u log [ 1 − σ ( v ( w ) T θ j − 1 u ) ] ( 1 1 )

L

(

w

,

u

,

j

)

L(w,u,j)

L ( w , u , j )

L

(

w

,

u

,

j

)

=

(

1

−

d

j

u

)

⋅

log

[

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

+

d

j

u

log

[

1

−

σ

(

v

(

w

)

T

θ

j

−

1

u

)

]

L(w,u,j)=(1-d^u_j) \cdot \log [\sigma(v(w)^T\theta^u_{j-1})] + d^u_j \log [1- \sigma(v(w)^T \theta^u_{j-1})]

L ( w , u , j ) = ( 1 − d j u ) ⋅ log [ σ ( v ( w ) T θ j − 1 u ) ] + d j u log [ 1 − σ ( v ( w ) T θ j − 1 u ) ]

首先考虑

L

(

w

,

u

,

j

)

L(w,u,j)

L ( w , u , j )

θ

j

−

1

u

\theta^{u}_{j-1}

θ j − 1 u

Δ

L

(

w

,

u

,

j

)

Δ

θ

j

−

1

u

=

{

(

1

−

d

j

u

)

(

1

−

σ

(

v

(

w

)

T

θ

j

−

1

u

)

)

v

(

w

)

−

d

j

u

σ

(

v

(

w

)

T

θ

j

−

1

u

)

x

}

v

(

w

)

=

[

1

−

d

j

u

−

σ

(

v

(

w

)

T

θ

j

−

1

u

]

v

(

w

)

\begin {aligned} \frac{ \Delta L(w,u,j)}{\Delta \theta^u_{j-1}} &=\left\{ (1-d^u_j)(1- \sigma(v(w)^T \theta^u_{j-1}))v(w)-d^u_j \sigma(v(w)^T \theta^u_{j-1})x \right\} v(w) \\ &= [1-d^u_j-\sigma(v(w)^T \theta^u_{j-1}]v(w) \end {aligned}

Δ θ j − 1 u Δ L ( w , u , j ) = { ( 1 − d j u ) ( 1 − σ ( v ( w ) T θ j − 1 u ) ) v ( w ) − d j u σ ( v ( w ) T θ j − 1 u ) x } v ( w ) = [ 1 − d j u − σ ( v ( w ) T θ j − 1 u ] v ( w )

θ

j

−

1

u

\theta^{u}_{j-1}

θ j − 1 u

θ

j

−

1

u

=

θ

j

−

1

u

+

η

[

1

−

d

j

u

−

σ

(

v

(

w

)

T

θ

j

−

1

u

]

v

(

w

)

\theta^u_{j-1}=\theta^u_{j-1} + \eta [1-d^u_j-\sigma(v(w)^T \theta^u_{j-1}]v(w)

θ j − 1 u = θ j − 1 u + η [ 1 − d j u − σ ( v ( w ) T θ j − 1 u ] v ( w )

L

(

w

,

u

,

j

)

L(w,u,j)

L ( w , u , j )

v

(

w

)

v(w)

v ( w )

Δ

L

(

w

,

u

,

j

)

Δ

v

(

w

)

=

[

1

−

d

j

u

−

σ

(

v

(

w

)

T

θ

j

−

1

u

]

θ

j

−

1

u

\begin {aligned} \frac{ \Delta L(w,u,j)}{\Delta v(w)} &= [1-d^u_j-\sigma(v(w)^T \theta^u_{j-1}] \theta^u_{j-1} \end {aligned}

Δ v ( w ) Δ L ( w , u , j ) = [ 1 − d j u − σ ( v ( w ) T θ j − 1 u ] θ j − 1 u

v

(

w

)

v(w)

v ( w )

v

(

w

)

=

v

(

w

)

+

η

∑

u

∈

C

o

n

t

e

x

t

(

w

)

∑

j

=

2

l

w

Δ

L

(

w

,

u

,

j

)

Δ

v

(

w

)

v(w)=v(w)+ \eta \sum_{u \in Context(w)} \sum^{l^w}_{j=2} \frac{ \Delta L (w,u,j)}{\Delta v(w)}

v ( w ) = v ( w ) + η u ∈ C o n t e x t ( w ) ∑ j = 2 ∑ l w Δ v ( w ) Δ L ( w , u , j )

本节将介绍基于Negative Sampling的CBOW和Skip-gram模型。Negative Sampling(简称为NEG)是Tomas Mikolov等人在论文《Distributed Representations of Words and Phrases and their Compositionality》中提出的,它是NCE(Noise Contrastive Estimation)的一个简化版,目的是用来提高训练速度并改善所得词向量的质量。与Hierarchical Softmax相比,NEG不再使用复杂的Huffman树,而是利用相对简单的随机负采样,能大幅度提高性能,因而可作为Hierarchical Softmax的一种替代。

NCE 的细节有点复杂,其本质是利用已知的概率密度函数来估计未知的概率密度函数。简单来说,假设未知的概率密度函数为X,已知的概率密度为Y,如果得到了X和Y的关系,那么X也就可以求出来了。具体可以参考论文《 Noise-contrastive estimation of unnormalized statistical models, with applications to natural image statistics》。

顾名思义,在基于Negative Sampling的CBOW和Skip-gram模型中,负采样是个很重要的环节,对于一个给定的词

w

w

w

N

E

G

(

w

)

NEG(w)

N E G ( w )

词典

D

D

D

C

C

C

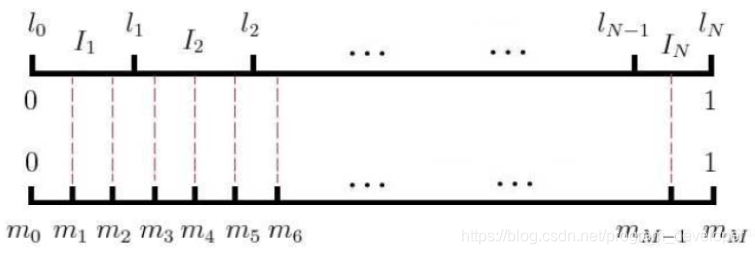

下面,先用一段通俗的描述来帮助读者理解带权采样的机理。设词典

D

D

D

w

w

w

l

e

n

(

w

)

len(w)

l e n ( w )

l

e

n

(

w

)

=

c

o

u

n

t

e

r

(

w

)

∑

u

∈

C

c

o

u

n

t

e

r

(

u

)

(12)

len(w)=\frac{counter(w)}{\sum_{u \in C}counter(u)} \tag{12}

l e n ( w ) = ∑ u ∈ C c o u n t e r ( u ) c o u n t e r ( w ) ( 1 2 )

c

o

u

n

t

e

r

(

.

)

counter(.)

c o u n t e r ( . )

C

C

C

1

1

1

接下来再谈谈Word2Vec中的具体做法。记

l

0

=

0

,

.

.

.

,

l

k

=

∑

j

=

1

k

l

e

n

(

w

j

)

,

k

=

1

,

2

,

.

.

.

,

N

l_0=0,..., l_k=\sum^{k}_{j=1}len(w_j), \ \ \ k=1,2,...,N

l 0 = 0 , . . . , l k = ∑ j = 1 k l e n ( w j ) , k = 1 , 2 , . . . , N

w

j

w_j

w j

j

j

j

{

l

i

}

j

=

0

N

\left\{ l_i \right\}^N_{j=0}

{ l i } j = 0 N

[

0

,

1

]

[0,1]

[ 0 , 1 ]

I

i

=

{

l

i

−

1

,

l

i

}

,

i

=

1

,

2

,

.

.

.

,

N

I_{i} = \left\{ l_{i-1}, l_{i} \right\},i = 1,2,...,N

I i = { l i − 1 , l i } , i = 1 , 2 , . . . , N

N

N

N

[

0

,

1

]

[0,1]

[ 0 , 1 ]

{

m

j

}

j

=

0

M

\left\{ m_{j} \right\}_{j=0}^{M}

{ m j } j = 0 M

M

>

>

N

M>>N

M > > N

T

a

b

l

e

(

.

)

Table(.)

T a b l e ( . )

将内部剖分结点

{

m

j

}

j

=

1

M

−

1

\left\{ m_{j} \right\}_{j=1}^{M-1}

{ m j } j = 1 M − 1

{

m

j

}

j

=

1

M

−

1

\left\{ m_{j} \right\}_{j=1}^{M-1}

{ m j } j = 1 M − 1

{

I

j

}

j

=

1

N

\left\{ I_{j} \right\}_{j=1}^{N}

{ I j } j = 1 N

{

w

j

}

j

=

1

N

\left\{ w_{j} \right\}_{j=1}^{N}

{ w j } j = 1 N

T

a

b

l

e

(

i

)

=

w

k

,

w

h

e

r

e

m

i

∈

I

k

,

i

=

1

,

2

,

.

.

.

,

M

−

1

(13)

Table(i)=w_k, \ \ where \ \ m_i \in I_{k}, \ \ i=1,2,...,M-1 \tag{13}

T a b l e ( i ) = w k , w h e r e m i ∈ I k , i = 1 , 2 , . . . , M − 1 ( 1 3 )

[

1

,

M

−

1

]

[1, M-1]

[ 1 , M − 1 ]

r

r

r

T

a

b

l

e

(

r

)

Table(r)

T a b l e ( r )

w

i

w_{i}

w i

w

i

w_{i}

w i

值得一提的是,Word2Vec源码中为词典

D

D

D

c

o

u

n

t

e

r

(

w

)

counter(w)

c o u n t e r ( w )

α

\alpha

α

α

=

0.75

\alpha = 0.75

α = 0 . 7 5

l

e

n

(

w

)

=

c

o

u

n

t

e

r

(

w

)

α

∑

u

∈

C

[

c

o

u

n

t

e

r

(

u

)

]

α

=

c

o

u

n

t

e

r

(

w

)

0.75

∑

u

∈

C

[

c

o

u

n

t

e

r

(

u

)

]

0.75

\begin {aligned} len(w) &= \frac{counter(w)^\alpha}{\sum_{u \in C}[counter(u)]^\alpha} \\ &= \frac{counter(w)^{0.75}}{\sum_{u \in C}[counter(u)]^{0.75}} \end {aligned}

l e n ( w ) = ∑ u ∈ C [ c o u n t e r ( u ) ] α c o u n t e r ( w ) α = ∑ u ∈ C [ c o u n t e r ( u ) ] 0 . 7 5 c o u n t e r ( w ) 0 . 7 5

M

=

1

0

8

M = 10^{8}

M = 1 0 8

t

a

b

l

e

s

i

z

e

table_size

t a b l e s i z e

上面已经介绍完了负采样算法,下面开始推导出基于Negative Sampling的CBOW的目标函数。首先我们先选好一个关于

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

N

E

G

(

w

)

≠

⊘

NEG(w) \ne \oslash

N E G ( w ) = ⊘

∀

w

~

∈

D

\forall \widetilde{w} \in D

∀ w

∈ D

w

~

\widetilde{w}

w

L

w

(

w

~

)

=

{

1

,

w

~

=

w

0

,

w

~

≠

w

L^w(\widetilde{w})= \left\{ \begin{matrix} 1, \ \ \ \widetilde{w}=w \\ 0, \ \ \ \widetilde{w} \neq w \end{matrix} \right.

L w ( w

) = { 1 , w

= w 0 , w

= w

w

~

\widetilde{w}

w

1

1

1

0

0

0

对于一个给定的正样本

(

C

o

n

t

e

x

t

(

w

)

,

w

)

(Context(w),w)

( C o n t e x t ( w ) , w )

g

(

w

)

=

∏

u

∈

w

∪

N

E

G

(

w

)

p

(

u

∣

C

o

n

t

e

x

t

(

w

)

)

(14)

g(w)=\prod_{u \in {w} \cup NEG(w)} p(u|Context(w)) \tag{14}

g ( w ) = u ∈ w ∪ N E G ( w ) ∏ p ( u ∣ C o n t e x t ( w ) ) ( 1 4 )

p

(

u

∣

C

o

n

t

e

x

t

(

w

)

)

=

{

σ

(

x

w

T

θ

u

)

,

L

w

(

u

)

=

1

1

−

σ

(

x

w

T

θ

u

)

,

L

w

(

u

)

=

0

=

[

σ

(

x

w

T

θ

u

)

]

L

w

(

u

)

⋅

[

1

−

σ

(

x

w

T

)

θ

u

]

1

−

L

w

(

u

)

(15)

\begin {aligned} p(u|Context(w)) &= \left\{\begin{matrix} \sigma(x^T_w \theta^u), \ \ \ \ L^w(u)=1 \\ 1-\sigma(x^T_w \theta^u), \ \ \ \ L^w(u)=0 \end{matrix}\right. \\ &= [\sigma(x^T_w\theta^u)]^{L^w(u)} \cdot [1-\sigma(x^T_w)\theta^u]^{1-L^w(u)} \end {aligned} \tag{15}

p ( u ∣ C o n t e x t ( w ) ) = { σ ( x w T θ u ) , L w ( u ) = 1 1 − σ ( x w T θ u ) , L w ( u ) = 0 = [ σ ( x w T θ u ) ] L w ( u ) ⋅ [ 1 − σ ( x w T ) θ u ] 1 − L w ( u ) ( 1 5 )

x

w

x_w

x w

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

θ

u

∈

R

m

\theta^u \in R^m

θ u ∈ R m

为什么要最大化

g

(

w

)

g(w)

g ( w )

g

(

w

)

g(w)

g ( w )

g

(

w

)

=

σ

(

x

w

T

θ

w

)

∏

u

∈

N

E

G

(

w

)

[

1

−

σ

(

x

w

T

θ

u

)

]

g(w)=\sigma(x^T_w\theta^w) \prod_{u \in NEG(w)} [1- \sigma(x^T_w\theta^u)]

g ( w ) = σ ( x w T θ w ) u ∈ N E G ( w ) ∏ [ 1 − σ ( x w T θ u ) ]

σ

(

x

w

T

θ

w

)

\sigma(x^T_w \theta^w)

σ ( x w T θ w )

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

w

w

w

σ

(

x

w

T

θ

u

)

,

u

∈

N

E

G

(

w

)

\sigma(x^T_w\theta^u), \ u \in NEG(w)

σ ( x w T θ u ) , u ∈ N E G ( w )

C

o

n

t

e

x

t

(

w

)

Context(w)

C o n t e x t ( w )

u

u

u

g

(

w

)

g(w)

g ( w )

σ

(

x

w

T

θ

w

)

\sigma(x^T_w \theta^w)

σ ( x w T θ w )

σ

(

x

w

T

θ

u

)

,

u

∈

N

E

G

(

w

)

\sigma(x^T_w\theta^u), \ u \in NEG(w)

σ ( x w T θ u ) , u ∈ N E G ( w )

C

C

C

G

=

∏

w

∈

C

g

(

w

)

G = \prod_{w \in C}g(w)

G = w ∈ C ∏ g ( w )

G

G

G

L

=

log

G

=

∑

w

∈

C

log

g

(

w

)

=

∑

w

∈

C

∑

u

∈

w

∪

N

E

G

(

w

)

log

[

σ

(

x

w

T

θ

u

)

]

L

w

(

u

)

⋅

[

1

−

σ

(

x

w

T

)

θ

u

]

1

−

L

w

(

u

)

=

∑

w

∈

C

∑

u

∈

w

∪

N

E

G

(

w

)

L

w

(

u

)

⋅

log

[

σ

(

x

w

T

θ

u

)

+

[

1

−

L

w

(

u

)

]

⋅

log

[

1

−

σ

(

x

w

T

θ

u

)

]

]

\begin {aligned} L &= \log G = \sum_{w \in C} \log g(w) \\ &= \sum_{w \in C} \sum_{u \in {w} \cup NEG(w)} \log { [\sigma(x^T_w\theta^u)]^{L^w(u)} \cdot [1-\sigma(x^T_w)\theta^u]^{1-L^w(u)} } \\ &= \sum_{w \in C} \sum_{u \in {w} \cup NEG(w)} { L^w(u) \cdot \log[\sigma(x^T_w \theta^u) + [1-L^w(u)] \cdot \log [1-\sigma(x^T_w \theta^u)]] } \end {aligned}

L = log G = w ∈ C ∑ log g ( w ) = w ∈ C ∑ u ∈ w ∪ N E G ( w ) ∑ log [ σ ( x w T θ u ) ] L w ( u ) ⋅ [ 1 − σ ( x w T ) θ u ] 1 − L w ( u ) = w ∈ C ∑ u ∈ w ∪ N E G ( w ) ∑ L w ( u ) ⋅ log [ σ ( x w T θ u ) + [ 1 − L w ( u ) ] ⋅ log [ 1 − σ ( x w T θ u ) ] ]

L

(

w

,

u

)

L(w,u)

L ( w , u )

L

(

w

,

u

)

=

L

w

(

u

)

⋅

log

[

σ

(

x

w

T

θ

u

)

+

[

1

−

L

w

(

u

)

]

⋅

log

[

1

−

σ

(

x

w

T

θ

u

)

]

]

L(w,u) = L^w(u) \cdot \log[\sigma(x^T_w \theta^u) + [1-L^w(u)] \cdot \log [1-\sigma(x^T_w \theta^u)]]

L ( w , u ) = L w ( u ) ⋅ log [ σ ( x w T θ u ) + [ 1 − L w ( u ) ] ⋅ log [ 1 − σ ( x w T θ u ) ] ]

L

(

w

,

u

)

L(w,u)

L ( w , u )

θ

u

\theta^{u}

θ u

Δ

L

(

w

,

u

)

Δ

θ

u

=

{

L

w

(

u

)

[

1

−

σ

(

x

w

T

θ

u

)

]

x

w

−

[

1

−

L

w

(

u

)

]

⋅

σ

(

x

w

T

θ

u

)

}

x

w

=

[

L

w

(

u

)

−

σ

(

x

w

T

θ

u

)

]

x

w

\begin {aligned} \frac{\Delta L(w,u)}{\Delta \theta^u} &= \left\{ L^w(u)[1- \sigma(x^T_w\theta^u)]x_w-[1-L^w(u)] \cdot \sigma(x^T_w \theta^u)\right\} x_w \\ &=[L^w(u)-\sigma(x^T_w \theta^u)]x_w \end {aligned}

Δ θ u Δ L ( w , u ) = { L w ( u ) [ 1 − σ ( x w T θ u ) ] x w − [ 1 − L w ( u ) ] ⋅ σ ( x w T θ u ) } x w = [ L w ( u ) − σ ( x w T θ u ) ] x w

θ

u

\theta^u

θ u

θ

u

=

θ

u

+

η

[

L

w

(

u

)

−

σ

(

x

w

T

θ

u

)

]

x

w

\theta^u=\theta^u+\eta [L^w(u)-\sigma(x^T_w \theta^u)]x_w

θ u = θ u + η [ L w ( u ) − σ ( x w T θ u ) ] x w

x

w

x_w

x w

Δ

L

(

w

,

u

)

Δ

x

w

=

[

L

w

(

u

)

−

σ

(

x

w

T

θ

u

)

]

θ

u

\begin {aligned} \frac{\Delta L(w,u)}{\Delta x_w} &=[L^w(u)-\sigma(x^T_w \theta^u)] \theta^u \end {aligned}

Δ x w Δ L ( w , u ) = [ L w ( u ) − σ ( x w T θ u ) ] θ u

v

(

w

)

v(w)

v ( w )

v

(

w

~

)

=

v

(

w

~

)

+

η

∑

u

∈

w

∪

N

E

G

(

w

)

Δ

L

(

w

,

u

)

Δ

x

w

,

w

~

∈

C

o

n

t

e

x

t

(

w

)

v(\tilde w) =v(\tilde w)+ \eta \sum_{u \in {w} \cup NEG(w)} \frac{\Delta L(w,u)}{\Delta x_w}, \ \ \tilde w \in Context(w)

v ( w ~ ) = v ( w ~ ) + η u ∈ w ∪ N E G ( w ) ∑ Δ x w Δ L ( w , u ) , w ~ ∈ C o n t e x t ( w )

本小节介绍基于Negative Sampling的Skip-gram模型。它和上一小节介绍的CBOW模型所用的思想是一样的,因此,这里我们直接从目标函数出发,且沿用之前的记号。

对于一个给定的样本

(

w

,

C

o

n

t

e

x

t

(

w

)

)

(w,Context(w))

( w , C o n t e x t ( w ) )

g

(

w

)

=

∏

w

~

∈

C

o

n

t

e

x

t

(

w

)

∏

u

∈

w

∪

N

E

U

w

~

(

w

)

p

(

C

o

n

t

e

x

t

∣

w

~

)

g(w)= \prod_{\tilde w \in Context(w)} \prod_{u \in {w} \cup NEU^{\tilde w}(w)}p(Context| \widetilde{w})

g ( w ) = w ~ ∈ C o n t e x t ( w ) ∏ u ∈ w ∪ N E U w ~ ( w ) ∏ p ( C o n t e x t ∣ w

)

p

(

u

∣

w

~

)

=

{

σ

(

v

(

w

~

)

T

θ

u

)

,

L

w

(

u

)

=

1

1

−

σ

(

v

(

w

~

)

T

θ

u

)

,

L

w

(

u

)

=

0

p(u| \widetilde{w}) = \left\{ \begin{matrix} \sigma(v(\tilde w)^T \theta^u), \ \ \ L^w(u)=1 \\ 1-\sigma(v(\tilde w)^T \theta^u), \ \ \ L^w(u)=0 \end{matrix} \right.

p ( u ∣ w

) = { σ ( v ( w ~ ) T θ u ) , L w ( u ) = 1 1 − σ ( v ( w ~ ) T θ u ) , L w ( u ) = 0

p

(

u

∣

w

~

)

=

[

σ

(

v

(

w

~

)

T

]

L

w

(

u

)

⋅

[

1

−

σ

(

v

(

w

~

)

T

]

1

−

L

w

(

u

)

p(u| \widetilde{w})=[\sigma(v(\tilde w)^T]^{L^w(u)} \cdot [1-\sigma(v(\tilde w)^T]^{1-L^w(u)}

p ( u ∣ w

) = [ σ ( v ( w ~ ) T ] L w ( u ) ⋅ [ 1 − σ ( v ( w ~ ) T ] 1 − L w ( u )

N

E

G

w

~

(

w

)

NEG^{\widetilde{w}}(w)

N E G w

( w )

w

~

\widetilde{w}

w

C

C

C

G

=

∏

w

∈

C

g

(

w

)

G = \prod_{w \in C}g(w)

G = w ∈ C ∏ g ( w )

G

G

G

L

=

log

G

=

∑

w

∈

C

log

g

(

w

)

=

∑

w

∈

C

∑

w

~

∈

C

o

n

t

e

x

t

(

w

)

∑

u

∈

w

∪

N

E

U

w

~

(

w

)

L

w

(

u

)

log

[

σ

(

v

(

w

~

)

T

θ

u

)

]

+

[

1

−

L

w

(

u

)

]

log

[

1

−

σ

(

v

(

w

~

)

T

θ

u

)

]

\begin {aligned} L &= \log G = \sum_{w \in C} \log g(w) \\ &= \sum_{w\in C} \sum_{\tilde w \in Context(w)} \sum_{u \in {w} \cup NEU^{\tilde w}(w)} L^w(u)\log[\sigma(v(\tilde w)^T \theta^u)] + [1-L^w(u)]\log[1-\sigma(v(\tilde w)^T \theta^u)] \end {aligned}

L = log G = w ∈ C ∑ log g ( w ) = w ∈ C ∑ w ~ ∈ C o n t e x t ( w ) ∑ u ∈ w ∪ N E U w ~ ( w ) ∑ L w ( u ) log [ σ ( v ( w ~ ) T θ u ) ] + [ 1 − L w ( u ) ] log [ 1 − σ ( v ( w ~ ) T θ u ) ]

L

(

w

,

w

~

,

u

)

L(w, \tilde w, u)

L ( w , w ~ , u )

L

(

w

,

w

~

,

u

)

=

L

w

(

u

)

log

[

σ

(

v

(

w

~

)

T

θ

u

)

]

+

[

1

−

L

w

(

u

)

]

log

[

1

−

σ

(

v

(

w

~

)

T

θ

u

)

]

L(w, \tilde w, u) = L^w(u)\log[\sigma(v(\tilde w)^T \theta^u)] + [1-L^w(u)]\log[1-\sigma(v(\tilde w)^T \theta^u)]

L ( w , w ~ , u ) = L w ( u ) log [ σ ( v ( w ~ ) T θ u ) ] + [ 1 − L w ( u ) ] log [ 1 − σ ( v ( w ~ ) T θ u ) ]

L

(

w

,

w

~

,

u

)

L(w, \widetilde{w}, u)

L ( w , w

, u )

θ

u

\theta^{u}

θ u

Δ

L

(

w

,

w

~

,

u

)

Δ

θ

u

=

{

L

w

(

u

)

[

1

−

σ

(

v

(

w

~

)

w

T

θ

u

)

]

v

(

w

~

)

−

[

1

−

L

w

(

u

)

]

⋅

σ

(

v

(

w

~

)

w

θ

u

)

}

v

(

w

~

)

=

[

L

w

(

u

)

−

σ

(

v

(

w

~

)

T

θ

u

)

]

v

(

w

~

)

\begin {aligned} \frac{\Delta L(w, \tilde w, u)}{\Delta \theta^u} &= \left\{L^w(u)[1- \sigma(v(\tilde w)^T_w\theta^u)]v(\tilde w)-[1-L^w(u)] \cdot \sigma(v(\tilde w)_w \theta^u) \right\} v(\tilde w) \\ &=[L^w(u)-\sigma(v(\tilde w)^T \theta^u)]v(\tilde w) \end {aligned}

Δ θ u Δ L ( w , w ~ , u ) = { L w ( u ) [ 1 − σ ( v ( w ~ ) w T θ u ) ] v ( w ~ ) − [ 1 − L w ( u ) ] ⋅ σ ( v ( w ~ ) w θ u ) } v ( w ~ ) = [ L w ( u ) − σ ( v ( w ~ ) T θ u ) ] v ( w ~ )

然后得到

θ

u

\theta^u

θ u

θ

u

=

θ

u

+

η

=

[

L

w

(

u

)

−

σ

(

v

(

w

~

)

T

θ

u

)

]

v

(

w

~

)

\theta^u = \theta^u + \eta =[L^w(u)-\sigma(v(\tilde w)^T \theta^u)]v(\tilde w)

θ u = θ u + η = [ L w ( u ) − σ ( v ( w ~ ) T θ u ) ] v ( w ~ )

Δ

L

(

w

,

w

~

,

u

)

Δ

v

(

w

~

)

=

[

L

w

(

u

)

−

σ

(

v

(

w

~

)

T

θ

u

)

]

θ

u

\begin {aligned} \frac{\Delta L(w, \tilde w, u)}{\Delta v(\tilde w)} &=[L^w(u)-\sigma(v(\tilde w)^T \theta^u)]\theta^u \end {aligned}

Δ v ( w ~ ) Δ L ( w , w ~ , u ) = [ L w ( u ) − σ ( v ( w ~ ) T θ u ) ] θ u

v

(

w

~

)

v(\tilde w)

v ( w ~ )

v

(

w

~

)

=

v

(

w

~

)

+

η

∑

u

∈

w

∪

N

E

U

w

~

(

w

)

Δ

L

(

w

,

w

~

,

u

)

Δ

v

(

w

~

)

,

w

~

∈

C

o

n

t

e

x

t

(

w

)

v(\tilde w) = v(\tilde w) + \eta \sum_{u \in {w} \cup NEU^{\tilde w}(w)} \frac{ \Delta L(w, \tilde w, u)}{\Delta v(\tilde w)}, \ \ \ \tilde w \in Context(w)

v ( w ~ ) = v ( w ~ ) + η u ∈ w ∪ N E U w ~ ( w ) ∑ Δ v ( w ~ ) Δ L ( w , w ~ , u ) , w ~ ∈ C o n t e x t ( w )

(1)Word2Vec两个算法模型的原理是什么,网络结构怎么画?

(2)网络输入输出是什么?隐藏层的激活函数是什么?输出层的激活函数是什么?

(3)目标函数/损失函数是什么?

(4)Word2Vec如何获取词向量?

(5)推导一下Word2Vec参数如何更新?

(6)Word2Vec的两个模型哪个效果好哪个速度快?为什么?

(7)Word2Vec加速训练的方法有哪些?

(8)介绍下Negative Sampling,对词频低的和词频高的单词有什么影响?为什么?

(9)Word2Vec和隐狄利克雷模型(LDA)有什么区别与联系?

以上问题可以通过本文和参考文章找到答案,这里不再详细解答。

(10)介绍下Hierarchical Softmax的计算过程,怎么把 Huffman 放到网络中的?参数是如何更新的?对词频低的和词频高的单词有什么影响?为什么?

Hierarchical Softmax利用了Huffman树依据词频建树,词频大的节点离根节点较近,词频低的节点离根节点较远,距离远参数数量就多,在训练的过程中,低频词的路径上的参数能够得到更多的训练,所以效果会更好。

(11)Word2Vec有哪些参数,有没有什么调参的建议?

Skip-Gram 的速度比CBOW慢一点,小数据集中对低频次的效果更好;

Sub-Sampling Frequent Words可以同时提高算法的速度和精度,Sample 建议取值为

[

1

0

−

5

,

1

0

−

3

]

[10^{-5}, 10^{-3}]

[ 1 0 − 5 , 1 0 − 3 ]

Hierarchical Softmax对低词频的更友好;

Negative Sampling对高词频更友好;

向量维度一般越高越好,但也不绝对;

Window Size,Skip-Gram一般10左右,CBOW一般为5左右。

(12)Word2Vec有哪些局限性?

Word2Vec作为一个简单易用的算法,其也包含了很多局限性:

Word2Vec只考虑到上下文信息,而忽略的全局信息;

Word2Vec只考虑了上下文的共现性,而忽略的了彼此之间的顺序性;

Word2Vec主要原理是根据上下文来预测单词,一个词的意义往往可以从其前后的句子中抽取出来。

而用户的行为也是一种相似的时间序列,可以通过上下文进行推断。当用户浏览并与内容进行交互时,我们可以从用户前后的交互过程中判断行为的抽象特征,这就使得我们可以把词向量模型应用到推荐、广告领域当中。

Word2Vec学习到的词向量代表了词的语义,可以用来做分类、聚类、也可以做词的相似度计算。

把Word2Vec生成的向量直接作为深度神经网络的输入,可以做sentiment analysis等工作。

基于Word2Vec这一类的Graph Embedding方法有很多,具体可以参考论文:DeepWalk(是引入Word2Vec思想比较经典的图嵌入算法),node2vec,struc2vec 等等。

Airbnb在论文《Real-time Personalization using Embeddings for Search Ranking at Airbnb》中提出将用户的浏览行为组成List,通过Word2Vec方法学习item的向量,其点击率提升了21%,且带动了99%的预定转化率。该论文主要是在Skip-gram 模型的基础上做了改进。

Yahoo在论文《E-commerce in Your Inbox: Product Recommendations at Scale》中提出Yahoo邮箱从发送到用户的购物凭证中抽取商品并组成List,通过Word2Vec学习并为用户推荐潜在的商品;

Yahoo在论文《Scalable Semantic Matching of Queries to Ads in Sponsored Search Advertising》中提出将用户的搜索查询和广告组成List,并为其学习特征向量,以便对于给定的搜索查询可以匹配适合的广告。

【1】Rong X. word2vec parameter learning explained[J]. arXiv preprint arXiv:1411.2738, 2014.

最后除引用文献外也推荐一些看过的资料:

本文主要参考了peghoty的《Word2Vec中的数学》,写的非常棒, 强烈推荐大家学习。此外,我把自己学习Word2Vec时,收集到的优质资料已经整理好了,关注Microstrong公众号后,在后台回复【Word2Vec】领取。